Heim >Technologie-Peripheriegeräte >KI >Studie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben

Studie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-12 15:19:031377Durchsuche

Übersetzer |. Li Rui

Rezensent |.Bevor Chatbots mit Empfindungsvermögen zu einem heißen Thema wurden, hatten große Sprachmodelle (LLM) bereits für mehr Aufregung und Besorgnis gesorgt. In den letzten Jahren haben Large Language Models (LLMs), Deep-Learning-Modelle, die auf große Textmengen trainiert werden, bei mehreren Benchmarks zur Messung der Sprachverständnisfähigkeit gute Ergebnisse erzielt.

Große Sprachmodelle wie GPT-3 und LaMDA schaffen es, die Kohärenz über längere Texte hinweg aufrechtzuerhalten. Sie scheinen über verschiedene Themen Bescheid zu wissen und bleiben auch bei längeren Gesprächen konsistent. Große Sprachmodelle (LLMs) sind so überzeugend geworden, dass manche Menschen sie mit Persönlichkeit und höheren Formen der Intelligenz assoziieren.

Aber können Large Language Models (LLMs) logisches Denken wie Menschen ausführen? Laut einem von UCLA-Wissenschaftlern veröffentlichten Forschungsbericht lernt Transformers, eine Deep-Learning-Architektur, die in großen Sprachmodellen (LLMs) verwendet wird, nicht, Denkfähigkeiten zu simulieren. Stattdessen haben Computer clevere Wege gefunden, die statistischen Eigenschaften von Denkproblemen zu erlernen.

Die Forscher testeten die derzeit beliebte Transformer-Architektur BERT in einem begrenzten Problemraum. Ihre Ergebnisse zeigen, dass BERT genau auf Inferenzprobleme an Beispielen innerhalb einer Verteilung im Trainingsraum reagieren kann, jedoch nicht auf Beispiele in anderen Verteilungen verallgemeinern kann, die auf demselben Problemraum basieren.

Und diese Tests verdeutlichen einige der Mängel tiefer neuronaler Netze und der Benchmarks, die zu ihrer Bewertung verwendet werden.

1. Wie misst man logisches Denken in der künstlichen Intelligenz?

Es gibt mehrere Benchmarks für Systeme der künstlichen Intelligenz, die auf Probleme bei der Verarbeitung und dem Verstehen natürlicher Sprache abzielen, wie GLUE, SuperGLUE, SNLI und SqUAD. Da Transformer immer größer wurde und auf größeren Datensätzen trainiert wurde, konnte Transformer diese Benchmarks schrittweise verbessern.

Es ist erwähnenswert, dass die Leistung von KI-Systemen bei diesen Benchmarks oft mit der menschlichen Intelligenz verglichen wird. Die menschliche Leistung bei diesen Benchmarks hängt eng mit gesundem Menschenverstand und logischen Denkfähigkeiten zusammen. Es ist jedoch unklar, ob sich große Sprachmodelle verbessern, weil sie die Fähigkeit zum logischen Denken erlangen oder weil sie großen Textmengen ausgesetzt sind.

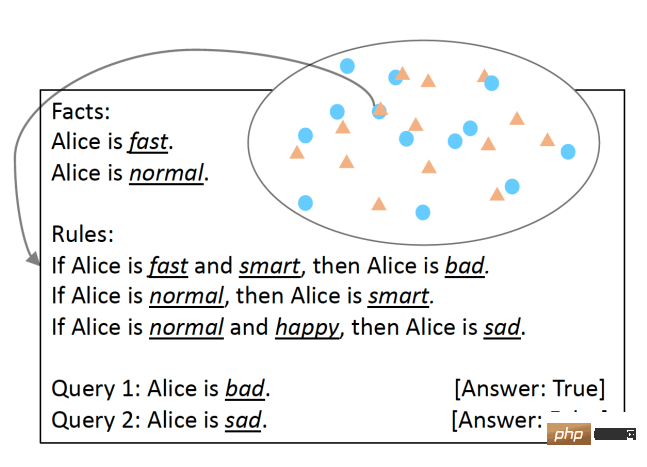

Um dies zu testen, haben UCLA-Forscher SimpleLogic entwickelt, eine Klasse von Fragen zum logischen Denken, die auf Aussagenlogik basieren. Um sicherzustellen, dass die Argumentationsfähigkeiten des Sprachmodells gründlich getestet wurden, beseitigten die Forscher Sprachunterschiede durch die Verwendung von Vorlagen-Sprachstrukturen. SimpleLogic-Probleme bestehen aus einer Reihe von Fakten, Regeln, Abfragen und Bezeichnungen. Fakten sind Prädikate, von denen man weiß, dass sie „wahr“ sind. Regeln sind Bedingungen, die als Begriffe definiert werden. Eine Abfrage ist eine Frage, auf die ein maschinelles Lernmodell antworten muss. Die Bezeichnung ist die Antwort auf die Abfrage, also „wahr“ oder „falsch“. SimpleLogic-Fragen werden in fortlaufende Textzeichenfolgen kompiliert, die die Signale und Trennzeichen enthalten, die das Sprachmodell während des Trainings und der Inferenz erwartet.

Fragen im SimpleLogic-Format Eines der Merkmale von SimpleLogic ist, dass seine Fragen in sich geschlossen sind und keine Vorkenntnisse erfordern. Dies ist besonders wichtig, da, wie viele Wissenschaftler sagen, Menschen beim Sprechen das gemeinsame Wissen ignorieren. Aus diesem Grund tappen Sprachmodelle oft in eine Falle, wenn Fragen zu grundlegendem Weltwissen gestellt werden, das jeder kennt. Im Gegensatz dazu bietet SimpleLogic Entwicklern alles, was sie zur Lösung ihrer Probleme benötigen. Daher sollte jeder Entwickler, der sich mit einem Problem befasst, das durch das SimpleLogic-Format entsteht, in der Lage sein, dessen Regeln abzuleiten und unabhängig von seinem Hintergrundwissen mit neuen Beispielen umgehen zu können.

Fragen im SimpleLogic-Format Eines der Merkmale von SimpleLogic ist, dass seine Fragen in sich geschlossen sind und keine Vorkenntnisse erfordern. Dies ist besonders wichtig, da, wie viele Wissenschaftler sagen, Menschen beim Sprechen das gemeinsame Wissen ignorieren. Aus diesem Grund tappen Sprachmodelle oft in eine Falle, wenn Fragen zu grundlegendem Weltwissen gestellt werden, das jeder kennt. Im Gegensatz dazu bietet SimpleLogic Entwicklern alles, was sie zur Lösung ihrer Probleme benötigen. Daher sollte jeder Entwickler, der sich mit einem Problem befasst, das durch das SimpleLogic-Format entsteht, in der Lage sein, dessen Regeln abzuleiten und unabhängig von seinem Hintergrundwissen mit neuen Beispielen umgehen zu können.

2. Statistische Charakterisierung und logische Inferenz

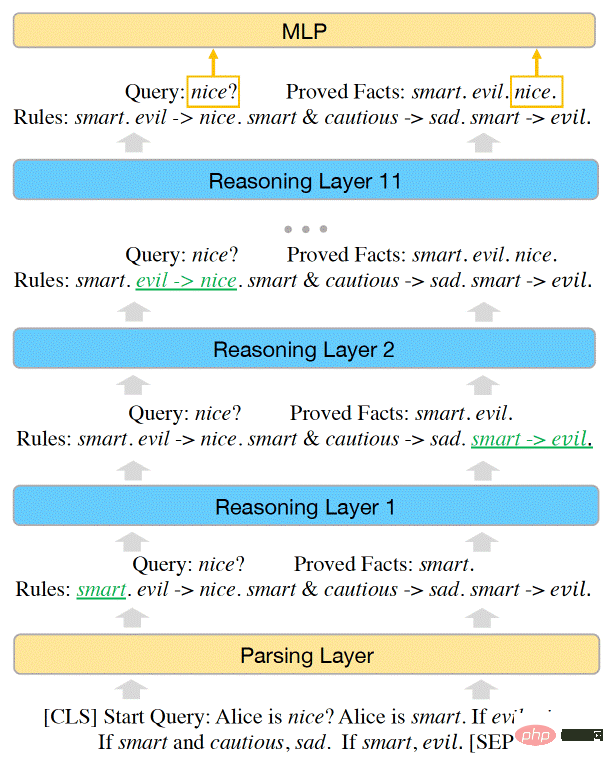

Forscher haben gezeigt, dass der Problemraum in SimpleLogic durch eine Inferenzfunktion dargestellt werden kann. Die Forscher zeigten außerdem, dass BERT leistungsstark genug ist, um alle Probleme in SimpleLogic zu lösen, und dass sie die Parameter des maschinellen Lernmodells manuell anpassen können, um die Inferenzfunktion darzustellen.

Als sie BERT jedoch anhand des SimpleLogic-Beispieldatensatzes trainierten, war das Modell nicht in der Lage, die Inferenzfunktion selbst zu erlernen. Modelle für maschinelles Lernen schaffen es, eine nahezu perfekte Genauigkeit bei der Datenverteilung zu erreichen. Es lässt sich jedoch nicht auf andere Distributionen innerhalb desselben Problemraums verallgemeinern. Dies ist der Fall, obwohl der Trainingsdatensatz den gesamten Problemraum abdeckt und alle Verteilungen aus derselben Inferenzfunktion stammen.

Die Kapazität des BERT Transformer-Modells reicht aus, um die Inferenzfähigkeiten von SimpleLogic darzustellen

Die Kapazität des BERT Transformer-Modells reicht aus, um die Inferenzfähigkeiten von SimpleLogic darzustellen

(Hinweis: Dies unterscheidet sich von der Out-of-Distribution-Generalisierungsherausforderung, die auf Open-Space-Probleme anwendbar ist. Wenn das Modell nicht verallgemeinern kann zu OOD-Daten, wenn die Daten bei der Verarbeitung außerhalb des Verteilungsbereichs ihres Trainingssatzes liegen, wird ihre Leistung erheblich sinken)

Die Forscher schrieben: „Nach weiteren Untersuchungen liefern wir eine Erklärung für dieses Paradoxon: Ein Modell, das nur bei Verteilungstestbeispielen eine hohe Genauigkeit erreicht, hat nicht gelernt, logische Schlussfolgerungen zu ziehen und statistische Merkmale zu verwenden.“ Vorhersagen treffen, anstatt korrekte Inferenzfunktionen zu modellieren.“

Dieser Befund verdeutlicht eine wichtige Herausforderung bei der Verwendung von Deep Learning für Sprachaufgaben. Neuronale Netze sind sehr gut darin, statistische Merkmale zu entdecken und anzupassen. In manchen Anwendungen kann dies sehr nützlich sein. Bei der Sentiment-Analyse gibt es beispielsweise starke Korrelationen zwischen bestimmten Wörtern und Sentiment-Kategorien.

Bei Aufgaben zum logischen Denken sollte das Modell jedoch versuchen, die zugrunde liegenden Argumentationsmerkmale zu finden und zu lernen, selbst wenn statistische Merkmale vorhanden sind.

„Vorsicht ist geboten, wenn wir versuchen, neuronale Modelle durchgängig zu trainieren, um Aufgaben der Verarbeitung natürlicher Sprache (NLP) zu lösen, die sowohl logisches Denken als auch Vorkenntnisse erfordern und sprachliche Unterschiede darstellen“, schreiben die Forscher Die Herausforderungen, die SimpleLogic mit sich bringt, werden in der realen Welt noch gravierender, da die riesigen Informationsmengen, die für große Sprachmodelle (LLMs) erforderlich sind, einfach nicht in den Daten enthalten sind.

Die Forscher beobachteten, dass sich die Leistung des Sprachmodells bei anderen Verteilungen desselben Problemraums verbesserte, wenn sie ein statistisches Merkmal aus dem Trainingsdatensatz entfernten. Das Problem besteht jedoch darin, dass das Entdecken und Entfernen mehrerer statistischer Merkmale leichter gesagt als getan ist. Wie die Forscher in ihrer Arbeit betonen, „können solche statistischen Merkmale zahlreich und äußerst komplex sein, was es schwierig macht, sie aus den Trainingsdaten zu entfernen.“ Wenn das Modell zunimmt, verschwindet das Problem des logischen Denkens nicht. Es ist einfach in riesigen Architekturen und sehr großen Trainingskorpora versteckt. Große Sprachmodelle (LLM) können Fakten sehr gut beschreiben und Sätze zusammenfügen, aber im Hinblick auf das logische Denken nutzen sie immer noch statistische Merkmale zum Denken, was keine solide Grundlage darstellt. Darüber hinaus gibt es keinen Hinweis darauf, dass durch das Hinzufügen von Ebenen, Parametern und Aufmerksamkeitsköpfen zu Transformers die Lücke im logischen Denken geschlossen wird.

Dieser Artikel steht im Einklang mit anderen Arbeiten, die die Grenzen neuronaler Netze beim Erlernen logischer Regeln zeigen, wie zum Beispiel beim Spiel des Lebens oder beim abstrakten Denken aus visuellen Daten. Der Artikel beleuchtet eine der größten Herausforderungen, denen sich aktuelle Sprachmodelle gegenübersehen. Wie UCLA-Forscher betonen: „Wenn ein Modell einerseits trainiert wird, eine Aufgabe aus Daten zu lernen, tendiert es immer dazu, statistische Muster zu lernen, die in den Inferenzbeispielen inhärent vorhanden sind. Logische Regeln andererseits jedoch nie Verlassen Sie sich auf statistische Muster, um Schlussfolgerungen zu ziehen. Da es schwierig ist, einen logischen Schlussfolgerungsdatensatz zu erstellen, der keine statistischen Merkmale enthält, ist es schwierig, Schlussfolgerungen aus Daten zu ziehen. Sprachmodelle-logisches-Argumentieren/

Das obige ist der detaillierte Inhalt vonStudie zeigt, dass große Sprachmodelle Probleme mit dem logischen Denken haben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!