Heim >Backend-Entwicklung >Python-Tutorial >Holen Sie sich Daten aus dem Internet mit Excel und Python

Holen Sie sich Daten aus dem Internet mit Excel und Python

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-11 18:28:041305Durchsuche

Der heutige Artikel besteht hauptsächlich aus zwei Teilen. Der erste Teil besteht darin, eine Daten-Website mit Python zu erstellen, und der andere darin, Excel und Python zu verwenden, um Daten von der geschriebenen Web-Website abzurufen.

1. Erstellen Sie Website-Daten zum Testen.

Erstellen Sie eine Web-Website bzw. einen Web-API-Dienst über das Python Flask Web-Framework.

1. Erstellen Sie eine Website

Erstellen Sie ein neues Python-Skript mit dem Namen „5-5-WebTable.py“, um eine einfache Webseite mit einer Tabelle zu erstellen. Wenn der Leser nicht an der Konstruktionsmethode interessiert ist, können Sie den folgenden Code überspringen und direkt das Skript „5-5-WebTable.py“ ausführen, um die Website zu öffnen.

(1) Installieren Sie das Flaschenpaket.

pip install flask

(2) Erstellen Sie eine Webseite mit einer Tabelle.

from flask import Flask

app = Flask(__name__)# 创建Falsk Web应用实例

# 将路由“/”映射到table_info函数,函数返回HTML代码

@app.route('/')

def table_info():

return """<h2>HTML表格实例,用于提供给Excel和Python读取</h2>

<table border="1">

<caption>用户信息表</caption>

<tbody><tr>

<th>姓名</th>

<th>性别</th>

<th>年龄</th>

</tr>

<tr>

<td>小米</td>

<td>女</td>

<td>22</td>

</tr>

……….

</tbody></table>"""

if __name__ == '__main__':

app.debug = True# 启用调试模式

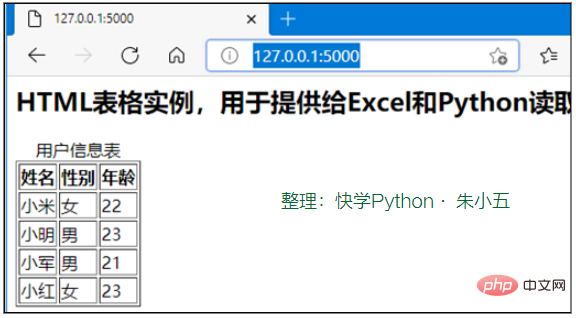

app.run()# 运行,网站端口默认为5000Starten Sie die Website über den Befehl „python ./5-5-WebTable.py“ und geben Sie dann http://127.0.0.1:5000/ in den Browser ein, wie in Abbildung 1 dargestellt Webinhalte.

Abbildung 1 Mit Flask erstellte Website testen

2. Web-API-Dienst erstellen

Erstellen Erstellen Sie ein neues Python-Skript mit dem Namen „5-5-WebAPI.py“ und verwenden Sie das Paket flask_restplus, um den Web-API-Dienst zu erstellen. Wenn der Leser nicht an der Konstruktionsmethode interessiert ist, können Sie den folgenden Code überspringen und das Skript „5-5-WebAPI.py“ direkt ausführen, um den Web-API-Dienst zu öffnen.

(1) Installieren Sie das flask_restplus-Paket.

pip install flask-restplus

(2) Importieren Sie die erforderlichen Bibliotheken und initialisieren Sie Anwendungsobjekte.

from flask import Flask

# Api类是Web API应用的入口,需要用Flask应用程序初始化

from flask_restplus import Api

# Resource类是HTTP请求的资源的基类

from flask_restplus import Resource

# fields类用于定义数据的类型和格式

from flask_restplus import fields

app = Flask(__name__)# 创建Falsk Web应用实例

# 在flask应用的基础上构建flask_restplusApi对象

api = Api(app, version='1.0',

title='Excel集成Python数据分析-测试用WebAPI',

description='测试用WebAPI', )

# 使用namespace函数生成命名空间,用于为资源分组

ns = api.namespace('ExcelPythonTest', description='Excel与Python Web API测试')

# 使用api.model函数生成模型对象

todo = api.model('task_model', {

'id': fields.Integer(readonly=True,

description='ETL任务唯一标识'),

'task': fields.String(required=True,

description='ETL任务详情')

})(3) Web-API-Datenoperationsklasse, einschließlich Methoden wie Hinzufügen, Löschen, Ändern und Abfragen.

class TodoDAO(object):

def __init__(self):

self.counter = 0

self.todos = []

def get(self, id):

for todo in self.todos:

if todo['id'] == id:

return todo

api.abort(404, "ETL任务 {} 不存在".format(id))

def create(self, data):

todo = data

todo['id'] = self.counter = self.counter + 1

self.todos.append(todo)

return todo

# 实例化数据操作,创建3条测试数据

DAO = TodoDAO()

DAO.create({'task': 'ETL-抽取数据操作'})

DAO.create({'task': 'ETL-数据清洗转换'})

DAO.create({'task': 'ETL-数据加载操作'})(4) Erstellen Sie die Routenzuordnung der Web-API.

Die HTTP-Ressourcenanforderungsklasse erbt von der Ressourcenklasse und ordnet sie dann verschiedenen Routen zu, während die HTTP-Methode angegeben wird, die verwendet werden kann.

@ns.route('/')# 路由“/”对应的资源类为TodoList,可使用get方法和post方法进行请求

class TodoList(Resource):

@ns.doc('list_todos')# @doc装饰器对应API文档的信息

@ns.marshal_list_with(todo)# @marshal_xxx装饰器对模型数据进行格式转换与输出

def get(self):# 定义get方法获取所有的任务信息

return DAO.todos

@ns.doc('create_todo')

@ns.expect(todo)

@ns.marshal_with(todo, code=201)

def post(self):# 定义post方法获取所有的任务信息

return DAO.create(api.payload), 201

# 路由/<int:id>对应的资源类为Todo,可使用get、delete、put方法进行请求

@ns.route('/<int:id>')

@ns.response(404, '未发现相关ETL任务')

@ns.param('id', 'ETL任务ID号')

class Todo(Resource):

@ns.doc('get_todo')

@ns.marshal_with(todo)

def get(self, id):

return DAO.get(id)

@ns.doc('delete_todo')

@ns.response(204, 'ETL任务已经删除')

def delete(self, id):

DAO.delete(id)

return '', 204

@ns.expect(todo)

@ns.marshal_with(todo)

def put(self, id):

return DAO.update(id, api.payload)

if __name__ == '__main__':

app.run(debug=True, port=8000)# 启动Web API服务,端口为8000(4) Starten Sie den Web-API-Dienst.

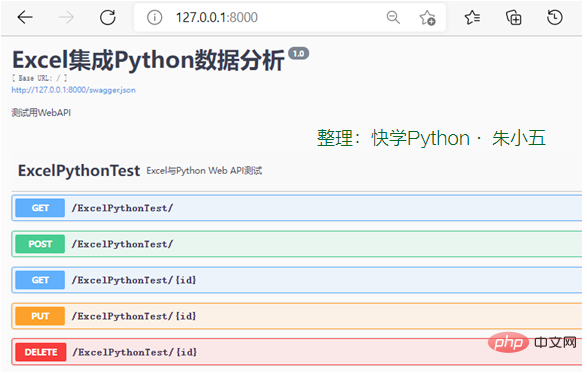

Starten Sie den Web-API-Dienst über den Befehl „python ./5-5-WebAPI.py“, geben Sie „http://127.0.0.1:8000/“ in den Browser ein und Abbildung 5- Liste der in 23 gezeigten Web-API-Dienstanforderungsmethoden.

Abbildung 2 Liste der WebAPI-Dienstanforderungsmethoden

2. Webseitendaten zum Crawlen

Excel kann Webseitendaten über die Funktion „Von Website“ auf der Registerkarte „Daten“ crawlen. Python kann die Requests-Bibliothek, das Beautiful Soup-Paket und das Scrapy-Framework zum Crawlen von Webseitendaten verwenden.

1. Holen Sie sich

über Excel. Klicken Sie auf die Funktion „Daten“ → „Aus anderen Quellen“. Es gibt Einschränkungen hinsichtlich der Webseitendaten, die Excel lesen kann: Dynamische Webseitendaten können nicht automatisch erkannt werden, und Nicht-Tabellendaten können nicht automatisch erkannt werden.

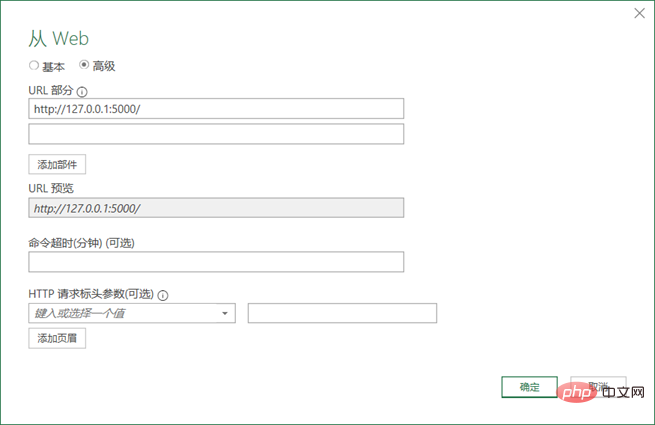

(1) Klicken Sie auf die Funktion „Daten“ → „Aus anderen Quellen“ → „Von Website“.

(2) Stellen Sie sicher, dass die in Abschnitt 5.5.1 beschriebene Website geöffnet wurde.

(3) Geben Sie die Website-URL-Adresse „http://127.0.0.1:5000/“ ein.

Klicken Sie auf die Schaltfläche „Erweitert“, um detailliertere HTTP-Anfrageinformationen zu konfigurieren. Klicken Sie dann auf die Schaltfläche „OK“, wie in Abbildung 3 dargestellt.

Abbildung 3 Konfigurieren Sie die URL zum Lesen der Website

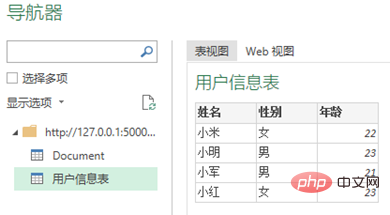

(4) Wählen Sie im Fenster „Navigator“ Importdaten aus.

Wie in Abbildung 4 gezeigt, erkennt Excel automatisch die Tabellendaten auf der Webseite, wählt den Tabellennamen aus und klickt auf die Schaltfläche „Laden“.

Abbildung 4 Excel erkennt Tabellendaten in Webseiten automatisch

2 Verwenden Sie Python zum Crawlen

#🎜 🎜#Im Folgenden wird die Verwendung der Anforderungsbibliothek zum Erfassen von Daten von der gesamten Webseite und die anschließende Verwendung von Beautiful Soup zum Parsen der Webseite veranschaulicht. Leser können sich zum Lernen auf die Codematerialdatei „5-5-web.ipynb“ in diesem Buch beziehen. (1) Webseitendaten durch Anfragen lesen.import requests #导入requests包 url ='http://127.0.0.1:5000/' strhtml= requests.get(url) #使用get方法请求网页数据(2) Analysieren Sie Webseiten mit Beautiful Soup.

from bs4 import BeautifulSoup

soup = BeautifulSoup(strhtml.text)# 将网页内容作为参数,创建soup对象

table = soup.find('table')# 查找网页中的table元素

table_body = table.find('tbody')# 查找table元素中的tbody元素

data = []

rows = table_body.find_all('tr')# 查找表中的所有tr元素

for row in rows:# 遍历数据

cols = row.find_all('td')

cols = [ele.text.strip() for ele in cols]

data.append([ele for ele in cols if ele])

# 结果输出:[[],

['小米', '女', '22'],['小明','男','23'],……3. Web-API-Dienst aufrufen Excel kann den Web-API-Dienst über die Funktion „Selbstwebsite“ unter der Registerkarte „Daten“ aufrufen. Python kann die Anforderungsbibliothek, das Beautiful Soup-Paket und das Scrapy-Framework verwenden, um die Web-API aufzurufen und Daten abzurufen. 1. Verwenden Sie Excel, um aufzurufen. (1) Stellen Sie sicher, dass der in Abschnitt 5.5.1 beschriebene Web-API-Dienst gestartet wurde. (2) Geben Sie die URL ein, die der Web-API-Methode entspricht: http://127.0.0.1:8000/ExcelPythonTest/. (3) Verarbeiten Sie die zurückgegebenen Daten. Nach dem Aufruf des Web-API-Dienstes werden die Daten im JSON-Format zurückgegeben und die JSON-Daten werden gemäß der in Abschnitt 5.4.3 eingeführten Methode verarbeitet. 2. Verwenden Sie Python zum Aufrufen Verwenden Sie die Anforderungsbibliothek, um die Web-API-Methode aufzurufen, und verarbeiten Sie dann die zurückgegebenen JSON-Daten. Leser können auf die Codematerialdatei verweisen. 5-5 dieses Buches" -api.ipynb" zum Lernen. import requests#导入requests包 url ='http://127.0.0.1:8000/ExcelPythonTest/' strhtml= requests.get(url)#使用get方法获取网页数据 import pandas as pd frame= pd.read_json(strhtml.text)#使用Pandas包中的read_json函数 print(frame) #结果输出: id task 0 1 ETL-抽取数据操作 1 2 ETL-数据清洗转换 2 3 ETL-数据加载操作

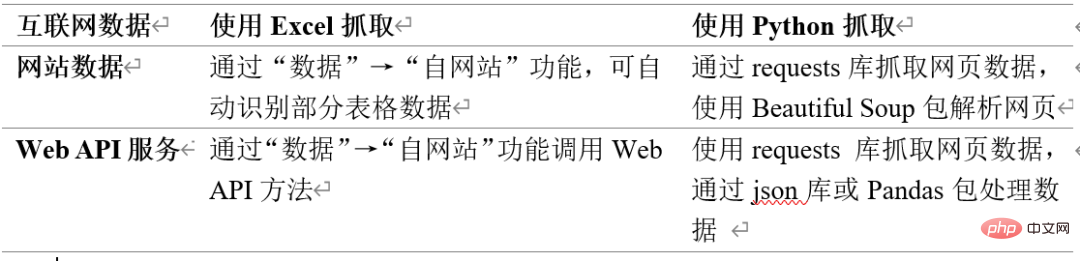

4、两种方法对比

表1所示为Excel和Python抓取互联网数据方法的对比。需要注意Excel从互联网抓取数据的功能并不完善。

表1 Excel和Python抓取互联网数据方法对比

Das obige ist der detaillierte Inhalt vonHolen Sie sich Daten aus dem Internet mit Excel und Python. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!