Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Wie ist der aktuelle Entwicklungsstand von In-Context Learning, das von GPT vorangetrieben wurde? Diese Rezension macht es deutlich

Wie ist der aktuelle Entwicklungsstand von In-Context Learning, das von GPT vorangetrieben wurde? Diese Rezension macht es deutlichMit der schrittweisen Erweiterung der Sprachmodelle und Korpusgrößen haben große Sprachmodelle (LLM) mehr Potenzial gezeigt. Einige neuere Studien haben gezeigt, dass LLM In-Context-Learning (ICL) nutzen kann, um eine Reihe komplexer Aufgaben auszuführen, beispielsweise das Lösen mathematischer Denkprobleme.

Zehn Forscher der Peking-Universität, des Shanghai AI Lab und der University of California, Santa Barbara, haben kürzlich einen Übersichtsartikel zum kontextbezogenen Lernen veröffentlicht, in dem sie den aktuellen Fortschritt der ICL-Forschung detailliert beschreiben.

Papieradresse: https://arxiv.org/pdf/2301.00234v1.pdf

Die Kernidee des kontextbezogenen Lernens ist das Analogielernen. Die folgende Abbildung beschreibt, wie das Das Sprachmodell verwendet ICL. Treffen Sie Entscheidungen.

Erstens erfordert ICL einige Beispiele, um einen Demonstrationskontext zu bilden, und diese Beispiele werden normalerweise in natürlichsprachlichen Vorlagen geschrieben. ICL ordnet dann die Abfragefrage dem Präsentationskontext zu, um eine Eingabeaufforderung zu bilden, und speist sie zur Vorhersage in ein Sprachmodell ein. Im Gegensatz zur Trainingsphase des überwachten Lernens, bei der die Aktualisierung der Modellparameter mithilfe umgekehrter Gradienten erforderlich ist, sind bei ICL keine Parameteraktualisierungen erforderlich, damit das vorab trainierte Sprachmodell Vorhersageaufgaben direkt ausführen kann, und es wird erwartet, dass das Modell die verborgenen Muster in der Demonstration lernt Beispiele und treffen Sie Entscheidungen auf der Grundlage dieser.

Als neues Paradigma bietet ICL viele attraktive Vorteile. Erstens sind die Demobeispiele in einem natürlichen Sprachformat geschrieben, das eine interpretierbare Schnittstelle für die Verknüpfung mit großen Sprachmodellen bietet. Dieses Paradigma macht es einfacher, menschliches Wissen in Sprachmodelle zu integrieren, indem Demonstrationsbeispiele und Vorlagen geändert werden (Liu et al., 2022; Lu et al., 2022; Wu et al., 2022; Wei et al., 2022c). Zweitens ähnelt das Lernen im Kontext dem Entscheidungsprozess des menschlichen Lernens durch Analogie. Drittens handelt es sich bei ICL im Vergleich zu überwachtem Training um ein ausbildungsfreies Lernkonzept. Dies kann nicht nur den Rechenaufwand für die Anpassung des Modells an neue Aufgaben erheblich reduzieren, sondern auch Language Model as a Service (LMaaS, Sun et al., 2022) ermöglichen und einfach auf groß angelegte reale Aufgaben anwenden.

Obwohl ICL vielversprechend ist, gibt es dennoch viele Aspekte, die es wert sind, untersucht zu werden, einschließlich seiner Leistung. Beispielsweise verfügt das ursprüngliche GPT-3-Modell über bestimmte ICL-Fähigkeiten, einige Studien haben jedoch ergeben, dass diese Fähigkeit durch Anpassung während des Vortrainings erheblich verbessert werden kann. Darüber hinaus hängt die Leistung von ICL von bestimmten Einstellungen ab, einschließlich Eingabeaufforderungsvorlagen, kontextbezogener Probenauswahl und Probenreihenfolge. Obwohl der Wirkmechanismus von ICL vernünftig erscheint, ist er noch nicht klar genug und es gibt nicht viele Studien, die seinen Wirkmechanismus vorläufig erklären können.

Dieses Übersichtspapier kommt zu dem Schluss, dass die starke Leistung von ICL auf zwei Phasen beruht:

- Die Trainingsphase zur Kultivierung der ICL-Fähigkeiten großer Sprachmodelle;

- Das große Sprachmodell prognostiziert basierend auf einer bestimmten Aufgabe Demonstrationen Argumentationsphase.

In der Trainingsphase wird das Sprachmodell direkt entsprechend den Sprachmodellierungszielen trainiert, beispielsweise der Links-nach-rechts-Generierung. Obwohl diese Modelle nicht speziell für das Lernen im Kontext optimiert sind, sind die Fähigkeiten von ICL dennoch überraschend. Die bestehende ICL-Forschung basiert grundsätzlich auf gut trainierten Sprachmodellen.

Da in der Inferenzphase die Eingabe- und Ausgabebezeichnungen durch interpretierbare Vorlagen in natürlicher Sprache dargestellt werden, kann die ICL-Leistung aus mehreren Perspektiven optimiert werden. Dieses Übersichtspapier bietet eine detaillierte Beschreibung und einen Vergleich, wählt geeignete Beispiele zur Demonstration aus und entwirft spezifische Bewertungsmethoden für verschiedene Aufgaben.

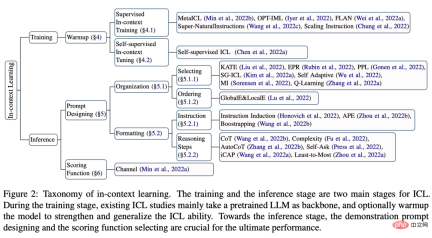

Der allgemeine Inhalt und die Struktur dieses Übersichtsartikels sind in der folgenden Abbildung dargestellt, einschließlich: der formalen Definition von ICL (§3), der Aufwärmmethode (§4), der Prompt-Design-Strategie (§5) und der Bewertungsfunktion ( §6) .

Darüber hinaus bietet §7 Einblick in die aktuelle Suche nach der Aufklärung der Funktionsweise von ICLs. §8 stellt darüber hinaus nützliche Bewertungen und Ressourcen für ICL bereit und §9 stellt mögliche Anwendungsszenarien vor, die die Wirksamkeit von ICL demonstrieren. Abschließend fasst §10 die bestehenden Herausforderungen und potenziellen Richtungen im ICL-Bereich zusammen, um eine Referenz für die weitere Entwicklung des Bereichs zu bieten.

Interessierte Leser können den Originaltext des Artikels lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonWie ist der aktuelle Entwicklungsstand von In-Context Learning, das von GPT vorangetrieben wurde? Diese Rezension macht es deutlich. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lassen Sie uns tanzen: Strukturierte Bewegung, um unsere menschlichen neuronalen Netze zu optimierenApr 27, 2025 am 11:09 AM

Lassen Sie uns tanzen: Strukturierte Bewegung, um unsere menschlichen neuronalen Netze zu optimierenApr 27, 2025 am 11:09 AMWissenschaftler haben ausführlich menschliche und einfachere neuronale Netzwerke (wie die in C. elegans) untersucht, um ihre Funktionalität zu verstehen. Es stellt sich jedoch eine entscheidende Frage: Wie passen wir unsere eigenen neuronalen Netze an, um neben neuartigen Ai S effektiv zu arbeiten

Neues Google Leak zeigt Abonnementänderungen für Gemini AIApr 27, 2025 am 11:08 AM

Neues Google Leak zeigt Abonnementänderungen für Gemini AIApr 27, 2025 am 11:08 AMGoogles Gemini Advanced: Neue Abonnements am Horizont Der Zugriff auf Gemini Advanced erfordert derzeit einen Google One AI -Premium -Plan von 19,99 USD/Monat. Ein Bericht von Android Authority hat jedoch auf bevorstehende Änderungen hinweist. Code im neuesten Google P.

Wie die Beschleunigung der Datenanalyse löst den versteckten Engpass von AIApr 27, 2025 am 11:07 AM

Wie die Beschleunigung der Datenanalyse löst den versteckten Engpass von AIApr 27, 2025 am 11:07 AMTrotz des Hype um fortgeschrittene KI -Funktionen lauert eine erhebliche Herausforderung in den Bereitstellungen von Enterprise AI: Datenverarbeitung Engpässe. Während CEOs KI -Fortschritte feiern, kreischen sich die Ingenieure mit langsamen Abfragen, überladenen Pipelines, a

Markitdown MCP kann jedes Dokument in Markdowns umwandeln!Apr 27, 2025 am 09:47 AM

Markitdown MCP kann jedes Dokument in Markdowns umwandeln!Apr 27, 2025 am 09:47 AMUm Dokumente zu handeln, geht es nicht mehr nur darum, Dateien in Ihren KI -Projekten zu öffnen, sondern darum, das Chaos in Klarheit zu verwandeln. Dokumente wie PDFs, Powerpoints und Wort überfluten unsere Workflows in jeder Form und Größe. Strukturiert abrufen

Wie benutze ich Google ADK für Bauagenten? - Analytics VidhyaApr 27, 2025 am 09:42 AM

Wie benutze ich Google ADK für Bauagenten? - Analytics VidhyaApr 27, 2025 am 09:42 AMNutzen Sie die Macht des Google Agent Development Kit (ADK), um intelligente Agenten mit realen Funktionen zu erstellen! Dieses Tutorial führt Sie durch den Bau von Konversationsagenten mit ADK und unterstützt verschiedene Sprachmodelle wie Gemini und GPT. W

Verwendung von SLM über LLM für eine effektive Problemlösung - Analytics VidhyaApr 27, 2025 am 09:27 AM

Verwendung von SLM über LLM für eine effektive Problemlösung - Analytics VidhyaApr 27, 2025 am 09:27 AMZusammenfassung: SLM (Small Language Model) ist für die Effizienz ausgelegt. Sie sind besser als das große Sprachmodell (LLM) in Ressourcenmangel-, Echtzeit- und Datenschutz-sensitiven Umgebungen. Am besten für fokussierte Aufgaben, insbesondere für Domänenspezifität, -kontrollierbarkeit und Interpretierbarkeit wichtiger als allgemeines Wissen oder Kreativität. SLMs sind kein Ersatz für LLMs, aber sie sind ideal, wenn Präzision, Geschwindigkeit und Kostenwirksamkeit kritisch sind. Technologie hilft uns, mehr mit weniger Ressourcen zu erreichen. Es war schon immer ein Promoter, kein Fahrer. Von der Dampfmaschine -Ära bis zur Internetblase -Ära liegt die Kraft der Technologie in dem Ausmaß, in dem sie uns hilft, Probleme zu lösen. Künstliche Intelligenz (KI) und in jüngerer Zeit generativer KI sind keine Ausnahme

Wie benutze ich Google Gemini -Modelle für Computer Vision -Aufgaben? - Analytics VidhyaApr 27, 2025 am 09:26 AM

Wie benutze ich Google Gemini -Modelle für Computer Vision -Aufgaben? - Analytics VidhyaApr 27, 2025 am 09:26 AMNutzen Sie die Kraft von Google Gemini für Computer Vision: einen umfassenden Leitfaden Google Gemini, ein führender KI -Chatbot, erweitert seine Fähigkeiten über die Konversation hinaus, um leistungsstarke Funktionen von Computer Visionen zu umfassen. In dieser Anleitung wird beschrieben, wie man verwendet wird

Gemini 2.0 Flash gegen O4-Mini: Kann Google besser als OpenAI machen?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash gegen O4-Mini: Kann Google besser als OpenAI machen?Apr 27, 2025 am 09:20 AMDie KI-Landschaft von 2025 ist mit der Ankunft von Googles Gemini 2.0 Flash und Openai's O4-Mini elektrisierend. Diese modernen Modelle, die in Abstand von Wochen veröffentlicht wurden, bieten vergleichbare fortschrittliche Funktionen und beeindruckende Benchmark-Ergebnisse. Diese eingehende Vergleiche

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Herunterladen der Mac-Version des Atom-Editors

Der beliebteste Open-Source-Editor

Dreamweaver CS6

Visuelle Webentwicklungstools

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

Dreamweaver Mac

Visuelle Webentwicklungstools

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!