Heim >Technologie-Peripheriegeräte >KI >Stanford/Google Brain: Doppelte Destillation und geführte Diffusionsmodell-Probenahme beschleunigen sich um das 256-fache!

Stanford/Google Brain: Doppelte Destillation und geführte Diffusionsmodell-Probenahme beschleunigen sich um das 256-fache!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 18:51:011680Durchsuche

In letzter Zeit erwiesen sich klassifikatorfreie geführte Diffusionsmodelle als sehr effektiv bei der Erzeugung hochauflösender Bilder und wurden häufig in groß angelegten Diffusionsframeworks verwendet, darunter DALL-E 2. GLIDE und Imagen.

Ein Nachteil klassifikatorfreier geführter Diffusionsmodelle besteht jedoch darin, dass sie zum Zeitpunkt der Inferenz rechenintensiv sind. Denn sie erfordern die hunderte Evaluierung zweier Diffusionsmodelle – eines klassenbedingten Modells und eines unbedingten Modells.

Um dieses Problem zu lösen, schlugen Wissenschaftler der Stanford University und Google Brain vor, eine zweistufige Destillationsmethode zu verwenden, um das klassifikatorfreie geführte Diffusionsmodell zu verbessern Effizienz.

Papieradresse: https://arxiv.org/abs/2210.03142

Wie verfeinert man das klassifikatorfreie geführte Diffusionsmodell zu einem schnellen Stichprobenmodell?

Zunächst lernten die Forscher für ein vorab trainiertes klassifikatorfreies Leitmodell zunächst ein einzelnes Modell, das mit der kombinierten Ausgabe des bedingten Modells und des unbedingten Modells übereinstimmt.

Die Forscher destillierten dieses Modell dann schrittweise zu einem Diffusionsmodell mit weniger Probenahmeschritten.

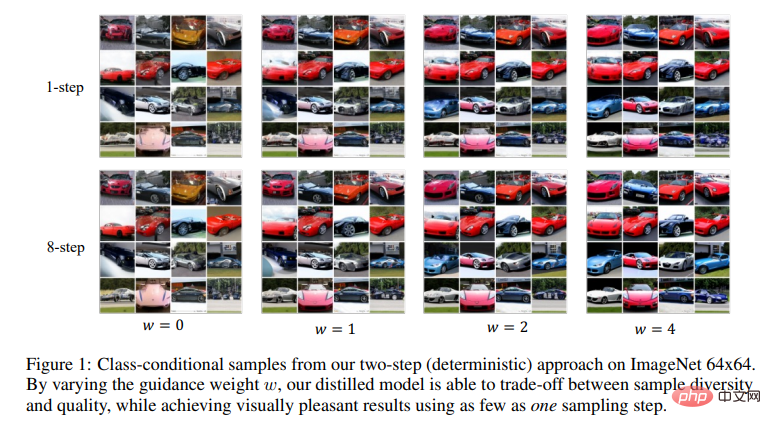

Es ist ersichtlich, dass diese Methode auf ImageNet 64x64 und CIFAR-10 Bilder erzeugen kann, die visuell mit dem Originalmodell vergleichbar sind.

Mit nur 4 Abtastschritten können mit dem Originalmodell vergleichbare FID/IS-Werte erzielt werden, während die Abtastgeschwindigkeit bis zu 256-mal beträgt.

Es ist ersichtlich, dass durch Ändern des Führungsgewichts w das vom Forscher destillierte Modell die Probe verbessern kann Diversität und Qualitätskompromisse zwischen ihnen. Und mit nur einem Bemusterungsschritt werden optisch ansprechende Ergebnisse erzielt.

Hintergrund des Diffusionsmodells

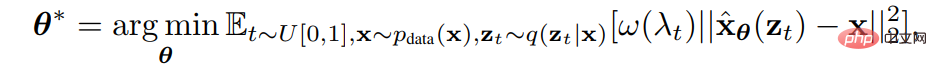

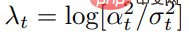

Mit Stichproben x aus der Datenverteilung , die Rauschplanungsfunktion

, die Rauschplanungsfunktion Forscher minimieren die gewichtete Varianz Wird verwendet, um ein Diffusionsmodell

Forscher minimieren die gewichtete Varianz Wird verwendet, um ein Diffusionsmodell  mit den Parametern θ zu trainieren.

mit den Parametern θ zu trainieren.

wobei  das Signal-Rausch-Verhältnis ist,

das Signal-Rausch-Verhältnis ist,  und

und  sind vorgegebene Gewichtungsfunktionen.

sind vorgegebene Gewichtungsfunktionen.

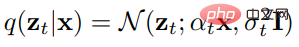

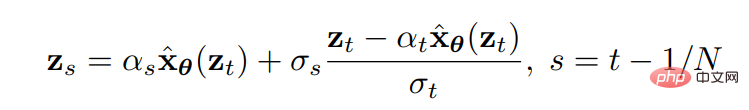

Sobald das Diffusionsmodell trainiert wurde, können Sie mit dem zeitdiskreten DDIM-Sampler Proben aus dem Modell entnehmen.  Konkret beginnt der DDIM-Sampler bei z1 ∼ N (0,I) und wird wie folgt aktualisiert

Konkret beginnt der DDIM-Sampler bei z1 ∼ N (0,I) und wird wie folgt aktualisiert

wobei N die Gesamtzahl der Abtastschritte ist. Mit  wird die endgültige Probe generiert.

wird die endgültige Probe generiert.

Klassifikatorfreie Anleitung ist eine effektive Methode, die die Probenqualität von Modellen mit bedingter Diffusion erheblich verbessern kann und wird häufig verwendet, einschließlich GLIDE, DALL·E 2 und Imagen.

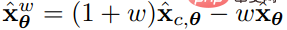

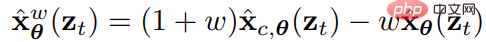

Es führt einen Leitgewichtsparameter ein, um die Qualität und Vielfalt von Proben zu messen. Um Stichproben zu generieren, verwendet die klassifikatorfreie Führung

ein, um die Qualität und Vielfalt von Proben zu messen. Um Stichproben zu generieren, verwendet die klassifikatorfreie Führung  als Vorhersagemodell bei jedem Aktualisierungsschritt, um das bedingte Diffusionsmodell

als Vorhersagemodell bei jedem Aktualisierungsschritt, um das bedingte Diffusionsmodell  und das gemeinsam trainierte

und das gemeinsam trainierte  zu bewerten.

zu bewerten.

Die Probenahme unter Verwendung einer klassifikatorfreien Führung ist oft teuer, da jede Aktualisierung der Probenahme die Bewertung von zwei Diffusionsmodellen erfordert.

Um dieses Problem zu lösen, verwendeten die Forscher die progressive Destillation, eine Methode zur Erhöhung der Abtastgeschwindigkeit des Diffusionsmodells durch wiederholte Destillation.

Bisher konnte diese Methode weder direkt für die Destillation geführter Modelle verwendet werden, noch konnte sie auf anderen Samplern als deterministischen DDIM-Samplern verwendet werden. In diesem Artikel haben die Forscher diese Probleme gelöst.

Destillation des klassifikatorfreien geführten Diffusionsmodells

Ihre Methode besteht darin, das klassifikatorfreie geführte Diffusionsmodell zu destillieren.

Für ein ausgebildetes, von Lehrern geleitetes Modell  unternehmen sie zwei Schritte.

unternehmen sie zwei Schritte.

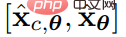

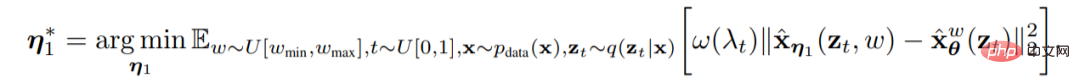

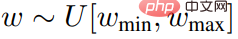

Im ersten Schritt führte der Forscher ein zeitkontinuierliches Schülermodell ein , das über einen lernbaren Parameter η1 verfügt, der zu jedem Zeitpunkt Schritt t ∈ [0, 1] mit der Ausgabe des Lehrermodells übereinstimmt. Nachdem sie eine Reihe von Unterrichtsintensitäten

, das über einen lernbaren Parameter η1 verfügt, der zu jedem Zeitpunkt Schritt t ∈ [0, 1] mit der Ausgabe des Lehrermodells übereinstimmt. Nachdem sie eine Reihe von Unterrichtsintensitäten  angegeben hatten, an denen sie interessiert waren, nutzten sie die folgenden Ziele, um das Schülermodell zu optimieren.

angegeben hatten, an denen sie interessiert waren, nutzten sie die folgenden Ziele, um das Schülermodell zu optimieren.

Welche  .

.

Um das Führungsgewicht w zu kombinieren, führte der Forscher das w-Bedingungsmodell ein, wobei w als Eingabe des Studentenmodells dient. Um die Merkmale besser zu erfassen, wandten sie die Fourier-Einbettung w an und bauten sie dann mithilfe der von Kingma et al. verwendeten Zeitschrittmethode in das Rückgrat des Diffusionsmodells ein.

Da die Initialisierung eine Schlüsselrolle für die Leistung spielt, verwendeten die Forscher bei der Initialisierung des Schülermodells dieselben Parameter wie das Lehrerbedingungsmodell (mit Ausnahme der neu eingeführten Parameter im Zusammenhang mit der W-Konditionierung).

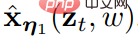

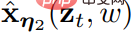

Im zweiten Schritt stellte sich der Forscher ein diskretes Zeitschrittszenario vor und halbierte jedes Mal die Anzahl der Probenahmeschritte und destillierte nach und nach Lernmodell vom ersten Schritt  in ein Lernmodell

in ein Lernmodell  mit lernbaren Parametern η2 und weniger Schritten.

mit lernbaren Parametern η2 und weniger Schritten.

wobei N die Anzahl der Abtastschritte darstellt, für  und

und  #🎜 🎜 #, der Forscher begann, das Schülermodell so zu trainieren, dass es einen Schritt verwendet, um mit der Ausgabe der zweistufigen DDIM-Stichprobe des Lehrermodells übereinzustimmen (zum Beispiel: von t/N bis t – 0,5/N, von t – 0,5). /N bis t - 1/ N).

#🎜 🎜 #, der Forscher begann, das Schülermodell so zu trainieren, dass es einen Schritt verwendet, um mit der Ausgabe der zweistufigen DDIM-Stichprobe des Lehrermodells übereinzustimmen (zum Beispiel: von t/N bis t – 0,5/N, von t – 0,5). /N bis t - 1/ N).

Nachdem wir die 2N Schritte im Lehrermodell in N Schritte im Schülermodell destilliert haben, können wir das neue N-stufige Schülermodell als neues Lehrermodell verwenden, und Wiederholen Sie dann den gleichen Vorgang, um das Lehrermodell in ein N/2-stufiges Schülermodell zu destillieren. Bei jedem Schritt initialisieren die Forscher das chemische Modell mithilfe der Parameter des Lehrermodells. Nr Modell

ist trainiert, fürkann der Forscher die Regeln aktualisieren, um Stichproben über DDIM durchzuführen. Die Forscher stellten fest, dass dieser Probenahmeprozess für das Destillationsmodell

angesichts der Initialisierung deterministisch ist.

Darüber hinaus können Forscher auch N-stufige Zufallsstichproben durchführen. Verwenden Sie einen deterministischen Abtastschritt, der doppelt so groß ist wie die ursprüngliche Schrittgröße (d. h. derselbe wie beim deterministischen N/2-Schritt-Sampler) und machen Sie dann einen zufälligen Schritt zurück (d. h. stören Sie ihn mit Rauschen), indem Sie die ursprüngliche Schrittgröße verwenden.

Darüber hinaus können Forscher auch N-stufige Zufallsstichproben durchführen. Verwenden Sie einen deterministischen Abtastschritt, der doppelt so groß ist wie die ursprüngliche Schrittgröße (d. h. derselbe wie beim deterministischen N/2-Schritt-Sampler) und machen Sie dann einen zufälligen Schritt zurück (d. h. stören Sie ihn mit Rauschen), indem Sie die ursprüngliche Schrittgröße verwenden.  , wenn t > 1/N, können die folgenden Aktualisierungsregeln verwendet werden -

, wenn t > 1/N, können die folgenden Aktualisierungsregeln verwendet werden -  #🎜 🎜#

#🎜 🎜#

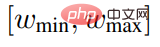

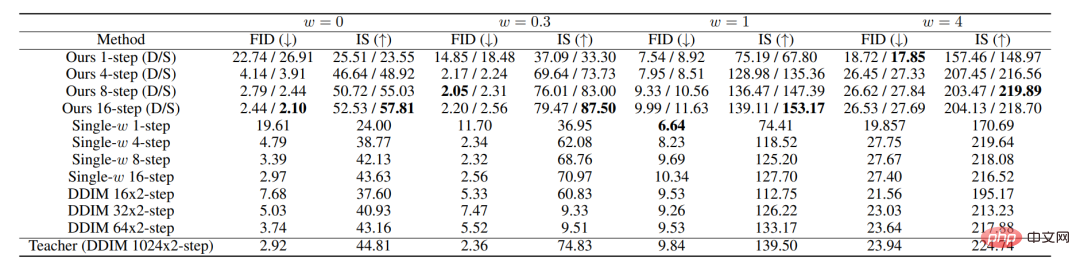

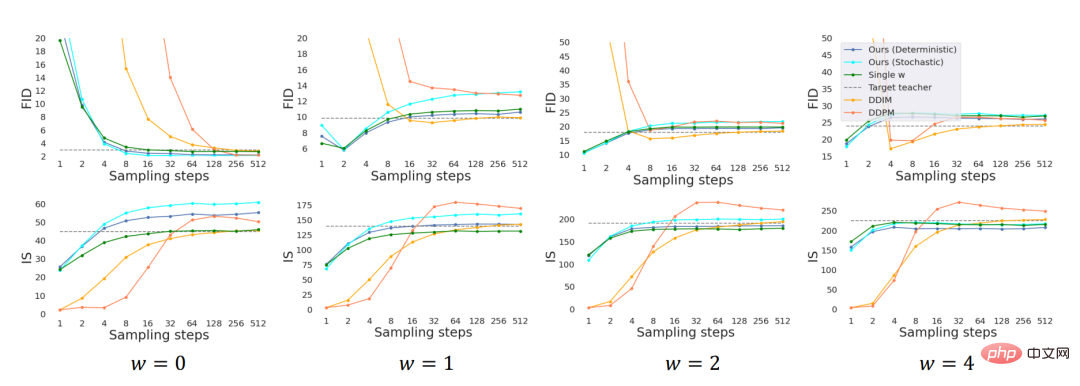

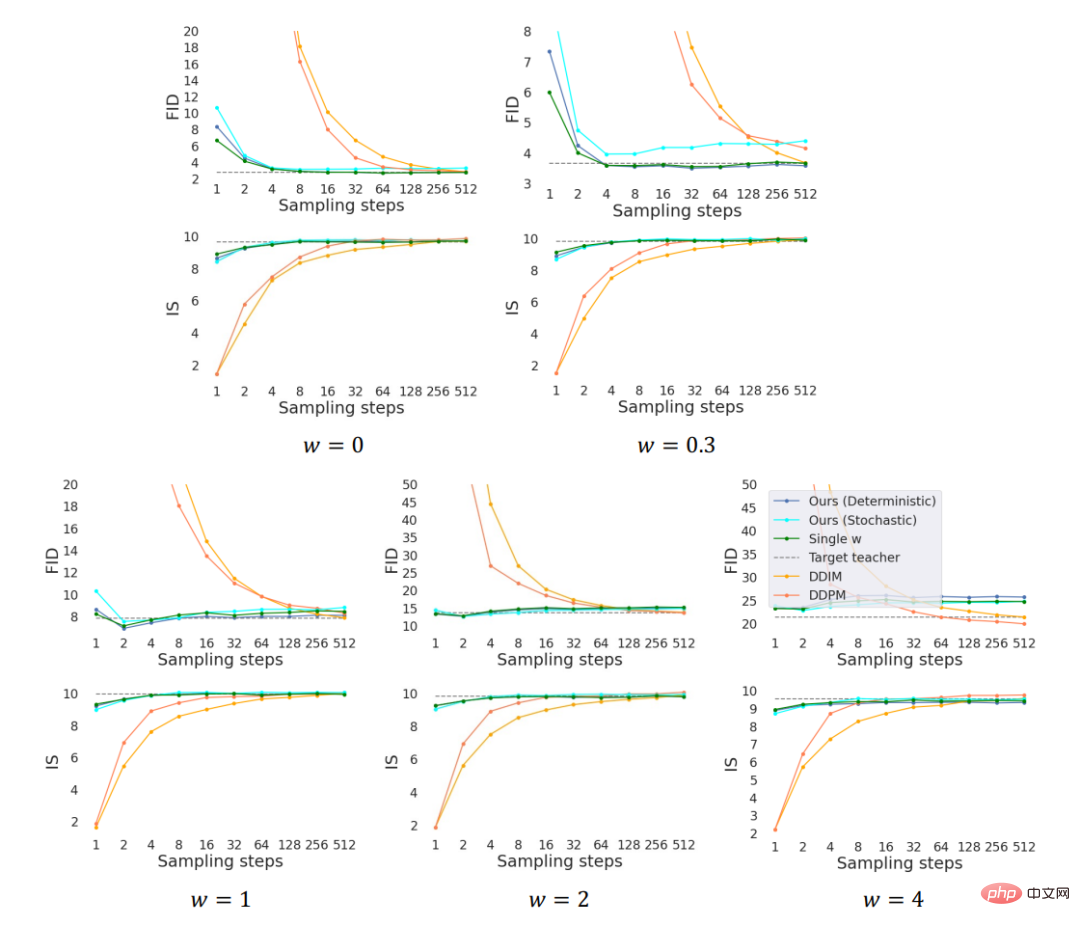

Unter ihnen

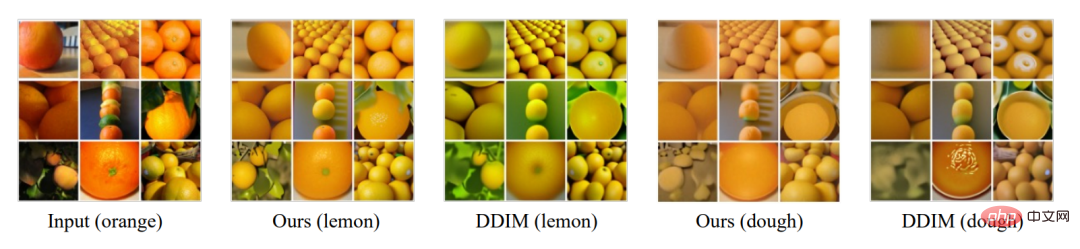

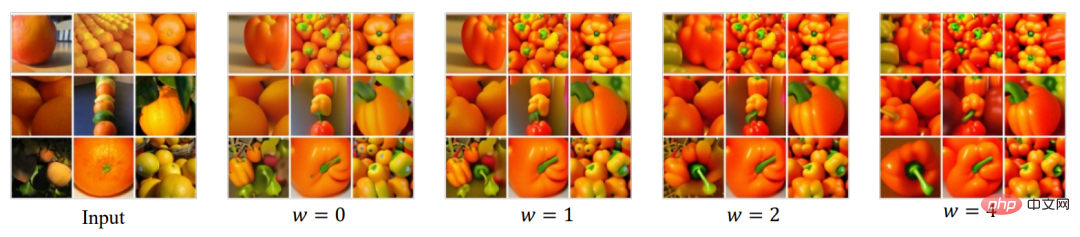

. Wenn t=1/N, verwendet der Forscher die deterministische Aktualisierungsformel, um Es ist erwähnenswert, dass wir beachten, dass die Durchführung von Zufallsstichproben die Auswertung des Modells in etwas anderen Zeitschritten im Vergleich zu einem deterministischen Sampler erfordert und kleine Änderungen am Trainingsalgorithmus für Randfälle erfordert. Andere Destillationsmethoden Es gibt auch eine Methode, die progressive Destillation direkt auf das Anleitungsmodell anzuwenden, dh der Struktur des Lehrermodells zu folgen und das Lernmodell direkt in eine gemeinsame Trainingsbedingung zu destillieren und bedingungslose Modelle. Nachdem Forscher es ausprobiert hatten, stellten sie fest, dass diese Methode nicht wirksam war. Modellexperimente wurden mit zwei Standarddatensätzen durchgeführt: ImageNet (64*64) und CIFAR 10. Im Experiment wurden verschiedene Bereiche des Führungsgewichts w untersucht, und es wurde festgestellt, dass alle Bereiche vergleichbar waren, sodass für das Experiment [wmin, wmax] = [0, 4] verwendet wurde. Die Modelle des ersten und zweiten Schritts werden mithilfe des Signal-Rausch-Verlusts trainiert. Zu den Grundstandards gehören DDPM-Ancestral-Sampling und DDIM-Sampling. Um besser zu verstehen, wie das Führungsgewicht w einzubeziehen ist, wird ein mit einem festen w-Wert trainiertes Modell als Referenz verwendet. Für einen fairen Vergleich verwendet das Experiment für alle Methoden dasselbe vorab trainierte Lehrermodell. Unter Verwendung der U-Net-Architektur (Ronneberger et al., 2015) als Basis und unter Verwendung desselben U-Net-Backbones wird eine Struktur mit darin eingebettetem w als zweistufiges Studentenmodell eingeführt. Das obige Bild zeigt die Leistung aller Methoden auf ImageNet 64x64. wobei D und S deterministische bzw. stochastische Sampler darstellen. Im Experiment verlief das Modelltraining unter der Bedingung des Führungsintervalls w∈[0, 4] äquivalent zum Modelltraining mit w als festem Wert. Bei weniger Schritten übertrifft unsere Methode die DDIM-Basisleistung deutlich und erreicht im Wesentlichen das Leistungsniveau des Lehrermodells bei 8 bis 16 Schritten. ImageNet 64x64-Stichprobenqualität, bewertet anhand von FID- und IS-Werten CIFAR-10-Stichprobenqualität, bewertet anhand von FID- und IS-Werten . Wir haben auch Lehrermodelle Die Kodierung Der Prozess wurde destilliert und Experimente zur Stilübertragung durchgeführt. Um insbesondere eine Stilübertragung zwischen zwei Domänen A und B durchzuführen, werden Bilder aus Domäne A mithilfe eines Diffusionsmodells codiert, das auf Domäne A trainiert wurde, und dann mithilfe eines Diffusionsmodells decodiert, das auf Domäne B trainiert wurde. Da der Codierungsprozess als invertierter DDIM-Abtastprozess verstanden werden kann, haben wir sowohl den Encoder als auch den Decoder mit klassifikatorfreier Führung destilliert und ihn mit dem DDIM-Encoder und -Decoder verglichen, wie in der Abbildung oben gezeigt. Wir untersuchen auch die Auswirkungen von Änderungen an der Boot-Stärke w auf die Leistung. Zusammenfassend schlagen wir eine Destillationsmethode für geführte Diffusionsmodelle und einen Zufallsprobenehmer zur Probenahme aus dem destillierten Modell vor. Empirisch gesehen erreicht unsere Methode in nur einem Schritt eine visuell hohe Erfahrungsstichprobe und erzielt in nur 8 bis 16 Schritten FID/IS-Werte, die mit denen von Lehrern vergleichbar sind.

aus

aus  abzuleiten.

abzuleiten. Experimente und Schlussfolgerungen

Das obige ist der detaillierte Inhalt vonStanford/Google Brain: Doppelte Destillation und geführte Diffusionsmodell-Probenahme beschleunigen sich um das 256-fache!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Meinung: KI-gesteuerte Technologie schafft neue Wege

- [KI-Frontstation] Bitte beaufsichtigen Sie uns! Der CEO von OpenAI weist erneut auf die Risiken der Branche der künstlichen Intelligenz hin

- Unterstützt durch digitale Intelligenz dringt die intelligente iPurchase AI-Kollektion tief in die Yiwu Clothing Expo ein, Innovation führt zur intelligenten Schaffung einer neuen Zukunft

- Xiaomi veröffentlicht den Roboter CyberDog 2

- Das neue Altair HyperWorks 2023 beinhaltet KI-Technologie