Heim >Technologie-Peripheriegeräte >KI >Meta AI unter LeCun setzt auf Selbstüberwachung

Meta AI unter LeCun setzt auf Selbstüberwachung

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBnach vorne

- 2023-04-09 09:01:031379Durchsuche

Ist selbstüberwachtes Lernen wirklich ein wichtiger Schritt in Richtung AGI?

Der KI-Chefwissenschaftler von Meta, Yann LeCun, vergaß die langfristigen Ziele nicht, als er von „konkreten Maßnahmen, die in diesem Moment zu ergreifen sind“ sprach. In einem Interview sagte er: „Wir wollen intelligente Maschinen bauen, die wie Tiere und Menschen lernen.“ In den letzten Jahren hat Meta eine Reihe von Artikeln zum selbstüberwachten Lernen (SSL) von KI-Systemen veröffentlicht. LeCun ist fest davon überzeugt, dass SSL eine notwendige Voraussetzung für KI-Systeme ist, die KI-Systemen dabei helfen kann, Weltmodelle zu erstellen, um menschenähnliche Fähigkeiten wie Rationalität, gesunden Menschenverstand und die Fähigkeit zu erlangen, Fähigkeiten und Wissen von einer Umgebung in eine andere zu übertragen.

Ihr neuer Artikel zeigt, wie ein selbstüberwachtes System namens Masked Autoencoder (MAE) lernen kann, Bilder, Videos und sogar Audio aus sehr fragmentierten, unvollständigen Daten zu rekonstruieren. Obwohl MAEs keine neue Idee sind, hat Meta diese Arbeit auf neue Bereiche ausgeweitet.

LeCun sagte, dass MAE-Systeme durch die Untersuchung, wie fehlende Daten vorhergesagt werden können, seien es Standbilder oder Video- oder Audiosequenzen, ein Modell der Welt erstellen. Er sagte: „Wenn es vorhersagen kann, was im Video passieren wird, muss es verstehen, dass die Welt dreidimensional ist, dass einige Objekte unbelebt sind und sich nicht von selbst bewegen und andere Objekte lebendig und schwer vorherzusagen sind.“ , bis zur Vorhersage Komplexes Verhalten von Lebewesen.“ Sobald ein KI-System über ein genaues Modell der Welt verfügt, kann es dieses Modell zur Planung von Aktionen verwenden.

LeCun sagte: „Das Wesen der Intelligenz besteht darin, Vorhersagen zu lernen.“ Obwohl er nicht behauptete, dass Metas MAE-System der allgemeinen künstlichen Intelligenz nahe kommt, glaubt er, dass es ein wichtiger Schritt in Richtung allgemeiner künstlicher Intelligenz ist.

Aber nicht alle sind sich einig, dass Metaforscher auf dem richtigen Weg zur allgemeinen künstlichen Intelligenz sind. Yoshua Bengio führt manchmal freundschaftliche Debatten mit LeCun über große Ideen in der KI. In einer E-Mail an IEEE Spectrum erläuterte Bengio einige der Unterschiede und Gemeinsamkeiten ihrer Ziele.

Bengio schrieb: „Ich glaube wirklich nicht, dass unsere aktuellen Methoden (ob selbstüberwacht oder nicht) ausreichen, um die Lücke zwischen künstlicher und menschlicher Intelligenz zu schließen.“ Er sagte, dass das Feld „qualitative Fortschritte“ machen müsse Technologie wirklich fördern nähert sich der künstlichen Intelligenz im menschlichen Maßstab.

Bengio stimmt mit LeCuns Ansicht überein, dass „die Fähigkeit, über die Welt nachzudenken, das Kernelement der Intelligenz ist.“ Sein Team konzentriert sich jedoch nicht auf Modelle, die Vorhersagen treffen können, sondern auf Modelle, die die Welt in natürlicher Sprache vorhersagen können Modell, das Wissen in einer Form darstellt. Er wies darauf hin, dass solche Modelle es uns ermöglichen würden, diese Erkenntnisse zu kombinieren, um neue Probleme zu lösen, kontrafaktische Simulationen durchzuführen oder mögliche Zukünfte zu untersuchen. Bengios Team entwickelte ein neues neuronales Netzwerk-Framework, das modularer ist als das von LeCun favorisierte, das sich mit End-to-End-Lernen beschäftigt.

Der beliebte Transformer

Metas MAE basiert auf einer neuronalen Netzwerkarchitektur namens Transformer. Diese Architektur erfreute sich zunächst im Bereich der Verarbeitung natürlicher Sprache großer Beliebtheit und wurde später auf viele Bereiche wie Computer Vision ausgeweitet.

Natürlich ist Meta nicht das erste Team, das Transformer erfolgreich für Vision-Aufgaben einsetzt. Ross Girshick, ein Forscher bei Meta AI, sagte, dass Googles Forschung zu Visual Transformer (ViT) das Meta-Team inspiriert habe: „Die Einführung der ViT-Architektur hat (uns) geholfen, einige Hindernisse zu beseitigen, die während des Experiments aufgetreten sind.“

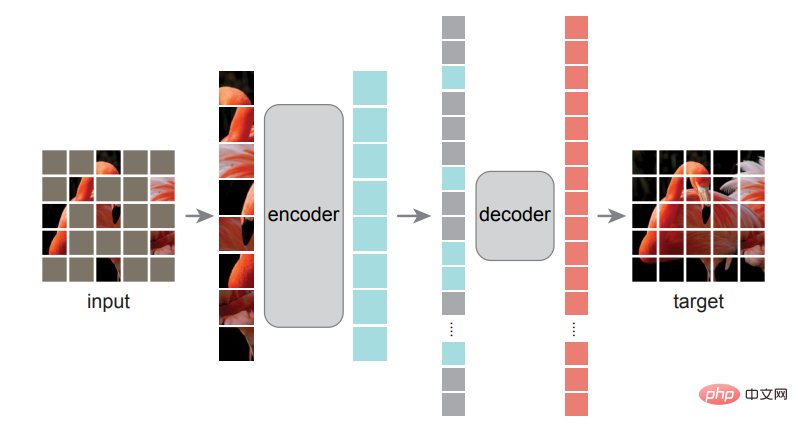

Girshick ist einer der Autoren von Metas erstem MAE-Systempapier. Einer der Autoren dieses Papiers ist He Kaiming. Sie diskutieren eine sehr einfache Methode: Maskieren Sie zufällige Blöcke des Eingabebildes und rekonstruieren Sie die fehlenden Pixel.

Das Training dieses Modells ähnelt BERT und einigen anderen Transformer-basierten Sprachmodellen. Forscher zeigen ihnen riesige Textdatenbanken, aber einige Wörter fehlen oder sind „maskiert“. Das Modell muss die fehlenden Wörter selbst vorhersagen und dann die maskierten Wörter aufdecken, damit das Modell seine Arbeit überprüfen und seine Parameter aktualisieren kann. Dieser Vorgang wiederholt sich ständig. Um optisch etwas Ähnliches zu erreichen, hat das Team das Bild in Patches aufgeteilt, dann einige der Patches maskiert und das MAE-System gebeten, die fehlenden Teile des Bildes vorherzusagen, erklärte Girshick.

Das Training dieses Modells ähnelt BERT und einigen anderen Transformer-basierten Sprachmodellen. Forscher zeigen ihnen riesige Textdatenbanken, aber einige Wörter fehlen oder sind „maskiert“. Das Modell muss die fehlenden Wörter selbst vorhersagen und dann die maskierten Wörter aufdecken, damit das Modell seine Arbeit überprüfen und seine Parameter aktualisieren kann. Dieser Vorgang wiederholt sich ständig. Um optisch etwas Ähnliches zu erreichen, hat das Team das Bild in Patches aufgeteilt, dann einige der Patches maskiert und das MAE-System gebeten, die fehlenden Teile des Bildes vorherzusagen, erklärte Girshick.

Einer der Durchbrüche des Teams war die Erkenntnis, dass die Maskierung des größten Teils des Bildes die besten Ergebnisse liefern würde, ein wesentlicher Unterschied zu Sprachtransformatoren, die möglicherweise nur 15 % der Wörter maskieren. „Sprache ist ein äußerst dichtes und effizientes Kommunikationssystem, und jedes Symbol hat eine große Bedeutung“, sagte Girshick. „Aber Bilder – diese Signale aus der natürlichen Welt – sind nicht dazu da, Redundanz zu beseitigen Komprimieren Sie den Inhalt beim Erstellen von JPG-Bildern gut

Forscher von Meta AI experimentierten damit, wie viel vom Bild maskiert werden musste, um die besten Ergebnisse zu erzielen.

Girshick erklärte, dass durch die Maskierung von mehr als 75 % der Patches im Bild Redundanzen im Bild beseitigt wurden, die die Aufgabe sonst zu trivial machen würden, um für sie geeignet zu sein Zug. Ihr zweiteiliges MAE-System verwendet zunächst einen Encoder, um die Beziehungen zwischen Pixeln aus einem Trainingsdatensatz zu lernen, und dann tut ein Decoder sein Bestes, um das Originalbild aus dem maskierten Bild zu rekonstruieren. Nach Abschluss dieses Trainingsschemas kann der Encoder auch für Bildverarbeitungsaufgaben wie Klassifizierung und Objekterkennung feinabgestimmt werden.

Girshick sagte: „Was für uns letztendlich spannend ist, ist, dass wir die Ergebnisse dieses Modells in nachgelagerten Aufgaben sehen, wenn wir den Encoder zur Erledigung von Aufgaben wie der Objekterkennung verwenden: „Wir sehen die Vorteile.“ sehr beeindruckend.“ Er wies darauf hin, dass eine weitere Erweiterung des Modells zu einer besseren Leistung führen kann, was eine mögliche Richtung für zukünftige Modelle darstellt, da SSL „das Potenzial hat, große Datenmengen ohne manuelle Annotation zu verwenden.“

Die Strategie von Meta zur Verbesserung der SSL-Ergebnisse mag darin bestehen, alles daran zu setzen, aus riesigen, ungefilterten Datensätzen zu lernen, aber es ist auch ein zunehmend kontroverser Ansatz. KI-Ethikforscher wie Timnit Gebru haben auf die Vorurteile aufmerksam gemacht, die den nicht kuratierten Datensätzen innewohnen, aus denen große Sprachmodelle lernen, und die manchmal zu katastrophalen Ergebnissen führen können.

Selbstüberwachtes Lernen für Video und Audio

Im Video-MAE-System deckt der Masker 95 % jedes Videobilds ab, da die Ähnlichkeit zwischen Bildern bedeutet, dass Videosignale mehr Redundanz aufweisen als statische Bilder. Der Metaforscher Christoph Feichtenhofer sagte, dass ein großer Vorteil des MAE-Ansatzes bei Videos darin besteht, dass Videos oft rechenintensiv sind und MAE die Rechenkosten um bis zu 95 % senkt, indem bis zu 95 % des Inhalts jedes Frames ausgeblendet werden . Die in diesen Experimenten verwendeten Videoclips waren nur wenige Sekunden lang, aber Feichtenhofer sagte, das Training künstlicher Intelligenzsysteme mit längeren Videos sei ein sehr aktives Forschungsthema. Stellen Sie sich vor, Sie haben einen virtuellen Assistenten, der ein Video von Ihrem Zuhause hat und Ihnen sagen kann, wo Sie vor einer Stunde Ihre Schlüssel gelassen haben.

Direkter können wir uns vorstellen, dass Bild- und Videosysteme beide für die Klassifizierungsaufgaben nützlich sind, die für die Content-Moderation auf Facebook und Instagram erforderlich sind, sagte Feichtenhofer, „Integrität“ sei eine mögliche Anwendung: „Wir kommunizieren.“ mit dem Produktteam, aber das ist sehr neu und wir haben noch keine konkreten Projekte. Sie fanden einen cleveren Weg, die Maskierungstechnik anzuwenden. Sie wandelten die Tondateien in Spektrogramme um, bei denen es sich um visuelle Darstellungen des Frequenzspektrums eines Signals handelt, und maskierten dann Teile der Bilder für das Training. Der rekonstruierte Ton kann sich sehen lassen, auch wenn das Modell aktuell nur wenige Sekunden lange Clips bewältigen kann.

Mögliche Anwendungen dieser Forschung umfassen Klassifizierungsaufgaben und die Unterstützung der Voice-over-IP-Übertragung (VoIP), indem sie den Audioverlust ausgleichen, wenn Pakete verloren gehen, sagte Bernie Huang, ein Forscher auf dem Gebiet des Audiosystems eine effizientere Möglichkeit, Audiodateien zu komprimieren.

Meta hat Forschung zu Open-Source-KI wie diesen MAE-Modellen durchgeführt und stellt außerdem ein vorab trainiertes großes Sprachmodell für die Community der künstlichen Intelligenz bereit. Kritiker weisen jedoch darauf hin, dass Meta trotz seiner Offenheit für Forschung seine Kerngeschäftsalgorithmen nicht für Studien zur Verfügung gestellt hat: diejenigen, die Newsfeeds, Empfehlungen und Anzeigenplatzierung steuern.

Das obige ist der detaillierte Inhalt vonMeta AI unter LeCun setzt auf Selbstüberwachung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Technologietrends, die Sie im Jahr 2023 im Auge behalten sollten

- Wie künstliche Intelligenz Rechenzentrumsteams neue Alltagsaufgaben beschert

- Können künstliche Intelligenz oder Automatisierung das Problem der geringen Energieeffizienz in Gebäuden lösen?

- OpenAI-Mitbegründer im Interview mit Huang Renxun: Die Argumentationsfähigkeiten von GPT-4 haben noch nicht die Erwartungen erfüllt

- Dank der OpenAI-Technologie übertrifft Bing von Microsoft Google im Suchverkehr