Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Googles Super-KI-Supercomputer vernichtet NVIDIA A100! Die Leistung von TPU v4 wurde um das Zehnfache gesteigert, Details wurden erstmals bekannt gegeben

Googles Super-KI-Supercomputer vernichtet NVIDIA A100! Die Leistung von TPU v4 wurde um das Zehnfache gesteigert, Details wurden erstmals bekannt gegebenObwohl Google bereits 2020 den damals leistungsstärksten KI-Chip, TPU v4, im eigenen Rechenzentrum einsetzte.

Aber erst am 4. April dieses Jahres gab Google erstmals die technischen Details dieses KI-Supercomputers bekannt.

Papieradresse: https://arxiv.org/abs/2304.01433

Im Vergleich zu TPU v3 ist die Leistung von TPU v4 2,1-mal höher, und nach der Integration von 4096 Chips ist die Leistung höher des Supercomputings wurde um das Zehnfache verbessert.

Darüber hinaus behauptet Google auch, dass der eigene Chip schneller und energieeffizienter sei als NVIDIA A100.

Im Wettbewerb mit A100 ist die Geschwindigkeit 1,7-mal schneller

In dem Papier gab Google an, dass TPU v4 bei Systemen vergleichbarer Größe eine 1,7-mal bessere Leistung als Nvidia A100 bieten und gleichzeitig die Energieeffizienz verbessern kann. 1,9-fach.

Darüber hinaus ist die Supercomputing-Geschwindigkeit von Google etwa 4,3-mal bis 4,5-mal schneller als die von Graphcore IPU Bow.

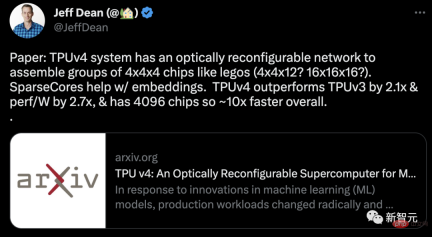

Google zeigte das TPU v4-Paket sowie 4 auf der Platine montierte Pakete.

Wie TPU v3 enthält jedes TPU v4 zwei TensorCore (TC). Jeder TC enthält vier 128x128 Matrixmultiplikationseinheiten (MXU), eine Vektorverarbeitungseinheit (VPU) mit 128 Kanälen (16 ALUs pro Kanal) und 16 MiB Vektorspeicher (VMEM).

Zwei TCs teilen sich einen 128 MiB großen gemeinsamen Speicher (CMEM).

Es ist erwähnenswert, dass der A100-Chip gleichzeitig mit Googles TPU der vierten Generation auf den Markt kam. Wie ist also seine spezifische Leistung im Vergleich?

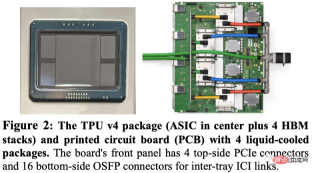

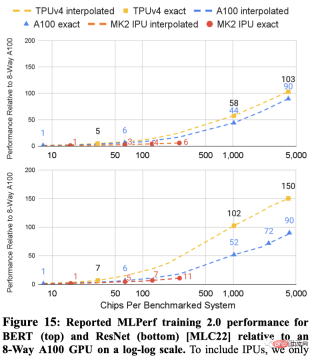

Google hat die schnellste Leistung jedes DSA bei 5 MLPerf-Benchmarks separat nachgewiesen. Dazu gehören BERT, ResNET, DLRM, RetinaNet und MaskRCNN.

Unter anderem hat Graphcore IPU Ergebnisse zu BERT und ResNET eingereicht.

Das Folgende zeigt die Ergebnisse der beiden Systeme auf ResNet und BERT. Die gepunkteten Linien zwischen den Punkten sind Interpolationen basierend auf der Anzahl der Chips.

MLPerf-Ergebnisse für TPU v4 und A100 lassen sich auf größere Systeme als die IPU skalieren (4096 Chips vs. 256 Chips).

Bei Systemen ähnlicher Größe ist TPU v4 1,15-mal schneller als A100 auf BERT und etwa 4,3-mal schneller als IPU. Für ResNet ist TPU v4 1,67x bzw. etwa 4,5x schneller.

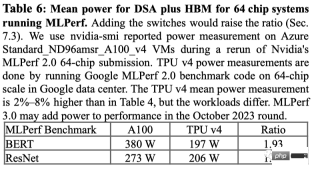

Beim Stromverbrauch beim MLPerf-Benchmark verbrauchte der A100 im Durchschnitt 1,3x bis 1,9x mehr Strom.

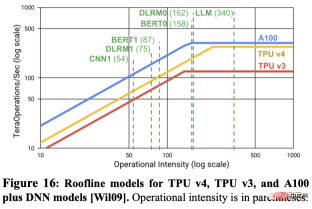

Prognostizieren Spitzen-FLOPS die tatsächliche Leistung? Viele Leute im Bereich des maschinellen Lernens glauben, dass die Spitzenwerte bei Gleitkommaoperationen pro Sekunde ein guter Indikator für die Leistung sind, aber in Wirklichkeit ist das nicht der Fall.

Zum Beispiel ist TPU v4 bei zwei MLPerf-Benchmarks 4,3x bis 4,5x schneller als IPU Bow auf einem System gleicher Größe, obwohl es bei Spitzen-Gleitkommaoperationen pro Sekunde nur einen 1,10-fachen Vorteil hat.

Ein weiteres Beispiel ist, dass die maximalen Gleitkommaoperationen pro Sekunde von A100 1,13-mal so hoch sind wie die von TPU v4, aber bei der gleichen Anzahl von Chips ist TPU v4 1,15-mal bis 1,67-mal schneller.

Wie unten gezeigt, wird das Roofline-Modell verwendet, um die Beziehung zwischen Spitzen-FLOPS/Sekunde und Speicherbandbreite darzustellen.

Die Frage ist also: Warum vergleicht Google nicht mit Nvidias neuestem H100?

Google gab an, dass das Produkt der vierten Generation nicht mit Nvidias aktuellem Flaggschiff-H100-Chip verglichen wurde, da der H100 nach der Einführung der Google-Chips mit neuerer Technologie hergestellt wurde.

Google deutete jedoch an, dass es eine neue TPU entwickelt, die mit Nvidia H100 konkurrieren soll, nannte jedoch keine Details. Google-Forscher Jouppi sagte in einem Interview mit Reuters, dass Google „eine Produktionslinie für zukünftige Chips“ habe.

TPU vs. GPU

Während ChatGPT und Bard „gegeneinander kämpfen“, arbeiten zwei Giganten auch hinter den Kulissen hart daran, sie am Laufen zu halten – Nvidias CUDA-betriebene GPU (Grafikverarbeitungseinheit) und Googles angepasste TPU (Tensor). Verarbeitungseinheit).

Mit anderen Worten, hier geht es nicht mehr um ChatGPT vs. Bard, sondern um TPU vs. GPU und darum, wie effizient sie die Matrixmultiplikation durchführen können.

Aufgrund seines hervorragenden Designs in der Hardwarearchitektur eignet sich die GPU von NVIDIA sehr gut für Matrixmultiplikationsaufgaben – wodurch effektiv eine parallele Verarbeitung zwischen mehreren CUDA-Kernen erreicht wird.

Daher ist das Training von Modellen auf GPU seit 2012 ein Konsens im Bereich Deep Learning, und daran hat sich bis heute nichts geändert.

Mit der Einführung von NVIDIA DGX ist NVIDIA in der Lage, Hardware- und Softwarelösungen für fast alle KI-Aufgaben aus einer Hand anzubieten, die Wettbewerber aufgrund fehlender Rechte an geistigem Eigentum nicht bereitstellen können.

Im Gegensatz dazu brachte Google 2016 die Tensor Processing Unit (TPU) der ersten Generation auf den Markt, die nicht nur einen benutzerdefinierten ASIC (anwendungsspezifischer integrierter Schaltkreis) enthielt, der für Tensor-Computing optimiert war, sondern auch ein eigenes TensorFlow-Framework ins Visier nahm optimiert worden. Dies verschafft TPU neben der Matrixmultiplikation auch einen Vorteil bei anderen KI-Rechenaufgaben und kann sogar Feinabstimmungs- und Inferenzaufgaben beschleunigen.

Darüber hinaus haben Forscher von Google DeepMind auch einen Weg gefunden, einen besseren Matrixmultiplikationsalgorithmus zu entwickeln – AlphaTensor.

Obwohl Google durch selbst entwickelte Technologie und neue Methoden zur KI-Computing-Optimierung gute Ergebnisse erzielt hat, hat die langfristige, intensive Zusammenarbeit zwischen Microsoft und NVIDIA gleichzeitig den Handlungsspielraum beider Parteien durch die Nutzung ihrer jeweiligen Ersparnisse erweitert in der Branche.

TPU der vierten Generation

Bereits im Jahr 2021 kündigte Pichai auf der Google I/O-Konferenz zum ersten Mal den KI-Chip TPU v4 der neuesten Generation von Google an.

„Dies ist das schnellste System, das wir jemals bei Google eingesetzt haben, und ein historischer Meilenstein für uns.“

Diese Verbesserung hat das Unternehmen zum Aufbau eines KI-Supercomputers gemacht. Dies ist ein wichtiger Punkt im Wettbewerb. da große Sprachmodelle wie Googles Bard oder OpenAIs ChatGPT in der Parametergröße explodiert sind.

Das bedeutet, dass sie weitaus größer sind als die Kapazität, die ein einzelner Chip speichern kann, und der Bedarf an Rechenleistung ein riesiges „Schwarzes Loch“ ist.

Diese großen Modelle müssen also auf Tausende von Chips verteilt werden, und dann müssen diese Chips wochenlang oder sogar länger zusammenarbeiten, um das Modell zu trainieren.

Derzeit verfügt PaLM, das größte von Google bisher öffentlich veröffentlichte Sprachmodell, über 540 Milliarden Parameter, die zum Training innerhalb von 50 Tagen auf zwei 4000-Chip-Supercomputer aufgeteilt wurden.

Google sagte, sein Supercomputer könne die Verbindungen zwischen Chips problemlos neu konfigurieren, um Probleme zu vermeiden und eine Leistungsoptimierung durchzuführen.

Google-Forscher Norm Jouppi und Google Distinguished Engineer David Patterson schrieben in einem Blogbeitrag über das System:

„Durch Schaltkreisumschaltung können ausgefallene Komponenten einfach umgangen werden. Diese Flexibilität ermöglicht es uns sogar, die Ultra-Computing-Verbindungstopologien zu ändern.“ um die Leistung von Modellen für maschinelles Lernen zu beschleunigen.

Obwohl Google erst jetzt Details zu seinem Supercomputer veröffentlicht, ist er seit 2020 in Oklahoma. Gehen Sie im Rechenzentrum von Mayes County online.

Google sagte, dass Midjourney dieses System zum Trainieren seines Modells verwendet habe und die neueste Version von V5 es jedem ermöglicht, die erstaunliche Bilderzeugung zu sehen.

Kürzlich sagte Pichai in einem Interview mit der New York Times, dass Bard von LaMDA zu PaLM versetzt wird.

Mit dem Segen des Supercomputers TPU v4 wird Bard jetzt nur noch stärker.

Das obige ist der detaillierte Inhalt vonGoogles Super-KI-Supercomputer vernichtet NVIDIA A100! Die Leistung von TPU v4 wurde um das Zehnfache gesteigert, Details wurden erstmals bekannt gegeben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lassen Sie uns tanzen: Strukturierte Bewegung, um unsere menschlichen neuronalen Netze zu optimierenApr 27, 2025 am 11:09 AM

Lassen Sie uns tanzen: Strukturierte Bewegung, um unsere menschlichen neuronalen Netze zu optimierenApr 27, 2025 am 11:09 AMWissenschaftler haben ausführlich menschliche und einfachere neuronale Netzwerke (wie die in C. elegans) untersucht, um ihre Funktionalität zu verstehen. Es stellt sich jedoch eine entscheidende Frage: Wie passen wir unsere eigenen neuronalen Netze an, um neben neuartigen Ai S effektiv zu arbeiten

Neues Google Leak zeigt Abonnementänderungen für Gemini AIApr 27, 2025 am 11:08 AM

Neues Google Leak zeigt Abonnementänderungen für Gemini AIApr 27, 2025 am 11:08 AMGoogles Gemini Advanced: Neue Abonnements am Horizont Der Zugriff auf Gemini Advanced erfordert derzeit einen Google One AI -Premium -Plan von 19,99 USD/Monat. Ein Bericht von Android Authority hat jedoch auf bevorstehende Änderungen hinweist. Code im neuesten Google P.

Wie die Beschleunigung der Datenanalyse löst den versteckten Engpass von AIApr 27, 2025 am 11:07 AM

Wie die Beschleunigung der Datenanalyse löst den versteckten Engpass von AIApr 27, 2025 am 11:07 AMTrotz des Hype um fortgeschrittene KI -Funktionen lauert eine erhebliche Herausforderung in den Bereitstellungen von Enterprise AI: Datenverarbeitung Engpässe. Während CEOs KI -Fortschritte feiern, kreischen sich die Ingenieure mit langsamen Abfragen, überladenen Pipelines, a

Markitdown MCP kann jedes Dokument in Markdowns umwandeln!Apr 27, 2025 am 09:47 AM

Markitdown MCP kann jedes Dokument in Markdowns umwandeln!Apr 27, 2025 am 09:47 AMUm Dokumente zu handeln, geht es nicht mehr nur darum, Dateien in Ihren KI -Projekten zu öffnen, sondern darum, das Chaos in Klarheit zu verwandeln. Dokumente wie PDFs, Powerpoints und Wort überfluten unsere Workflows in jeder Form und Größe. Strukturiert abrufen

Wie benutze ich Google ADK für Bauagenten? - Analytics VidhyaApr 27, 2025 am 09:42 AM

Wie benutze ich Google ADK für Bauagenten? - Analytics VidhyaApr 27, 2025 am 09:42 AMNutzen Sie die Macht des Google Agent Development Kit (ADK), um intelligente Agenten mit realen Funktionen zu erstellen! Dieses Tutorial führt Sie durch den Bau von Konversationsagenten mit ADK und unterstützt verschiedene Sprachmodelle wie Gemini und GPT. W

Verwendung von SLM über LLM für eine effektive Problemlösung - Analytics VidhyaApr 27, 2025 am 09:27 AM

Verwendung von SLM über LLM für eine effektive Problemlösung - Analytics VidhyaApr 27, 2025 am 09:27 AMZusammenfassung: SLM (Small Language Model) ist für die Effizienz ausgelegt. Sie sind besser als das große Sprachmodell (LLM) in Ressourcenmangel-, Echtzeit- und Datenschutz-sensitiven Umgebungen. Am besten für fokussierte Aufgaben, insbesondere für Domänenspezifität, -kontrollierbarkeit und Interpretierbarkeit wichtiger als allgemeines Wissen oder Kreativität. SLMs sind kein Ersatz für LLMs, aber sie sind ideal, wenn Präzision, Geschwindigkeit und Kostenwirksamkeit kritisch sind. Technologie hilft uns, mehr mit weniger Ressourcen zu erreichen. Es war schon immer ein Promoter, kein Fahrer. Von der Dampfmaschine -Ära bis zur Internetblase -Ära liegt die Kraft der Technologie in dem Ausmaß, in dem sie uns hilft, Probleme zu lösen. Künstliche Intelligenz (KI) und in jüngerer Zeit generativer KI sind keine Ausnahme

Wie benutze ich Google Gemini -Modelle für Computer Vision -Aufgaben? - Analytics VidhyaApr 27, 2025 am 09:26 AM

Wie benutze ich Google Gemini -Modelle für Computer Vision -Aufgaben? - Analytics VidhyaApr 27, 2025 am 09:26 AMNutzen Sie die Kraft von Google Gemini für Computer Vision: einen umfassenden Leitfaden Google Gemini, ein führender KI -Chatbot, erweitert seine Fähigkeiten über die Konversation hinaus, um leistungsstarke Funktionen von Computer Visionen zu umfassen. In dieser Anleitung wird beschrieben, wie man verwendet wird

Gemini 2.0 Flash gegen O4-Mini: Kann Google besser als OpenAI machen?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash gegen O4-Mini: Kann Google besser als OpenAI machen?Apr 27, 2025 am 09:20 AMDie KI-Landschaft von 2025 ist mit der Ankunft von Googles Gemini 2.0 Flash und Openai's O4-Mini elektrisierend. Diese modernen Modelle, die in Abstand von Wochen veröffentlicht wurden, bieten vergleichbare fortschrittliche Funktionen und beeindruckende Benchmark-Ergebnisse. Diese eingehende Vergleiche

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Herunterladen der Mac-Version des Atom-Editors

Der beliebteste Open-Source-Editor

Dreamweaver CS6

Visuelle Webentwicklungstools

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software