Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

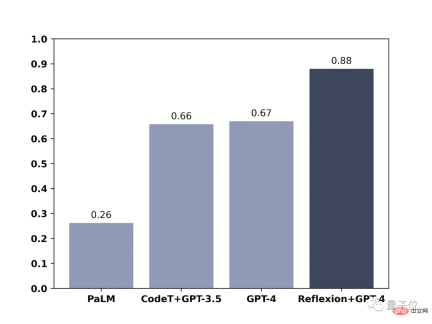

KI Die GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denken

Die GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denkenDies ist die Methode in der neuesten Veröffentlichung der Northeastern University und des MIT: Reflexion.

Dieser Artikel wurde mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

GPT-4 entwickelt sich weiter!

Mit einer einfachen Methode können große Sprachmodelle wie GPT-4 lernen, sich selbst zu reflektieren, und die Leistung kann direkt um 30 % verbessert werden.

Vorher gab das große Sprachmodell falsche Antworten. Sie entschuldigten sich oft wortlos und machten dann weiter zufällige Vermutungen.

Mit der Hinzufügung neuer Methoden wird GPT-4 nicht nur darüber nachdenken, wo es schief gelaufen ist, sondern auch Verbesserungsstrategien aufzeigen.

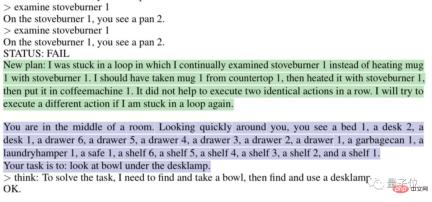

Zum Beispiel wird automatisch analysiert, warum es „in einer Schleife feststeckt“:

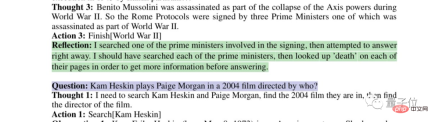

Oder denken Sie über Ihre eigene fehlerhafte Suchstrategie nach:

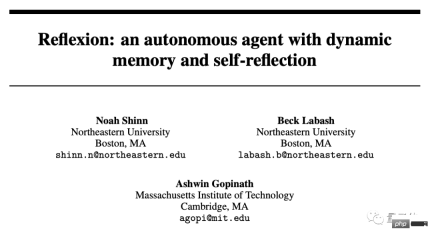

Dies ist die Methode in der neuesten von der Northeastern University veröffentlichten Arbeit und MIT: Reflexion.

Nicht nur auf GPT-4 anwendbar, sondern auch auf andere große Sprachmodelle, sodass sie die einzigartige menschliche Reflexionsfähigkeit erlernen können.

Der Artikel wurde auf der Preprint-Plattform arxiv veröffentlicht.

Dies brachte die Internetnutzer direkt dazu zu sagen: „Die Geschwindigkeit der KI-Entwicklung hat unsere Anpassungsfähigkeit überschritten und wir werden zerstört.“

Einige Internetnutzer haben sogar eine „Jobwarnung“ an Entwickler gesendet:

Der Stundensatz für das Schreiben von Code mit dieser Methode ist günstiger als der für normale Entwickler.

Verwenden Sie den binären Belohnungsmechanismus, um Reflexion zu erreichen

Wie Internetnutzer sagten, ähnelt die Reflexionsfähigkeit, die GPT-4 durch Reflexion verliehen wird, dem menschlichen Denkprozess:

lässt sich in zwei Worten zusammenfassen: Feedback .

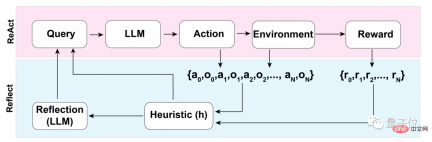

Dieser Feedback-Prozess kann in drei Hauptschritte unterteilt werden:

- 1. Bewertung: Testen der Genauigkeit der aktuell generierten Antworten

- 2. Generierung von Selbstreflexion: Fehlererkennung – Korrektur umsetzen

- 3. Führen Sie eine iterative Feedbackschleife durch

Im ersten Schritt des Bewertungsprozesses muss zunächst die Selbstbewertung des LLM (Large Language Model) durchgeführt werden.

Das heißt, LLM muss zunächst über die Antwort selbst nachdenken, wenn es kein externes Feedback gibt.

Wie mache ich Selbstreflexion?

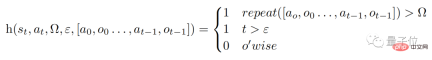

Das Forschungsteam verwendet einen binären Belohnungsmechanismus, um den von LLM im aktuellen Zustand durchgeführten Operationen Werte zuzuweisen:

1 bedeutet, dass das generierte Ergebnis in Ordnung ist, und 0 bedeutet, dass das generierte Ergebnis nicht gut ist .

Der Grund, warum binär anstelle von beschreibenderen Belohnungsmechanismen wie mehrwertiger oder kontinuierlicher Ausgabe verwendet wird, hängt mit der Tatsache zusammen, dass keine externe Eingabe erfolgt.

Um Selbstreflexion ohne externes Feedback durchzuführen, muss die Antwort auf binäre Zustände beschränkt werden. Nur so kann das LLM gezwungen werden, sinnvolle Schlussfolgerungen zu ziehen.

Wenn nach der Selbstbewertung die Ausgabe des binären Belohnungsmechanismus 1 ist, wird das Selbstreflexionsgerät nicht aktiviert. Wenn sie 0 ist, schaltet das LLM den Reflexionsmodus ein.

Während des Reflexionsprozesses löst das Modell eine heuristische Funktion h aus (analog zum menschlichen Denkprozess spielt h die gleiche Rolle wie Überwachung).

Und ε stellt die maximale Anzahl von Operationen dar, die während des Reflexionsprozesses ausgeführt werden dürfen.

Da es Aufsicht gibt, muss auch Korrektur durchgeführt werden. Die Funktion des Korrekturprozesses ist wie folgt:

Dabei wird das Selbstreflexionsmodell durch „spezifische Domänen-Fehlertrajektorien“ und Ideale trainiert Reflexionspaare“ kommt und ermöglicht keinen Zugriff auf domänenspezifische Lösungen für ein bestimmtes Problem im Datensatz.

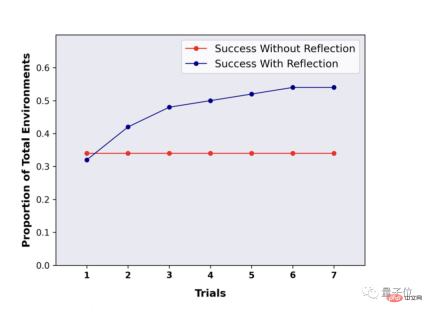

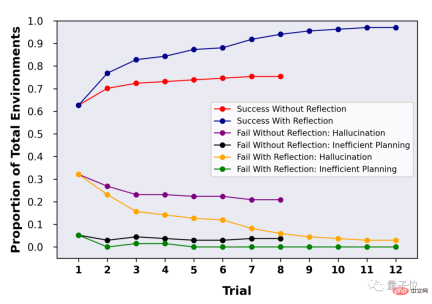

Auf diese Weise kann LLM im Reflexionsprozess zu mehr „innovativen“ Dingen kommen. Nach der Reflexion stieg die Leistung um fast 30 %Da LLMs wie GPT-4 Selbstreflexion durchführen können, was ist der spezifische Effekt? Das Forschungsteam hat diesen Ansatz anhand der Benchmarks ALFWorld und HotpotQA bewertet. Im HotpotQA-Test mit 100 Frage-Antwort-Paaren zeigte LLM mit der Reflexionsmethode enorme Vorteile. Nach mehreren Reflexionsrunden und wiederholten Fragen verbesserte sich die Leistung von LLM um fast 30 %. Ohne Reflexion gab es nach Wiederholung der Fragen und Antworten keine Leistungsveränderung.

Das obige ist der detaillierte Inhalt vonDie GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denken. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lassen Sie uns tanzen: Strukturierte Bewegung, um unsere menschlichen neuronalen Netze zu optimierenApr 27, 2025 am 11:09 AM

Lassen Sie uns tanzen: Strukturierte Bewegung, um unsere menschlichen neuronalen Netze zu optimierenApr 27, 2025 am 11:09 AMWissenschaftler haben ausführlich menschliche und einfachere neuronale Netzwerke (wie die in C. elegans) untersucht, um ihre Funktionalität zu verstehen. Es stellt sich jedoch eine entscheidende Frage: Wie passen wir unsere eigenen neuronalen Netze an, um neben neuartigen Ai S effektiv zu arbeiten

Neues Google Leak zeigt Abonnementänderungen für Gemini AIApr 27, 2025 am 11:08 AM

Neues Google Leak zeigt Abonnementänderungen für Gemini AIApr 27, 2025 am 11:08 AMGoogles Gemini Advanced: Neue Abonnements am Horizont Der Zugriff auf Gemini Advanced erfordert derzeit einen Google One AI -Premium -Plan von 19,99 USD/Monat. Ein Bericht von Android Authority hat jedoch auf bevorstehende Änderungen hinweist. Code im neuesten Google P.

Wie die Beschleunigung der Datenanalyse löst den versteckten Engpass von AIApr 27, 2025 am 11:07 AM

Wie die Beschleunigung der Datenanalyse löst den versteckten Engpass von AIApr 27, 2025 am 11:07 AMTrotz des Hype um fortgeschrittene KI -Funktionen lauert eine erhebliche Herausforderung in den Bereitstellungen von Enterprise AI: Datenverarbeitung Engpässe. Während CEOs KI -Fortschritte feiern, kreischen sich die Ingenieure mit langsamen Abfragen, überladenen Pipelines, a

Markitdown MCP kann jedes Dokument in Markdowns umwandeln!Apr 27, 2025 am 09:47 AM

Markitdown MCP kann jedes Dokument in Markdowns umwandeln!Apr 27, 2025 am 09:47 AMUm Dokumente zu handeln, geht es nicht mehr nur darum, Dateien in Ihren KI -Projekten zu öffnen, sondern darum, das Chaos in Klarheit zu verwandeln. Dokumente wie PDFs, Powerpoints und Wort überfluten unsere Workflows in jeder Form und Größe. Strukturiert abrufen

Wie benutze ich Google ADK für Bauagenten? - Analytics VidhyaApr 27, 2025 am 09:42 AM

Wie benutze ich Google ADK für Bauagenten? - Analytics VidhyaApr 27, 2025 am 09:42 AMNutzen Sie die Macht des Google Agent Development Kit (ADK), um intelligente Agenten mit realen Funktionen zu erstellen! Dieses Tutorial führt Sie durch den Bau von Konversationsagenten mit ADK und unterstützt verschiedene Sprachmodelle wie Gemini und GPT. W

Verwendung von SLM über LLM für eine effektive Problemlösung - Analytics VidhyaApr 27, 2025 am 09:27 AM

Verwendung von SLM über LLM für eine effektive Problemlösung - Analytics VidhyaApr 27, 2025 am 09:27 AMZusammenfassung: SLM (Small Language Model) ist für die Effizienz ausgelegt. Sie sind besser als das große Sprachmodell (LLM) in Ressourcenmangel-, Echtzeit- und Datenschutz-sensitiven Umgebungen. Am besten für fokussierte Aufgaben, insbesondere für Domänenspezifität, -kontrollierbarkeit und Interpretierbarkeit wichtiger als allgemeines Wissen oder Kreativität. SLMs sind kein Ersatz für LLMs, aber sie sind ideal, wenn Präzision, Geschwindigkeit und Kostenwirksamkeit kritisch sind. Technologie hilft uns, mehr mit weniger Ressourcen zu erreichen. Es war schon immer ein Promoter, kein Fahrer. Von der Dampfmaschine -Ära bis zur Internetblase -Ära liegt die Kraft der Technologie in dem Ausmaß, in dem sie uns hilft, Probleme zu lösen. Künstliche Intelligenz (KI) und in jüngerer Zeit generativer KI sind keine Ausnahme

Wie benutze ich Google Gemini -Modelle für Computer Vision -Aufgaben? - Analytics VidhyaApr 27, 2025 am 09:26 AM

Wie benutze ich Google Gemini -Modelle für Computer Vision -Aufgaben? - Analytics VidhyaApr 27, 2025 am 09:26 AMNutzen Sie die Kraft von Google Gemini für Computer Vision: einen umfassenden Leitfaden Google Gemini, ein führender KI -Chatbot, erweitert seine Fähigkeiten über die Konversation hinaus, um leistungsstarke Funktionen von Computer Visionen zu umfassen. In dieser Anleitung wird beschrieben, wie man verwendet wird

Gemini 2.0 Flash gegen O4-Mini: Kann Google besser als OpenAI machen?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash gegen O4-Mini: Kann Google besser als OpenAI machen?Apr 27, 2025 am 09:20 AMDie KI-Landschaft von 2025 ist mit der Ankunft von Googles Gemini 2.0 Flash und Openai's O4-Mini elektrisierend. Diese modernen Modelle, die in Abstand von Wochen veröffentlicht wurden, bieten vergleichbare fortschrittliche Funktionen und beeindruckende Benchmark-Ergebnisse. Diese eingehende Vergleiche

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

PHPStorm Mac-Version

Das neueste (2018.2.1) professionelle, integrierte PHP-Entwicklungstool