Heim >häufiges Problem >Was Hochleistungsrechner können

Was Hochleistungsrechner können

- 青灯夜游Original

- 2022-08-31 14:50:314771Durchsuche

Was Sie tun können: 1. Numerische Simulation kosmischer Neutrinos und dunkler Materie, um den Evolutionsprozess des Universums aufzudecken, oder Sie können auch den Zeitprozess simulieren und den Simulationsprozess beschleunigen, um Modellierungen und theoretische Experimente zur Entwicklung des Himmels durchzuführen Körper. 2. Erstellen Sie ein mathematisches Modell nuklearer Explosionen, verstehen Sie die Prinzipien nuklearer Explosionen genau und unterstützen Sie die Entwicklung einer neuen Generation von Atomwaffen oder vorhersagen Sie, wann Atomwaffen versagen werden und welche Teile ersetzt werden müssen. 3. Simulieren und beobachten Sie Wolkenbewegungen genau, um eine Klimasimulation und Wettervorhersage zu erreichen. 4. Simulieren Sie Erdbeben, um Menschen dabei zu helfen, Methoden zur Erdbebenvorhersage zu erforschen und so die mit Erdbeben verbundenen Risiken zu mindern.

Die Betriebsumgebung dieses Tutorials: Windows 7-System, Dell G3-Computer.

Hochleistungscomputer (HPC, auch Supercomputer genannt) werden hauptsächlich zur Lösung anspruchsvoller Probleme eingesetzt, die von anderen Computern nicht gelöst werden können. Sie beziehen sich normalerweise auf einen Computertyp mit extrem hoher Rechengeschwindigkeit, enormer Speicherkapazität und extrem hoher Leistung Kommunikationsbandbreite. Hochleistungsrechnen gilt als die „Krone“ der Informatik und des Ingenieurwesens, und Länder haben in den letzten Jahren häufig Forschungs- und Entwicklungspläne auf nationaler Ebene gestartet.

Hochleistungscomputer sind Computer mit den leistungsstärksten Funktionen, der schnellsten Rechengeschwindigkeit und der größten Speicherkapazität. Sie werden hauptsächlich in nationalen High-Tech-Bereichen und in der Spitzentechnologieforschung eingesetzt. Sie spiegeln die wissenschaftliche Forschungsstärke eines Landes wider und haben großen Einfluss auf die nationale Sicherheit und die gesellschaftliche Entwicklung. Es ist ein wichtiges Symbol für den wissenschaftlichen und technologischen Entwicklungsstand des Landes und die umfassende nationale Stärke.

Hochleistungscomputer sind Computer, die große Datenmengen und Hochgeschwindigkeitsvorgänge ausführen können, die normale Personalcomputer nicht bewältigen können. Seine Grundkomponenten unterscheiden sich nicht wesentlich vom Konzept eines Personalcomputers, aber seine Spezifikationen und Leistung sind viel leistungsfähiger. Es handelt sich um einen supergroßen elektronischen Computer. Es verfügt über starke Rechen- und Datenverarbeitungsfunktionen. Seine Hauptmerkmale sind hohe Geschwindigkeit und große Kapazität. Es ist mit einer Vielzahl externer und peripherer Geräte sowie umfangreichen, hochfunktionalen Softwaresystemen ausgestattet. Die meisten existierenden Supercomputer können mit einer Geschwindigkeit von mehr als einer Terazeit pro Sekunde arbeiten.

Als Element der High-Tech-Entwicklung sind Hochleistungscomputer längst zu einem wettbewerbsfähigen Instrument für die Wirtschaft und die Landesverteidigung von Ländern auf der ganzen Welt geworden. Nach jahrzehntelangen unermüdlichen Bemühungen chinesischer Wissenschaftler und Techniker hat sich Chinas Forschungs- und Entwicklungsniveau im Bereich Hochleistungscomputer erheblich verbessert und ist nach den USA und Japan zum drittgrößten Entwickler und Hersteller von Hochleistungscomputern geworden. China verfügt derzeit über 22 Supercomputer (19 auf dem chinesischen Festland, 1 in Hongkong und 2 in Taiwan) und ist weltweit führend in Bezug auf Besitz und Rechengeschwindigkeit. Mit der rasanten Entwicklung. Es wird auch zunehmend in der Industrie, in der wissenschaftlichen Forschung und im akademischen Bereich eingesetzt. Allerdings klafft hinsichtlich des Einsatzgebiets von Hochleistungsrechnern noch immer eine große Lücke zwischen China und entwickelten Ländern wie den USA und Deutschland. Die Entwicklung von Chinas Hochleistungscomputern und ihren Anwendungen bietet eine solide Grundlage und Garantie dafür, dass China zu einer Technologiemacht wird.

Der Einsatz von Hochleistungscomputern

1. Aufdeckung des Evolutionsprozesses des Universums

Das internationale Team zur numerischen Simulation kosmischer Neutrinos unter der Leitung chinesischer Wissenschaftler am „Tianhe- 2-Zoll-Supercomputersystem Die numerische Simulation von 30 Billionen Teilchen auf kosmischen Neutrinos und Dunkler Materie wurde erfolgreich abgeschlossen und der 13,7 Milliarden Jahre lange Evolutionsprozess des Universums seit dem Urknall 16 Millionen Jahre später enthüllt. Neutrinos gehören zu den grundlegendsten Teilchenarten der Natur. Sie erheben keine Gebühr und handeln sehr schnell. Derzeit kann die absolute Masse von Neutrinos nicht durch physikalische Experimente und kosmologische Beobachtungen gemessen werden. Neutrinos könnten die Entstehung von Galaxien und großräumigen Strukturen im frühen Universum hemmen. Letzteres kann indirekt durch groß angelegte kosmologische numerische Simulationen gemessen werden, um Informationen über die Neutrinomasse zu erhalten. Für solche groß angelegten kosmologischen numerischen Simulationen sind Supercomputer mit leistungsstarken Rechen- und Speicherkapazitäten erforderlich.

Es ist auch möglich, den Zeitprozess zu simulieren und den Prozess der Simulation zu beschleunigen, um Modellierungen und theoretische Experimente zur Entwicklung von Himmelskörpern durchzuführen.

2. Simulierter Atomtest

Die 500 besten Supercomputer sind Titan und Sequoia in den Vereinigten Staaten. Sie sind dem US-Energieministerium im Oak Ridge National Laboratory und im Lawrence Livermore National Laboratory angeschlossen. Auf ihnen basierende Supercomputing-Anwendungen betreffen die Entwicklung und Aufrechterhaltung der Sicherheit von Atomwaffen. Basierend auf den Daten von 1.054 US-Atomtests von 1945 bis 1992 wurde mit einem Supercomputer ein mathematisches Modell nuklearer Explosionen erstellt, das ein tiefgreifendes Verständnis der Prinzipien nuklearer Explosionen ermöglichte und der Entwicklung einer neuen Generation von Atomwaffen diente; Viele Atomwaffen nähern sich dem Ende ihrer Lebensdauer. Mithilfe von Supercomputersimulationen lässt sich vorhersagen, wann sie ausfallen und welche Teile ersetzt werden müssen.

3. Klimasimulation und Wettervorhersage

Diese Supercomputing-Anwendung gewann den China Gordon Bell Prize und trägt den Namen „Global Non-Static Cloud Resolution Simulation“. Das Projekt ist auf Klima- und Meteorologieforschung ausgerichtet. Wettervorhersagen erfordern die Verarbeitung, Speicherung, Abfrage, Analyse und Statistik umfangreicher meteorologischer Daten in Echtzeit. Die Berechnung mit einem gewöhnlichen Computer würde Hunderte von Jahren dauern. Beispielsweise hängt der Niederschlag eng mit der Bewegung der Wolken zusammen. Mit Supercomputern können Wolkenbewegungen genau simuliert und beobachtet werden. Mit zunehmender Rechengeschwindigkeit von Supercomputern nimmt die Genauigkeit der Beobachtungen immer weiter ab. Wenn wir in Zukunft jede Wolke „markieren“ könnten, wäre die Wettervorhersage in Ordnung.

4. Erdbebensimulation

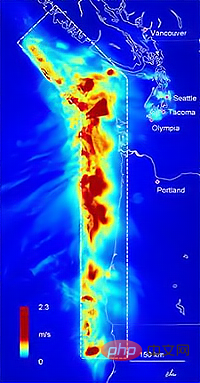

Supercomputer können Erdbeben simulieren. Es simuliert Krustenbewegungen, indem es Spannungsänderungen in verschiedenen Schichten berechnet. Beispielsweise verwendeten chinesische und deutsche Wissenschaftler Tianhe-2, um die Ausbreitung seismischer Wellen real zu simulieren, und reproduzierten den Ausbreitungsprozess seismischer Randwellen des Rand-Erdbebens von 1992 in Kalifornien, USA Erdbebenvorhersage.

Die Simulation von Erdbeben kann Menschen dabei helfen, Methoden zur Erdbebenvorhersage zu erforschen und so die mit Erdbeben verbundenen Risiken zu mindern.

5. Ölexploration

Supercomputer können auch berechnen, wo Ölquellen gebohrt werden sollten. Derzeit ist die seismische Exploration ein wichtiges Mittel zur Erkundung von Öl- und Gasressourcen vor Bohrungen. Bei der sogenannten seismischen Erkundung wird der Elastizitätsunterschied und der Dichteunterschied unterirdischer Medien genutzt, um die Reaktion der Erde auf künstlich angeregte seismische Wellen zu beobachten und zu analysieren, die Beschaffenheit und Form unterirdischer Schichten abzuleiten und dadurch die genaue Verteilung von Öl und Gas zu bestimmen . Dieser Prozess erfordert eine intensive Berechnung und Simulation großer Datenmengen, und die Berechnungsergebnisse müssen in intuitive dreidimensionale Bilder umgewandelt werden, sodass dies mit Hilfe von Hochleistungscomputern erreicht werden muss. 6. Vorhersage der Tsunamigefahr Die Ergebnisse zeigen, dass im Falle eines Erdbebens in der Präfektur Miyagi das Überschwemmungsgebiet in der Stadt Sendai innerhalb von 10 Minuten vorhergesagt werden kann. Wenn diese Technologie gefördert wird, wird sie die Genauigkeit der Tsunami-Warnungen verbessern und die Bewohner effektiver bei der Evakuierung unterstützen. Die Simulation einer Tsunami-Katastrophe erfordert viel Zeit und dauert lange, was die Durchführung einer Katastrophenanalyse in Echtzeit erschwert. Während des Erdbebens „3.11“ in Japan war die vorhergesagte Höhe der Tsunamiwelle geringer als die tatsächliche Höhe.

7. Präzisionsmedizin

Präzisionsmedizin ist eine auf jeden Einzelnen zugeschnittene medizinische Behandlung. Sie ist nicht nur ein medizinischer Bereich, sondern auch eng mit der Rechenleistung verbunden. Genetische Unterschiede bestimmen individuelle Unterschiede. Es gibt 3 Milliarden Basenpaare im Genom eines Menschen, die darauf warten, von Wissenschaftlern analysiert zu werden, wobei Informationen wie die Lebensgewohnheiten und die äußere Umgebung des Menschen berücksichtigt werden. Aber das reicht nicht aus. Wir bräuchten genetische Daten von mindestens Millionen Menschen, um eine Datenbank zu erstellen, um den Zusammenhang zwischen genetischen Unterschieden und verschiedenen Gesundheitsproblemen zu analysieren und so Menschen zu „behandeln“. Für die Verarbeitung all dessen ist erhebliche Rechenleistung erforderlich.

8. Medikamentenentwicklung

Mit Hilfe des Supercomputers „Beijing“ haben Wissenschaftler erfolgreich neue Medikamente gegen Krebs entwickelt. Die Forscher konzentrierten ihre Forschung auf Proteine, die eine wichtige Rolle bei der Proliferation von Krebszellen spielen, und nutzten dieses spezielle Protein als Durchbruch, um mithilfe von Supercomputersimulationen Chemikalien zu berechnen, die die Proliferation von Krebszellen wirksam hemmen können. Generell ist die Berechnung der Bindung dieses krebszellspezifischen Proteins an potenziell wirksame Medikamente und seiner Wirkung auf das Körperwasser äußerst komplex und erfordert präzise Simulationsexperimente mit Hilfe von Supercomputern.

9. Simulierter Blutfluss

Die Gesamtlänge menschlicher Blutgefäße beträgt 100.000 bis 160.000 Kilometer. Ohne Supercomputer wäre es nahezu unmöglich, den Blutfluss in Blutgefäßen in Echtzeit zu simulieren. US-Wissenschaftlern ist es gelungen, mithilfe eines Supercomputers das gesamte menschliche Arteriensystem nachzubilden. Jede Arterie mit einem Durchmesser von mehr als 1 mm wird im 3D-Modell mit einer Auflösung von 9 Mikrometern angezeigt. Chinesische Wissenschaftler nutzen die „Taihu Divine Power Lantern“ auch zur Simulation und Analyse des menschlichen Blutflusses. Dadurch kann schnell und effektiv festgestellt werden, ob bei einer Person das Risiko eines Hirninfarkts besteht, ohne dass ein Messgerät im Blutgefäß platziert werden muss. Supercomputer simulieren nicht nur den Blutfluss, sondern können auch das Herz, das Gehirn und andere Körperteile simulieren.

10. Transportindustrie

Supercomputer können verwendet werden, um die Aerodynamik, den Kraftstoffverbrauch, das Strukturdesign und die Kollisionsvermeidung von Fahrzeugen wie Autos, Flugzeugen oder Schiffen zu verstehen und zu verbessern und dazu beizutragen, den Passagierkomfort zu verbessern, Lärm zu reduzieren usw. , alles mit potenziellen wirtschaftlichen und sicherheitstechnischen Vorteilen.

Das obige ist der detaillierte Inhalt vonWas Hochleistungsrechner können. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was ist der allgemeine Begriff für alle elektronischen Geräte und elektromechanischen Geräte, aus denen ein Computer besteht?

- Was ist ein Computer für verschiedene Anwendungsbereiche und Algorithmen?

- Wie hoch ist die Geschwindigkeit beim Hochladen auf den Computer, auch Netzwerk-Breitband genannt?

- Zu welchen Protokollen der Computernetzwerkarchitektur gehören TCP und UDP?

- Welche Geräte implementieren die Verbindung auf der Datenverbindungsebene von Computernetzwerken?

- Worauf beziehen sich computertechnische Leistungsindikatoren hauptsächlich?