Heim >Betrieb und Instandhaltung >Betrieb und Wartung von Linux >BigData-Big-Data-Betrieb und -Wartung

BigData-Big-Data-Betrieb und -Wartung

- 重铸Original

- 2020-07-23 17:24:20308Durchsuche

Big-Data-Betrieb und -Wartung

1.HDFSVerteiltes Dateisystem-Betrieb und -Wartung

1.Rekursion im Stammverzeichnis des HDFS erstellen Dateisystemverzeichnis "1daoyun/file", laden Sie die angehängte Datei BigDataSkills.txt hoch Gehen Sie in das Verzeichnis 1daoyun/file und verwenden Sie die entsprechenden Befehle, um die Dateien im 1daoyun/file anzuzeigen > Verzeichnislisteninformationen.

hadoop fs -mkdir -p /1daoyun/file

hadoop fs -put BigDataSkills.txt /1daoyun/file

hadoop fs -ls /1daoyun/file

2.in HDFS Erstellen Sie ein rekursives Verzeichnis "1daoyun/file" im Stammverzeichnis des Dateisystems, ändern Sie das BigDataSkills.txt , laden Sie sie in das Verzeichnis 1daoyun/file hoch und verwenden Sie HDFS Dateisystem Check-Tool prüft, ob Dateien beschädigt sind.

hadoop fs -mkdir -p /1daoyun/filehadoop fs -put BigDataSkills.txt/1daoyun/file

hadoop fsck /1daoyun/file/BigDataSkills.txt

3.

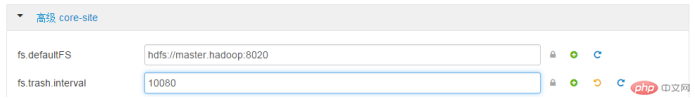

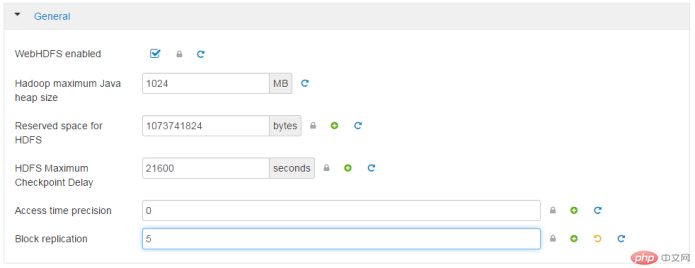

in Erstellen Sie ein rekursives Verzeichnis „1daoyun/file“ im Stammverzeichnis des HDFS-Dateisystems und fügen Sie das im Anhang BigDataSkills.txt wird in das Verzeichnis 1daoyun/file hochgeladen, und der Upload-Prozess gibt an BigDataSkills.txt Dateien im HDFS Dateisystem haben einen Replikationsfaktor von 2 und werden verwendet fsck ToolTool prüft die Anzahl der Kopien von Speicherblöcken. hadoop fs -mkdir -p /1daoyun/file hadoop fs -D dfs.replication=2 -put BigDataSkills.txt /1daoyun/file hadoop fsck /1daoyun/file/BigDataSkills.txt 4.HDFS Es gibt ein Dateisystem im Stammverzeichnis Verzeichnis /apps Dateiverzeichnis, es ist erforderlich, die Snapshot-Erstellungsfunktion dieses Verzeichnisses zu aktivieren und einen Snapshot für zu erstellen In der Verzeichnisdatei lautet der Snapshot-Name apps_1daoyun. Verwenden Sie , um die Listeninformationen der Snapshot-Datei mithilfe verwandter Befehle anzuzeigen. hadoop dfsadmin -allowSnapshot /apps hadoop fs -createSnapshot /apps apps_1daoyun hadoop fs -ls /apps/.snapshot 5.wann Hadoop Wenn der Cluster startet, wechselt er zunächst in den abgesicherten Modus, der standardmäßig nach 30 Sekunden beendet wird. Wenn sich das System im abgesicherten Modus befindet, kann das Dateisystem HDFS nur gelesen werden und kann keine Vorgänge wie Schreiben, Ändern, Löschen usw. ausführen. Gehen Sie nun davon aus, dass der Hadoop -Cluster gewartet werden muss und dass es notwendig ist, den Cluster in den abgesicherten Modus zu versetzen und seinen Status zu überprüfen. hdfs dfsadmin -safemode enter hdfs dfsadmin -safemode get 6.Um zu verhindern, dass Bediener versehentlich Dateien löschen, bietet das HDFS -Dateisystem die Papierkorbfunktion, aber Viele Junk-Dateien beanspruchen viel Speicherplatz. Es ist erforderlich, dass die WEB -Schnittstelle der Xiandian Big Data Platform vollständig aus der HDFS -Datei gelöscht wird Das Zeitintervall beträgt 7 Tage. ErweitertKernseitefs.trash.interval: 10080 7.Um zu verhindern, dass Bediener versehentlich Dateien löschen, bietet das HDFS Dateisystem eine Papierkorbfunktion, aber zu viele Junk-Dateien beanspruchen viel Speicherplatz. Es ist erforderlich, den Befehl „vi“ in der Linux Shell zu verwenden, um die entsprechenden Konfigurationsdateien und Parameterinformationen zu ändern Papierkorbfunktion. Starten Sie nach Abschluss den entsprechenden Dienst neu . ErweitertKernseitefs.trash.interval: 0vi /etc/hadoop/2.4.3.0 -227/0/core-site.xml dfs.sh 8.Hadoop Auf den Hosts im Cluster kann es unter bestimmten Umständen zu Ausfallzeiten oder Systemschäden kommen Sobald diese Probleme auftreten, werden die Datendateien im HDFS Dateisystem wird unweigerlich beschädigt oder geht verloren Um sicherzustellen HDFS Die Zuverlässigkeit des Dateisystems erfordert nun die redundante Replikation Faktor, der in der WEB- Schnittstelle der Xidian-Big-Data-Plattform verwendet werden soll. Geändert in 5. AllgemeinBlockreplikation5 9.Hadoop Bei den Hosts im Cluster kann es unter bestimmten Umständen zu Ausfallzeiten oder Systemschäden kommen Diese Probleme, HDFS Datendateien im Dateisystem werden unweigerlich beschädigt oder gehen verloren, Um sicherzustellen, dass HDFS Für die Zuverlässigkeit von Im Dateisystem muss der Redundanzreplikationsfaktor des Clusters in Linux Shell

oder

oder

vi/etc/hadoop/2.4.3.0-227/0/hdfs- site.xml

>/usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh --config /usr/hdp/current/hadoop-client/conf stop {namenode/datenode}

/usr/hdp/current/hadoop-client/sbin/hadoop-daemon.sh --config /usr/hdp/current/hadoop-client/conf start {namenode/datenode }

10.

Verwenden Sie den Befehl, um das hdfs

Dateisystem /tmp anzuzeigen

Die Anzahl der Verzeichnisse unter dem Verzeichnis, die Anzahl der Dateien und die Gesamtgröße der Dateien . hadoop fs -count /tmp2.MapREDUCE Fallfrage

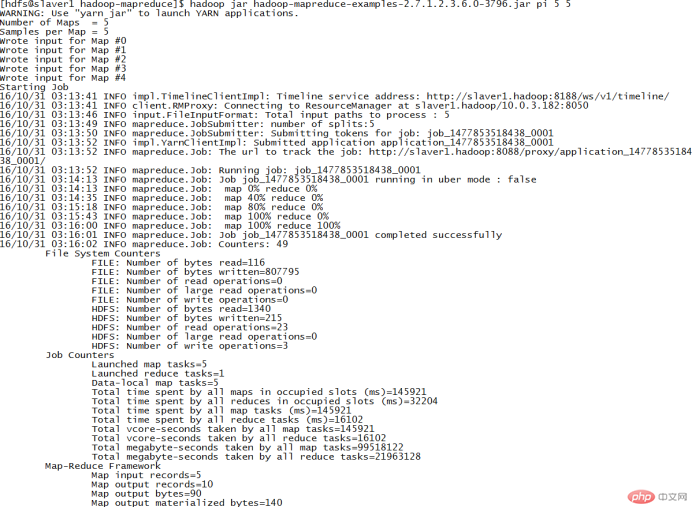

1.Im Clusterknoten/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis, es gibt ein Fall JAR Paket hadoop-mapreduce-examples.jar. Führen Sie das Programm PI im JAR-Paket aus, um die PiπApproximation von zu berechnen , erfordert das Ausführen von 5 Malen für jede Map -Aufgabe Die Anzahl der Würfe für die Aufgabe beträgt 5. cd /usr/hdp/2.4.3.0-227/hadoop-mapreduce/

hadoop jar hadoop- mapreduce-examples-2.7.1.2.4.3.0-227.jar pi 5 5

2. Es gibt einen Fall

Es gibt einen Fall

/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis 🎜>JAR Pakethadoop-mapreduce-examples.jar. Führen Sie das Programm wordcount im Paket JAR aus, um ein Paar /1daoyun/file zu erstellen / Die Datei BigDataSkills.txt zählt Wörter, gibt die Operationsergebnisse im Verzeichnis /1daoyun/output aus und verwendet zugehörige Befehle, um die Ergebnisse der Wortzählung abzufragen. hadoop jar/usr/hdp/2.4.3.0-227/hadoop-mapreduce/hadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar wordcount /1daoyun/ file/BigDataSkills.txt /1daoyun/output

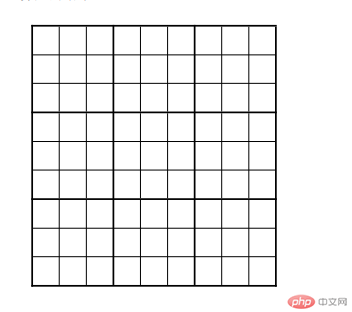

3.Im Clusterknoten/usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis, es gibt ein Fall JAR Paket hadoop-mapreduce-examples.jar. Führen Sie das Programm Sudoku im Paket JAR aus, um die Ergebnisse der Sudoku-Aufgaben in der Tabelle unten zu berechnen . .

cat puzzle1.dta

hadoop jarhadoop-mapreduce-examples- 2.7.1.2.4.3.0-227.jar sudoku /root/puzzle1.dta

4.im Clusterknoten /usr/hdp/2.4.3.0-227/hadoop-mapreduce/ Verzeichnis, es gibt einen Fall JAR Paket hadoop-mapreduce-examples.jar. Führen Sie das Programm grep im Paket JAR aus, um das Dateisystem / 1daoyun/file/BigDataSkills zu zählen. txt Die Anzahl der Vorkommen von "Hadoop" in der Datei. Fragen Sie nach dem Zählen die statistischen Ergebnisinformationen ab.

hadoop jarhadoop-mapreduce-examples-2.7.1.2.4.3.0-227.jar grep /1daoyun/file/BigDataSkills.txt /output hadoop

Das obige ist der detaillierte Inhalt vonBigData-Big-Data-Betrieb und -Wartung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Erfahren Sie, wie Sie den Nginx-Server unter Linux installieren

- Detaillierte Einführung in den wget-Befehl von Linux

- Ausführliche Erläuterung von Beispielen für die Verwendung von yum zur Installation von Nginx unter Linux

- Detaillierte Erläuterung der Worker-Verbindungsprobleme in Nginx

- Detaillierte Erläuterung des Installationsprozesses von Python3 unter Linux