Heim >Backend-Entwicklung >Python-Tutorial >Das effizienteste Python-Crawler-Framework aller Zeiten (empfohlen)

Das effizienteste Python-Crawler-Framework aller Zeiten (empfohlen)

- 烟雨青岚nach vorne

- 2020-07-02 13:20:273722Durchsuche

Webcrawler (in der FOAF-Community auch als Web-Spider, Web-Roboter und häufiger als Web-Page-Chaser bekannt) sind eine Art Web-Crawler, der automatisch bestimmte Regeln befolgt Programm oder Skript, das Informationen aus dem World Wide Web crawlt. Finden wir es unten gemeinsam heraus.

1. Scrapy

Scrapy ist ein Anwendungsframework, das zum Crawlen von Website-Daten und zum Extrahieren von Strukturdaten geschrieben wurde. Es kann in einer Reihe von Programmen verwendet werden, darunter Data Mining, Informationsverarbeitung oder Speicherung historischer Daten. . Mit diesem Framework können Sie problemlos Daten wie Amazon-Produktinformationen durchsuchen.

Projektadresse: https://scrapy.org/

2PySpider

pyspider ist ein Ein leistungsstarkes Web-Crawler-System, das in Python implementiert ist. Es kann Skripte schreiben, Funktionen planen und Crawling-Ergebnisse in Echtzeit auf der Browseroberfläche anzeigen. Das Backend verwendet häufig verwendete Datenbanken zum Speichern von Crawling-Ergebnissen und kann auch Zeitpläne festlegen .

Projektadresse: https://github.com/binux/pyspider

3.Crawley

Crawley kann den Inhalt der entsprechenden Website mit hoher Geschwindigkeit crawlen, unterstützt relationale und nicht relationale Datenbanken und die Daten können in JSON, XML usw. exportiert werden.

Projektadresse: http://project.crawley-cloud.com/

4.Portia

Portia ist ein visuelles Open-Source-Crawler-Tool, mit dem Sie Websites ohne Programmierkenntnisse crawlen können! Kommentieren Sie einfach die Seiten, die Sie interessieren, und Portia erstellt einen Spider, um Daten von ähnlichen Seiten zu extrahieren.

Projektadresse: https://github.com/scrapinghub/portia

5. Zeitung

Zeitungen können zum Extrahieren von Nachrichten, Artikeln und zur Inhaltsanalyse verwendet werden. Verwenden Sie Multithreading, unterstützen Sie mehr als 10 Sprachen usw.

Projektadresse: https://github.com/codelucas/newspaper

6.Schöne Suppe

Beautiful Soup ist eine Python-Bibliothek, die Daten aus HTML- oder XML-Dateien extrahieren kann. Sie kann die übliche Art der Dokumentennavigation, -suche und -änderung über Ihren bevorzugten Konverter realisieren und Ihnen Stunden oder sogar Tage ersparen.

Projektadresse: https://www.crummy.com/software/BeautifulSoup/bs4/doc/

7.Grab

Grab ist ein Python-Framework zum Erstellen von Web-Scrapern. Mit Grab können Sie Web-Scraper unterschiedlicher Komplexität erstellen, von einfachen 5-Zeilen-Skripten bis hin zu komplexen asynchronen Website-Scrapern, die Millionen von Webseiten verarbeiten. Grab bietet eine API zum Durchführen von Netzwerkanfragen und zum Verarbeiten empfangener Inhalte, beispielsweise für die Interaktion mit dem DOM-Baum eines HTML-Dokuments.

Projektadresse: http://docs.grablib.org/en/latest/#grab-spider-user-manual

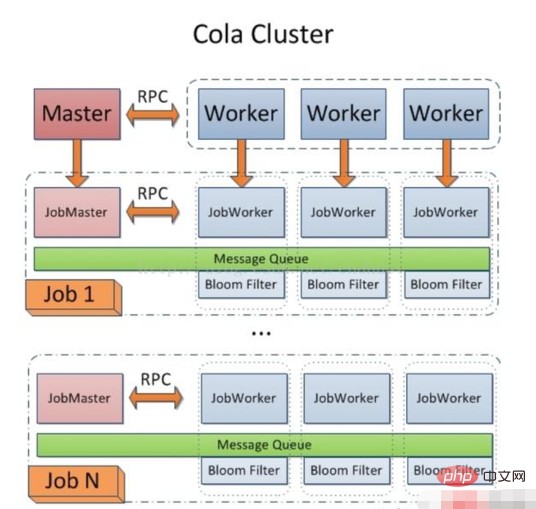

8 .Cola

Cola ist ein verteiltes Crawler-Framework. Für Benutzer müssen sie nur einige spezifische Funktionen schreiben, ohne auf die Details des verteilten Betriebs zu achten. Aufgaben werden automatisch auf mehrere Maschinen verteilt und der gesamte Prozess ist für den Benutzer transparent.

Projektadresse: https://github.com/chineking/cola

Vielen Dank fürs Lesen, ich hoffe, Sie werden viel davon profitieren.

Nachdruck unter: https://www.toutiao.com/i6560240315519730190/

Empfohlenes Tutorial: „Python-Tutorial“

Das obige ist der detaillierte Inhalt vonDas effizienteste Python-Crawler-Framework aller Zeiten (empfohlen). Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!