Heim >häufiges Problem >BP-Algorithmus für neuronale Netzwerke

BP-Algorithmus für neuronale Netzwerke

- (*-*)浩Original

- 2019-10-24 14:10:0710190Durchsuche

Das BP-Netzwerk (Back Propagation) wurde 1986 von einer Gruppe von Wissenschaftlern unter der Leitung von Rumelhart und McCelland vorgeschlagen. Es ist ein mehrschichtiges Feedforward-Netzwerk, das nach dem Fehler-Back-Propagation-Algorithmus trainiert wurde Verwendetes neuronales Netzwerkmodell eins.

Das BP-Netzwerk kann eine große Anzahl von Eingabe-Ausgabe-Musterzuordnungsbeziehungen lernen und speichern, ohne die mathematischen Gleichungen, die diese Zuordnungsbeziehung beschreiben, im Voraus offenzulegen.

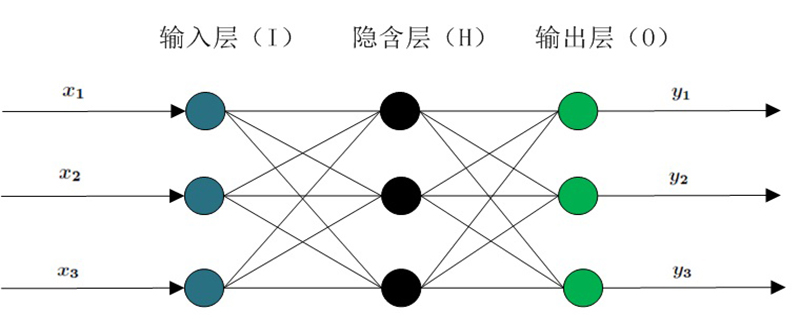

Seine Lernregel besteht darin, die Methode des steilsten Abstiegs zu verwenden und die Gewichte und Schwellenwerte des Netzwerks durch Backpropagation kontinuierlich anzupassen, um die Summe der quadratischen Fehler des Netzwerks zu minimieren. Die Topologiestruktur des neuronalen BP-Netzwerkmodells umfasst die Eingabeschicht, die verborgene Schicht und die Ausgabeschicht. (Empfohlenes Lernen: Web-Front-End-Video-Tutorial)

BP-Neuronales Netzwerk-Algorithmus wird auf der Grundlage des vorhandenen BP-Neuronalen Netzwerk-Algorithmus durch willkürliche Auswahl vorgeschlagen Mit einer Reihe von Gewichten wird die gegebene Zielausgabe direkt als algebraische Summe linearer Gleichungen verwendet, um ein System linearer Gleichungen zu erstellen. Die Lösung erfordert kein lokales Minimum und keine langsamen Konvergenzprobleme herkömmlicher Methoden zu verstehen.

BP-Algorithmus

Künstliche neuronale Netze (ANN) erschienen nach den 1940er Jahren. Es ist durch zahlreiche Neuronen regulierbar. Es ist durch Verbindungsgewichte verbunden und hat die Eigenschaften von großen -Skalierte Parallelverarbeitung, verteilte Informationsspeicherung und gute Selbstorganisations- und Selbstlernfähigkeiten werden zunehmend in den Bereichen Informationsverarbeitung, Mustererkennung, intelligente Steuerung und Systemmodellierung eingesetzt.

Insbesondere das Fehler-Backpropagation-Training (BP-Netzwerk) kann jede kontinuierliche Funktion annähern und verfügt über starke nichtlineare Abbildungsfähigkeiten sowie die Anzahl der Zwischenschichten des Netzwerks und die Verarbeitungseinheiten jeder Schicht. Parameter wie Die Anzahl und der Lernkoeffizient des Netzwerks können je nach Situation eingestellt werden. Die Flexibilität ist groß und spielt daher in vielen Anwendungsbereichen eine wichtige Rolle.

Um die Mängel des neuronalen BP-Netzwerks zu beheben, wie z. B. langsame Konvergenzgeschwindigkeit, Unfähigkeit, Konvergenz zum globalen Maximalpunkt zu garantieren, fehlende theoretische Anleitung bei der Auswahl der mittleren Schicht des Netzwerks und der Anzahl seiner Einheiten Aufgrund der Instabilität des Netzwerklernens und des Gedächtnisses wurden für diese Methode viele verbesserte Algorithmen vorgeschlagen.

Das obige ist der detaillierte Inhalt vonBP-Algorithmus für neuronale Netzwerke. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!