Heim >Backend-Entwicklung >Python-Tutorial >Kann Spark Python ausführen?

Kann Spark Python ausführen?

- 藏色散人Original

- 2019-08-06 11:53:503390Durchsuche

Kann Spark Python ausführen?

spark kann Python-Programme ausführen. In Python oder Erweiterungsbibliotheken wie sklearn geschriebene Algorithmen können auf Spark ausgeführt werden. Es ist auch möglich, die mllib von Spark direkt zu verwenden, die für die meisten Algorithmen verfügbar ist.

Spark ist eine Allzweck-Engine, mit der eine Vielzahl von Vorgängen ausgeführt werden können, darunter SQL-Abfragen, Textverarbeitung, maschinelles Lernen usw.

Dieses Experiment wurde unter Linux mit einer Spark-Umgebung ausgeführt. Die Spark-Version ist äquivalent zur lokalen Ausführung in Spark. Die Spark-Datei wird in /opt/moudles/spark-1.6 abgelegt. 1/ (Sie werden es im Code sehen)

Schreiben Sie ein Python-Testprogramm

#test.py文件

# -*- coding:utf-8 -*-

import os

import sys

#配置环境变量并导入pyspark

os.environ['SPARK_HOME'] = r'/opt/moudles/spark-1.6.1'

sys.path.append("/opt/moudles/spark-1.6.1/python")

sys.path.append("/opt/moudles/spark-1.6.1/python/lib/py4j-0.9-src.zip")

from pyspark import SparkContext, SparkConf

appName ="spark_1" #应用程序名称

master= "spark://hadoop01:7077"#hadoop01为主节点hostname,请换成自己的主节点主机名称

conf = SparkConf().setAppName(appName).setMaster(master)

sc = SparkContext(conf=conf)

data = [1, 2, 3, 4, 5]

distData = sc.parallelize(data)

res = distData.reduce(lambda a, b: a + b)

print("===========================================")

print (res)

print("===========================================")Führen Sie das Python-Programm aus

Führen Sie den folgenden Befehl aus

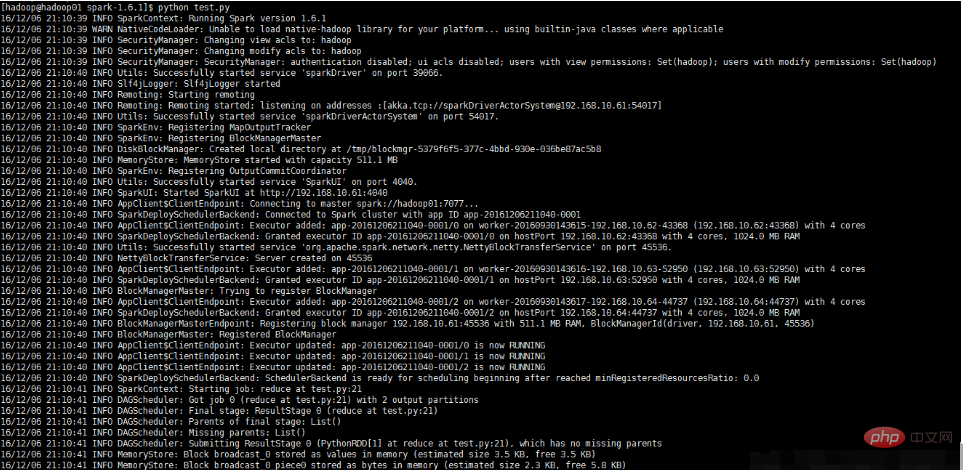

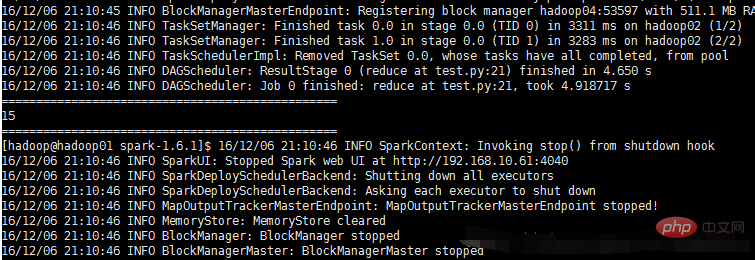

python test.py

Die Ausführung und die Ergebnisse sind in der folgenden Abbildung dargestellt:

Das obige ist der detaillierte Inhalt vonKann Spark Python ausführen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- So konfigurieren Sie opencv in Python

- So zeichnen Sie ein Kaninchen mit Python – eine detaillierte Einführung in die Verwendung der Kreiszeichnungsfunktion „circle()' in der Turtle-Bibliothek

- Die umfassendste Zusammenfassung der Verwendung von Python-Pandas

- Verstehen Sie sich selbst in Python in einem Artikel