Heim >Backend-Entwicklung >Python-Tutorial >Wie schreibe ich einen Crawler in Python?

Wie schreibe ich einen Crawler in Python?

- silencementOriginal

- 2019-05-18 19:22:1625010Durchsuche

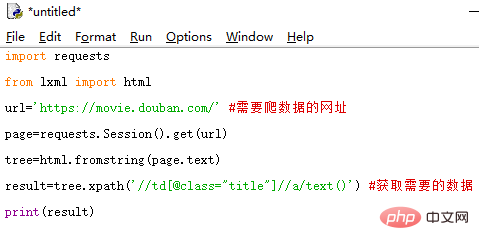

So schreiben Sie einen Crawler in Python: Rufen Sie zuerst die Python-Drittanbieter-Bibliothek „requests“ und „lxml“ auf. Verwenden Sie dann „requests“, um die Webseite anzufordern, und „lxml“, um das angeforderte Web zu analysieren page; schließlich „print“ verwenden. Die Anweisung druckt das Ergebnis.

Wie schreibe ich einen Crawler in Python?

Rufen Sie zuerst die Python-Bibliotheksanforderungen von Drittanbietern, lxml, auf. request ist für das Anfordern von Webseiten verantwortlich, lxml ist für das Parsen der angeforderten Webseiten verantwortlich und das Endergebnis wird mithilfe einer print-Anweisung ausgedruckt. Natürlich können wir die erfassten Daten auch in einer Datenbank speichern

Lassen Sie uns ohne weitere Umschweife einfach in den Code springen!

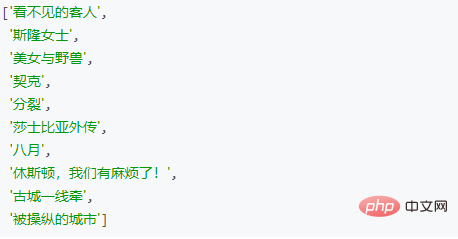

Ergebnisse zurückgeben

Das obige ist der detaillierte Inhalt vonWie schreibe ich einen Crawler in Python?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!