Heim >häufiges Problem >Was ist ein Reptil?

Was ist ein Reptil?

- 若昕Original

- 2019-04-24 13:49:414998Durchsuche

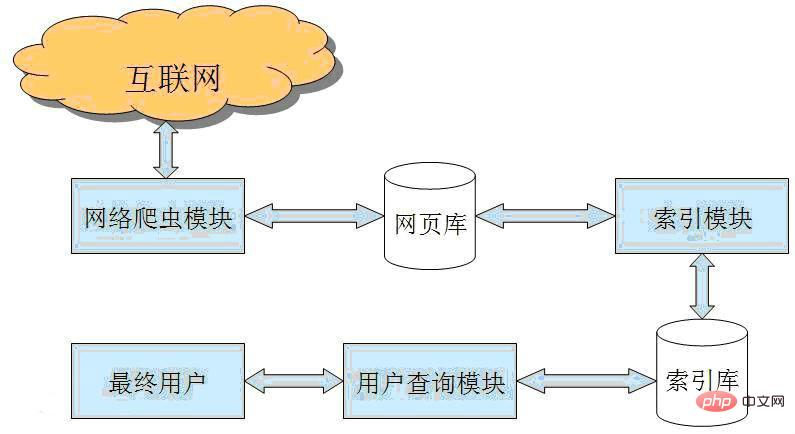

Webcrawler ist ein Programm oder Skript, das World Wide Web-Informationen nach bestimmten Regeln automatisch crawlt. Sie werden häufig in Internet-Suchmaschinen oder anderen ähnlichen Websites verwendet und können den Inhalt automatisch sammeln aller Seiten, auf die es zugreifen kann, um den Inhalt und die Abrufmethoden dieser Websites zu erhalten oder zu aktualisieren. Funktional gesehen sind Crawler im Allgemeinen in drei Teile unterteilt: Datenerfassung, -verarbeitung und -speicherung.

Herkömmliche Crawler beginnen mit der URL einer oder mehrerer Ausgangswebseiten und rufen die URL auf der Ausgangswebseite ab. Während des Crawlens der Webseite extrahieren sie kontinuierlich neue URLs von der aktuellen Seite und fügen sie ein in die Warteschlange gestellt, bis die Systemanforderungen erfüllt sind. Der Arbeitsablauf des fokussierten Crawlers ist komplexer und erfordert das Filtern von Links, die nichts mit dem Thema zu tun haben, auf der Grundlage eines bestimmten Webseiten-Analysealgorithmus, das Beibehalten nützlicher Links und das Einfügen in die URL-Warteschlange, die auf das Crawlen wartet. Anschließend wählt es gemäß einer bestimmten Suchstrategie die als nächstes zu crawlende Webseiten-URL aus der Warteschlange aus und wiederholt den obigen Vorgang, bis er stoppt, wenn ein bestimmter Zustand des Systems erreicht ist. Darüber hinaus werden alle von Crawlern gecrawlten Webseiten vom System gespeichert und einer bestimmten Analyse, Filterung und Indizierung für nachfolgende Abfragen und Abrufe unterzogen. Die in diesem Prozess erhaltenen Analyseergebnisse können auch Feedback und Anleitung geben zukünftige Crawling-Prozesse.

Das obige ist der detaillierte Inhalt vonWas ist ein Reptil?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!