Heim >Backend-Entwicklung >Python-Tutorial >Eine Erläuterung der Implementierungsmethode der Python+OpenCV-Bildstilmigration

Eine Erläuterung der Implementierungsmethode der Python+OpenCV-Bildstilmigration

- 不言nach vorne

- 2018-10-16 14:21:405281Durchsuche

Der Inhalt dieses Artikels besteht darin, die Implementierungsmethode der Python + OpenCV-Bildstilmigration zu erläutern. Ich hoffe, dass er für Freunde hilfreich ist.

Viele Menschen machen mittlerweile gerne Fotos (Selfies). Sie werden es satt haben, zu viel mit den begrenzten Filtern und Dekorationen herumzuspielen, deshalb gibt es Apps, die die Funktion den Stil berühmter Gemälde nachahmen bieten, wie z. B. Prisma, Versa usw., die Ihr Bild verwandeln können Fotos in Van Gogh, Die Stile von Meistern wie Picasso und Munch.

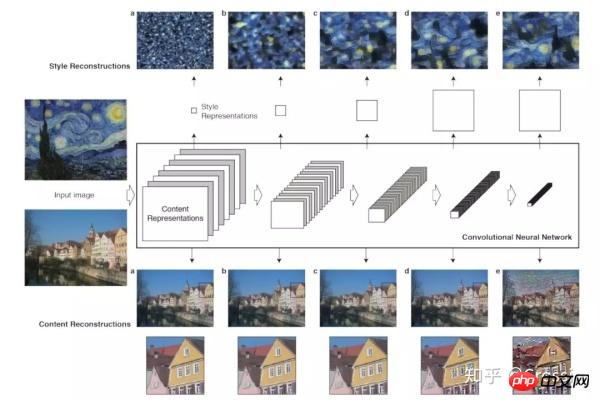

Diese Funktion heißt „Image Style Transfer“ und basiert fast ausschließlich auf dem CVPR 2015-Papier „A Es wurde auf der Grundlage der in Neural Algorithm of Artistic Style und dem ECCV 2016-Papier „Perceptual Losses for Real-Time Style Transfer and Super-Resolution“ sowie nachfolgenden verwandten Algorithmen entwickelt Forschung.

Laienhaft ausgedrückt bedeutet es, das neuronale Netzwerk zu verwenden, um die Stile berühmter Gemälde vorab in Modelle zu trainieren und sie dann auf verschiedene Fotos anzuwenden, um neue stilisierte Bilder zu erzeugen.

Aus „A Neural Algorithm of Artistic Style“

Und weil neuronale Netze zunehmend in der Computer Vision eingesetzt werden, dem berühmten Bild Die Entwicklungsbibliothek OpenCV hat in Version 3.3 offiziell DNN (Deep Neural Network) eingeführt und unterstützt Modelle gängiger Frameworks wie Caffe, TensorFlow, Torch/PyTorch usw., die zur Realisierung von Bilderkennung, Erkennung, und Klassifizierung, Segmentierung, Färbung und andere Funktionen.

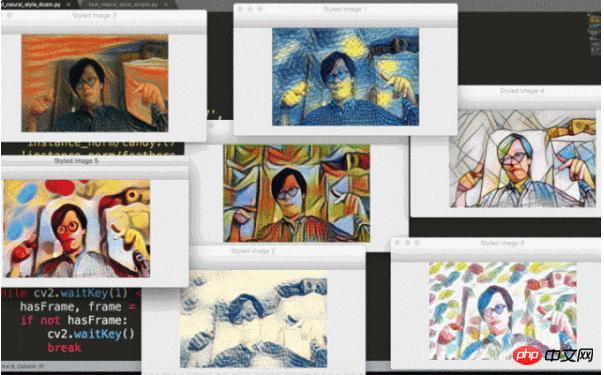

Ich habe erst kürzlich entdeckt, dass es im OpenCV-Beispielcode (entschuldigen Sie meinen Rückblick) ein Python-Beispiel für die Übertragung von Bildstilen gibt, das auf der Netzwerkmodellimplementierung im ECCV-Artikel von 2016 basiert. Daher können Sie auch als Neuling in der künstlichen Intelligenz mit von anderen trainierten Modellen spielen und die Wunder neuronaler Netze erleben.

(Relevante Codes und Modelle finden Sie am Ende des Artikels)

Offizielle OpenCV-Codeadresse: https://github.com/opencv/opencv/blob/3.4.0/samples/ dnn/fast_neural_style Führen Sie den Code aus, indem Sie den Befehl im Verzeichnis .py

ausführen:

python fast_neural_style.py --model starry_night.t7

model Der Parameter dient nicht dazu, den Pfad zur vorab trainierten Modelldatei bereitzustellen Bereitstellung von Downloads, aber das Referenzprojekt https:

finden Sie unter //github.com/jcjohnson/fast-neural-style. Weitere einstellbare Parameter sind:

inputSie können das Originalbild/-video angeben. Wenn nicht angegeben, wird die Kamera standardmäßig für die Echtzeiterfassung verwendet.width,height, passen Sie die Größe des verarbeiteten Bildes an. Eine kleinere Einstellung kann die Berechnungsgeschwindigkeit verbessern. Auf meinem eigenen Computer kann ein konvertiertes 300x200-Video 15 fps erreichen.median_filterDie Fenstergröße des Medianfilters wird zur Glättung des Ergebnisbildes verwendet. Dies hat nur geringe Auswirkungen auf das Ergebnis.

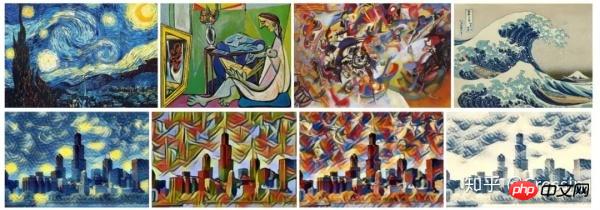

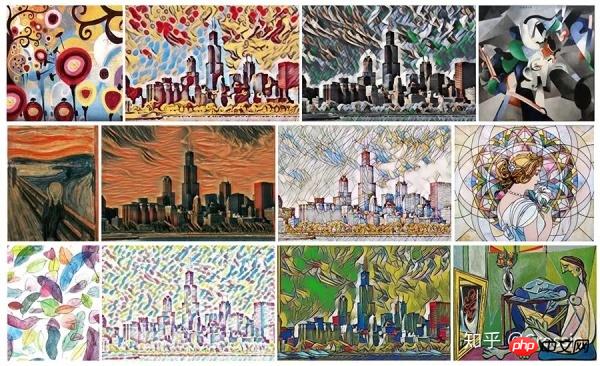

Der Effekt nach der Ausführung (entnommen aus jcjohnson/fast-neural-style):

Original Bild

ECCV16-Modelle

instance_norm-Modelle

Der Kerncode ist eigentlich sehr kurz, einfach Laden Sie das Bild-> Führen Sie die Berechnung durch Beispiel:

import cv2

# 加载模型

net = cv2.dnn.readNetFromTorch('the_scream.t7')

net.setPreferableBackend(cv2.dnn.DNN_BACKEND_OPENCV);

# 读取图片

image = cv2.imread('test.jpg')

(h, w) = image.shape[:2]

blob = cv2.dnn.blobFromImage(image, 1.0, (w, h), (103.939, 116.779, 123.680), swapRB=False, crop=False)

# 进行计算

net.setInput(blob)

out = net.forward()

out = out.reshape(3, out.shape[2], out.shape[3])

out[0] += 103.939

out[1] += 116.779

out[2] += 123.68

out /= 255

out = out.transpose(1, 2, 0)

# 输出图片

cv2.imshow('Styled image', out)

cv2.waitKey(0)

Außerdem wurde eine Version mit Echtzeitvergleich mehrerer Effekte geändert (der Berechnungsaufwand ist groß und sehr verzögert) und auch im Code hochgeladen.

PS: Als ich mir vor zwei Tagen das Konzert von Zhao Lei angesehen habe, habe ich auch gesagt: Es gibt viele Hintergrund-MVs Für sein Konzert erinnert mich die Verwendung von Bildbinarisierung, Kantenerkennung und anderen Operationen an die großen Aufgaben in Kursen zur digitalen Bildverarbeitung in der Vergangenheit ... Jetzt, da die Effizienz der Bildstilübertragung Echtzeit erreicht hat, glaube ich, dass dies der Fall sein wird künftig häufig genutzt werden.

Das obige ist der detaillierte Inhalt vonEine Erläuterung der Implementierungsmethode der Python+OpenCV-Bildstilmigration. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!