Heim >Backend-Entwicklung >Python-Tutorial >Was ist ein Python-Crawler? Warum wird Python Crawler genannt?

Was ist ein Python-Crawler? Warum wird Python Crawler genannt?

- 乌拉乌拉~Original

- 2018-08-13 14:37:4071293Durchsuche

Heute erklären wir die grundlegenden konzeptionellen Kenntnisse von Python. Viele Freunde, die neu in Python sind, haben viele Fragen: Was ist ein Python-Crawler? Warum wird Python dann Crawler genannt?

Was ist ein Python-Crawler?

Bevor wir den Artikel betreten, müssen wir zunächst wissen, was ein Crawler ist. Ein Crawler, also ein Webcrawler, kann als eine Spinne verstanden werden, die im Internet kriecht. Das Internet wird mit einem großen Netz verglichen, und ein Crawler ist eine Spinne, die in diesem Netz herumkriecht, wenn sie auf ihre Beute trifft ), dann wird es es packen. Wenn es beispielsweise eine Webseite crawlt und einen Pfad in dieser Webseite findet, bei dem es sich tatsächlich um einen Hyperlink handelt, der auf die Webseite verweist, kann es zu einer anderen Webseite crawlen, um Daten abzurufen. Wenn es nicht leicht zu verstehen ist, können Sie es anhand der folgenden Bilder tatsächlich verstehen:

Aufgrund der Skriptfunktionen von Python Die Verarbeitung von Zeichen ist in Python ebenfalls sehr flexibel und verfügt über umfangreiche Web-Crawling-Module, sodass beide häufig miteinander verknüpft sind. Python-Crawler-Entwicklungsingenieure beginnen auf einer bestimmten Seite der Website (normalerweise der Homepage), lesen den Inhalt der Webseite, finden andere Linkadressen auf der Webseite und finden dann über diese Linkadressen die nächste Webseite wird so lange fortgesetzt, bis alle Webseiten der Website gecrawlt wurden. Betrachtet man das gesamte Internet als Website, dann können Webspider dieses Prinzip nutzen, um alle Webseiten im Internet zu crawlen.

Crawler kann den Inhalt einer Website oder einer Anwendung crawlen und nützlichen Wert extrahieren. Es kann auch Benutzervorgänge in Browsern oder App-Anwendungen simulieren, um automatisierte Verfahren zu implementieren. Die folgenden Verhaltensweisen können mit Crawlern erreicht werden:

Vote Grabbing Artifact

Voting Artifact

Prediction (Stock Marktprognose, Kassenprognose)

Nationale Stimmungsanalyse

Soziale Beziehungsnetzwerke

Wie oben erwähnt, können wir davon ausgehen, dass

Crawler sich im Allgemeinen auf das Crawlen von Netzwerken beziehen Ressourcen und weil die Skriptfunktionen von Python nicht nur einfach zu konfigurieren, sondern auch sehr flexibel in der Zeichenverarbeitung sind. Darüber hinaus verfügt Python über umfangreiche Web-Crawling-Module, sodass beide häufig miteinander verknüpft sind. Aus diesem Grund wird Python als Crawler bezeichnet.

Warum wird Python Crawler genannt? Als Programmiersprache ist Python wegen seiner prägnanten und klaren Syntax und der erzwungenen Verwendung von Leerzeichen zum Einrücken von Anweisungen sehr beliebt. Um ein Beispiel zu nennen: Um eine Aufgabe zu erledigen, müssen insgesamt 1.000 Codezeilen in der Sprache C, 100 Codezeilen in Java und nur 20 Codezeilen in Python geschrieben werden. Wenn Sie Python zum Ausführen von Programmieraufgaben verwenden, schreiben Sie weniger Code und der Code ist präziser, kürzer und besser lesbar. Wenn ein Team entwickelt, kann es den Code anderer Personen schneller lesen und die Entwicklungseffizienz verbessern höher, was die Arbeit effizienter macht.

Dies ist eine Programmiersprache, die sich sehr gut für die Entwicklung von Webcrawlern eignet. Im Vergleich zu anderen statischen Programmiersprachen ist die Schnittstelle von Python zum Crawlen von Webdokumenten im Vergleich zu anderen dynamischen Skriptsprachen einfacher. Das urllib2-Paket von Python bietet eine relativ einfache Möglichkeit vollständige API für den Zugriff auf Webdokumente. Darüber hinaus gibt es in Python hervorragende Pakete von Drittanbietern, die das Crawlen von Webseiten effizient implementieren und die Tag-Filterfunktion von Webseiten mit sehr kurzen Codes vervollständigen können.

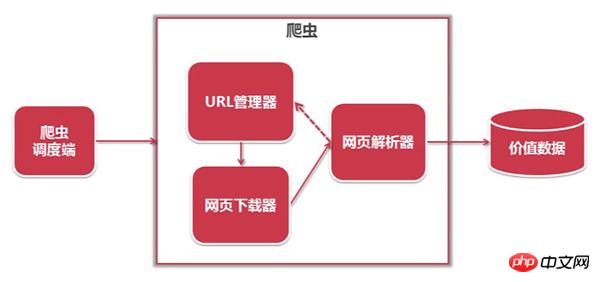

Die Architektur des Python-Crawlers ist wie folgt:

3. Analysiert wertvolle Daten, speichert sie und fügt die URL dem URL-Manager hinzu.

Der Workflow von Python ist wie folgt:

(Der Python-Crawler ermittelt, ob eine URL zum Crawlen vorhanden ist Manager: Wenn eine URL gecrawlt werden muss, wird sie über den Planer an den Downloader übergeben, der URL-Inhalt wird heruntergeladen und über den Planer an den Parser gesendet, der URL-Inhalt wird analysiert und die Wertdaten und die neue URL werden aufgelistet werden über den Scheduler an die Anwendung übergeben und der Wert wird ausgegeben Informationsprozess )

Python ist eine Programmiersprache, die sich sehr gut für die Entwicklung von Webcrawlern eignet. Sie bietet Module wie urllib, re, json, pyquery usw. und verfügt auch über viele etablierte Frameworks wie das Scrapy-Framework und das PySpider-Crawler-System. usw., was an sich sehr einfach und praktisch ist, daher ist es die bevorzugte Programmiersprache für Webcrawler. Ich hoffe, dieser Artikel kann Freunden, die gerade mit der Python-Sprache in Berührung gekommen sind, etwas helfen!

Das obige ist der detaillierte Inhalt vonWas ist ein Python-Crawler? Warum wird Python Crawler genannt?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!