Heim >Datenbank >MySQL-Tutorial >Wie kann die Leistung optimiert werden? Detailliertes Beispiel für die Implementierung von Batch-Einfügungen durch MySQL zur Optimierung der Leistung

Wie kann die Leistung optimiert werden? Detailliertes Beispiel für die Implementierung von Batch-Einfügungen durch MySQL zur Optimierung der Leistung

- 零下一度Original

- 2017-04-28 09:37:151465Durchsuche

In diesem Artikel wird hauptsächlich das MySQL-Tutorial zum Implementieren der Stapeleinfügung zur Optimierung der Leistung vorgestellt. Die Laufzeit wird angegeben, um den Vergleich nach der Leistungsoptimierung auszudrücken.

Für einige Daten mit großen Datenmengen Datenmengen. In großen Systemen ist die Datenbank nicht nur mit einer geringen Abfrageeffizienz, sondern auch mit einer langen Datenspeicherzeit konfrontiert. Insbesondere bei Berichtssystemen kann der Zeitaufwand für den Datenimport mehrere Stunden oder mehr als zehn Stunden pro Tag betragen. Daher ist es sinnvoll, die Leistung beim Einfügen in die Datenbank zu optimieren.

Nach einigen Leistungstests mit MySQL innodb habe ich als Referenz einige Methoden gefunden, die die Einfügeeffizienz verbessern können.

1. Fügen Sie mehrere Daten mit einer SQL-Anweisung ein.

Häufig verwendete Einfügeanweisungen wie

INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('0', 'userid_0', 'content_0', 0); INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('1', 'userid_1', 'content_1', 1);

werden wie folgt geändert:

INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('0', 'userid_0', 'content_0', 0), ('1', 'userid_1', 'content_1', 1);

Der geänderte Einfügevorgang kann die Einfügeeffizienz von verbessern das Programm. Der Hauptgrund für die hohe Effizienz der zweiten SQL-Ausführung besteht darin, dass die Anzahl der Protokolle nach dem Zusammenführen (Binlog von MySQL und Transaktionsprotokolle von Innodb) reduziert wird, wodurch die Menge und Häufigkeit des Protokolllöschens verringert und dadurch die Effizienz verbessert wird. Durch das Zusammenführen von SQL-Anweisungen kann auch die Anzahl der SQL-Anweisungsanalysen reduziert und die Netzwerkübertragungs-E/A reduziert werden.

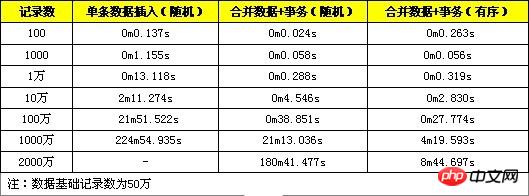

Hier sind einige Testvergleichsdaten, mit denen ein einzelnes Datenelement importiert und für den Import in eine SQL-Anweisung umgewandelt und jeweils 100, 1.000 und 10.000 Datensätze getestet werden sollen.

2. Führen Sie die Einfügeverarbeitung in der Transaktion durch.

Ändern Sie die Einfügung in:

START TRANSACTION; INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('0', 'userid_0', 'content_0', 0); INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('1', 'userid_1', 'content_1', 1); ... COMMIT;

3. Geben Sie die Daten der Reihe nach ein.

Ordentliches Einfügen von Daten bedeutet, dass die eingefügten Datensätze in der Reihenfolge des Primärschlüssels angeordnet sind. Datum/Uhrzeit ist beispielsweise der Primärschlüssel des Datensatzes:

INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('1', 'userid_1', 'content_1', 1); INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('0', 'userid_0', 'content_0', 0); INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`) VALUES ('2', 'userid_2', 'content_2',2);

geändert in :

INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`)

VALUES ('0', 'userid_0', 'content_0', 0);

INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`)

VALUES ('1', 'userid_1', 'content_1', 1);

INSERT INTO `insert_table` (`datetime`, `uid`, `content`, `type`)

VALUES ('2', 'userid_2', 'content_2',2);Da die Datenbank beim Einfügen Indexdaten verwalten muss, erhöhen ungeordnete Datensätze die Kosten für die Indexverwaltung. Wir können uns auf den von innodb verwendeten B+Tree-Index beziehen. Wenn sich jeder eingefügte Datensatz am Ende des Index befindet, ist die Indexpositionierungseffizienz sehr hoch, und die Indexanpassung ist gering Index, B+Tree erfordert mehr Rechenressourcen und die Indexpositionierungseffizienz der eingefügten Datensätze nimmt ab. Wenn die Datenmenge groß ist, kommt es zu häufigen Festplattenvorgängen.

Nachfolgend finden Sie einen Leistungsvergleich zwischen Zufallsdaten und sequentiellen Daten, die jeweils als 100, 1000, 10000, 100000 und 1 Million aufgezeichnet werden.

Aus den Testergebnissen geht hervor, dass sich die Leistung dieser Optimierungsmethode verbessert hat, die Verbesserung ist jedoch nicht sehr offensichtlich.

Umfassender Leistungstest:

Hier ist ein Test, der die oben genannten drei Methoden gleichzeitig verwendet, um die INSERT-Effizienz zu optimieren.

Aus den Testergebnissen geht hervor, dass die Leistungsverbesserung der Methode zum Zusammenführen von Daten + Transaktionen offensichtlich ist, wenn die Datenmenge klein ist Wenn die Datenmenge groß ist, ist die Leistungsverbesserung offensichtlich (mehr als 10 Millionen). Dies liegt daran, dass die Datenmenge zu diesem Zeitpunkt die Kapazität von innodb_buffer übersteigt Operationen, und die Leistung sinkt schnell. Die Methode, zusammengeführte Daten + Transaktionen + geordnete Daten zu verwenden, funktioniert immer noch gut, wenn das Datenvolumen mehrere zehn Millionen erreicht. Wenn das Datenvolumen groß ist, ist die Positionierung des geordneten Datenindex bequemer und erfordert keine häufigen Lese- und Schreibvorgänge auf der Festplatte Daher kann eine hohe Leistung aufrechterhalten werden.

Hinweise:

1. Beim Zusammenführen von Daten im selben SQL darf das SQL-Längenlimit nicht überschritten werden. Es kann über die max_allowed_packet-Konfiguration geändert werden . Der Standardwert ist 1M, wurde während des Tests auf 8M geändert.

2. Transaktionen müssen in ihrer Größe kontrolliert werden. Wenn eine Transaktion zu groß ist, kann dies die Ausführungseffizienz beeinträchtigen. MySQL verfügt über das Konfigurationselement innodb_log_buffer_size. Wenn dieser Wert überschritten wird, werden die Innodb-Daten auf die Festplatte geleert. Ein besserer Ansatz besteht daher darin, die Transaktion festzuschreiben, bevor die Daten diesen Wert erreichen.

Das obige ist der detaillierte Inhalt vonWie kann die Leistung optimiert werden? Detailliertes Beispiel für die Implementierung von Batch-Einfügungen durch MySQL zur Optimierung der Leistung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!