Heim >Backend-Entwicklung >Python-Tutorial >Ausführliche Erläuterung der automatischen IP-Proxy-Methode mit Python zum Crawlen weicher Prüfungsfragen

Ausführliche Erläuterung der automatischen IP-Proxy-Methode mit Python zum Crawlen weicher Prüfungsfragen

- 高洛峰Original

- 2017-03-31 10:00:492109Durchsuche

Vor kurzem habe ich vor, weiche Prüfungsfragen für die Prüfung zu erfassen. Bei der Erfassung sind einige Probleme aufgetreten. Der folgende Artikel stellt hauptsächlich die Verwendung von pythonCrawling der relevanten Informationen zum automatischen IP-Proxy für weiche Prüfungsfragen. Der Artikel stellt es ausführlich vor. Freunde, die es brauchen, können einen Blick unten werfen.

Vorwort

Seit kurzem gibt es eine Prüfung auf Software-Professional-Niveau, im Folgenden als Soft-Prüfung bezeichnet, um die Prüfung besser zu prüfen und vorzubereiten , ich habe vor, die weichen Prüfungsfragen von www.rkpass.cn zu übernehmen.

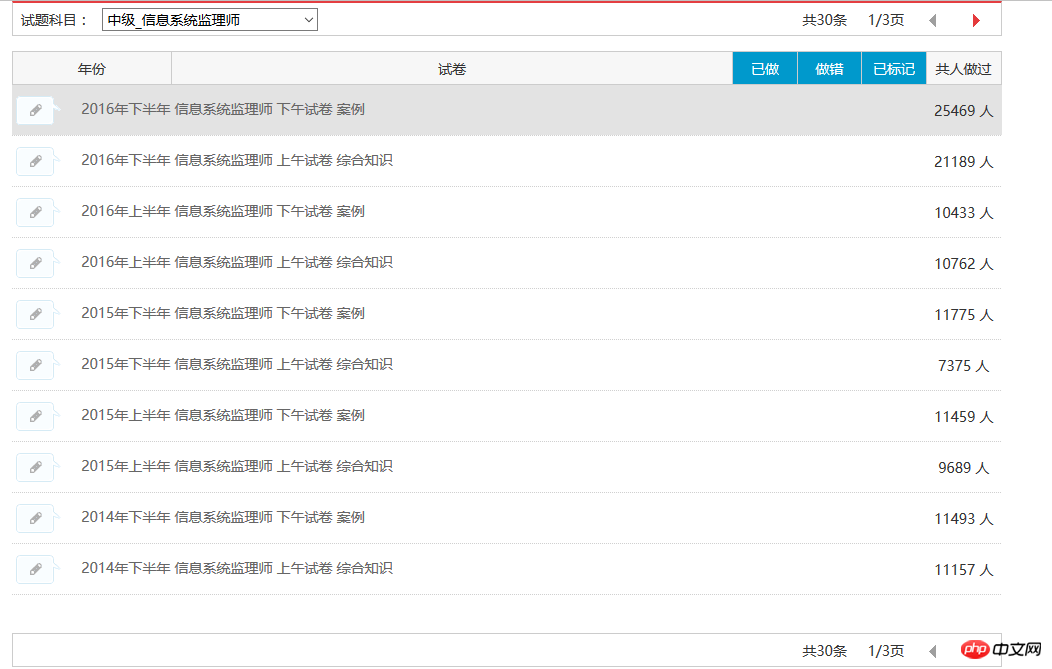

Lassen Sie mich zunächst die Geschichte (keng) des Crawlens weicher Prüfungsfragen (shi) erzählen die Fragen in einem bestimmten Modul, wie unten gezeigt:

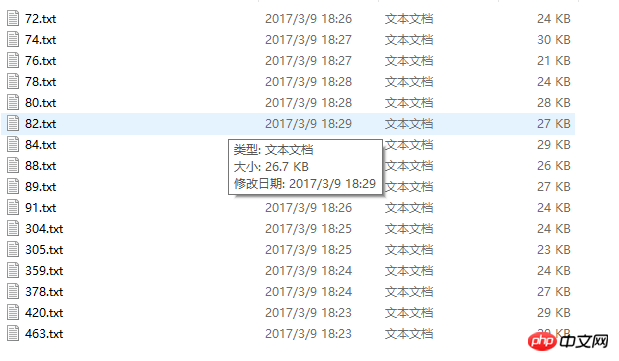

Derzeit können alle 30 Testfragendatensätze des Information System Supervisor erfasst werden. Die Ergebnisse sind wie folgt:

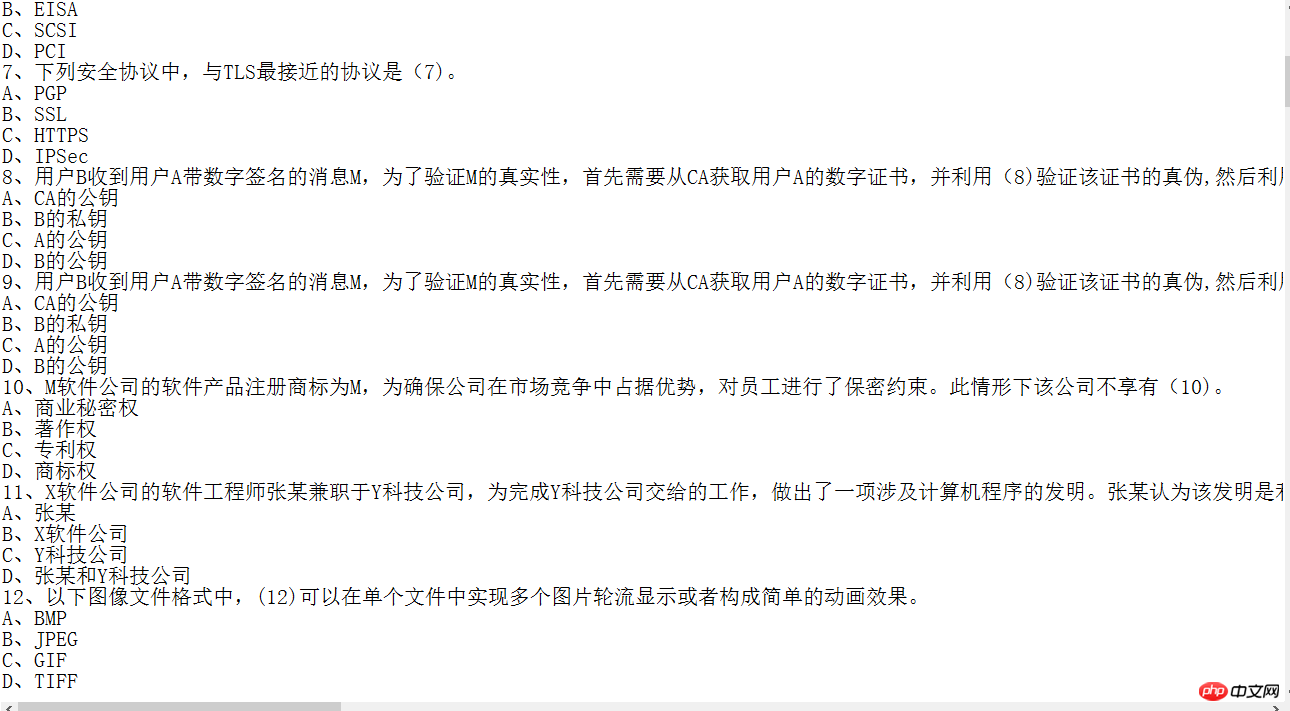

Erfasstes Inhaltsbild:

Obwohl einige Informationen erfasst werden können, ist die Qualität des Codes nicht hoch Die Erfassung von Informationssystem-Supervisoren als Beispiel. Da das Ziel klar ist, habe ich keine Ausnahmebehandlung durchgeführt, um die Testpapierinformationen zu erfassen

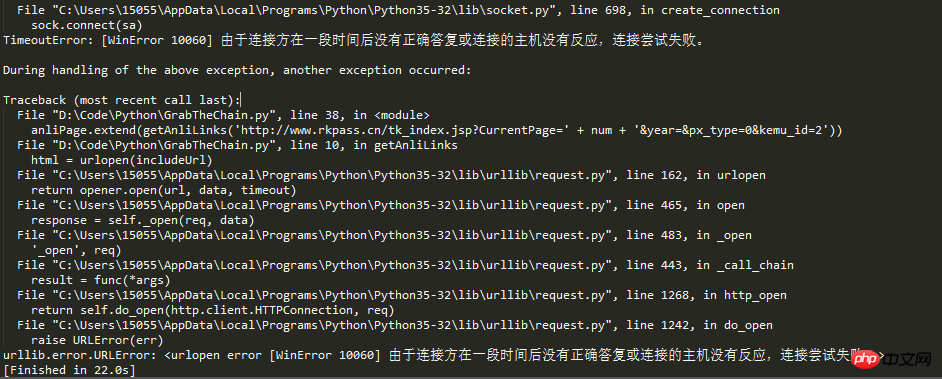

Zurück zum Thema und heute schreibe ich, weil ich auf eine neue Falle gestoßen bin. Aus dem Titel des Artikels können wir schließen, dass er angefordert wurde Zu oft wurde die IP durch den Anti-Crawler-Mechanismus der Website blockiert.

Die Taten unserer revolutionären Vorfahren können nicht ersticken dass wir als Nachfolger des Sozialismus nicht den Schwierigkeiten nachgeben, Straßen über Berge öffnen und Brücken über Flüsse bauen können, um das IP-Problem zu lösen, IP-Proxy. Diese Idee kommt beim Crawlen von Informationen zum Vorschein , wenn die Crawling-Häufigkeit den festgelegten Schwellenwert der Website überschreitet, wird der Zugriff normalerweise durch den Anti-Crawling-Mechanismus der Website anhand der IP-Adresse identifiziert Crawler-Entwickler müssen normalerweise zwei Methoden anwenden, um dieses Problem zu lösen:

1 Verlangsamen Sie die Crawling-Geschwindigkeit und verringern Sie den Druck auf die Zielwebsite 2. Die zweite Methode besteht darin, die Proxy-IP und andere Mittel festzulegen, um den Anti-Crawler-Mechanismus zu durchbrechen und mit hoher Frequenz weiter zu crawlen Gehen Sie zum Code: Screenshot der laufenden Ergebnisse:

Das obige ist der detaillierte Inhalt vonAusführliche Erläuterung der automatischen IP-Proxy-Methode mit Python zum Crawlen weicher Prüfungsfragen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!