Heim >Backend-Entwicklung >Python-Tutorial >Beispieldarstellung der Verwendung von Python Selenium zum Crawlen von Inhalten und Speichern der MySQL-Datenbank

Beispieldarstellung der Verwendung von Python Selenium zum Crawlen von Inhalten und Speichern der MySQL-Datenbank

- 高洛峰Original

- 2017-03-17 09:30:262323Durchsuche

In diesem Artikel wird hauptsächlich der Implementierungscode von Python Selenium-Crawling-Inhalten und deren Speicherung in der MySQL-Datenbank vorgestellt. Freunde, die ihn benötigen, können darauf verweisen.

Ich habe ihn weitergegeben früher In einem Artikel wird beschrieben, wie CSDN-Blogzusammenfassungen und andere Informationen gecrawlt werden. Nachdem der Selenium-Crawler zum Crawlen von Daten verwendet wurde, müssen diese normalerweise im TXT-Text gespeichert werden. Dies ist jedoch schwierig für die Datenverarbeitung und Datenanalyse. In diesem Artikel geht es hauptsächlich darum, meine persönlichen Blog-Informationen durch Selenium zu crawlen und sie dann in der Datenbank MySQL zu speichern, um die Daten zu analysieren, z. B. um zu analysieren, in welchem Zeitraum es mehr Blogs gibt, und um die Kombination mit WordCloud zu analysieren, um das Thema des Artikels zu analysieren. Artikelleseranking usw. .

Dies ist ein grundlegender Artikel. Ich hoffe, dass er für Sie hilfreich ist. Wenn der Artikel Fehler oder Mängel aufweist, verzeihen Sie mir bitte. Im nächsten Artikel wird der Prozess der Datenanalyse kurz erläutert.

1. Crawling-Ergebnisse

Die gecrawlte Adresse lautet: http://blog.csdn.net/Eastmount

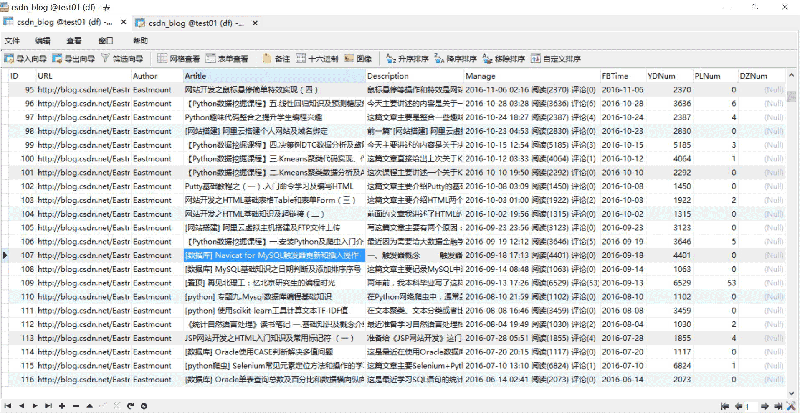

Die Ergebnisse des Crawlens und Speicherns in der MySQL-Datenbank sind wie folgt:

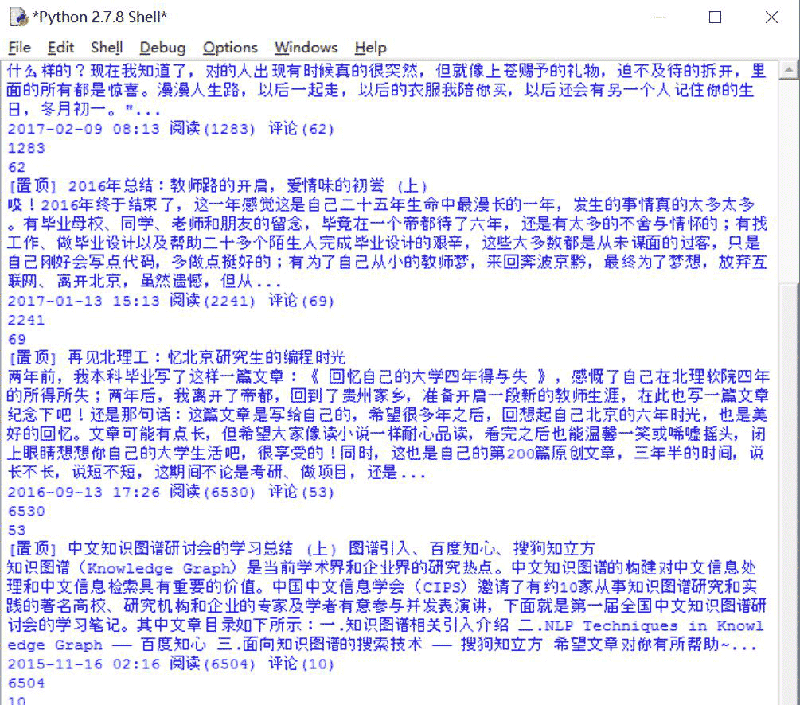

Der laufende Prozess ist wie gezeigt Unten wird angezeigt:

2. Vollständige Codeanalyse

Der vollständige Code lautet wie folgt:

# coding=utf-8

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import selenium.webdriver.support.ui as ui

import re

import time

import os

import codecs

import MySQLdb

#打开Firefox浏览器 设定等待加载时间

driver = webdriver.Firefox()

wait = ui.WebDriverWait(driver,10)

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

texts = driver.find_element_by_xpath("//p[@id='papelist']").text

print '页码', texts

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print '页数:' + str(m[1])

return int(m[1])

#主函数

def main():

#获取txt文件总行数

count = len(open("Blog_URL.txt",'rU').readlines())

print count

n = 0

urlfile = open("Blog_URL.txt",'r')

#循环获取每个博主的文章摘信息

while n < count: #这里爬取2个人博客信息,正常情况count个博主信息

url = urlfile.readline()

url = url.strip("\n")

print url

driver.get(url)

#获取总页码

allPage = getPage()

print u'页码总数为:', allPage

time.sleep(2)

#数据库操作结合

try:

conn=MySQLdb.connect(host='localhost',user='root',

passwd='123456',port=3306, db='test01')

cur=conn.cursor() #数据库游标

#报错:UnicodeEncodeError: 'latin-1' codec can't encode character

conn.set_character_set('utf8')

cur.execute('SET NAMES utf8;')

cur.execute('SET CHARACTER SET utf8;')

cur.execute('SET character_set_connection=utf8;')

#具体内容处理

m = 1 #第1页

while m <= allPage:

ur = url + "/article/list/" + str(m)

print ur

driver.get(ur)

#标题

article_title = driver.find_elements_by_xpath("//p[@class='article_title']")

for title in article_title:

#print url

con = title.text

con = con.strip("\n")

#print con + '\n'

#摘要

article_description = driver.find_elements_by_xpath("//p[@class='article_description']")

for description in article_description:

con = description.text

con = con.strip("\n")

#print con + '\n'

#信息

article_manage = driver.find_elements_by_xpath("//p[@class='article_manage']")

for manage in article_manage:

con = manage.text

con = con.strip("\n")

#print con + '\n'

num = 0

print u'长度', len(article_title)

while num < len(article_title):

#插入数据 8个值

sql = '''insert into csdn_blog

(URL,Author,Artitle,Description,Manage,FBTime,YDNum,PLNum)

values(%s, %s, %s, %s, %s, %s, %s, %s)'''

Artitle = article_title[num].text

Description = article_description[num].text

Manage = article_manage[num].text

print Artitle

print Description

print Manage

#获取作者

Author = url.split('/')[-1]

#获取阅读数和评论数

mode = re.compile(r'\d+\.?\d*')

YDNum = mode.findall(Manage)[-2]

PLNum = mode.findall(Manage)[-1]

print YDNum

print PLNum

#获取发布时间

end = Manage.find(u' 阅读')

FBTime = Manage[:end]

cur.execute(sql, (url, Author, Artitle, Description, Manage,FBTime,YDNum,PLNum))

num = num + 1

else:

print u'数据库插入成功'

m = m + 1

#异常处理

except MySQLdb.Error,e:

print "Mysql Error %d: %s" % (e.args[0], e.args[1])

finally:

cur.close()

conn.commit()

conn.close()

n = n + 1

else:

urlfile.close()

print 'Load Over'

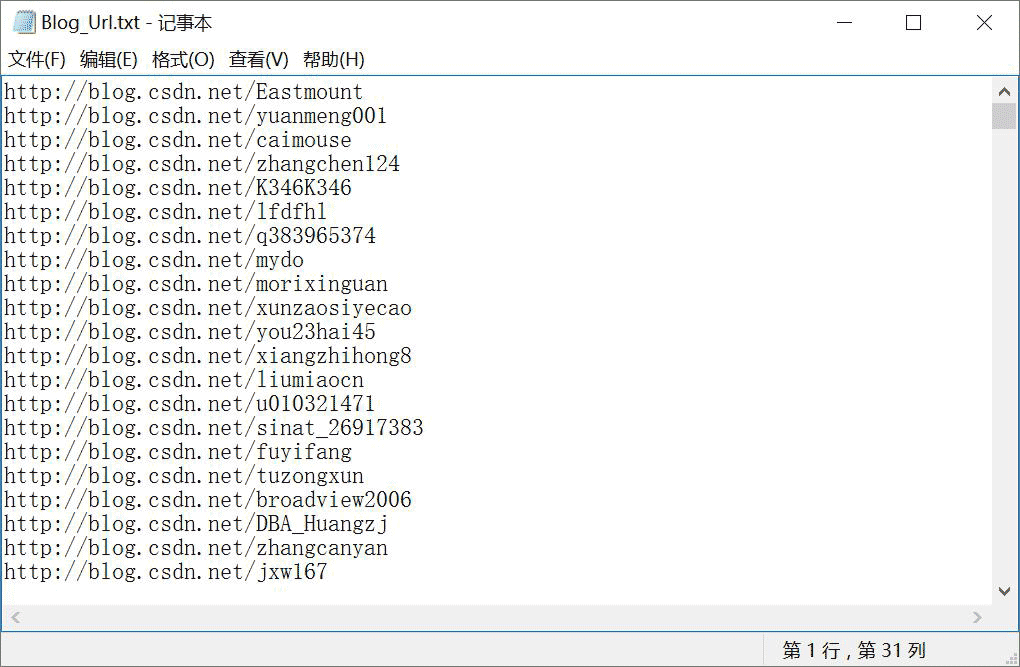

main()Platzieren Sie die Blog-Adress-URL des Benutzers, der gecrawlt werden muss, in der Datei Blog_Url.txt, wie in der Abbildung unten gezeigt. Beachten Sie, dass der Autor hier einen URL-Code zum Crawlen aller CSDN-Experten vorab geschrieben hat, der hier weggelassen wurde, um auf die Ressourcen anderer Personen zuzugreifen und das Lesevolumen zu erhöhen.

Der Analyseprozess ist wie folgt.

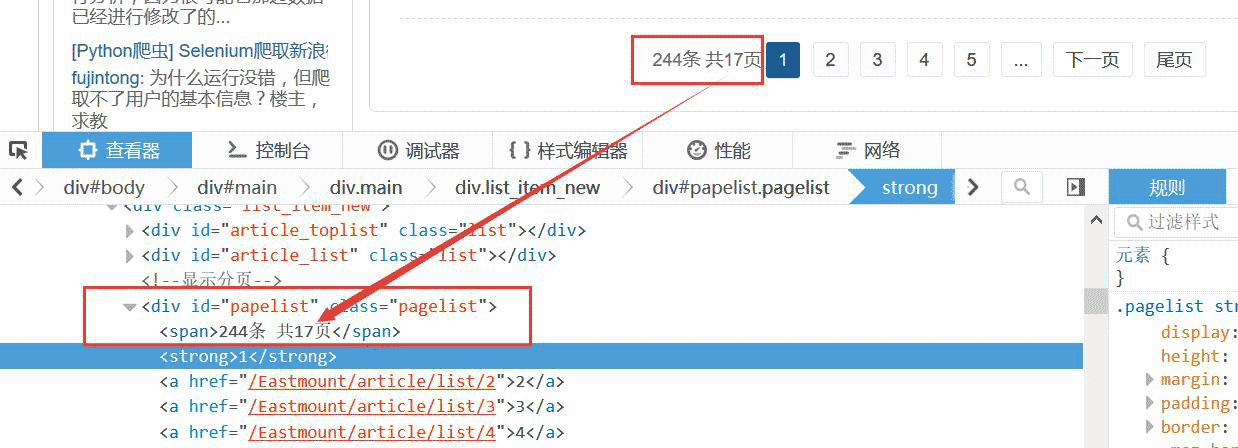

1. Ermitteln Sie die Gesamtseitenzahl des Bloggers.

Lesen Sie zunächst die Adresse des Bloggers aus Blog_Url.txt und rufen Sie dann die Gesamtseitenzahl ab. Der Code lautet wie folgt:

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

texts = driver.find_element_by_xpath("//p[@id='papelist']").text

print '页码', texts

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print '页数:' + str(m[1])

return int(m[1])Um beispielsweise die Gesamtseitenzahl von 17 Seiten zu erhalten, wie unten gezeigt:

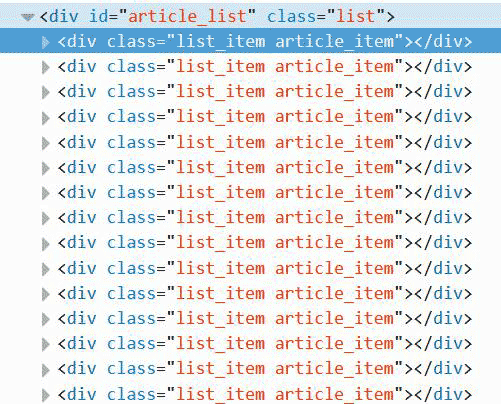

2. DOM-Baumanalyse zum Umblättern

Das Umblättern des Blogs verwendet hier eine URL-Verbindung, was bequemer ist.

Zum Beispiel: http://blog.csdn.net/Eastmount/article/list/2

Sie brauchen also nur: 1. Die Gesamtseitenzahl abrufen; 2. Die Informationen jeder Seite crawlen; Stellen Sie die URL so ein, dass sie Seite 4 durchläuft. Erneut crawlen.

Sie können auch auf „Nächste Seite“ klicken, um zu springen. Wenn es keine „Nächste Seite“ gibt, wird der Sprung gestoppt, der Crawler beendet und dann wird der nächste Blogger gecrawlt.

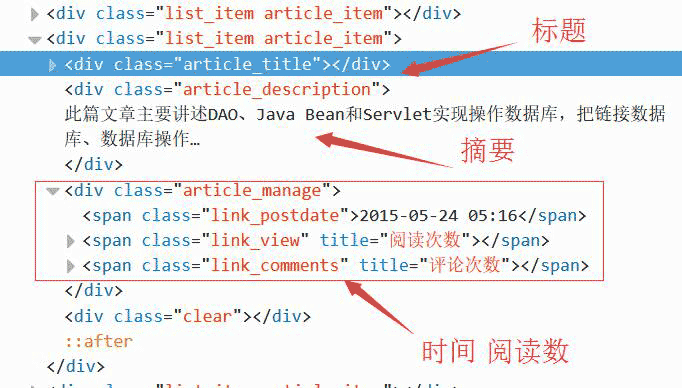

3. Details abrufen: Titel, Zusammenfassung, Zeit

Dann überprüfen Sie die Elemente und analysieren Sie jede Blog-Seite, wenn Sie Beaut verwenden WennulSoup beim Crawlen einen Fehler „Verboten“ meldet.

Es wurde festgestellt, dass jeder Artikel aus einem e388a4556c0f65e1904146cc1a846bee94b3e26ee717c64999d7867364b1b4a3 besteht, wie unten gezeigt, Sie müssen nur die Position lokalisieren.

Sie können nach dem Ort suchen. Hier müssen Sie den Titel, die Zusammenfassung und die Zeit suchen.

代码如下所示。注意,在while中同时获取三个值,它们是对应的。

#标题

article_title = driver.find_elements_by_xpath("//p[@class='article_title']")

for title in article_title:

con = title.text

con = con.strip("\n")

print con + '\n'

#摘要

article_description = driver.find_elements_by_xpath("//p[@class='article_description']")

for description in article_description:

con = description.text

con = con.strip("\n")

print con + '\n'

#信息

article_manage = driver.find_elements_by_xpath("//p[@class='article_manage']")

for manage in article_manage:

con = manage.text

con = con.strip("\n")

print con + '\n'

num = 0

print u'长度', len(article_title)

while num < len(article_title):

Artitle = article_title[num].text

Description = article_description[num].text

Manage = article_manage[num].text

print Artitle, Description, Manage 4.特殊字符串处理

获取URL最后一个/后的博主名称、获取字符串时间、阅读数代码如下:

#获取博主姓名 url = "http://blog.csdn.net/Eastmount" print url.split('/')[-1] #输出: Eastmount #获取数字 name = "2015-09-08 18:06 阅读(909) 评论(0)" print name import re mode = re.compile(r'\d+\.?\d*') print mode.findall(name) #输出: ['2015', '09', '08', '18', '06', '909', '0'] print mode.findall(name)[-2] #输出: 909 #获取时间 end = name.find(r' 阅读') print name[:end] #输出: 2015-09-08 18:06 import time, datetime a = time.strptime(name[:end],'%Y-%m-%d %H:%M') print a #输出: time.struct_time(tm_year=2015, tm_mon=9, tm_mday=8, tm_hour=18, tm_min=6, # tm_sec=0, tm_wday=1, tm_yday=251, tm_isdst=-1)

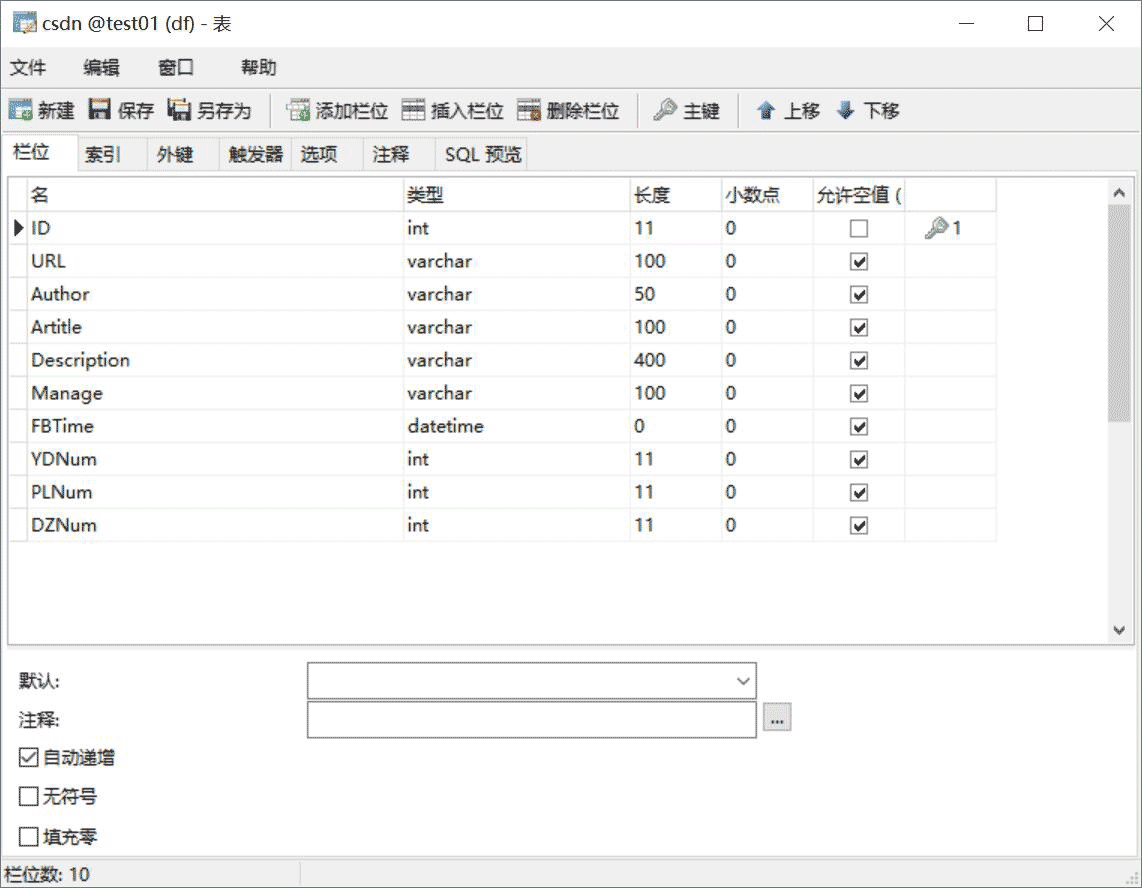

三. 数据库相关操作

SQL语句创建表代码如下:

CREATE TABLE `csdn` ( `ID` int(11) NOT NULL AUTO_INCREMENT, `URL` varchar(100) COLLATE utf8_bin DEFAULT NULL, `Author` varchar(50) COLLATE utf8_bin DEFAULT NULL COMMENT '作者', `Artitle` varchar(100) COLLATE utf8_bin DEFAULT NULL COMMENT '标题', `Description` varchar(400) COLLATE utf8_bin DEFAULT NULL COMMENT '摘要', `Manage` varchar(100) COLLATE utf8_bin DEFAULT NULL COMMENT '信息', `FBTime` datetime DEFAULT NULL COMMENT '发布日期', `YDNum` int(11) DEFAULT NULL COMMENT '阅读数', `PLNum` int(11) DEFAULT NULL COMMENT '评论数', `DZNum` int(11) DEFAULT NULL COMMENT '点赞数', PRIMARY KEY (`ID`) ) ENGINE=InnoDB AUTO_INCREMENT=9371 DEFAULT CHARSET=utf8 COLLATE=utf8_bin;

显示如下图所示:

其中,Python调用MySQL推荐下面这篇文字。

python专题九.Mysql数据库编程基础知识

核心代码如下所示:

# coding:utf-8 import MySQLdb try: conn=MySQLdb.connect(host='localhost',user='root',passwd='123456',port=3306, db='test01') cur=conn.cursor() #插入数据 sql = '''insert into student values(%s, %s, %s)''' cur.execute(sql, ('yxz','111111', '10')) #查看数据 print u'\n插入数据:' cur.execute('select * from student') for data in cur.fetchall(): print '%s %s %s' % data cur.close() conn.commit() conn.close() except MySQLdb.Error,e: print "Mysql Error %d: %s" % (e.args[0], e.args[1])

注意,在下载过程中,有的网站是新版本的,无法获取页码。

比如:http://blog.csdn.net/michaelzhou224

这时需要简单设置,跳过这些链接,并保存到文件中,核心代码如下所示:

#获取每个博主的博客页面低端总页码

def getPage():

print 'getPage'

number = 0

#texts = driver.find_element_by_xpath("//p[@id='papelist']").text

texts = driver.find_element_by_xpath("//p[@class='pagelist']").text

print 'testsss'

print u'页码', texts

if texts=="":

print u'页码为0 网站错误'

return 0

m = re.findall(r'(\w*[0-9]+)\w*',texts) #正则表达式寻找数字

print u'页数:' + str(m[1])

return int(m[1])主函数修改:

error = codecs.open("Blog_Error.txt", 'a', 'utf-8')

#循环获取每个博主的文章摘信息

while n < count: #这里爬取2个人博客信息,正常情况count个博主信息

url = urlfile.readline()

url = url.strip("\n")

print url

driver.get(url+"/article/list/1")

#print driver.page_source

#获取总页码

allPage = getPage()

print u'页码总数为:', allPage

#返回错误,否则程序总截住

if allPage==0:

error.write(url + "\r\n")

print u'错误URL'

continue; #跳过进入下一个博主

time.sleep(2)

#数据库操作结合

try:

.....Das obige ist der detaillierte Inhalt vonBeispieldarstellung der Verwendung von Python Selenium zum Crawlen von Inhalten und Speichern der MySQL-Datenbank. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!