Heim >Backend-Entwicklung >Python-Tutorial >Python implementiert eine einfache Crawler-Funktion

Python implementiert eine einfache Crawler-Funktion

- 高洛峰Original

- 2016-12-13 13:32:561781Durchsuche

Wenn wir jeden Tag im Internet surfen, sehen wir oft einige gut aussehende Bilder und wir möchten diese Bilder speichern und herunterladen oder sie als Desktop-Hintergrundbilder oder als Designmaterialien verwenden.

Unsere häufigste Vorgehensweise besteht darin, mit der rechten Maustaste zu klicken und „Speichern unter“ auszuwählen. Für einige Bilder gibt es jedoch keine Option zum Speichern unter, wenn Sie mit der rechten Maustaste klicken. Eine andere Möglichkeit besteht darin, sie mit einem Screenshot-Tool aufzunehmen, was jedoch die Klarheit des Bildes verringert. Okay~! Tatsächlich sind Sie sehr gut. Klicken Sie mit der rechten Maustaste, um den Quellcode der Seite anzuzeigen.

Wir können Python verwenden, um eine so einfache Crawler-Funktion zu implementieren und den gewünschten Code lokal zu crawlen. Schauen wir uns an, wie man mit Python eine solche Funktion implementiert.

1. Holen Sie sich die gesamten Seitendaten

Zuerst können wir die gesamten Seiteninformationen des Bildes abrufen heruntergeladen.

getjpg.py

#coding=utf-8

import urllib

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

html = getHtml("http://tieba.baidu.com/p/2738151262")

print htmlDas Urllib-Modul bietet eine Schnittstelle zum Lesen von Webseitendaten. Wir können Daten auf www und ftp wie lokale Dateien lesen. Zuerst definieren wir eine getHtml()-Funktion:

Die urllib.urlopen()-Methode wird zum Öffnen einer URL-Adresse verwendet.

Die Methode read() wird verwendet, um die Daten auf der URL zu lesen, eine URL an die Funktion getHtml() zu übergeben und die gesamte Seite herunterzuladen. Beim Ausführen des Programms wird die gesamte Webseite ausgedruckt.

Zweitens filtern Sie die gewünschten Daten auf der Seite

Python bietet sehr leistungsstarke reguläre Ausdrücke, die wir brauchen Ich möchte zunächst ein wenig über reguläre Python-Ausdrücke wissen.

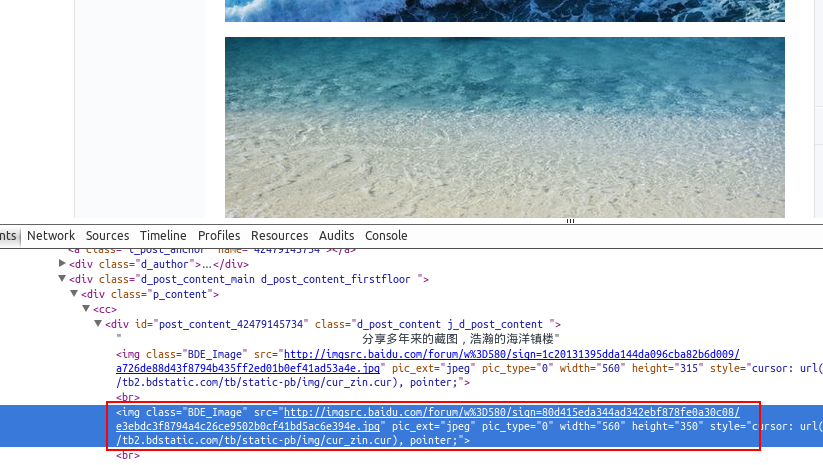

Angenommen, wir finden ein paar schöne Hintergrundbilder in Baidu Tieba und gehen zum vorherigen Abschnitt, um die Tools anzuzeigen. Die Adresse des Bildes wurde gefunden, z. B.: src="http://imgsrc.baidu.com/forum...jpg" pic_ext="jpeg"

Ändern Sie den Code wie folgt:

import re

import urllib

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = re.findall(imgre,html)

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866")

print getImg(html)Wir haben außerdem die Funktion getImg() erstellt, um die erforderlichen Bildlinks auf der gesamten erhaltenen Seite zu filtern. Das re-Modul enthält hauptsächlich reguläre Ausdrücke:

re.compile() kann den regulären Ausdruck in ein reguläres Ausdrucksobjekt kompilieren.

Die re.findall()-Methode liest den in HTML imgre enthaltenen Inhalt. regulärer Ausdruck) Daten.

Durch Ausführen des Skripts wird die URL-Adresse des Bildes abgerufen, das auf der gesamten Seite enthalten ist.

Drittens speichern Sie die seitengefilterten Daten lokal

Durchlaufen Sie die gefilterte Bildadresse durch eine for-Schleife und speichern Sie unter lokal lautet der Code wie folgt:

#coding=utf-8

import urllib

import re

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

return html

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = re.findall(imgre,html)

x = 0

for imgurl in imglist:

urllib.urlretrieve(imgurl,'%s.jpg' % x)

x+=1

html = getHtml("http://tieba.baidu.com/p/2460150866")

print getImg(html)Der Kern hier besteht darin, die Methode urllib.urlretrieve() zu verwenden, um Remote-Daten direkt auf den lokalen herunterzuladen.

Durchlaufen Sie die erhaltene Bildverbindung durch eine for-Schleife. Um den Bilddateinamen standardisierter zu gestalten, benennen Sie ihn um. Die Benennungsregel besteht darin, 1 zur x-Variablen hinzuzufügen. Der Speicherort ist standardmäßig das Speicherverzeichnis des Programms.

Nachdem das Programm ausgeführt wurde, sehen Sie die in das lokale Verzeichnis heruntergeladenen Dateien.