Heim >Web-Frontend >js-Tutorial >Warum kann js Dezimaloperationen nicht korrekt verarbeiten? _Javascript-Kenntnisse

Warum kann js Dezimaloperationen nicht korrekt verarbeiten? _Javascript-Kenntnisse

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOriginal

- 2016-05-16 15:22:591501Durchsuche

var sum = 0;

for(var i = 0; i < 10; i++) {

sum += 0.1;

}

console.log(sum);

Wird das obige Programm 1 ausgeben?

Im Artikel 25 JavaScript-Interviewfragen, die Sie kennen müssen erklärt die 8. Frage kurz, warum js Dezimaloperationen nicht korrekt verarbeiten kann. Heute werde ich ein altes Thema noch einmal aufgreifen und dieses Problem eingehender analysieren.

Aber zunächst ist zu beachten, dass die Unfähigkeit, Dezimaloperationen korrekt zu verarbeiten, kein Designfehler in der JavaScript-Sprache selbst ist. Andere höhere Programmiersprachen wie C, Java usw. sind ebenfalls nicht in der Lage um Dezimaloperationen korrekt zu verarbeiten:

#include <stdio.h>

void main(){

float sum;

int i;

sum = 0;

for(i = 0; i < 100; i++) {

sum += 0.1;

}

printf('%f\n', sum); //10.000002

}

Darstellung von Zahlen im Computer

Wir alle wissen, dass in höheren Programmiersprachen geschriebene Programme durch Interpretation, Kompilierung und andere Vorgänge in Maschinensprache umgewandelt werden müssen, die von der CPU (Central Processing Unit) erkannt werden kann, bevor sie ausgeführt werden können Für die CPU werden die dezimalen und dezimalen Zahlensysteme Oktal und Hexadezimal usw. nicht erkannt. Diese im Programm deklarierten Basiszahlen werden zur Berechnung in Binärzahlen umgewandelt.

Warum nicht zur Berechnung in ternäre Zahlen umwandeln?

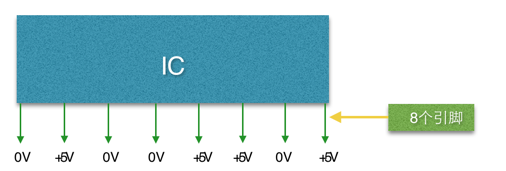

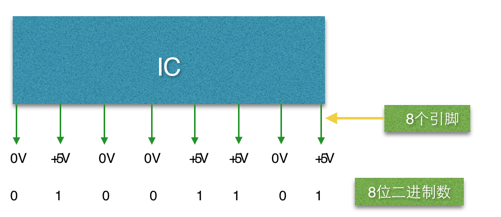

Das Innere eines Computers besteht aus vielen elektronischen Komponenten wie IC (Integrated Circuit: Integrierter Schaltkreis). Es sieht ungefähr so aus:

ICs gibt es in vielen Formen, mit vielen Stiften, die nebeneinander auf beiden Seiten oder im Inneren angeordnet sind (im Bild ist nur eine Seite dargestellt). Alle Pins des IC haben nur zwei Zustände der Gleichspannung 0 V oder 5 V, d. h. ein IC-Pin kann nur zwei Zustände darstellen. Diese Eigenschaft von IC bestimmt, dass die Daten im Computer nur mit Binärzahlen verarbeitet werden können.

Da 1 Bit (ein Pin) nur zwei Zustände darstellen kann, lautet die binäre Berechnungsmethode 0, 1, 10, 11, 100 ... Diese Form:

Bei Zahlenoperationen werden also alle Operanden in Binärzahlen umgewandelt, um an der Operation teilzunehmen, z. B. 39, wird in die Binärzahl 00100111 umgewandelt

Binäre Darstellung von Dezimalzahlen

Wie oben erwähnt, werden die Daten im Programm in Binärzahlen umgewandelt, wenn es sich um Dezimalzahlen handelt. Beispielsweise wird die Dezimalzahl 11,1875 in 1101,0010 umgewandelt.

Der numerische Bereich, der durch 4 Nachkommastellen in Binärzahlen ausgedrückt wird, beträgt 0,0000 bis 0,1111. Daher kann dies nur die Kombination (Addition) der vier Dezimalzahlen 0,5, 0,25, 0,125, 0,0625 und die Bitgewichte danach darstellen der Dezimalpunkt. Dezimal:

Wie aus der obigen Tabelle ersichtlich ist, ist die nächste Ziffer der Dezimalzahl 0,0625. Daher können Dezimalzahlen zwischen 0 und 0,0625 nicht durch Binärzahlen mit 4 Nachkommastellen dargestellt werden; der DezimalpunktDie Anzahl der entsprechenden Dezimalstellen erhöht sich ebenfalls, aber egal wie viele Stellen hinzugefügt werden, das Ergebnis von 0,1 kann nicht erhalten werden. Tatsächlich ist 0,1 in Binär umgewandelt 0,00110011001100110011... Beachten Sie, dass 0011 unendlich wiederholt wird:

console.log(0.2+0.1); //操作数的二进制表示 0.1 => 0.0001 1001 1001 1001…(无限循环) 0.2 => 0.0011 0011 0011 0011…(无限循环)

Der Zahlentyp von js ist nicht wie C/Java in Ganzzahl, einfache Genauigkeit, doppelte Genauigkeit usw. unterteilt, sondern wird einheitlich als Gleitkommatyp mit doppelter Genauigkeit ausgedrückt. Gemäß den IEEE-Vorschriften verwenden Gleitkommazahlen mit einfacher Genauigkeit 32 Bit zur Darstellung aller Dezimalzahlen, während Gleitkommazahlen mit doppelter Genauigkeit 64 Bit zur Darstellung aller Dezimalzahlen verwenden. Gleitkommazahlen bestehen aus Vorzeichen, Mantisse, Exponent und Basis , sodass nicht alle Ziffern verwendet werden, müssen Symbole, Exponenten usw. auch Ziffern belegen, und die Basis belegt keine Ziffern:

Der Dezimalteil einer Gleitkommazahl mit doppelter Genauigkeit unterstützt bis zu 52 Ziffern, sodass Sie nach der Addition der beiden eine Zeichenfolge von 0,0100110011001100110011001100110011001100 erhalten ... eine Binärzahl, die aufgrund der Beschränkung der Dezimalstelle von gekürzt wird Konvertieren Sie die Gleitkommazahl zu diesem Zeitpunkt in eine Dezimalzahl. Das ergibt 0,30000000000000004.

Zusammenfassung

js kann Dezimaloperationen nicht korrekt verarbeiten, einschließlich anderer höherer Programmiersprachen. Dies ist jedoch kein Designfehler der Sprache selbst, aber der Computer selbst kann Dezimaloperationen häufig nicht korrekt verarbeiten Dezimalbrüche können binär dargestellt werden.

Das Obige ist der gesamte Inhalt dieses Artikels. Ich hoffe, er wird für das Studium aller hilfreich sein.

In Verbindung stehende Artikel

Mehr sehen- Eine eingehende Analyse der Bootstrap-Listengruppenkomponente

- Detaillierte Erläuterung des JavaScript-Funktions-Curryings

- Vollständiges Beispiel für die Generierung von JS-Passwörtern und die Erkennung der Stärke (mit Download des Demo-Quellcodes)

- Angularjs integriert WeChat UI (weui)

- Wie man mit JavaScript schnell zwischen traditionellem Chinesisch und vereinfachtem Chinesisch wechselt und wie Websites den Wechsel zwischen vereinfachtem und traditionellem Chinesisch unterstützen – Javascript-Kenntnisse