Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Was ist die KL -Divergenz, die das maschinelle Lernen revolutionierte? - Analytics Vidhya

Was ist die KL -Divergenz, die das maschinelle Lernen revolutionierte? - Analytics VidhyaWas ist die KL -Divergenz, die das maschinelle Lernen revolutionierte? - Analytics Vidhya

Kullback-Leibler (KL) Divergenz: Ein tiefes Eintauchen in die relative Entropie

Nur wenige mathematische Konzepte haben das moderne maschinelle Lernen und die künstliche Intelligenz zutiefst beeinflusst wie Kullback-Leibler (KL) -Divergenz. Diese leistungsstarke Metrik, auch als relativer Entropie- oder Informationsgewinn bezeichnet, ist jetzt in zahlreichen Bereichen von wesentlicher Bedeutung, von statistischer Inferenz bis zum Schneiderei des tiefen Lernens. In diesem Artikel wird KL Divergence, seine Ursprünge, Anwendungen und seine entscheidende Rolle im Alter von Big Data und KI untersucht.

Key Takeaways

- KL -Divergenz quantifiziert die Differenz zwischen zwei Wahrscheinlichkeitsverteilungen.

- Es ist ein Spielveränderer in der maschinellen Lernen und der Informationstheorie, die nur zwei Wahrscheinlichkeitsverteilungen für die Berechnung erfordert.

- Es misst die zusätzlichen Informationen, die zur Codierung von Daten aus einer Verteilung erforderlich sind, indem sie den für eine anderen optimierten Code optimiert haben.

- KL-Divergenz ist von entscheidender Bedeutung für das Training fortschrittlicher Generativmodelle wie Diffusionsmodelle, Optimierung der Rauschverteilung und Verbesserung der Erzeugung von Text zu Image.

- Seine starke theoretische Grundlage, Flexibilität, Skalierbarkeit und Interpretierbarkeit machen es für komplexe Modelle von unschätzbarem Wert.

Inhaltsverzeichnis

- Einführung in die KL -Divergenz

- KL -Divergenz: Wesentliche Komponenten und transformierender Einfluss

- KL-Divergenz verstehen: eine Schritt-für-Schritt-Anleitung

- KL -Divergenz in Diffusionsmodellen: Eine revolutionäre Anwendung

- Vorteile der KL -Divergenz

- Reale Anwendungen der KL-Divergenz

- Häufig gestellte Fragen

Einführung in die KL -Divergenz

KL -Divergenz misst die Unterschiede zwischen zwei Wahrscheinlichkeitsverteilungen. Betrachten Sie zwei Modelle, die dasselbe Ereignis vorhersagen - ihre Unterschiede können mithilfe der KL -Divergenz quantifiziert werden.

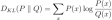

Für diskrete Wahrscheinlichkeitsverteilungen P und Q ist die KL -Divergenz von q nach p :

Diese Formel wird zwar anfänglich komplex, wird aber intuitiv als die durchschnittlichen zusätzlichen Informationen verstanden, die zur comodierenden Daten von P unter Verwendung eines für Q optimierten Codes erforderlich sind.

KL -Divergenz: Wesentliche Komponenten und transformierender Einfluss

Die Berechnung der KL -Divergenz erfordert:

- Zwei Wahrscheinlichkeitsverteilungen, die über denselben Ereignisbereich definiert sind.

- Eine logarithmische Funktion (Basis 2 oder natürlicher Logarithmus).

Mit diesen einfachen Eingaben hat KL Divergence verschiedene Felder revolutioniert:

- Maschinelles Lernen: entscheidend für die variationsberechtigte Inferenz und Generative Modelle (z. B. VAES) und misst, wie gut ein Modell der tatsächlichen Datenverteilung annähert.

- Informationstheorie: Bietet ein grundlegendes Maß für den Informationsgehalt und die Komprimierungseffizienz.

- Statistische Inferenz: Wesentliche bei Hypothesentests und Modellauswahl.

- Verarbeitung natürlicher Sprache: Wird in der Bewertung von Themenmodellierung und Sprachmodell verwendet.

- Verstärkungslernen: Hilft bei Strategien zur Politikoptimierung und Erkundung.

KL-Divergenz verstehen: eine Schritt-für-Schritt-Anleitung

Lassen Sie uns KL -Divergenz analysieren:

- Wahrscheinlichkeitsvergleich: Wir vergleichen die Wahrscheinlichkeit jedes Ereignisses unter Verteilungen P und Q.

- Verhältnisberechnung: Wir berechnen das Verhältnis P (x)/q (x) und zeigen, wie viel mehr (oder weniger) jedes Ereignis unter p im Vergleich zu Q ist.

- Logarithmische Transformation: Der Logarithmus dieses Verhältnisses sorgt dafür, dass die Nicht-Negativität nur dann Null ist, wenn P und Q identisch sind.

- Gewichtung: Wir gewichten das logarithmische Verhältnis von P (x) und betonen Ereignisse wahrscheinlicher unter p .

- Summierung: Schließlich summieren wir die gewichteten logarithmischen Verhältnisse über alle Ereignisse hinweg.

Das Ergebnis ist ein einzelner Wert, der die Differenz zwischen p und q darstellt. Beachten Sie, dass die KL -Divergenz asymmetrisch ist: DKL (p || q) ≠ DKL (q || p). Diese Asymmetrie ist ein Schlüsselmerkmal, das die Richtung des Unterschieds angibt.

KL -Divergenz in Diffusionsmodellen: Eine revolutionäre Anwendung

Diffusionsmodelle wie Dall-E 2 und stabile Diffusion sind ein Hauptbeispiel für die Leistung von KL Divergenz. Sie erzeugen bemerkenswert realistische Bilder aus Textbeschreibungen.

Die Rolle von KL Divergence in Diffusionsmodellen umfasst:

- Training: Misst die Differenz zwischen den wahren und geschätzten Rauschverteilungen bei jedem Schritt, sodass das Modell den Diffusionsprozess effektiv umkehren kann.

- Variationsuntergrenze: häufig im Trainingsobjektiv verwendet, um sicherzustellen, dass generierte Proben der Datenverteilung genau übereinstimmen.

- Latent Space Regularisierung: Hilft bei der Regularisierung des latenten Raums und der Gewährleistung gut erzogener Darstellungen.

- Modellvergleich: Wird zum Vergleich verschiedener Diffusionsmodellarchitekturen verwendet.

- Bedingte Generierung: In Text-zu-Image-Modellen misst es, wie gut generierte Bilder mit Textbeschreibungen übereinstimmen.

Vorteile der KL -Divergenz

Zu den Stärken von KL Divergence gehören:

- Starke theoretische Grundlage: Auf der Grundlage der Informationstheorie, die Interpretierbarkeit in Bezug auf Informationsbits bietet.

- Flexibilität: Anwendung sowohl für diskrete als auch für kontinuierliche Verteilungen.

- Skalierbarkeit: Wirksam in hochdimensionalen Räumen, geeignet für komplexe maschinelle Lernmodelle.

- Mathematische Eigenschaften: Erfüllt Nicht-Negativität und Konvexität, die für die Optimierung von Vorteil ist.

- Interpretierbarkeit: Seine Asymmetrie wird intuitiv in Bezug auf Codierung und Komprimierung verstanden.

Reale Anwendungen der KL-Divergenz

Die Auswirkung von KL Divergence erstreckt sich auf verschiedene Anwendungen:

- Empfehlungssysteme: Wird verwendet, um zu messen, wie gut Modelle Benutzerpräferenzen vorhersagen.

- Bildgenerierung: Wesentlich für die Schulung von KI -Bildungsmodellen.

- Sprachmodelle: spielt eine Rolle beim Training von Chatbots und anderen Sprachmodellen.

- Klimamodellierung: Wird verwendet, um die Zuverlässigkeit von Klimamodellen zu vergleichen und zu bewerten.

- Bewertung des finanziellen Risikos: In Risikomodellen für die Marktvorhersage verwendet.

Abschluss

KL -Divergenz ist ein leistungsstarkes Werkzeug, das über die reine Mathematik hinausgeht und das maschinelle Lernen, Marktvorhersagen und vieles mehr beeinflusst. Seine Bedeutung in unserer datengesteuerten Welt ist unbestreitbar. Im weiteren Verlauf der KI und der Datenanalyse wird die Rolle von KL Divergence nur bedeutender.

Häufig gestellte Fragen

Q1. Wofür steht „KL“? A: Kullback-Leibler, benannt nach Solomon Kullback und Richard Leibler.

Q2. Ist KL -Divergenz eine Distanzmetrik? A: Nein, seine Asymmetrie verhindert, dass es eine echte Entfernungsmetrik ist.

Q3. Kann KL -Divergenz negativ sein? A: Nein, es ist immer nicht negativ.

Q4. Wie wird KL -Divergenz im maschinellen Lernen verwendet? A: Bei Modellauswahl, Variationsinferenz und Bewertung generativer Modelle.

Q5. Was ist der Unterschied zwischen KL-Divergenz und Kreuzentropie? A: Die Minimierung der Kreuzentropie entspricht der Minimierung der KL-Divergenz zuzüglich der Entropie der wahren Verteilung.

Das obige ist der detaillierte Inhalt vonWas ist die KL -Divergenz, die das maschinelle Lernen revolutionierte? - Analytics Vidhya. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

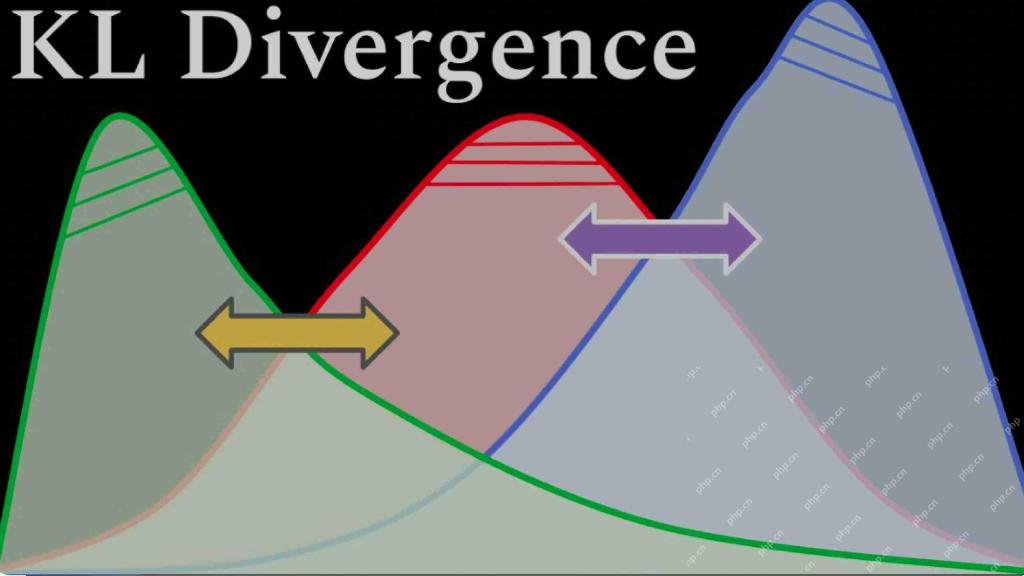

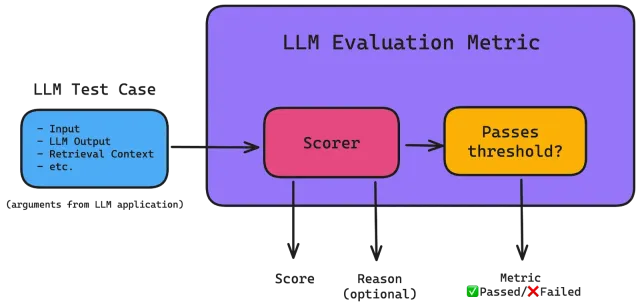

Bewertung der Toxizität in großen SprachmodellenApr 24, 2025 am 10:14 AM

Bewertung der Toxizität in großen SprachmodellenApr 24, 2025 am 10:14 AMIn diesem Artikel wird das entscheidende Problem der Toxizität in Großsprachenmodellen (LLMs) und die Methoden zur Bewertung und Minderung von Methoden untersucht. LLMs, die verschiedene Anwendungen von Chatbots bis hin zur Erzeugung von Inhalten betreiben, erfordert robuste Bewertungsmetriken, Witz

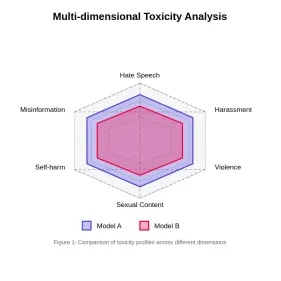

Umfassende Anleitung zum Reranker für LappenApr 24, 2025 am 10:10 AM

Umfassende Anleitung zum Reranker für LappenApr 24, 2025 am 10:10 AMRAG -Systeme (Abrufener Augmented Generation) transformieren den Zugang zum Informationen, ihre Effektivität hängt jedoch von der Qualität der abgerufenen Daten ab. Hier werden die Reranker entscheidend - als Qualitätsfilter für Suchergebnisse, um nur sicherzustellen, dass sie nur sicherstellen

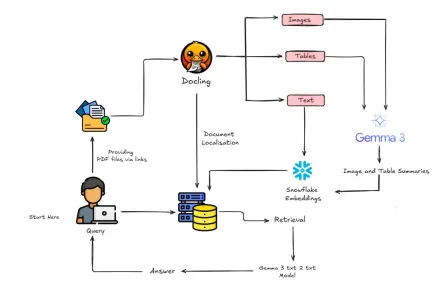

Wie baue ich multimodaler Lappen mit Gemma 3 & Docling?Apr 24, 2025 am 10:04 AM

Wie baue ich multimodaler Lappen mit Gemma 3 & Docling?Apr 24, 2025 am 10:04 AMDieses Tutorial führt Sie durch den Aufbau einer anspruchsvollen multimodalen Abrufpipeline (RAGMent-Generation) in Google Colab. Wir werden modernste Tools wie Gemma 3 (für Sprache und Vision), Docling (Dokumentkonvertierung), Langchain verwenden

Leitfaden zum Ray für skalierbare KI und maschinelles LernenanwendungenApr 24, 2025 am 10:01 AM

Leitfaden zum Ray für skalierbare KI und maschinelles LernenanwendungenApr 24, 2025 am 10:01 AMRay: Ein leistungsstarker Rahmen für die Skalierung von AI- und Python -Anwendungen Ray ist ein revolutionäres Open-Source-Framework, das mühelos AI- und Python-Anwendungen skalieren soll. Die intuitive API ermöglicht es Forschern und Entwicklern, ihren Code für zu wechseln

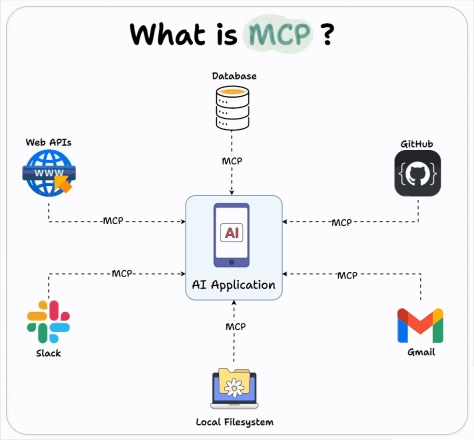

Wie benutze ich die OpenAI MCP -Integration für Bauagenten?Apr 24, 2025 am 09:58 AM

Wie benutze ich die OpenAI MCP -Integration für Bauagenten?Apr 24, 2025 am 09:58 AMOpenAI umfasst die Interoperabilität, indem es das Modellkontextprotokoll (MCP) von Anthropic unterstützt, einer Open-Source-Standard-Simpliking-Assistant-Integration der AI-Assistenten in verschiedene Datensysteme. Diese Zusammenarbeit fördert einen einheitlichen Rahmen für KI -Anwendungen nach EFF

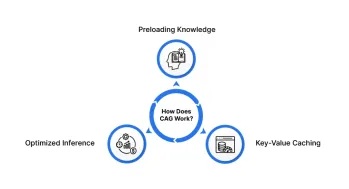

Cache-Augmented-Generation (CAG): Ist es besser als Rag?Apr 24, 2025 am 09:54 AM

Cache-Augmented-Generation (CAG): Ist es besser als Rag?Apr 24, 2025 am 09:54 AMCache-Augmented-Generation (CAG): Eine schnellere, effizientere Alternative zu Lappen Die Abruf Generation (RAG) hat die KI revolutioniert, indem er externes Wissen dynamisch einbezogen hat. Das Vertrauen in externe Quellen führt jedoch eine Latenz und führt zu

Rouge: Dekodierung der Qualität des maschinengenerierten TextesApr 24, 2025 am 09:49 AM

Rouge: Dekodierung der Qualität des maschinengenerierten TextesApr 24, 2025 am 09:49 AMBewertung großer Sprachmodelle: Ein tiefes Eintauchen in Rouge -Metriken Stellen Sie sich eine KI vor, die Gedichte komponieren, juristische Dokumente verfassen oder komplexe Forschung zusammenfasst. Wie bewerten wir ihre Leistung objektiv? Als Großsprachenmodelle (LLMs) Inc.

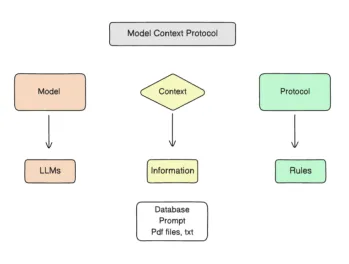

Verwendung von MCP: Modellkontextprotokoll - Analytics VidhyaApr 24, 2025 am 09:48 AM

Verwendung von MCP: Modellkontextprotokoll - Analytics VidhyaApr 24, 2025 am 09:48 AMSchalte die Kraft der realen Daten für deine AI-Assistenten mit dem Modellkontextprotokoll (MCP) frei! Sie haben wahrscheinlich Anwendungen mit LLMs erstellt, mit Wirkstoffen experimentiert und möglicherweise sogar Langchain, Autogen oder OpenAs Assistants API verwendet. Beeindruckend a

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),