Einführung

Stellen Sie sich auf die Suche nach dem perfekten KI -Tool für Ihr nächstes Projekt vor. Mit fortgeschrittenen Modellen wie Lama 3.1 von Meta und OpenAs O1-Präview zur Verfügung, könnte die richtige Wahl entscheidend sein. Dieser Artikel bietet eine vergleichende Analyse dieser beiden führenden Modelle und untersucht ihre einzigartigen Architekturen und Leistung in verschiedenen Aufgaben. Unabhängig davon, ob Sie nach Effizienz im Einsatz oder über eine überlegene Textgenerierung suchen, wird dieser Leitfaden die Erkenntnisse liefern, die Sie benötigen, um das ideale Modell auszuwählen und sein volles Potenzial auszuschöpfen.

Lernergebnisse

- Verstehen Sie die architektonischen Unterschiede zwischen METAs Lama 3.1 und OpenAs O1-Vorsicht.

- Bewerten Sie die Leistung jedes Modells über verschiedene NLP -Aufgaben hinweg.

- Identifizieren Sie die Stärken und Schwächen von Lama 3.1 und O1-Vorsicht für bestimmte Anwendungsfälle.

- Erfahren Sie, wie Sie das beste KI -Modell basierend auf Recheneffizienz und Aufgabenanforderungen auswählen.

- Gewinnen Sie Einblicke in die zukünftigen Entwicklungen und Trends in Modellen für natürliche Sprachverarbeitungsmodelle.

Dieser Artikel wurde als Teil des Data Science -Blogathons veröffentlicht.

Inhaltsverzeichnis

- Einführung in das Lama 3.1 von Meta und das O1-Präview von OpenAI

- Architektonische Unterschiede zwischen METAs Lama 3.1 und OpenAs O1-Vorsicht

- Leistungsvergleich für verschiedene Aufgaben

- Gesamtbewertungen: Eine umfassende Aufgabenbewertung

- Häufig gestellte Fragen

Einführung in das Lama 3.1 von Meta und das O1-Präview von OpenAI

Die schnellen Fortschritte in der künstlichen Intelligenz haben natürliche Sprachverarbeitung (NLP) revolutioniert, was zur Entwicklung hoch entwickelter Sprachmodelle führt, die komplexe Aufgaben ausführen können. Unter den Spitzenreiter in dieser KI-Revolution befinden sich LLAMA 3.1 von Meta und OpenAs O1-Vorwand, zwei modernste Modelle, die die Grenzen dessen überschreiten, was in der Textgenerierung, des Verständnisses und der Aufgabenautomatisierung möglich ist. Diese Modelle repräsentieren die neuesten Bemühungen von Meta und Openai, um die Kraft des Deep-Lernens zu nutzen, um die Industrie zu transformieren und die Interaktion zwischen Menschskomputer zu verbessern.

Während beide Modelle für eine breite Palette von NLP -Aufgaben ausgelegt sind, unterscheiden sie sich in ihrer zugrunde liegenden Architektur, Entwicklungsphilosophie und Zielanwendungen erheblich. Das Verständnis dieser Unterschiede ist der Schlüssel zur Auswahl des richtigen Modells für spezifische Anforderungen, unabhängig davon, ob es sich um hochwertige Inhalte, die Feinabstimmung für spezielle Aufgaben oder effiziente Modelle für begrenzte Hardware ausgeführt hat.

Das LLAMA 3.1 von Meta ist Teil eines wachsenden Trends, effizientere und skalierbare KI -Modelle zu schaffen, die in Umgebungen mit begrenzten Rechenressourcen wie Mobilgeräten und Edge Computing bereitgestellt werden können. Durch die Konzentration auf eine kleinere Modellgröße, ohne die Leistung zu beeinträchtigen, zielt Meta darauf ab, den Zugang zu fortschrittlichen KI -Funktionen zu demokratisieren, was es Entwicklern und Forschern erleichtert, diese Tools in verschiedenen Bereichen zu nutzen.

Im Gegensatz dazu baut OpenAI O1-Präview auf dem Erfolg seiner früheren GPT-Modelle auf, indem Sie Skalierung und Komplexität hervorheben und in Aufgaben überlegene Leistung bieten, die ein tiefes kontextbezogenes Verständnis und eine langfristige Textgenerierung erfordern. Der Ansatz von OpenAI beinhaltet die Schulung seiner Modelle zu enormen Datenmengen, was zu einem leistungsstärkeren, aber ressourcenintensiveren Modell führt, das in Unternehmensanwendungen und Szenarien hervorgeht, die eine hochmoderne Sprachverarbeitung erfordern. In diesem Blog werden wir ihre Leistung über verschiedene Aufgaben hinweg vergleichen.

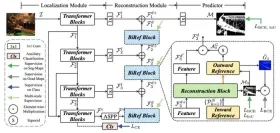

Architektonische Unterschiede zwischen METAs Lama 3.1 und OpenAs O1-Vorsicht

Hier finden Sie einen Vergleich der architektonischen Unterschiede zwischen METAs Lama 3.1 und Openais O1-Präview in einer folgenden Tabelle:

| Aspekt | Metas Lama 3.1 | OpenAI O1-Präview |

|---|---|---|

| Serie | Lama (Großsprachmodell Meta AI) | GPT-4-Serie |

| Fokus | Effizienz und Skalierbarkeit | Maßstab und Tiefe |

| Architektur | Transformatorbasiert, optimiert für kleinere Größe | Transformatorbasiert, wächst mit jeder Iteration an Größe |

| Modellgröße | Kleiner, optimiert für niedrigere Hardware | Größer, verwendet eine enorme Anzahl von Parametern |

| Leistung | Wettbewerbsleistung mit kleinerer Größe | Außergewöhnliche Leistung bei komplexen Aufgaben und detaillierten Ausgaben |

| Einsatz | Geeignet für Edge Computing und mobile Anwendungen | Ideal für Cloud-basierte Dienste und High-End-Unternehmensanwendungen |

| Rechenleistung | Erfordert weniger Rechenleistung | Erfordert eine signifikante Rechenleistung |

| Zielgebrauch | Für Entwickler mit begrenzten Hardware -Ressourcen zugänglich | Entwickelt für Aufgaben, die ein tiefes kontextbezogenes Verständnis benötigen |

Leistungsvergleich für verschiedene Aufgaben

Wir werden nun die Leistung von METAs Lama 3.1 und OpenAs O1-Vorsicht für verschiedene Aufgaben vergleichen.

Aufgabe 1

Sie investieren 5.000 US -Dollar in ein Sparkonto mit einem jährlichen Zinssatz von 3%, der monatlich zusammengesetzt ist. Was ist der Gesamtbetrag des Kontos nach 5 Jahren?

Lama 3.1

OpenAI O1-Präview

Gewinner: OpenAI O1-Präview

Grund: Beide gaben eine korrekte Ausgabe, aber OpenAI O1-Vorwand erzielte aufgrund seiner genauen Berechnung von 5.808,08 USD und der schrittweisen Aufschlüsselung, die der Lösung Klarheit und Tiefe lieferte, besser ab. LAMA 3.1 berechnete auch die richtige Menge, aber OpenAI O1-Previews detaillierte Erklärung und Formatierung ergab einen leichten Vorteil in Bezug auf die Gesamtleistung.

Aufgabe 2

Schreiben Sie den folgenden Satz um, um den grammatikalischen Fehler zu korrigieren: „Weder der Manager noch die Mitarbeiter waren sich der neuen Änderung der Richtlinien bewusst.“

Lama 3.1

OpenAI O1-Präview

Gewinner: OpenAI O1-Präview

Grund: Beide Modelle bestätigten die grammatikalische Korrektheit des ursprünglichen Satzes. anfangs) war genau, aber es fehlte die Tiefe und Klarheit der O1-Präviewexplanation.

Aufgabe 3

Wenn Sie einen Ball aus einer Höhe von 20 Metern fallen lassen und Luftwiderstand ignorieren, wie lange dauert es, bis der Ball den Boden erreicht?

(Verwenden Sie die Formel für freien Fall: t = √ (2H/g), wobei G = 9,8 m/s² (Beschleunigung aufgrund der Schwerkraft)))

Lama 3.1

OpenAI O1-Präview

Gewinner: OpenAI O1-Präview

OpenAI O1-Präview-Ausgabe bietet:

- Clearer schrittweise Berechnung

- Präzise Formatierung

- Präzise Erklärung

- Leichter zu folgen und zu verstehen

OpenAI O1-Preview's Output Excels in der Präsentation des Berechnungsprozesses und erleichtert es den Benutzern, die Lösung zu erfassen.

Aufgabe 4

Sie erhalten K -Eier und ein Gebäude mit N -Böden. Ihre Aufgabe ist es, die minimale Anzahl von Eierentropfen zu bestimmen, die erforderlich sind, um den Boden zu finden, aus dem das Ei bricht.

Lama 3.1

Def Eggdrop (k, n):

dp = [[0]*(n 1) für _ im Bereich (k 1)]

# Basisfälle

für i in Reichweite (1, K 1):

DP [i] [1] = 1

für j in Reichweite (1, N 1):

DP [1] [j] = j

# DP -Tabelle füllen

für i in Reichweite (2, k 1):

für J in Reichweite (2, N 1):

dp [i] [j] = float ('inf')

für x in Reichweite (1, j 1):

res = 1 max (dp [i-1] [x-1], dp [i] [jx])

dp [i] [j] = min (dp [i] [j], res)

Return DP [k] [n]

K = 2 # Eier

N = 100 # Böden

min_drops = Eggdrop (k, n)

print ("Minimale Eiertropfen:", min_drops)

OpenAI O1-Präview

Def Super_egg_drop (k, n):

# DP -Tabelle initialisieren

dp = [0] * (k 1)

M = 0 # Anzahl der Bewegungen

# Während die maximale Anzahl von Böden, die wir überprüfen können

während dp [k] <n: m="1" dp f jedes ei aktualisieren k in reichweite r beispielnutzung: anzahl der eier n="100" b min_drops="super_egg_drop" print tropfen die mit eiern und ben werden:><h4 id="Gewinner-OpenAI-O-Präview">Gewinner: OpenAI O1-Präview</h4>

<p> Hier ist der Grund, warum OpenAI O1-Präview ein Gewinner ist:</p>

<ul>

<li> Effizienz: super_egg_drop verwendet eine einzelne Schleife (o (m)), während die ursprüngliche Lösung verschachtelte Schleifen (O (k*n)) verwendet.</li>

<li> Space -Komplexität: super_egg_drop nutzt o (k) Raum, während die ursprüngliche Lösung O (k*n) verwendet.</li>

<li> Genauigkeit: Beide Lösungen sind korrekt, aber Super_EGG_Drop vermeidet potenzielle Probleme mit dem Überlauf.</li>

</ul>

<p> super_egg_drop ist eine optimiertere und elegantere Lösung.</p>

<h4 id="Warum-ist-es-genauer"> Warum ist es genauer?</h4>

<ul>

<li> Iterativer Ansatz: Vermeidet rekursive Funktionsaufrufe und potenzieller Stapelüberlauf.</li>

<li> Einzelschleife: Reduziert die Rechenkomplexität.</li>

<li> Effiziente Aktualisierung: Aktualisiert DP -Werte in einem einzigen Pass.</li>

</ul>

<h3 id="Aufgabe"> Aufgabe 5</h3>

<p> Erklären Sie, wie der Prozess der Photosynthese in Pflanzen zum Sauerstoffgehalt in der Erdatmosphäre beiträgt.</p>

<p><img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174442875496725.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="LAMA 3.1 gegen O1-Präview: Was ist besser?" ></p>

<p> <b>OpenAI O1-Präview</b></p>

<p><img src="/static/imghwm/default1.png" data-src="https://img.php.cn/upload/article/000/000/000/174442875689168.jpg?x-oss-process=image/resize,p_40" class="lazy" alt="LAMA 3.1 gegen O1-Präview: Was ist besser?" ></p>

<h4 id="Gewinner-OpenAI-O-Präview"> Gewinner: OpenAI O1-Präview</h4>

<p> OpenAI O1-Präview-Ausgabe ist ausgezeichnet:</p>

<ul>

<li> Klare Erklärung der Photosynthese</li>

<li> Präzise Gleichungsdarstellung</li>

<li> Detaillierte Beschreibung der Sauerstofffreisetzung</li>

<li> Betonung der Rolle der Photosynthese in der atmosphärischen Sauerstoffbalance</li>

<li> Engagierende Zusammenfassung</li>

</ul>

<h2 id="Gesamtbewertungen-Eine-umfassende-Aufgabenbewertung"> Gesamtbewertungen: Eine umfassende Aufgabenbewertung</h2>

<p><b></b> Nach einer gründlichen Bewertung erscheint OpenAI O1-Vorwand mit einer ausstehenden Bewertung von 4,8/5, was seine außergewöhnliche Leistung, Präzision und Tiefe bei der Umführung komplexer Aufgaben, mathematischen Berechnungen und wissenschaftlichen Erklärungen widerspiegelt. Seine Überlegenheit zeigt sich über mehrere Bereiche hinweg. Umgekehrt verdient Lama 3.1 eine respektable 4,2/5, die Genauigkeit, Potential und ein solides Fundament zeigt. Es erfordert jedoch eine weitere Verfeinerung von Effizienz, Tiefe und Politur, um die Lücke mit OpenAI O1-Präview-Exzellenz zu überbrücken, insbesondere bei der Behandlung von aufwendigen Aufgaben und der Bereitstellung detaillierter Erklärungen.</p>

<h2 id="Abschluss"> Abschluss</h2>

<p> Der umfassende Vergleich zwischen LLAMA 3.1 und OpenAI O1-Präview zeigt eindeutig die überlegene Leistung von OpenAI über eine Vielzahl von Aufgaben, einschließlich mathematischer Berechnungen, wissenschaftlichen Erklärungen, Textgenerierung und Codegenerierung. Die außergewöhnlichen Fähigkeiten von OpenAI bei der Umführung komplexer Aufgaben, präzise und detaillierte Informationen und der zeigen, dass die bemerkenswerte Lesbarkeit und das Engagement seine Position als Top-Performing-KI-Modell festlegen. Umgekehrt ist Lama 3.1 zwar Genauigkeit und Potenzial, ist zwar in Effizienz, Tiefe und Gesamtpolizei zu knapp. Diese vergleichende Analyse unterstreicht die Bedeutung der hochmodernen KI-Technologie für die Förderung von Innovation und Exzellenz.</p>

<p> Während sich die KI -Landschaft weiterentwickelt, werden sich zukünftige Entwicklungen wahrscheinlich auf die Verbesserung der Genauigkeit, Erklärung und spezialisierten Domänenfunktionen konzentrieren. Die herausragende Leistung von OpenAI O1-Präview setzt einen neuen Benchmark für KI-Modelle und ebnet den Weg für Durchbrüche in verschiedenen Bereichen. Letztendlich bietet dieser Vergleich für Forscher, Entwickler und Benutzer, die nach optimalen KI-Lösungen suchen, wertvolle Einblicke. Indem wir die Macht der überlegenen KI -Technologie nutzen, können wir beispiellose Möglichkeiten freischalten, Industrien transformieren und eine bessere Zukunft formen.</p>

<h4 id="Key-Takeaways"> Key Takeaways</h4>

<ul>

<li> OpenAs O1-Präview übertrifft LLAMA 3.1 in den Umgang mit komplexen Aufgaben, mathematischen Berechnungen und wissenschaftlichen Erklärungen.</li>

<li> LAMA 3.1 zeigt Genauigkeit und Potenzial, es muss Verbesserungen in Bezug auf Effizienz, Tiefe und Gesamtpolitur benötigen.</li>

<li> Effizienz, Lesbarkeit und Engagement sind entscheidend für eine effektive Kommunikation in AI-generierten Inhalten.</li>

<li> KI -Modelle benötigen spezielle Domain -Expertise, um präzise und relevante Informationen bereitzustellen.</li>

<li> Zukünftige KI-Fortschritte sollten sich auf die Verbesserung der Genauigkeit, Erklärung und aufgabenspezifischen Fähigkeiten konzentrieren.</li>

<li> Die Auswahl des KI -Modells sollte auf spezifischen Anwendungsfällen basieren und zwischen Präzision, Genauigkeit und allgemeinen Informationsbereitstellung ausgeglichen werden.</li>

</ul>

<h2 id="Häufig-gestellte-Fragen"> Häufig gestellte Fragen</h2> <strong>Q1. Was ist der Schwerpunkt von Metas Lama 3.1?</strong><p> A. METAs Lama 3.1 konzentriert sich auf Effizienz und Skalierbarkeit und macht es für Edge Computing und mobile Anwendungen zugänglich.</p> <strong>Q2. Wie unterscheidet sich LLAMA 3.1 von anderen Modellen?</strong><p> A. Lama 3.1 ist kleiner und optimiert für die Hardware mit niedrigerer Hardware gleichzeitig die Wettbewerbsleistung.</p> <strong>Q3. Wofür ist OpenAI O1-Präview entwickelt?</strong><p> A. OpenAI O1-Präview ist für Aufgaben ausgelegt, die ein tieferes kontextbezogenes Verständnis erfordern, mit Schwerpunkt auf Skala und Tiefe.</p> <strong>Q4. Welches Modell ist besser für ressourcenbezogene Geräte?</strong><p> A. Lama 3.1 ist besser für Geräte mit begrenzter Hardware wie Mobiltelefone oder Edge Computing -Umgebungen.</p> <strong>Q5. Warum erfordert OpenAI O1-Vorwand mehr Rechenleistung?</strong><p> A. OpenAI O1-Präview verwendet eine größere Anzahl von Parametern, sodass es komplexe Aufgaben und lange Gespräche übernehmen kann, aber es erfordert mehr Rechenressourcen.</p>

<p> <strong>Die in diesem Artikel gezeigten Medien sind nicht im Besitz von Analytics Vidhya und werden nach Ermessen des Autors verwendet.</strong></p></n:>Das obige ist der detaillierte Inhalt vonLAMA 3.1 gegen O1-Präview: Was ist besser?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

RF-Detr: Überbrückungsgeschwindigkeit und Genauigkeit bei der ObjekterkennungApr 24, 2025 am 10:40 AM

RF-Detr: Überbrückungsgeschwindigkeit und Genauigkeit bei der ObjekterkennungApr 24, 2025 am 10:40 AMWillkommene Leser, die CV -Klasse ist wieder in der Sitzung! In meinem vorherigen Blog haben wir bisher 30 verschiedene Computer -Vision -Modelle untersucht, die jeweils ihre eigenen einzigartigen Stärken auf den Tisch bringen

Agent SDK gegen Crewai vs Langchain: Welches zu verwenden, wann?Apr 24, 2025 am 10:39 AM

Agent SDK gegen Crewai vs Langchain: Welches zu verwenden, wann?Apr 24, 2025 am 10:39 AMDieser Artikel vergleicht drei beliebte Rahmenbedingungen zum Aufbau von AI -Agenten: OpenAIs Agent SDK, Langchain und Crewai. Jedes bietet einzigartige Stärken für die Automatisierung von Aufgaben und die Verbesserung der Entscheidungsfindung. Der Artikel führt Sie durch die Auswahl des besten Frams

Aufbau eines strukturierten Forschungsautomationssystems mit PydanticApr 24, 2025 am 10:32 AM

Aufbau eines strukturierten Forschungsautomationssystems mit PydanticApr 24, 2025 am 10:32 AMIm dynamischen Bereich der akademischen Forschung sind effiziente Informationssammeln, Synthese und Präsentation von größter Bedeutung. Der manuelle Prozess der Literaturübersicht ist zeitaufwändig und behindert eine tiefere Analyse. Ein Multi-Agent-Forschungsassistenten-System Bui

10 GPT-4O-Bildgenerierung Aufforderungen, heute auszuprobieren!Apr 24, 2025 am 10:26 AM

10 GPT-4O-Bildgenerierung Aufforderungen, heute auszuprobieren!Apr 24, 2025 am 10:26 AMIn der Welt der KI passiert absolut wildes Zeug. OpenAIs einheimische Bildgenerierung ist momentan verrückt. Wir sprechen über umwerfende Visuals, gruselige Details und Ausgänge, die so poliert sind, dass sie sich von einem Voll-On handgefertigt fühlen

Leitfaden zur Vibe -Codierung mit WindsurfApr 24, 2025 am 10:25 AM

Leitfaden zur Vibe -Codierung mit WindsurfApr 24, 2025 am 10:25 AMMachen Sie Ihre Codierungsvisionen mühelos mit dem Windsurf von Codeium, Ihrem KI-betriebenen Codierungsbegleiter, zum Leben. Windsurf optimiert den gesamten Lebenszyklus der Softwareentwicklung, vom Codieren und Debuggen bis hin zur Optimierung, wobei der Prozess in eine Inu umgewandelt wird

Erforschen der Bildhintergrundentfernung mit RMGB v2.0Apr 24, 2025 am 10:20 AM

Erforschen der Bildhintergrundentfernung mit RMGB v2.0Apr 24, 2025 am 10:20 AMBraiais RMGB V2.0: Ein leistungsstarkes Modell zur Entfernung von Open-Source-Hintergrund Bildsegmentierungsmodelle revolutionieren verschiedene Felder, und die Entfernung des Hintergrunds ist ein Schlüsselbereich des Fortschritts. Braiais RMGB v2.0 sticht als hochmoderne Open-Source-M aus

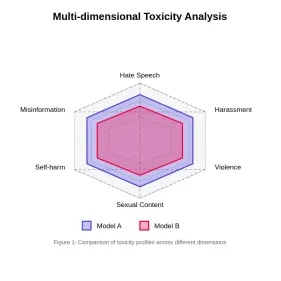

Bewertung der Toxizität in großen SprachmodellenApr 24, 2025 am 10:14 AM

Bewertung der Toxizität in großen SprachmodellenApr 24, 2025 am 10:14 AMIn diesem Artikel wird das entscheidende Problem der Toxizität in Großsprachenmodellen (LLMs) und die Methoden zur Bewertung und Minderung von Methoden untersucht. LLMs, die verschiedene Anwendungen von Chatbots bis hin zur Erzeugung von Inhalten betreiben, erfordert robuste Bewertungsmetriken, Witz

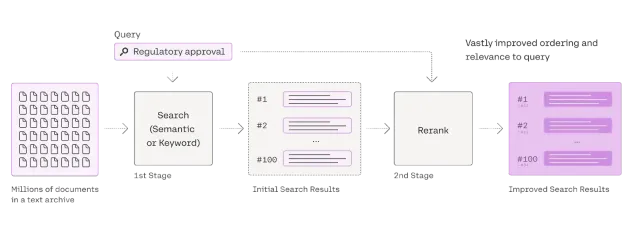

Umfassende Anleitung zum Reranker für LappenApr 24, 2025 am 10:10 AM

Umfassende Anleitung zum Reranker für LappenApr 24, 2025 am 10:10 AMRAG -Systeme (Abrufener Augmented Generation) transformieren den Zugang zum Informationen, ihre Effektivität hängt jedoch von der Qualität der abgerufenen Daten ab. Hier werden die Reranker entscheidend - als Qualitätsfilter für Suchergebnisse, um nur sicherzustellen, dass sie nur sicherstellen

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),