Dieser Artikel untersucht die Funktionen von SLMs (Kleinsprachenmodellen) in der Entitätsextraktion, einer entscheidenden Aufgabe der natürlichen Sprachverarbeitung (NLP). Es vergleicht die Leistung von Gemma 2B, Lama 3.2 (1B- und 3B -Versionen) und QWEN 7B bei der Identifizierung und Klassifizierung von Unternehmen wie Personen, Organisationen und Standorten innerhalb unstrukturierter Text. Der Artikel betont die Vorteile von SLMs gegenüber traditionellen Methoden und zeigt ihr kontextbezogenes Verständnis und ihre Effizienz hervor.

Der Kernvorteil der Verwendung von SLMs für die Entitätsextraktion ist ihre Fähigkeit, den Kontext um die Wörter zu interpretieren, was zu einer genaueren Identifizierung der Entität im Vergleich zu regelbasierten oder älteren Ansätzen für maschinelles Lernen führt. Dieses kontextbezogene Bewusstsein reduziert die durch mehrdeutigen Begriffe verursachten Fehler erheblich.

Der Artikel enthält detaillierte Übersichten jedes SLM:

-

Gemma 2B: Ein Google-entwickeltes Modell mit 2 Milliarden Parametern, 8192 Token-Kontextlänge und einer nur Decoder-Transformatorarchitektur. Die Trainingsdaten umfassen Webdokumente, Code und mathematische Texte.

-

llama 3.2 (1b & 3b): Die mehrsprachigen Modelle von Meta, die Versionen mit 1,23 Milliarden bzw. 3,2 Milliarden Parametern anbieten. Beide haben eine Kontextlänge von 128.000 Token und sind für den mehrsprachigen Dialog optimiert.

-

Qwen 7b: Das Modell von Alibaba Cloud mit 7 Milliarden Parametern und einer 8.192 -Token -Kontextlänge. Es verwendet auch eine Nur-Decoder-Transformatorarchitektur.

Ein strenger Bewertungsrahmen wird beschrieben, der sich auf die Genauigkeit der Entitätsextraktion in verschiedenen Kategorien (Projekt, Unternehmen, Personen) konzentriert. Eine Vergleichstabelle fasst die Leistung jedes Modells zusammen und zeigt Gemma 2B als die genaueste insgesamt, obwohl Lama 3.2 3b Stärke bei der Identifizierung von Menschen zeigt.

Die Schlussfolgerung bekräftigt die überlegene Leistung von SLMs in der Entitätsextraktion und betont die Bedeutung des kontextuellen Verständnisses und der Anpassungsfähigkeit. Der Artikel endet mit einem FAQ

(Hinweis: Bild -URLs bleiben unverändert. Der Kerninhalt des Artikels wurde bei der Erhaltung der ursprünglichen Bedeutung und Struktur umgeschrieben. Die Tabellenübersicht wird ebenfalls aufbewahrt.)

Das obige ist der detaillierte Inhalt vonGemma 2b gegen Lama 3.2 gegen Qwen 7b. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Top 7 AI -Bildgeneratoren im Jahr 2025, um es auszuprobierenApr 23, 2025 am 09:27 AM

Top 7 AI -Bildgeneratoren im Jahr 2025, um es auszuprobierenApr 23, 2025 am 09:27 AMDie KI -Image -Generationstechnologie hat im Jahr 2025 große Fortschritte erzielt, von anfangs verschwommenen abstrakten Bildern bis hin zu den heutigen realistischen Fotos und atemberaubenden Kunstwerken kann sie alles tun. In diesem Artikel werden die leistungsstärksten und kreativsten Bildgenerierungsmodelle auf dem Markt heute untersucht, die sich in Fotorealität, kreativer Vielfalt, moralischer Implementierung und der Anwendung verschiedener In-Progress-Arbeiten gut abschneiden. Digitale Künstler, Vermarkter, Inhaltsersteller und neugierige Menschen, die sich für diese Tools und deren Vorteile interessieren, werden im digitalen Ökosystem auf der Grundlage von Bildern immer wichtiger. Inhaltsverzeichnis Beste AI -Bildgeneratoren von 2025 Midjourney Dall-e 3 (OpenAI) Flux Ai Stabile Diffusion ICH

Was sind Ansichten in SQL?Apr 23, 2025 am 09:26 AM

Was sind Ansichten in SQL?Apr 23, 2025 am 09:26 AMEinführung SQL, die strukturierte Abfragesprache, ist grundlegend für die Verwaltung und Manipulation von relationalen Datenbanken. Eine leistungsstarke SQL -Funktion ist die Verwendung von Ansichten, die komplexe Abfragen optimieren und die Datenbankeffizienz und -verwaltungsfähigkeit steigern. Dieser Ski

Wie können versteckte Trends von Simpson in der Paradox -Paradox -Daten aufdecken? - Analytics VidhyaApr 23, 2025 am 09:20 AM

Wie können versteckte Trends von Simpson in der Paradox -Paradox -Daten aufdecken? - Analytics VidhyaApr 23, 2025 am 09:20 AMSimpsons Paradoxon: Enthüllung versteckter Trends in Daten Wurden Sie jemals von Statistiken irregeführt? Das Paradox von Simpson zeigt, wie aggregierte Daten entscheidende Trends verdecken können und die Bedeutung der Analyse von Daten auf mehreren Ebenen zeigt. Diese prägnante GUI

Was sind nominelle Daten? - Analytics VidhyaApr 23, 2025 am 09:13 AM

Was sind nominelle Daten? - Analytics VidhyaApr 23, 2025 am 09:13 AMEinführung Nominale Daten bilden das Fundament der Datenanalyse und spielen eine entscheidende Rolle in verschiedenen Bereichen wie Statistik, Informatik, Psychologie und Marketing. Dieser Artikel befasst sich mit den Eigenschaften, Anwendungen und Unterscheidungen von NOMI

Was ist One-Shot-Aufforderung? - Analytics VidhyaApr 23, 2025 am 09:12 AM

Was ist One-Shot-Aufforderung? - Analytics VidhyaApr 23, 2025 am 09:12 AMEinführung In der dynamischen Welt des maschinellen Lernens ist es von größter Bedeutung, genaue Antworten mit minimalen Daten effizient zu generieren. One-Shot-Aufforderung bietet eine leistungsstarke Lösung, mit der KI-Modelle bestimmte Aufgaben anhand eines einzigen Beispiels ausführen können

Teslas Robovan war das versteckte Juwel im Robotaxi -Teaser 2024Apr 22, 2025 am 11:48 AM

Teslas Robovan war das versteckte Juwel im Robotaxi -Teaser 2024Apr 22, 2025 am 11:48 AMSeit 2008 habe ich mich für den Shared-Bride-Van eingesetzt, der als "Robotjitney" als "Vansit" als Zukunft des städtischen Transports bezeichnet wurde. Ich sehe diese Fahrzeuge als Transitlösung der nächsten Generation des 21. Jahrhunderts, Surpas, voraus

Sam's Club -Wetten auf KI zur Beseitigung von Quittungsprüfungen und zur Verbesserung des EinzelhandelsApr 22, 2025 am 11:29 AM

Sam's Club -Wetten auf KI zur Beseitigung von Quittungsprüfungen und zur Verbesserung des EinzelhandelsApr 22, 2025 am 11:29 AMRevolutionieren die Erfahrung im Checkout Der innovative "Just Go" -System von Sam's Club baut auf seiner vorhandenen KI-angetriebenen "Scan & Go" -Technologie auf und ermöglicht es den Mitgliedern, während ihres Einkaufsbaus Einkäufe über die Sam's Club-App zu scannen.

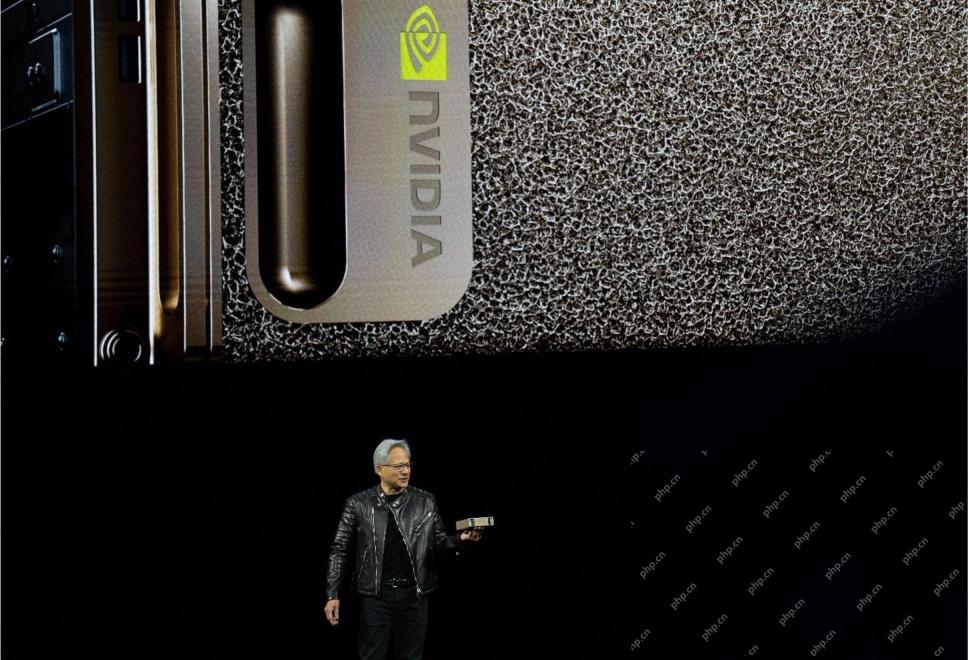

Die AI -Omniverse von Nvidia erweitert sich bei GTC 2025Apr 22, 2025 am 11:28 AM

Die AI -Omniverse von Nvidia erweitert sich bei GTC 2025Apr 22, 2025 am 11:28 AMVerbesserte Vorhersehbarkeit und neue Produktaufstellung von NVIDIA bei GTC 2025 Nvidia, ein wichtiger Akteur in der KI -Infrastruktur, konzentriert sich auf eine erhöhte Vorhersagbarkeit seiner Kunden. Dies beinhaltet eine konsequente Produktlieferung, die Erwartung der Leistungsverwaltung und die Erfüllung der Leistungsverwalter und beinhaltet

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!