Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Umarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI

Umarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AIUmarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI

Nutzen Sie die Kraft des Umarmungsgezwidr -Inferenz (TGI): Ihr lokaler LLM -Server

große Sprachmodelle (LLMs) revolutionieren KI, insbesondere in der Textgenerierung. Dies hat zu einem Anstieg der Tools geführt, mit denen die LLM -Bereitstellung vereinfacht wurde. Die Umarmung von Face's Text Generation Inference (TGI) fällt auf und bietet einen leistungsstarken, produktionsbereiten Rahmen für das lokale Ausführen von LLMs als Service. Dieser Leitfaden untersucht die Funktionen von TGI und zeigt, wie man sie für eine ausgefeilte KI -Textgenerierung nutzt.

Umarmung des Gesichts Tgi

verstehen

TGI, ein Rost- und Python -Framework, ermöglicht die Bereitstellung und das Servieren von LLMs auf Ihrer lokalen Maschine. Im Rahmen von HFoilv1.0 lizenziert es für die kommerzielle Verwendung als ergänzendes Instrument. Die wichtigsten Vorteile sind:

- Hochleistungs-Textgenerierung: TGI optimiert die Leistung mithilfe von Tensor-Parallelität und dynamischer Charge für Modelle wie StarCoder, Bloom, GPT-Neox, Lama und T5.

- Effiziente Ressourcenverbrauch: kontinuierliches Batching und optimierter Code minimieren den Ressourcenverbrauch, während mehrere Anforderungen gleichzeitig bearbeitet werden.

- Flexibilität: Es unterstützt Sicherheitsmerkmale wie Wasserzeichen, Logit -Verziehen gegen Vorspannungssteuerung und Stoppsequenzen.

tgi verfügt über optimierte Architekturen für eine schnellere Ausführung von LLMs wie LLAMA, Falcon7b und Mistral (siehe Dokumentation für die vollständige Liste).

Warum wobei ich das Gesicht tgi entscheiden möchte?

Umarmung ist ein zentraler Hub für Open-Source-LLMs. Bisher waren viele Modelle zu ressourcenintensiv für die lokale Nutzung und erforderten Cloud-Dienste. Fortschritte wie Qlora und GPTQ -Quantisierung haben jedoch einige LLMs auf lokalen Maschinen überschaubar gemacht.

TGI löst das Problem der LLM -Startzeit. Indem es das Modell vorbereitet, bietet es sofortige Antworten und beseitigt lange Wartezeiten. Stellen Sie sich vor, Sie hätten einen Endpunkt, der für eine Reihe von erstklassigen Sprachmodellen leicht zugänglich ist.

Die Einfachheit von

TGI ist bemerkenswert. Es ist für den nahtlosen Einsatz von optimierten Modellarchitekturen und Durchführungen mehrere Live -Projekte ausgelegt, darunter:

- Umarmung Chat

- OpenStIssistant

- nat.dev

Wichtiger Hinweis:

TGI ist derzeit nicht mit ARM-basierten GPU-Macs (M1 und später) inkompatibel.Einrichten des umarmenden Gesichts TGI

Es werden zwei Methoden vorgestellt: von Grund auf neu und mit Docker (für den Einfachheit halber empfohlen).

Methode 1: Von Grund auf (komplexer)

- Rost installieren:

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh - Erstellen Sie eine virtuelle Python -Umgebung:

conda create -n text-generation-inference python=3.9 && conda activate text-generation-inference - Protoc Installieren (Version 21.12 Empfohlen): (erfordert

sudo) Anweisungen, die für die Kürze weggelassen werden, siehe den Originaltext. - klonen Sie das Github -Repository:

git clone https://github.com/huggingface/text-generation-inference.git - TGI installieren:

cd text-generation-inference/ && BUILD_EXTENSIONS=False make install

Methode 2: Verwenden von Docker (empfohlen)

- Stellen Sie sicher, dass Docker installiert und ausgeführt wird.

- (Überprüfen Sie zuerst die Kompatibilität) Führen Sie den Befehl Docker aus (Beispiel mit Falcon-7b):

volume=$PWD/data && sudo docker run --gpus all --shm-size 1g -p 8080:80 -v $volume:/data ghcr.io/huggingface/text-generation-inference:0.9 --model-id tiiuae/falcon-7b-instruct --num-shard 1 --quantize bitsandbytesErsetzen Sie"all"durch"0"Wenn Sie eine einzelne GPU verwenden.

Verwenden von TGI in Anwendungen

Interagieren Sie nach dem Start von TGI mit der Postanforderung in den Endpunkt /generate (oder /stream zum Streaming). Beispiele mit Python und Curl finden Sie im Originaltext. Die text-generation Python -Bibliothek (pip install text-generation) vereinfacht die Interaktion.

Praktische Tipps und weiteres Lernen

- Verstehen Sie die Grundlagen der LLM: Machen Sie sich mit Tokenisierung, Aufmerksamkeitsmechanismen und der Transformer -Architektur vertraut.

- Modelloptimierung: Erfahren Sie, wie Sie Modelle vorbereiten und optimieren, einschließlich der Auswahl des richtigen Modells, der Anpassung von Tokenizern und Feinabstimmung.

- Generationsstrategien: Erforschen Sie verschiedene Strategien zur Erzeugung von Text (Gierige Suche, Strahlsuche, Top-K-Stichprobene).

Schlussfolgerung

Umarmung Face TGI bietet eine benutzerfreundliche Möglichkeit zum Bereitstellen und Host-LLMs lokal und bietet Vorteile wie Datenschutz und Kostenkontrolle. Die jüngsten Fortschritte machen es für viele Benutzer möglich. Weitere Untersuchungen fortschrittlicher LLM -Konzepte und -Ressourcen (im Originaltext genannt) wird für das fortgesetzte Lernen sehr empfohlen.

Das obige ist der detaillierte Inhalt vonUmarme Face's Text Generation Inference Toolkit für LLMs - Ein Game Changer in AI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

7 Leistungsstarke KI fordert jeder Projektmanager auf, jetzt zu meisternMay 08, 2025 am 11:39 AM

7 Leistungsstarke KI fordert jeder Projektmanager auf, jetzt zu meisternMay 08, 2025 am 11:39 AMGenerative KI, beispielhaft von Chatbots wie ChatGPT, bietet Projektmanagern leistungsstarke Tools, um Workflows zu optimieren und sicherzustellen, dass Projekte im Zeitplan und im Budget bleiben. Ein effektiver Gebrauch ist jedoch das Erstellen der richtigen Eingabeaufforderungen an. Präzise, Detail

Definieren der schlecht definierten Bedeutung von schwer fassbarem AGI über die hilfreiche Unterstützung der KI selbstMay 08, 2025 am 11:37 AM

Definieren der schlecht definierten Bedeutung von schwer fassbarem AGI über die hilfreiche Unterstützung der KI selbstMay 08, 2025 am 11:37 AMDie Herausforderung, künstliche allgemeine Intelligenz (AGI) zu definieren, ist von Bedeutung. Ansprüche des AGI-Fortschritts fehlen häufig einen klaren Benchmark, wobei Definitionen auf die festgelegten Forschungsrichtungen zugeschnitten sind. Dieser Artikel untersucht einen neuartigen Ansatz für definitiv

IBM Think 2025 präsentiert Watsonx.Datas Rolle in der generativen KIMay 08, 2025 am 11:32 AM

IBM Think 2025 präsentiert Watsonx.Datas Rolle in der generativen KIMay 08, 2025 am 11:32 AMIBM Watsonx.data: Straffung des AI -Datenstapels Enterprise IBM positioniert Watsonx.data als eine entscheidende Plattform für Unternehmen, die darauf abzielen, die Bereitstellung präziser und skalierbarer generativer KI -Lösungen zu beschleunigen. Dies wird erreicht, indem die Beschwerde vereinfacht wird

Der Aufstieg der humanoiden Robotermaschinen nähert sich.May 08, 2025 am 11:29 AM

Der Aufstieg der humanoiden Robotermaschinen nähert sich.May 08, 2025 am 11:29 AMDie schnellen Fortschritte in der Robotik, die durch Durchbrüche in KI und Materialwissenschaft angetrieben werden, sind bereit, eine neue Ära humanoischer Roboter einzuleiten. Seit Jahren steht die industrielle Automatisierung im Hauptaugenmerk, aber die Fähigkeiten von Robotern sind schnell exponiert

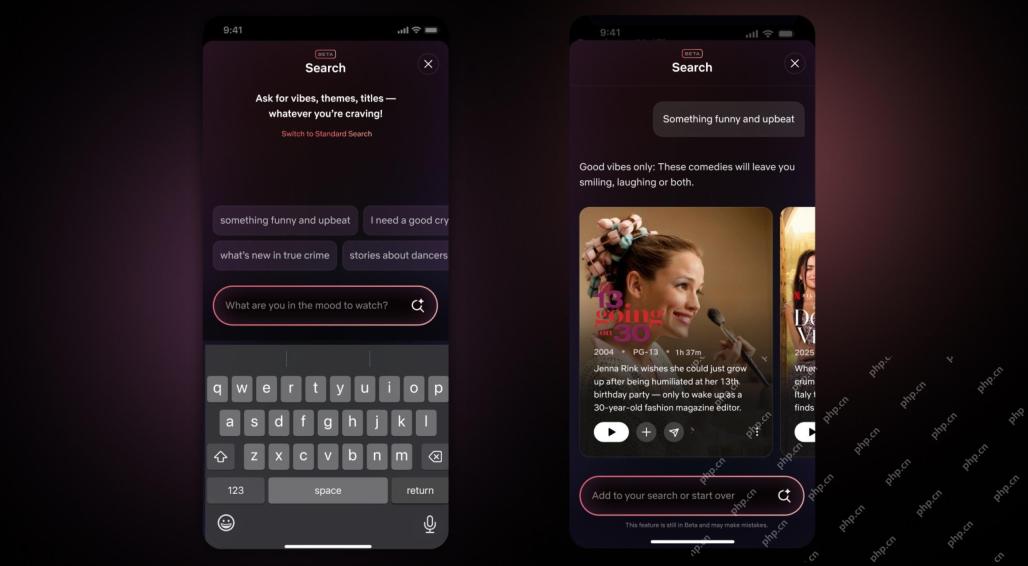

Netflix Revamps Interface-Debüt von KI-Suchwerkzeugen und Tiktok-ähnliches DesignMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debüt von KI-Suchwerkzeugen und Tiktok-ähnliches DesignMay 08, 2025 am 11:25 AMDas größte Update der Netflix -Schnittstelle in einem Jahrzehnt: intelligentere, personalisierter, umarme Inhalte Netflix kündigte in einem Jahrzehnt seine größte Überarbeitung seiner Benutzeroberfläche an, nicht nur ein neues Erscheinungsbild, sondern fügt auch weitere Informationen zu jeder Show hinzu und führt intelligenteren KI -Suchwerkzeugen ein, die vage Konzepte wie "Umgebungsstoffe" und flexiblere Strukturen des Unternehmens verstehen können, um das Interesse des Unternehmens an aufstrebenden Videospielen, Live -Ereignissen, Sportveranstaltungen und anderen neuen Arten von Inhalten besser zu demonstrieren. Um mit dem Trend Schritt zu halten, erleichtert die neue vertikale Videokomponente auf Mobile den Fans, durch Trailer und Clips zu scrollen, die vollständige Show zu sehen oder Inhalte mit anderen zu teilen. Dies erinnert Sie an die unendliche Scrolling und die sehr erfolgreiche kurze Video -Website Ti

Lange vor AGI: Drei KI -Meilensteine, die Sie herausfordern werdenMay 08, 2025 am 11:24 AM

Lange vor AGI: Drei KI -Meilensteine, die Sie herausfordern werdenMay 08, 2025 am 11:24 AMDie wachsende Diskussion der allgemeinen Intelligenz (AGI) in künstlicher Intelligenz hat viele dazu veranlasst, darüber nachzudenken, was passiert, wenn künstliche Intelligenz die menschliche Intelligenz übertrifft. Ob dieser Moment in der Nähe oder weit entfernt ist, hängt davon ab, wen Sie fragen, aber ich denke nicht, dass es der wichtigste Meilenstein ist, auf den wir uns konzentrieren sollten. Welche früheren KI -Meilensteine betreffen alle? Welche Meilensteine wurden erreicht? Hier sind drei Dinge, von denen ich denke, dass sie passiert sind. Künstliche Intelligenz übertrifft die menschlichen Schwächen Im Film "Social Dilemma" 2022 wies Tristan Harris vom Zentrum für humane Technologie darauf hin, dass künstliche Intelligenz die menschlichen Schwächen übertroffen hat. Was bedeutet das? Dies bedeutet, dass künstliche Intelligenz Menschen benutzen konnte

Venkat Achanta über die Plattformtransformation von Transunion und KI -EhrgeizMay 08, 2025 am 11:23 AM

Venkat Achanta über die Plattformtransformation von Transunion und KI -EhrgeizMay 08, 2025 am 11:23 AMDie CTO von Transunion, Ranganath Achanta, führte eine bedeutende technologische Transformation an, seit er sich nach seinem Akquisition von Neustar Ende 2021 dem Unternehmen angeschlossen hat. Seine Führung von über 7.000 Mitarbeitern in verschiedenen Abteilungen hat sich auf u konzentriert

Wenn das Vertrauen in KI springt, folgt die ProduktivitätMay 08, 2025 am 11:11 AM

Wenn das Vertrauen in KI springt, folgt die ProduktivitätMay 08, 2025 am 11:11 AMDer Aufbau von Vertrauen ist für eine erfolgreiche KI -Einführung im Geschäft von größter Bedeutung. Dies gilt insbesondere angesichts des menschlichen Elements innerhalb von Geschäftsprozessen. Mitarbeiter, wie alle anderen, haben Bedenken hinsichtlich der KI und ihrer Umsetzung. Deloitte -Forscher sind SC

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

ZendStudio 13.5.1 Mac

Leistungsstarke integrierte PHP-Entwicklungsumgebung

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version