selbst reflektierende relieval-ägmentierte Generation (Selbstschnellung): Verbesserung von LLMs mit adaptivem Abruf und Selbstkritik

große Sprachmodelle (LLMs) sind transformativ, aber ihre Abhängigkeit von parametrischem Wissen führt häufig zu sachlichen Ungenauigkeiten. Abruf (RAGMent-Augmented Generation) zielt darauf ab, dies durch Einbeziehung externer Kenntnisse zu beheben, aber traditionelle Lag-Methoden leiden unter Einschränkungen. In diesem Artikel wird die Selbstabschnitte untersucht, einen neuartigen Ansatz, der die Qualität und Tatsache die LLM-Qualität und die Fakten erheblich verbessert.

adressieren die Mängel von Standard -Lappen

Standard Rag holt unabhängig von der Relevanz eine feste Anzahl von Passagen ab. Dies führt zu mehreren Problemen:

- irrelevante Informationen: Abrufen unnötiger Dokumente verdünnt die Ausgangsqualität.

- Mangel an Anpassungsfähigkeit: Unfähigkeit, das Abrufen anhand von Aufgabenanforderungen anpassen zu können, führt zu einer inkonsistenten Leistung.

- Inkonsistente Ausgänge: generierter Text stimmt aufgrund eines expliziten Schulungsausbildungsausschusses möglicherweise nicht mit abgerufenen Informationen überein.

- . Abwesenheit einer Selbstbewertung:

- Kein Mechanismus zur Bewertung der Qualität oder Relevanz von abgerufenen Passagen oder der erzeugten Ausgabe. Begrenzte Quellenbeschreibung:

Einführung selbstschnell: adaptives Abruf und Selbstreflexion

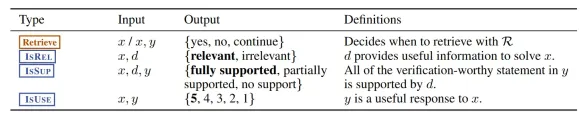

Selbstrag verbessert LLMs durch Integration von adaptivem Abruf und Selbstreflexion. Im Gegensatz zu Standard Rag wird die Passagen dynamisch nur bei Bedarf dynamisch abgerufen, wobei ein "Token abrufen". Entscheidend ist, dass es spezielle Reflexions -Token verwendet - Isrel (Relevanz), ISSUP (Support) und Isuse (Dienstprogramm) -, um seinen eigenen Erzeugungsprozess zu bewerten.

- Schlüsselmerkmale der Selbstschnellung gehören:

- On-Demand-Abruf:

- Effizientes Abrufen nur bei Bedarf. Reflexionstoken:

- Selbstbewertung mit ISREL-, ISSUP- und ISUSUSE-Token. Selbstkritärte:

- Bewertung der Relevanz und Ausgangsqualität der abgerufenen Passage. End-to-End-Training:

- gleichzeitiges Training der Ausgabegenerierung und Reflexionstoken Vorhersage. anpassbare Decodierung:

Der Selbst-Rag-Workflow

- Eingabebereich und Abrufentscheidung: Das Modell bestimmt, ob externes Wissen erforderlich ist.

- Abrufen relevanter Passagen: Bei Bedarf werden relevante Passagen unter Verwendung eines Retriever-Modells (z. B. Contriever-MS Marco) abgerufen.

- Parallele Verarbeitung und Segmentgenerierung: Der Generatormodell verarbeitet jede abgerufene Passage, wodurch mehrere Fortsetzungskandidaten mit zugehörigen Kritik -Token erzeugt werden.

- Selbstkritärung und Bewertung: Reflexionstoken bewerten die Relevanz (ISREL), Unterstützung (ISSUP) und Nützlichkeit (ISUS) jedes generierten Segments.

- Auswahl des besten Segments und Ausgangs: Eine Strahlsuche auf Segmentebene wählt die beste Ausgangssequenz basierend auf einer gewichteten Punktzahl aus, die Kritik-Token-Wahrscheinlichkeiten enthält.

- Trainingsprozess: Ein zweistufiger Schulungsprozess beinhaltet das Training eines Kritikermodells offline, um Reflexions-Token zu generieren, gefolgt von der Schulung des Generatormodells unter Verwendung von Daten, die mit diesen Token erweitert wurden.

Vorteile der Selbstschnellung

Selbstweite bietet mehrere wichtige Vorteile:

- Verbesserte sachliche Genauigkeit: On-Demand-Abruf und Selbstkritik führen zu einer höheren sachlichen Genauigkeit.

- Verbesserte Relevanz: adaptives Abrufen stellt sicher, dass nur relevante Informationen verwendet werden.

- Besseres Zitat und Überprüfbarkeit: detaillierte Zitate und Bewertungen verbessern Transparenz und Vertrauenswürdigkeit.

- Anpassbares Verhalten: Reflexionstoken ermöglichen aufgabenspezifische Anpassungen.

- Effiziente Inferenz: Offline -Kritiker -Modelltraining reduziert den Inferenzaufwand.

Implementierung mit Langchain und Langgraph

Der Artikel beschreibt eine praktische Implementierung mit Langchain und Langgraph, die Abhängigkeitsaufbau, Datenmodelldefinition, Dokumentenverarbeitung, Evaluator -Konfiguration, Rag -Ketten -Setup, Workflow -Funktionen, Workflow -Konstruktion und Tests abdeckt. Der Code zeigt, wie ein Selbstabschnittsystem erstellt wird, das verschiedene Abfragen bearbeiten und die Relevanz und Genauigkeit seiner Antworten bewertet.

Einschränkungen der Selbstschnellung

Trotz ihrer Vorteile hat die Selbstschnellung Einschränkungen:- Nicht vollständig unterstützte Ausgänge: Ausgänge werden möglicherweise nicht immer vollständig durch die zitierten Beweise unterstützt.

- Potenzial für Faktenfehler: Während verbessert, können noch faktuelle Fehler auftreten.

- Modellgröße Kompromisse: kleinere Modelle können manchmal größere in sachlich präzise übertreffen.

- Anpassungsabfälle: Reflexionstypengewichte können andere Aspekte des Ausgangs beeinflussen (z. B. Fluenz).

Schlussfolgerung

Selbstkanal stellt einen erheblichen Fortschritt in der LLM-Technologie dar. Durch die Kombination von adaptivem Abruf mit Selbstreflexion befasst es sich mit den wichtigsten Einschränkungen des Standardlags, was zu genaueren, relevanteren und überprüfbaren Ausgängen führt. Die anpassbare Natur des Frameworks ermöglicht es, ihr Verhalten auf verschiedene Anwendungen anzupassen, was es zu einem leistungsstarken Werkzeug für verschiedene Aufgaben macht, die eine hohe sachliche Genauigkeit erfordern. Die bereitgestellte Implementierung von Langchain und Langgraph bietet einen praktischen Leitfaden zum Aufbau und Bereitstellen von Selbstschnellsystemen.

häufig gestellte Fragen (FAQs) (Der FAQS -Abschnitt aus dem Originaltext wird hier aufbewahrt.)

Q1. Was ist Selbstschnellung?

Q2. Wie unterscheidet sich die Selbstschnellung von Standardlagen?Q3. Was sind Reflexionstoken?

Q4. Was sind die Hauptvorteile der Selbstabschnitte?Q5. Kann Selbstabbau sachliche Ungenauigkeiten vollständig beseitigen?

(Hinweis: Das Bild bleibt in seinem ursprünglichen Format und Ort.)

Das obige ist der detaillierte Inhalt vonSelbstschnellung: KI, die weiß, wann man es untersucht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Sie müssen KI am Arbeitsplatz hinter einem Schleier der Unwissenheit bauenApr 29, 2025 am 11:15 AM

Sie müssen KI am Arbeitsplatz hinter einem Schleier der Unwissenheit bauenApr 29, 2025 am 11:15 AMIn John Rawls 'wegweisendem Buch von 1971 schlug er ein Gedankenexperiment vor, das wir als Kern des heutigen KI-Designs und der Entscheidungsfindung verwenden sollten: den Schleier der Unwissenheit. Diese Philosophie bietet ein einfaches Instrument zum Verständnis von Eigenkapital und bietet auch eine Entwurf für Führungskräfte, um dieses Verständnis zu nutzen, um KI auf gerechte Weise zu entwerfen und umzusetzen. Stellen Sie sich vor, Sie treffen Regeln für eine neue Gesellschaft. Aber es gibt eine Prämisse: Sie wissen nicht im Voraus, welche Rolle Sie in dieser Gesellschaft spielen werden. Möglicherweise sind Sie reich oder arm, gesund oder behindert, gehören einer Mehrheit oder einer marginalen Minderheit. Der Betrieb unter diesem "Schleier der Unwissenheit" verhindert, dass Regelmacher Entscheidungen treffen, die selbst zugute kommen. Im Gegenteil, die Menschen werden motivierter sein, die Öffentlichkeit zu formulieren

Entscheidungen, Entscheidungen… nächste Schritte für die praktische angewandte KIApr 29, 2025 am 11:14 AM

Entscheidungen, Entscheidungen… nächste Schritte für die praktische angewandte KIApr 29, 2025 am 11:14 AMZahlreiche Unternehmen sind auf Roboterprozessautomatisierung (RPA) spezialisiert und bieten Bots, um sich wiederholende Aufgaben zu automatisieren - Uipath, Automatisierung überall, blaues Prisma und andere. In der Zwischenzeit verarbeiten Sie Mining, Orchestrierung und intelligente Dokumentenverarbeitung Speciali

Die Agenten kommen - mehr darüber, was wir neben AI -Partnern tun werdenApr 29, 2025 am 11:13 AM

Die Agenten kommen - mehr darüber, was wir neben AI -Partnern tun werdenApr 29, 2025 am 11:13 AMDie Zukunft der KI bewegt sich über die einfache Wortvorhersage und die Konversationsimulation hinaus. KI -Agenten sind aufgetaucht, in der Lage, unabhängige Handlungen und Aufgabenabschluss zu erledigen. Diese Verschiebung zeigt sich bereits in Tools wie dem Claude von Anthropic. KI -Agenten: Forschung a

Warum Empathie wichtiger ist als die Kontrolle für Führungskräfte in einer KI-gesteuerten ZukunftApr 29, 2025 am 11:12 AM

Warum Empathie wichtiger ist als die Kontrolle für Führungskräfte in einer KI-gesteuerten ZukunftApr 29, 2025 am 11:12 AMSchnelle technologische Fortschritte erfordern eine zukunftsweisende Perspektive auf die Zukunft der Arbeit. Was passiert, wenn die KI nur die Produktivitätsverstärkung überschreitet und unsere gesellschaftlichen Strukturen prägt? Topher McDougals bevorstehendes Buch Gaia Wakes:

KI für die Produktklassifizierung: Können Maschinen das Steuergesetz meistern?Apr 29, 2025 am 11:11 AM

KI für die Produktklassifizierung: Können Maschinen das Steuergesetz meistern?Apr 29, 2025 am 11:11 AMDie Produktklassifizierung, die häufig komplexe Codes wie "HS 8471.30" aus Systemen wie dem harmonisierten System (HS) umfasst, ist für den internationalen Handel und den Inlandsumsatz von entscheidender Bedeutung. Diese Codes gewährleisten den korrekten Steuerantrag und wirken sich auf jeden Inv aus

Könnte die Nachfrage des Rechenzentrums einen Klima -Tech -Rebound auslösen?Apr 29, 2025 am 11:10 AM

Könnte die Nachfrage des Rechenzentrums einen Klima -Tech -Rebound auslösen?Apr 29, 2025 am 11:10 AMDie Zukunft des Energieverbrauchs in Rechenzentren und Klimaschutzinvestitionen In diesem Artikel wird der Anstieg des Energieverbrauchs in Rechenzentren untersucht, die von KI und ihren Auswirkungen auf den Klimawandel angetrieben werden, und analysiert innovative Lösungen und politische Empfehlungen, um diese Herausforderung zu befriedigen. Herausforderungen des Energiebedarfs: Zentren im großen und ultra-großen Maßstab verbrauchen enorme Macht, vergleichbar mit der Summe von Hunderttausenden gewöhnlicher nordamerikanischer Familien und aufstrebende AI-Zentren im Bereich Ultra-Large-Scale-Zentren verbrauchen Dutzende von Zeiten mehr mehr Macht als diese. In den ersten acht Monaten des 2024 haben Microsoft, Meta, Google und Amazon rund 125 Milliarden US -Dollar in den Bau und den Betrieb von AI -Rechenzentren investiert (JP Morgan, 2024) (Tabelle 1). Der wachsende Energiebedarf ist sowohl eine Herausforderung als auch eine Chance. Laut Kanarischen Medien der drohende Elektrizität

AI und Hollywoods nächstes goldenes ZeitalterApr 29, 2025 am 11:09 AM

AI und Hollywoods nächstes goldenes ZeitalterApr 29, 2025 am 11:09 AMGenerative AI revolutioniert die Film- und Fernsehproduktion. Das Ray 2-Modell von Luma sowie das Gen-4 von Runway, Openai von Sora, Google's VEO und andere neue Modelle verbessern die Qualität der generierten Videos mit beispielloser Geschwindigkeit. Diese Modelle können problemlos komplexe Spezialeffekte und realistische Szenen erzeugen, selbst kurze Videoclips und Kameraser-Bewegungseffekte wurden erreicht. Während die Manipulation und Konsistenz dieser Tools noch verbessert werden müssen, ist die Geschwindigkeit des Fortschritts erstaunlich. Generatives Video wird zu einem unabhängigen Medium. Einige Modelle sind gut in der Animationsproduktion, andere sind gut in Live-Action-Bildern. Es ist erwähnenswert, dass Adobe's Firefly und Moonvalleys MA

Wird Chatgpt langsam AIs größtes Ja-Mann?Apr 29, 2025 am 11:08 AM

Wird Chatgpt langsam AIs größtes Ja-Mann?Apr 29, 2025 am 11:08 AMChatGPT -Benutzererfahrung lehnt ab: Ist es ein Modellverschlechterungs- oder Benutzererwartungen? In jüngster Zeit haben sich eine große Anzahl von ChatGPT bezahlten Nutzern über ihre Leistungsverschlechterung beschwert, die weit verbreitete Aufmerksamkeit erregt hat. Die Benutzer berichteten über langsamere Antworten auf Modelle, kürzere Antworten, mangelnde Hilfe und noch mehr Halluzinationen. Einige Benutzer äußerten Unzufriedenheit in den sozialen Medien und wiesen darauf hin, dass ChatGPT zu „zu schmeichelhaft“ geworden ist, und neigt dazu, Benutzeransichten zu überprüfen, anstatt ein kritisches Feedback zu geben. Dies wirkt sich nicht nur auf die Benutzererfahrung aus, sondern verleiht Unternehmenskunden auch tatsächliche Verluste, wie z. B. reduzierte Produktivität und Rechenressourcenverschwendung. Nachweis der Leistungsverschlechterung Viele Benutzer haben einen signifikanten Verschlechterung der Chatgpt-Leistung gemeldet, insbesondere in älteren Modellen wie GPT-4 (die Ende dieses Monats bald vom Service abgebrochen werden). Das

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

MantisBT

Mantis ist ein einfach zu implementierendes webbasiertes Tool zur Fehlerverfolgung, das die Fehlerverfolgung von Produkten unterstützen soll. Es erfordert PHP, MySQL und einen Webserver. Schauen Sie sich unsere Demo- und Hosting-Services an.

ZendStudio 13.5.1 Mac

Leistungsstarke integrierte PHP-Entwicklungsumgebung