Technologie-Peripheriegeräte

Technologie-Peripheriegeräte KI

KI Feinabstimmung Google Gemma: Verbesserung von LLMs mit individuellen Anweisungen

Feinabstimmung Google Gemma: Verbesserung von LLMs mit individuellen AnweisungenFeinabstimmung Google Gemma: Verbesserung von LLMs mit individuellen Anweisungen

Google DeepMinds Gemma: Ein tiefes Eintauchen in Open-Source-LLMs

Die KI-Landschaft summt mit Aktivität, insbesondere in Bezug auf Open-Source-Großsprachenmodelle (LLMs). Tech-Giganten wie Google, Meta und Twitter umfassen zunehmend Open-Source-Entwicklung. Google DeepMind hat kürzlich Gemma vorgestellt, eine Familie leichter Open-Source-LLMs, die mit derselben zugrunde liegenden Forschung und Technologie wie Gemini-Modellen von Google erstellt wurden. In diesem Artikel werden Gemma-Modelle, deren Zugänglichkeit über Cloud-GPUs und TPUs untersucht, und bietet eine Schritt-für-Schritt-Anleitung zur Feinabstimmung des Gemma 7B-IT-Modells auf einem Rollenspieldatensatz.

Google Gemma

verstehenGemma (was "Edelstein" in Lateinisch bedeutet) ist eine Familie nur von Decoder, nur von Google DeepMind, entwickelte Modelle von Text-to-Text-Modellen. Gemma wurde von den Gemini -Modellen inspiriert und ist für den leichten Betrieb und die umfassende Kompatibilität für Framework ausgelegt. Google hat Modellgewichte für zwei Gemma-Größen veröffentlicht: 2B und 7B, die jeweils in vorgeborenen und in Anweisungen abgestimmten Varianten erhältlich sind (z. B. Gemma 2B-IT und Gemma 7B-IT). Die Leistung von Gemma konkurriert andere offene Modelle, insbesondere übertrifft die LLAM-2 von Meta über verschiedene LLM-Benchmarks.

Bildquelle

Bildquelle

Gemma erstreckt sich auf seine Unterstützung für mehrere Frameworks (Keras 3.0, Pytorch, Jax, umarmende Gesichtstransformatoren) und vielfältige Hardware (Laptops, Desktops, IoT -Geräte, Mobilgeräte und Cloud). Inferenz und Überwachung der Feinabstimmung (SFT) sind auf kostenlosen Cloud-TPUs mit beliebten Frameworks für maschinelles Lernen möglich. Darüber hinaus bietet Google neben Gemma ein verantwortungsbewusstes generatives KI -Toolkit, das Entwicklungsleitungen und Tools zum Erstellen sichererer KI -Anwendungen bietet. Anfänger in AI und LLMs werden ermutigt, die KI -Fundamentals -Fähigkeiten für grundlegendes Wissen zu erkunden.

Zugriff auf das Gemma -Modell von Google

Zugriff auf Gemma ist unkompliziert. Der freie Zugang ist über Huggingchat und Poe erhältlich. Die lokale Verwendung ist auch möglich, indem Modellgewichte vom Umarmungsgesicht und die Verwendung von GPT4all oder LMSTUDIO heruntergeladen werden. Diese Anleitung konzentriert sich auf die Verwendung von Kaggle's Free GPUs und TPUs für Inferenz.

Gemma -Inferenz auf TPUs

laufendUm die Gemma -Inferenz auf TPUs mit Keras auszuführen, befolgen Sie die folgenden Schritte:

- Navigieren Sie zu Keras/Gemma, wählen Sie die Modellvariante "Gemma_instruct_2b_en" und klicken Sie auf "Neues Notizbuch".

- Wählen Sie im rechten Feld "TPU VM V3-8" als Beschleuniger.

- Installieren Sie die erforderlichen Python -Bibliotheken:

!pip install -q tensorflow-cpu !pip install -q -U keras-nlp tensorflow-hub !pip install -q -U keras>=3 !pip install -q -U tensorflow-text

- Überprüfen Sie die TPU -Verfügbarkeit mit

jax.devices(). - setzen Sie

jaxals Keras -Backend:os.environ["KERAS_BACKEND"] = "jax" - Laden Sie das Modell mit

keras_nlpund generieren Sie Text mit der Funktiongenerate.

Bildquelle

Bildquelle

Gemma -Inferenz auf gpus

ausführenfür die GPU -Inferenz mit Transformatoren folgen folgenden Schritten:

- Navigieren Sie zu Google/Gemma, wählen Sie "Transformers", wählen Sie die Variante "7b-it" und erstellen Sie ein neues Notizbuch.

- Wählen Sie GPT T4 x2 als Beschleuniger.

- Erforderliche Pakete installieren:

%%capture %pip install -U bitsandbytes %pip install -U transformers %pip install -U accelerate

- Laden Sie das Modell mit 4-Bit-Quantisierung mit BitsandBytes für VRAM-Management.

- Laden Sie den Tokenizer.

- Erstellen Sie eine Eingabeaufforderung, tokenisieren sie, übergeben Sie sie an das Modell, dekodieren Sie die Ausgabe und zeigen Sie das Ergebnis an.

Bildquelle

Bildquelle

GEMMA von Google von Google: Eine Schritt-für-Schritt-Anleitung

Dieser Abschnitt beschreibt mithilfe eines Kaggle P100 GPU.

hieunguyenminh/roleplay Einrichten

Installieren Sie die erforderlichen Pakete:

%%capture %pip install -U bitsandbytes %pip install -U transformers %pip install -U peft %pip install -U accelerate %pip install -U trl %pip install -U datasetsImportierende Bibliotheken importieren.

- Variablen für das Basismodell, den Datensatz und den fein abgestimmten Modellnamen definieren.

- Melden Sie sich bei der Umarmung von Face CLI mit Ihrem API -Schlüssel an.

- Initialisieren Sie Gewichte und Verzerrungen (W & B) Arbeitsbereich.

- Laden des Datensatzes

Laden Sie die ersten 1000 Zeilen des Rollenspieldatensatzes.

Laden des Modells und Tokenizers

Laden Sie das Gemma 7B-IT-Modell mit 4-Bit-Genauigkeit mit BitsandBytes. Laden Sie den Tokenizer und konfigurieren Sie das Pad -Token.

Hinzufügen der Adapterschicht

Fügen Sie eine LORA-Adapterschicht hinzu, um das Modell effizient zu optimieren.

Training des Modells

Schulungsargumente (Hyperparameter) definieren und einen SftTrainer erstellen. Trainieren Sie das Modell mit

.

.train() Speichern des Modells

speichern Sie das fein abgestimmte Modell lokal und drücken Sie es in den umarmenden Gesichtszentrum.

Modellinstr es

Antworten mit dem fein abgestimmten Modell erzeugen.

Gemma 7B Inferenz mit Rollenspiel -Adapter

Dieser Abschnitt zeigt, wie das Basismodell und der trainierte Adapter geladen werden, sie zusammenführen und Antworten generieren.

endgültige Gedanken

Die Veröffentlichung von Gemma durch Google ist eine Verschiebung zur Open-Source-Zusammenarbeit in AI. Dieses Tutorial bot einen umfassenden Leitfaden zur Verwendung und Feinabstimmung Gemma-Modellen, wobei die Leistung von Open-Source-Entwicklungs- und Cloud-Computing-Ressourcen hervorgehoben wurde. Der nächste Schritt besteht darin, Ihre eigene LLM-basierte Anwendung mit Frameworks wie Langchain zu erstellen.Das obige ist der detaillierte Inhalt vonFeinabstimmung Google Gemma: Verbesserung von LLMs mit individuellen Anweisungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

7 Leistungsstarke KI fordert jeder Projektmanager auf, jetzt zu meisternMay 08, 2025 am 11:39 AM

7 Leistungsstarke KI fordert jeder Projektmanager auf, jetzt zu meisternMay 08, 2025 am 11:39 AMGenerative KI, beispielhaft von Chatbots wie ChatGPT, bietet Projektmanagern leistungsstarke Tools, um Workflows zu optimieren und sicherzustellen, dass Projekte im Zeitplan und im Budget bleiben. Ein effektiver Gebrauch ist jedoch das Erstellen der richtigen Eingabeaufforderungen an. Präzise, Detail

Definieren der schlecht definierten Bedeutung von schwer fassbarem AGI über die hilfreiche Unterstützung der KI selbstMay 08, 2025 am 11:37 AM

Definieren der schlecht definierten Bedeutung von schwer fassbarem AGI über die hilfreiche Unterstützung der KI selbstMay 08, 2025 am 11:37 AMDie Herausforderung, künstliche allgemeine Intelligenz (AGI) zu definieren, ist von Bedeutung. Ansprüche des AGI-Fortschritts fehlen häufig einen klaren Benchmark, wobei Definitionen auf die festgelegten Forschungsrichtungen zugeschnitten sind. Dieser Artikel untersucht einen neuartigen Ansatz für definitiv

IBM Think 2025 präsentiert Watsonx.Datas Rolle in der generativen KIMay 08, 2025 am 11:32 AM

IBM Think 2025 präsentiert Watsonx.Datas Rolle in der generativen KIMay 08, 2025 am 11:32 AMIBM Watsonx.data: Straffung des AI -Datenstapels Enterprise IBM positioniert Watsonx.data als eine entscheidende Plattform für Unternehmen, die darauf abzielen, die Bereitstellung präziser und skalierbarer generativer KI -Lösungen zu beschleunigen. Dies wird erreicht, indem die Beschwerde vereinfacht wird

Der Aufstieg der humanoiden Robotermaschinen nähert sich.May 08, 2025 am 11:29 AM

Der Aufstieg der humanoiden Robotermaschinen nähert sich.May 08, 2025 am 11:29 AMDie schnellen Fortschritte in der Robotik, die durch Durchbrüche in KI und Materialwissenschaft angetrieben werden, sind bereit, eine neue Ära humanoischer Roboter einzuleiten. Seit Jahren steht die industrielle Automatisierung im Hauptaugenmerk, aber die Fähigkeiten von Robotern sind schnell exponiert

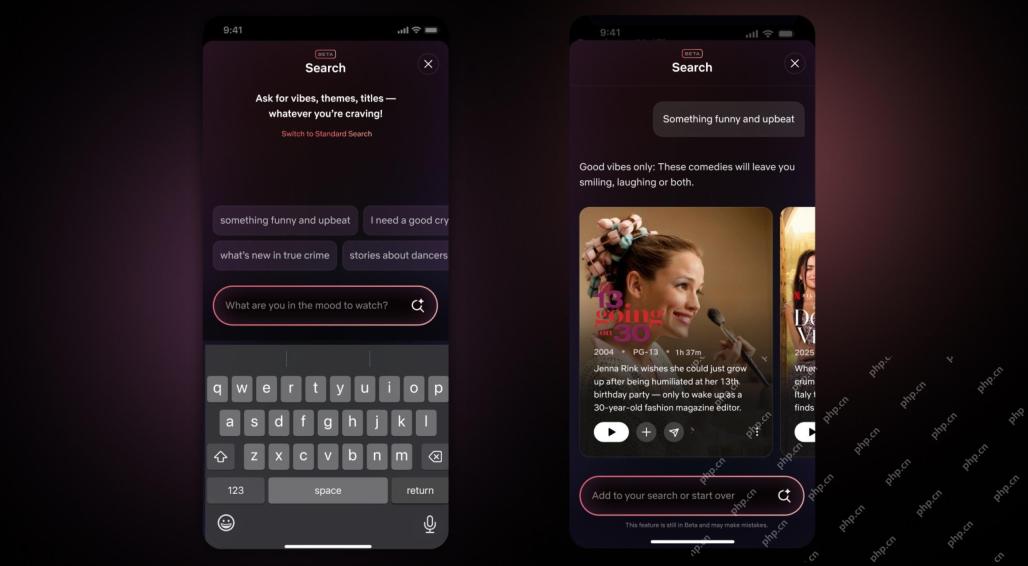

Netflix Revamps Interface-Debüt von KI-Suchwerkzeugen und Tiktok-ähnliches DesignMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debüt von KI-Suchwerkzeugen und Tiktok-ähnliches DesignMay 08, 2025 am 11:25 AMDas größte Update der Netflix -Schnittstelle in einem Jahrzehnt: intelligentere, personalisierter, umarme Inhalte Netflix kündigte in einem Jahrzehnt seine größte Überarbeitung seiner Benutzeroberfläche an, nicht nur ein neues Erscheinungsbild, sondern fügt auch weitere Informationen zu jeder Show hinzu und führt intelligenteren KI -Suchwerkzeugen ein, die vage Konzepte wie "Umgebungsstoffe" und flexiblere Strukturen des Unternehmens verstehen können, um das Interesse des Unternehmens an aufstrebenden Videospielen, Live -Ereignissen, Sportveranstaltungen und anderen neuen Arten von Inhalten besser zu demonstrieren. Um mit dem Trend Schritt zu halten, erleichtert die neue vertikale Videokomponente auf Mobile den Fans, durch Trailer und Clips zu scrollen, die vollständige Show zu sehen oder Inhalte mit anderen zu teilen. Dies erinnert Sie an die unendliche Scrolling und die sehr erfolgreiche kurze Video -Website Ti

Lange vor AGI: Drei KI -Meilensteine, die Sie herausfordern werdenMay 08, 2025 am 11:24 AM

Lange vor AGI: Drei KI -Meilensteine, die Sie herausfordern werdenMay 08, 2025 am 11:24 AMDie wachsende Diskussion der allgemeinen Intelligenz (AGI) in künstlicher Intelligenz hat viele dazu veranlasst, darüber nachzudenken, was passiert, wenn künstliche Intelligenz die menschliche Intelligenz übertrifft. Ob dieser Moment in der Nähe oder weit entfernt ist, hängt davon ab, wen Sie fragen, aber ich denke nicht, dass es der wichtigste Meilenstein ist, auf den wir uns konzentrieren sollten. Welche früheren KI -Meilensteine betreffen alle? Welche Meilensteine wurden erreicht? Hier sind drei Dinge, von denen ich denke, dass sie passiert sind. Künstliche Intelligenz übertrifft die menschlichen Schwächen Im Film "Social Dilemma" 2022 wies Tristan Harris vom Zentrum für humane Technologie darauf hin, dass künstliche Intelligenz die menschlichen Schwächen übertroffen hat. Was bedeutet das? Dies bedeutet, dass künstliche Intelligenz Menschen benutzen konnte

Venkat Achanta über die Plattformtransformation von Transunion und KI -EhrgeizMay 08, 2025 am 11:23 AM

Venkat Achanta über die Plattformtransformation von Transunion und KI -EhrgeizMay 08, 2025 am 11:23 AMDie CTO von Transunion, Ranganath Achanta, führte eine bedeutende technologische Transformation an, seit er sich nach seinem Akquisition von Neustar Ende 2021 dem Unternehmen angeschlossen hat. Seine Führung von über 7.000 Mitarbeitern in verschiedenen Abteilungen hat sich auf u konzentriert

Wenn das Vertrauen in KI springt, folgt die ProduktivitätMay 08, 2025 am 11:11 AM

Wenn das Vertrauen in KI springt, folgt die ProduktivitätMay 08, 2025 am 11:11 AMDer Aufbau von Vertrauen ist für eine erfolgreiche KI -Einführung im Geschäft von größter Bedeutung. Dies gilt insbesondere angesichts des menschlichen Elements innerhalb von Geschäftsprozessen. Mitarbeiter, wie alle anderen, haben Bedenken hinsichtlich der KI und ihrer Umsetzung. Deloitte -Forscher sind SC

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SAP NetWeaver Server-Adapter für Eclipse

Integrieren Sie Eclipse mit dem SAP NetWeaver-Anwendungsserver.

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),

EditPlus chinesische Crack-Version

Geringe Größe, Syntaxhervorhebung, unterstützt keine Code-Eingabeaufforderungsfunktion

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung