Verstärkungslernen (RL): Ein tiefes Eintauchen in die Interaktion zwischen Agent und Umwelt

Basic und Advanced verstärkte Lernmodelle (RL) -Modelle übertreffen die aktuellen Großsprachenmodelle in ihrer Ähnlichkeit mit der KI der Science-Fiction. In diesem Artikel wird untersucht, wie RL es einem Agenten ermöglicht, herausfordernde Niveaus in Super Mario zu erobern.

Der Agent fehlt zunächst das Spielwissen: Kontrollen, Fortschrittsmechaniker, Hindernisse und Gewinnbedingungen. Es lernt all dies autonom durch Verstärkungslernenalgorithmen ohne menschliche Intervention.

Die Stärke vonrl liegt in der Lösung von Problemen ohne vordefinierte Lösungen oder explizite Programmierung, häufig mit minimalen Datenanforderungen. Dies macht es in verschiedenen Feldern wirksam:

- Autonome Fahrzeuge: RL-Agenten lernen optimale Fahrstrategien basierend auf Echtzeitverkehr und Straßenregeln.

- Robotik: Roboter meistern komplexe Aufgaben in dynamischen Umgebungen durch RL -Training.

- Game AI: RL -Techniken ermöglichen es KI -Agenten, anspruchsvolle Strategien in Spielen wie Go und StarCraft II zu entwickeln.

rl ist ein sich schnell entwickelnder Feld mit immensem Potenzial. Zukünftige Anwendungen werden in Ressourcenmanagement, Gesundheitswesen und personalisierter Bildung erwartet. In diesem Tutorial werden RL -Grundlagen vorgestellt, in denen Kernkonzepte wie Agent, Umwelt, Aktionen, Staaten, Belohnungen und mehr.

Agent und Umgebung: Die Perspektive einer KatzeBetrachten Sie eine Katze, Bob, um Kratzpfosten anstelle von Möbeln zu verwenden. Bob ist der

Agent , der Lernende und Entscheidungsträger. Der Raum ist die Umgebung , die Herausforderungen (Möbel) und das Ziel (Kratzerpfosten) darstellt.

rl -Umgebungen werden als:kategorisiert

- diskret: Ein vereinfachter Raum wie ein gitterbasiertes Spiel, das Bobs Bewegung und Raumvariationen begrenzt.

- kontinuierlich: Ein Raum in der Praxis bietet nahezu unendliche Möglichkeiten für Möbelvereinbarungen und Bobs Aktionen.

-Umgebung (Möbel bleibt festgelegt). Eine dynamische Umgebung wie ein Super -Mario -Level ändert sich im Laufe der Zeit, zunehmende Lernkomplexität. Handlungen und Zustände: Definieren der Möglichkeiten

Zustandsraum

umfasst alle möglichen Konfigurationen der Agentenumwelt. Die Größe hängt vom Umgebungstyp ab:endlich:

- diskrete Umgebungen haben eine begrenzte Anzahl von Zuständen (z. B. Brettspiele).

- unendlich: kontinuierliche Umgebungen haben unbegrenzte Zustandsräume (z. B. Roboter, reale Szenarien).

- Aktionsraum

- diskret: Begrenzte Aktionen (z. B. nach oben, unten, links, rechts).

- kontinuierlich: Ein breiterer Aktionsbereich (z. B. jede Richtung, Springen).

Jede Aktion übergeht die Umgebung in einen neuen Zustand.

Belohnungen, Zeitschritte und Episoden: Messen Sie den Fortschritt

Belohnungen Anreize den Agenten. Im Schach ist es positiv, ein Stück zu fangen; Ein Scheck zu erhalten ist negativ. Für Bob belohnen die Belohnung positive Aktionen (unter Verwendung von Kratzern), während Wasserspritzer negative Aktionen bestrafen (Kratzen von Möbeln).

Zeitschritte Messen Sie die Lernreise des Agenten. Jeder Schritt beinhaltet eine Aktion, die zu einem neuen Zustand und einer Belohnung führt.

an Episode umfasst eine Abfolge von Zeitschritten, beginnend in einem Standardzustand und endet, wenn das Ziel erreicht ist oder der Agent fehlschlägt.

Erkundung vs. Ausbeutung: Ausgleich des ACT

balancierenDer Agent muss Erkundung (neue Aktionen ausprobieren) und Ausbeutung

(unter Verwendung bekannt Beste Aktionen) ausgleichen. Zu den Strategien gehören:- Epsilon-Greedy: zufällige Untersuchung mit einer Wahrscheinlichkeit (Epsilon); Ansonsten die bekannteste Aktion ausnutzen.

- Boltzmann Exploration: probabilistisch begünstigt Aktionen mit höheren erwarteten Belohnungen.

Verstärkungslernalgorithmen: modellbasiertes vs. modellfreies

RL-Algorithmen leiten die Entscheidungsfindung des Agenten. Es gibt zwei Hauptkategorien:

modellbasiertes Rl

Der Agent erstellt ein internes Modell der Umgebung, um Aktionen zu planen. Dies ist eine Stichprobeneffizient, aber für komplexe Umgebungen herausfordernd. Ein Beispiel ist Dyna-Q, das modellbasiertes und modellfreies Lernen kombiniert.

modellfreies Rl

Der Agent lernt direkt aus Erfahrung ohne explizites Modell. Dies ist einfacher, aber weniger Beispieleffizient. Beispiele sind:

- Q-Learning: lernt Q-Werte (erwartete zukünftige Belohnungen) für State-Action-Paare.

- sarsa: Ähnlich wie das Q-Learning, aber aktualisiert die Werte basierend auf der tatsächlichen nächsten Aktion.

- Policy Gradient Methoden: Lernen Sie direkt einen politischen Zuordnungszustände zu Maßnahmen.

- Deep Q-Networks (DQN): kombiniert Q-Learning mit tiefen neuronalen Netzwerken für hochdimensionale Zustandsräume.

Algorithmusauswahl hängt von der Komplexität der Umgebung und der Verfügbarkeit von Ressourcen ab.

Q-Learning: Ein detailliertes Aussehen

Q-Learning ist ein modellfreies Algorithmus-Lehrer optimaler Strategien. Ein Q-Table speichert Q-Werte für jedes Staatspaar. Der Agent wählt Aktionen, die auf einer Epsilon-Greedy-Politik basieren und die Erkundung und Ausbeutung ausbalancieren. Q-Werte werden mit einer Formel aktualisiert, die den aktuellen Q-Wert, die Belohnung und den maximalen Q-Wert des nächsten Zustands enthält. Parameter wie Gamma (Rabattfaktor) und Alpha (Lernrate) steuern den Lernprozess.

Verstärkungslernen in Python mit Gymnasium

Gymnasium bietet verschiedene Umgebungen für RL -Experimente. Der folgende Code -Snippet zeigt eine Interaktionsschleife mit der Breakout -Umgebung:

import gymnasium as gym

env = gym.make("ALE/Breakout-v5", render_mode="rgb_array")

# ... (interaction loop and GIF creation code as in the original article) ...

Dieser Code generiert ein GIF, das die Aktionen des Agenten visualisiert. Beachten Sie, dass die Aktionen ohne Lernalgorithmus zufällig sind.

Schlussfolgerung

Verstärkungslernen ist eine leistungsstarke Technik mit breiten Anwendungen. Dieses Tutorial umfasste grundlegende Konzepte und lieferte einen Ausgangspunkt für die weitere Erkundung. Zusätzliche Ressourcen sind im ursprünglichen Artikel zum fortgesetzten Lernen aufgeführt.

Das obige ist der detaillierte Inhalt vonVerstärkungslernen: Eine Einführung mit Python -Beispielen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

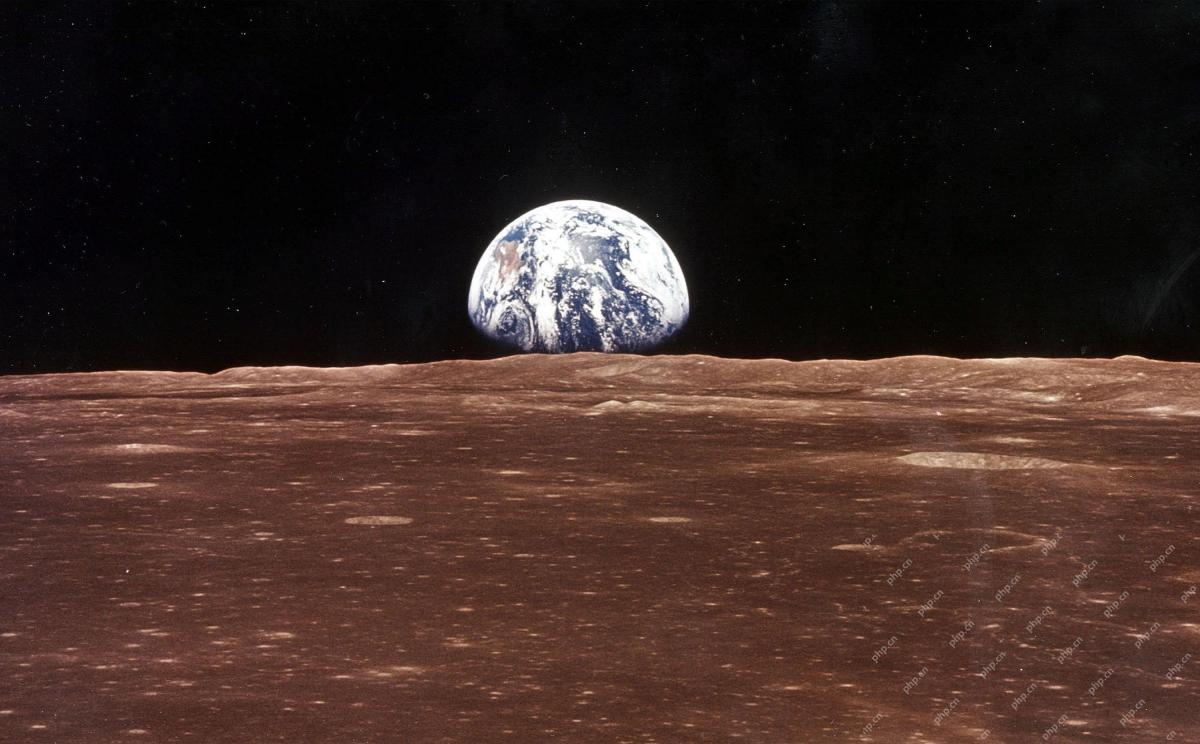

Eine KI -Weltraumfirma wird geborenMay 12, 2025 am 11:07 AM

Eine KI -Weltraumfirma wird geborenMay 12, 2025 am 11:07 AMDieser Artikel zeigt, wie KI die Weltraumindustrie revolutioniert und morgen.IO als Hauptbeispiel revolutioniert. Im Gegensatz zu etablierten Weltraumunternehmen wie SpaceX, die nicht mit KI im Kern gebaut wurden, ist Tomorrow.io ein KI-nativer Unternehmen. Lassen Sie uns erkunden

10 Praktika für maschinelles Lernen in Indien (2025)May 12, 2025 am 10:47 AM

10 Praktika für maschinelles Lernen in Indien (2025)May 12, 2025 am 10:47 AMLegen Sie Ihr Traummaschinen -Lernpraktikum in Indien (2025)! Für Studenten und Fachkräfte für die frühen Karriere ist ein Praktikum für maschinelles Lernen das perfekte Launchpad für eine lohnende Karriere. Indische Unternehmen in verschiedenen Sektoren-von modernen Gena

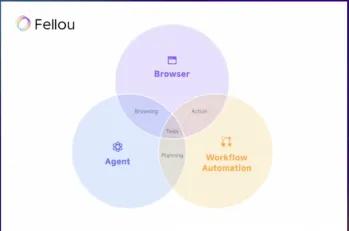

Versuchen Sie Fellou Ai und verabschieden Sie sich von Google und ChatgptMay 12, 2025 am 10:26 AM

Versuchen Sie Fellou Ai und verabschieden Sie sich von Google und ChatgptMay 12, 2025 am 10:26 AMDie Landschaft des Online -Surfens hat im vergangenen Jahr eine bedeutende Transformation erfahren. Diese Verschiebung begann mit verbesserten, personalisierten Suchergebnissen von Plattformen wie Verwirrigkeit und Copilot und wurde mit der Integration von Webs durch Chatgpt beschleunigt

Persönliches Hacking wird ein ziemlich heftiger Bär seinMay 11, 2025 am 11:09 AM

Persönliches Hacking wird ein ziemlich heftiger Bär seinMay 11, 2025 am 11:09 AMCyberangriffe entwickeln sich weiter. Vorbei sind die Tage generischer Phishing -E -Mails. Die Zukunft der Cyberkriminalität ist hyperpersonalisiert und nutzt leicht verfügbare Online-Daten und KI, um hoch gezielte Angriffe zu erzeugen. Stellen Sie sich einen Betrüger vor, der Ihren Job kennt, Ihr F.

Papst Leo XIV zeigt, wie KI seine Namenswahl beeinflusst hatMay 11, 2025 am 11:07 AM

Papst Leo XIV zeigt, wie KI seine Namenswahl beeinflusst hatMay 11, 2025 am 11:07 AMIn seiner Eröffnungsrede an das College of Cardinals diskutierte der in Chicago geborene Robert Francis Prevost, der neu gewählte Papst Leo XIV, den Einfluss seines Namensvetters, Papst Leo XIII., Dessen Papsttum (1878-1903) mit der Dämmerung des Automobils und der Dämmerung des Automobils und des Automobils zusammenfiel

FASTAPI -MCP -Tutorial für Anfänger und Experten - Analytics VidhyaMay 11, 2025 am 10:56 AM

FASTAPI -MCP -Tutorial für Anfänger und Experten - Analytics VidhyaMay 11, 2025 am 10:56 AMDieses Tutorial zeigt, wie Sie Ihr großes Sprachmodell (LLM) mit dem Modellkontextprotokoll (MCP) und Fastapi in externe Tools integrieren. Wir erstellen eine einfache Webanwendung mit Fastapi und konvertieren sie in einen MCP -Server, um Ihr L zu aktivieren

DIA-1.6B TTS: Bestes Modell zur Generierung von Text zu Dialogue-Analytics VidhyaMay 11, 2025 am 10:27 AM

DIA-1.6B TTS: Bestes Modell zur Generierung von Text zu Dialogue-Analytics VidhyaMay 11, 2025 am 10:27 AMEntdecken Sie DIA-1.6B: Ein bahnbrechendes Text-zu-Sprach-Modell, das von zwei Studenten ohne Finanzierung entwickelt wurde! Dieses 1,6 -Milliarden -Parametermodell erzeugt eine bemerkenswert realistische Sprache, einschließlich nonverbaler Hinweise wie Lachen und Niesen. Dieser Artikelhandbuch

3 Wege KI kann Mentoring sinnvoller als je zuvor machenMay 10, 2025 am 11:17 AM

3 Wege KI kann Mentoring sinnvoller als je zuvor machenMay 10, 2025 am 11:17 AMIch stimme voll und ganz zu. Mein Erfolg ist untrennbar mit der Anleitung meiner Mentoren verbunden. Ihre Einsichten, insbesondere in Bezug auf das Geschäftsmanagement, bildeten das Fundament meiner Überzeugungen und Praktiken. Diese Erfahrung unterstreicht mein Engagement für Mentor

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SecLists

SecLists ist der ultimative Begleiter für Sicherheitstester. Dabei handelt es sich um eine Sammlung verschiedener Arten von Listen, die häufig bei Sicherheitsbewertungen verwendet werden, an einem Ort. SecLists trägt dazu bei, Sicherheitstests effizienter und produktiver zu gestalten, indem es bequem alle Listen bereitstellt, die ein Sicherheitstester benötigen könnte. Zu den Listentypen gehören Benutzernamen, Passwörter, URLs, Fuzzing-Payloads, Muster für vertrauliche Daten, Web-Shells und mehr. Der Tester kann dieses Repository einfach auf einen neuen Testcomputer übertragen und hat dann Zugriff auf alle Arten von Listen, die er benötigt.

Dreamweaver Mac

Visuelle Webentwicklungstools

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools