Stability AI kündigte im Februar 2024 eine frühzeitige Vorschau von stabiler Diffusion 3 an. Das KI -Modell befindet sich noch in der Vorschau, aber im April 2024 kündigte das Team an, dass es stabile Diffusion 3 und stabile Diffusion 3 Turbo auf der API -Entwickler -API -API -API -API -API -API -API -API -API -API -API -API -API -API -API -API -API -API -API -Plattform machen würde.

Beachten Sie, dass stabile Diffusion 3 einfach eine Reihe von generativen AI-Modellen von Text-to-Image-Modellen ist. Nach Angaben des Teams bei Stability AI ist das Modell"gleich oder übertrifft" andere Text-zu-Image-Generatoren, wie z. In diesem Tutorial lernen Sie praktische Schritte, um mit der API zu beginnen, damit Sie Ihre eigenen Bilder generieren können. Warum stabile Diffusion 3?

Stabile Diffusion 3 führt mehrere Fortschritte und Merkmale ein, die sie von ihren Vorgängern unterscheiden und im Bereich der Text-zu-Image-Erzeugung sehr wettbewerbsfähig machen-insbesondere im Hinblick auf die verbesserte Erzeugung von Text und die Bereitschaftsfunktionen.

Lassen Sie uns diese Fortschritte untersuchen:

Verbesserte Eingabeaufforderung nach

- Kontextbezogenes Verständnis: Stabile Diffusion 3 enthält hochmoderne Techniken der natürlichen Sprachverarbeitung (NCLP), sodass sie bessere Benutzeraufforderungen verstehen und interpretieren können. Dies ermöglicht genauere und kontextbezogene Antworten auf Benutzereingaben.

- Eingabeaufforderung Kontinuität: Im Gegensatz zu früheren Versionen behält stabile Diffusion 3 bei den folgenden Eingabeaufforderungen eine bessere Kontinuität bei, und stellt sicher, dass der generierte Text während der gesamten Konversation kohärent und mit der Eingabe des Benutzers ausgerichtet bleibt.

verbesserte Textgenerierung

- fein abgestimmte Sprachmodelle: Stabile Diffusion 3 verwendet fein abgestimmte Sprachmodelle, die umfangreiche Schulungen an großen Datensätzen absolviert haben, was zu verbesserten Funktionen der Textgenerierung führt. Diese Modelle verstehen Grammatik, Syntax und Semantik besser, was zu kohärenteren und natürlicheren Reaktionen führt.

- reduzierte Reaktionsvariabilität: Durch verbesserte Trainingsmethoden und Modellarchitekturen reduziert stabile Diffusion 3 die Reaktionsvariabilität und erzeugt konsistentere und qualitativ hochwertigere Ausgaben über verschiedene Eingabeaufforderungen hinweg und Kontexte.

Erweiterte Eingabeaufforderungserweiterung

- Dialogunterstützung für mehreren Turns: Stabile Diffusion 3 kann Multi-Turn-Dialoge effektiver verarbeiten und die Kohärenz und den Kontext über mehrere Austauschs zwischen dem Benutzer und dem AI-Modell aufrechterhalten. .

- Einheitliche Expansionstechniken: Das Modell verwendet erweiterte Eingabeaufentwicklungs -Expansionstechniken, um informativere und kontextbezogene Antworten zu generieren, den Dialog zu bereichern und Benutzern umfassende Antworten auf ihre Fragen zu geben.

fein abgestimmte Kontrollmechanismen

- Parameterabstimmung: Stabile Diffusion 3 Features Fege-stimmende Kontrollmechanismen, mit denen Benutzer Parameter wie Antwortlänge, Kreativitätsebene und Themenrelevanz anpassen können, wodurch ein individuelles Interaktionserfahrung ermöglicht wird.

- Vorspannungsminderung: Das Modell enthält Maßnahmen zur Minderung von Verzerrungen in der Textgenerierung, die Fairness und Inklusivität in den Antworten auf Benutzeraufforderungen fördert.

Erste Schritte mit stabiler Diffusion 3 API

Dieser Abschnitt wird die Schritte durchlaufen, um mit der Stabilitäts -API zu beginnen.

Schritt 1: Erstellen Sie Ihr Konto.

Sie müssen ein Konto erstellen, bevor Sie die API von Stability AI verwenden können. Sie können sich über einen Benutzernamen und ein Kennwort anmelden, aber neue Benutzer erhalten 25 kostenlose Credits für die Anmeldung über das Google -Konto.Schritt 2: Behalten Sie Ihren API -Schlüssel an. Sobald Sie Ihr Konto erstellt haben, benötigen Sie eine API erhalten. Dies finden Sie auf der API -Keys -Seite. In der Dokumentation stellt die Stabilität AI fest, dass „alle auf dieser Website dokumentierten APIs denselben Authentifizierungsmechanismus verwenden: den API -Schlüssel über den Autorisierungsheader eingeben.“

Schritt 3: Credits hochfahren. Sie müssen Credits haben, um die API anzufordern. Gutschriften sind die Einheit der Währung, die beim Aufrufen der API verbraucht wird - der verbrauchte Betrag variiert zwischen Modellen und Modalitäten. Nachdem Sie alle Ihre Credits verwendet haben, können Sie mehr über Ihr Abrechnungs -Dashboard für 1 USD pro 100 Credits kaufen.

In diesem Tutorial werden wir Google Colab und Comfyui verwenden, um zu demonstrieren, wie Bilder mit der stabilen Diffusion 3 -API generiert werden. Im nächsten Abschnitt werden wir die Schritte abdecken, um mit jedem Tool zu beginnen.

Verwenden der stabilen Diffusion 3 -API mit Google Colab

Um mit Google Colab zu beginnen, müssen Sie ein Google -Konto erstellen. Klicken Sie auf den Link und befolgen Sie die Anweisungen.

Wenn Sie bereits ein Google -Konto haben, öffnen Sie ein neues Notizbuch und befolgen Sie die folgenden Schritte.

Hinweis: Der in diesem Beispiel verwendete Code stammt aus dem Tutorial SD3_API von Stabilität AI.

Schritt 1: Installieren Sie die Anforderungen.

from io import BytesIO import IPython import json import os from PIL import Image import requests import time from google.colab import output

Schritt 2: Verbindung zur Stabilitäts -API.

import getpass

# To get your API key, visit https://platform.stability.ai/account/keys

STABILITY_KEY = getpass.getpass('Enter your API Key')

Schritt 3. Definieren Sie Funktionen

def send_generation_request(

host,

params,

):

headers = {

"Accept": "image/*",

"Authorization": f"Bearer {STABILITY_KEY}"

}

# Encode parameters

files = {}

image = params.pop("image", None)

mask = params.pop("mask", None)

if image is not None and image != '':

files["image"] = open(image, 'rb')

if mask is not None and mask != '':

files["mask"] = open(mask, 'rb')

if len(files)==0:

files["none"] = ''

# Send request

print(f"Sending REST request to {host}...")

response = requests.post(

host,

headers=headers,

files=files,

data=params

)

if not response.ok:

raise Exception(f"HTTP {response.status_code}: {response.text}")

return response

Schritt 4. Bilder generieren.

Nach der Dokumentation umfassen die stabilen Bilddienste nur ein Angebot, das derzeit in Produktion ist:

- SD3: verwendet 6,5 Credits

- SD3 Turbo: verwendet 4 Credits

Lassen Sie sie sie ausführen.

In diesem Beispiel werden wir ein Bild eines Tukanvogels in einem Tiefland -Tropengebiet erstellen.

# SD3

prompt = "This dreamlike digital art captures a vibrant, Toucan bird in a lowland tropic area" #@param {type:"string"}

negative_prompt = "" #@param {type:"string"}

aspect_ratio = "1:1" #@param ["21:9", "16:9", "3:2", "5:4", "1:1", "4:5", "2:3", "9:16", "9:21"]

seed = 0 #@param {type:"integer"}

output_format = "jpeg" #@param ["jpeg", "png"]

host = f"https://api.stability.ai/v2beta/stable-image/generate/sd3"

params = {

"prompt" : prompt,

"negative_prompt" : negative_prompt,

"aspect_ratio" : aspect_ratio,

"seed" : seed,

"output_format" : output_format,

"model" : "sd3",

"mode" : "text-to-image"

}

response = send_generation_request(

host,

params

)

# Decode response

output_image = response.content

finish_reason = response.headers.get("finish-reason")

seed = response.headers.get("seed")

# Check for NSFW classification

if finish_reason == 'CONTENT_FILTERED':

raise Warning("Generation failed NSFW classifier")

# Save and display result

generated = f"generated_{seed}.{output_format}"

with open(generated, "wb") as f:

f.write(output_image)

print(f"Saved image {generated}")

output.no_vertical_scroll()

print("Result image:")

IPython.display.display(Image.open(generated))

Hier ist, was es erstellt hat:

Bild erstellt vom Autor mit stabiler Diffusion 3

Erstellen wir nun ein Bild eines Autos aus Früchten mit SD3 Turbo:

#SD3 Turbo

prompt = "A car made out of fruits." #@param {type:"string"}

aspect_ratio = "1:1" #@param ["21:9", "16:9", "3:2", "5:4", "1:1", "4:5", "2:3", "9:16", "9:21"]

seed = 0 #@param {type:"integer"}

output_format = "jpeg" #@param ["jpeg", "png"]

host = f"https://api.stability.ai/v2beta/stable-image/generate/sd3"

params = {

"prompt" : prompt,

"aspect_ratio" : aspect_ratio,

"seed" : seed,

"output_format" : output_format,

"model" : "sd3-turbo"

}

response = send_generation_request(

host,

params

)

# Decode response

output_image = response.content

finish_reason = response.headers.get("finish-reason")

seed = response.headers.get("seed")

# Check for NSFW classification

if finish_reason == 'CONTENT_FILTERED':

raise Warning("Generation failed NSFW classifier")

# Save and display result

generated = f"generated_{seed}.{output_format}"

with open(generated, "wb") as f:

f.write(output_image)

print(f"Saved image {generated}")

output.no_vertical_scroll()

print("Result image:")

IPython.display.display(Image.open(generated))

Ausführen dieses Codes erzeugt das folgende Bild:

Bild erstellt vom Autor mit stabilen Diffusion 3 Turbo

Verwenden der API mit comfyui

comfyui ist eine robuste und flexible grafische Benutzeroberfläche (GUI) für eine stabile Diffusion. Es verfügt über eine graphbasierte Schnittstelle und verwendet ein Design im Flussdisplay-Design, mit dem Benutzer ausgefeilte, stabile Diffusions-Workflows erstellen und ausführen können.

Systemanforderungen:

- Grafikverarbeitungseinheit (GPU): Eine angemessene NVIDIA -GPU mit mindestens 8 GB VRAM, wie z. B. RTX 3060 Ti oder besser.

- Zentrale Verarbeitungseinheit (CPU): Ein zeitgenössischer Prozessor, einschließlich Intel Xeon E5, I5, Ryzen 5 oder höher.

- Zufallszugriffsspeicher (RAM): 16 GB oder größer.

- Betriebssystem: Windows 10/11 oder Linux.

- Angemessener Speicherplatz auf Ihrem Computer für Modelle und generierte Bilder.

Schritt 1: Installieren Sie Comfyui

Die einfachste Methode zur Installation von Comfyui unter Windows besteht darin, das eigenständige Installationsprogramm auf der Seite "Releases" zu verwenden. Dieser Installateur enthält wesentliche Abhängigkeiten wie Pytorch und umarmende Gesichtstransformatoren, wodurch die Notwendigkeit separater Installationen beseitigt wird.

Es bietet ein umfassendes Paket, das ein schnelles Setup von Comfyui unter Windows ermöglicht, ohne komplizierte Konfigurationen zu erfordern.

einfach herunterladen, extrahieren, Modelle hinzufügen und starten!

Schritt 1.1: Laden Sie die eigenständige Version von Comfyui aus diesem Github -Repository herunter - Klicken auf den Link initiiert den Download.

Schritt 1.2: Sobald Sie die neueste Comfyui-Windows.zip-Datei heruntergeladen haben, extrahieren Sie sie mit einem Dienstprogramm wie 7-Zip oder Winrar.

Schritt 1.3: Ein Checkpoint -Modell ist erforderlich, um Comfyui zu verwenden. Sie können ein Checkpoint -Modell von stabiler Diffusion oder Umarmung herunterladen. Legen Sie das Modell in den Ordner:

from io import BytesIO import IPython import json import os from PIL import Image import requests import time from google.colab import output

Schritt 1.4: Führen Sie jetzt einfach die run_nvidia_gpu.bat (empfohlen) oder run_cpu.bat aus. Dies sollte automatisch Comfyui in Ihrem Browser starten.

Die Befehlszeile wird eine URL http://127.0.0.1:8188/ ausführen und generieren, die Sie jetzt in Ihrem Browser öffnen können.

Schritt 2: Installieren Sie Comfyui Manager

Suchen Sie in der Datei -Explorer -Anwendung das gerade installierte Verzeichnis. Da Sie Windows verwenden, sollte es "Comfyui_Windows_portable" bezeichnet werden. Navigieren Sie von hier aus zu Comfyui und dann Custom_nodes. Geben Sie von diesem Ort CMD in die Adressleiste ein und drücken Sie die Eingabetaste.

Dies sollte ein Eingabeaufforderung -Terminal öffnen, in dem Sie den folgenden Befehl einfügen müssen:

import getpass

# To get your API key, visit https://platform.stability.ai/account/keys

STABILITY_KEY = getpass.getpass('Enter your API Key')

Sobald es vollständig ist, starten Sie Comfyui neu. Die neue Schaltfläche „ Manager “ sollte im schwimmenden Bereich angezeigt werden.

Schritt 3: Installation des Stabilitäts -AI -API -Knotens

Wählen Sie die Schaltfläche Verwalten und navigieren Sie zu „ benutzerdefinierte Knoten installieren. Suchen Sie den Knoten "Stabilitäts -API -Knoten für Comfyui" und klicken Sie dann auf die Schaltfläche Installation auf der rechten Seite, um den Installationsvorgang zu initiieren. Anschließend wird eine " -Restart " -Baste sichtbar. Klicken Sie auf "

Neustart", um Comfyui neu zu starten.

aus und führen Sie ihn aus

Du bist jetzt gut zu gehen! Wie bei jedem Tool gibt es immer eine Möglichkeit, auf dem Weg ein paar Probleme zu begegnen. Hier sind die häufigsten Herausforderungen und Fehlerbehebungsschritte für Benutzer, die Probleme mit der API oder dem Setup -Prozess haben. Herausforderung: Benutzer können beim Zugriff auf die API aufgrund einer falschen API -Taste oder falschen Authentifizierungsanmeldeinformationen auf die API zugreifen. Fehlerbehebung: Überprüfen Sie den API-Schlüssel und stellen Sie sicher, dass er kopiert und ordnungsgemäß eingefügt wird. Stellen Sie sicher, dass es im Schlüssel keine zusätzlichen Leerzeichen oder Zeichen gibt. Stellen Sie sicher, dass der API -Schlüssel durch den stabilen Diffusion 3 -Server ordnungsgemäß authentifiziert wird. Herausforderung: Benutzer können auf Probleme im Zusammenhang mit dem Kreditmanagement stoßen, z. B. unzureichende Gutschriften oder Abrechnungsfehler. Fehlerbehebung: Überprüfen Sie Ihren Kreditsaldo im stabilen Diffusion 3 Dashboard, um sicherzustellen, dass Sie über ausreichende Credits verfügen. Überprüfen Sie Ihre Rechnungsinformationen und behandeln Sie alle Abrechnungsfehler oder Unstimmigkeiten mit dem Support -Team. Herausforderung: Benutzer können Konnektivitätsprobleme oder Netzwerkunterbrechungen auftreten, die sie daran hindern, auf die API zuzugreifen. Fehlerbehebung: Stellen Sie sicher, dass Sie eine stabile Internetverbindung haben und keine Netzwerkstörungen vorliegen. Um das Problem zu isolieren, greifen Sie aus einem anderen Netzwerk oder Gerät auf die API aus. Wenden Sie sich an Ihren Internetdienstanbieter, wenn Sie weiterhin Konnektivitätsprobleme haben. Herausforderung: Benutzer können bei der Installation oder Verwendung der erforderlichen Tools und Bibliotheken auf Kompatibilitätsprobleme oder Abhängigkeitsfehler stoßen.

Fehlerbehebung: Herausforderung: Benutzer können bei der Interaktion mit der API, insbesondere während der Spitzennutzungszeiten, langsame Reaktionszeiten oder Leistungsprobleme auftreten.

Fehlerbehebung:

Herausforderung: Fehlerbehebung: Für die Anleitung zu API -Nutzung, Fehlerbehebung und Best Practices finden Sie die stabile Dokumentation von Diffusion 3. Wenn Sie ungelöste Probleme oder Fragen haben, wenden Sie sich an das Support -Team oder die Community -Foren. stabile Diffusion 3 ist eine Reihe von generativen AI-Modellen von Text zu Image. Dieser Artikel umfasste praktische Schritte, um die API mit Google Colab und Comfyui zu verwenden. Jetzt haben Sie die Fähigkeiten, Ihre eigenen Bilder zu erstellen. Wenden Sie unbedingt das an, was Sie so schnell wie möglich gelernt haben, damit Sie nicht vergessen. Danke fürs Lesen! Best Practices für die Verwendung der stabilen Diffusion 3 -API umfassen die Bereitstellung klarer und spezifischer Aufforderungen, das Experimentieren mit unterschiedlichen Parametern, um die gewünschten Ergebnisse zu erzielen, die Kreditverwendung zu überwachen, um Depletion zu vermeiden und mit den neuesten Dokumentationen und Funktionen auf dem Laufenden zu bleiben.

Schritt 4: Definieren Sie den systemweiten API-Schlüssel

from io import BytesIO

import IPython

import json

import os

from PIL import Image

import requests

import time

from google.colab import output

Schritt 5: Laden und führen Sie den Workflow Fehlerbehebung und Tipps

API -Schlüssel und Authentifizierungsprobleme

Kreditmanagementprobleme

Konnektivitäts- und Netzwerkprobleme

Kompatibilitäts- und Abhängigkeitsfehler

Leistung und Reaktionszeit

Dokumentation und Unterstützung Schlussfolgerung

Weiteres Lernen

FAQs

Was sind einige Best Practices für die Verwendung einer stabilen Diffusion 3 -API effektiv?

Stabile Diffusion umfasst eine Sammlung von KI -Modellen, die sich auf die Erzeugung von Bildern aus textlichen Eingabeaufforderungen konzentrieren. Benutzer geben Beschreibungen der gewünschten Bilder an, und das Modell generiert entsprechende visuelle Darstellungen, die auf diesen Eingabeaufforderungen basieren.

Wie funktioniert die stabile Diffusion? Diese Innovation verschmilzt die Transformer -Architektur, die üblicherweise in Großsprachenmodellen wie GPT mit Diffusionsmodellen verwendet wird, und bietet das Potenzial, die Stärken beider Architekturen zu nutzen.

Das obige ist der detaillierte Inhalt vonSo verwenden Sie die stabile Diffusion 3 API. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

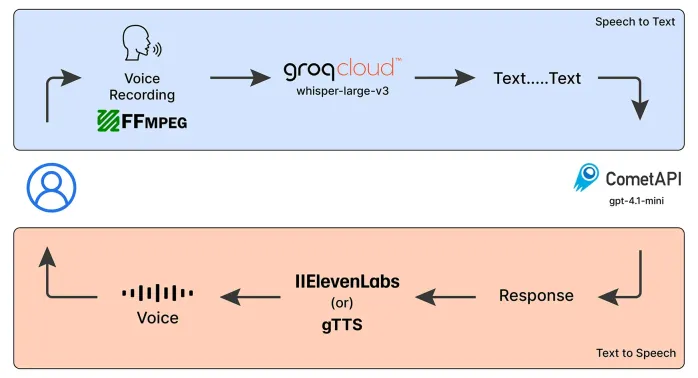

Notfallbetreiber Sprach -Chatbot: Unterstützung bei der UnterstützungMay 07, 2025 am 09:48 AM

Notfallbetreiber Sprach -Chatbot: Unterstützung bei der UnterstützungMay 07, 2025 am 09:48 AMSprachmodelle haben sich in der Welt schnell entwickelt. Jetzt ist es wichtig zu verstehen, wie wir die Funktionen dieses multimodalen Modells nutzen können

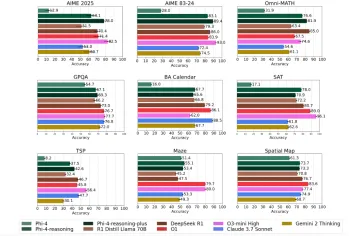

Die Phi-4-Argumentationsmodelle von Microsoft erklärten einfachMay 07, 2025 am 09:45 AM

Die Phi-4-Argumentationsmodelle von Microsoft erklärten einfachMay 07, 2025 am 09:45 AMMicrosoft ist nicht wie Openai, Google und Meta. Besonders nicht, wenn es um große Sprachmodelle geht. Während andere Tech -Giganten es vorziehen, mehrere Modelle zu starten, die die Benutzer mit Auswahlmöglichkeiten fast überwältigen. Microsoft startet einige,

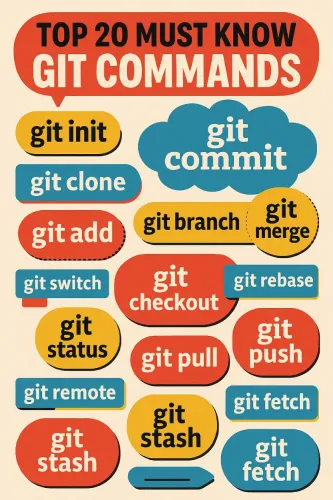

Top 20 Git -Befehle, die jeder Entwickler wissen sollte - Analytics VidhyaMay 07, 2025 am 09:44 AM

Top 20 Git -Befehle, die jeder Entwickler wissen sollte - Analytics VidhyaMay 07, 2025 am 09:44 AMGit kann sich wie ein Puzzle anfühlen, bis Sie die Schlüsselbewegungen lernen. In diesem Leitfaden finden Sie die Top 20 Git -Befehle, die dadurch bestellt werden, wie oft sie verwendet werden. Jeder Eintrag beginnt mit einer kurzen Zusammenfassung „Was es tut“, gefolgt von einer Bildanzeige

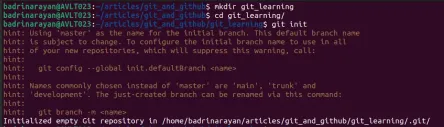

Git -Tutorial für AnfängerMay 07, 2025 am 09:36 AM

Git -Tutorial für AnfängerMay 07, 2025 am 09:36 AMIn der Softwareentwicklung kann das Verwalten von Code über mehrere Mitwirkende hinweg schneller werden. Stellen Sie sich vor, mehrere Personen bearbeiten das gleiche Dokument gleichzeitig, fügen jeweils neue Ideen hinzu, reparieren Fehler oder Optimierfunktionen. Ohne Struktur

Top 5 PDF zum Markdown -Konverter für mühelose Formatierung - Analytics VidhyaMay 07, 2025 am 09:21 AM

Top 5 PDF zum Markdown -Konverter für mühelose Formatierung - Analytics VidhyaMay 07, 2025 am 09:21 AMVerschiedene Formate wie PPTX, DOCX oder PDF zum Markdown -Konverter sind ein wesentliches Werkzeug für Inhaltautoren, Entwickler und Dokumentationsspezialisten. Wenn Sie die richtigen Werkzeuge haben

QWEN3 -Modelle: Zugriff, Funktionen, Anwendungen und mehrMay 07, 2025 am 09:18 AM

QWEN3 -Modelle: Zugriff, Funktionen, Anwendungen und mehrMay 07, 2025 am 09:18 AMQwen hat still ein Modell nach dem anderen hinzugefügt. Jedes seiner Modelle ist voller Merkmale und Größen, die so quantifiziert sind, dass es einfach unmöglich zu ignorieren ist. Nach QVQ, QWEN2.5-VL und QWEN2.5-OMNI in diesem Jahr die

Warum Sam Altman und andere jetzt Vibes als neues Messgerät für die neuesten Fortschritte in der KI verwendenMay 06, 2025 am 11:12 AM

Warum Sam Altman und andere jetzt Vibes als neues Messgerät für die neuesten Fortschritte in der KI verwendenMay 06, 2025 am 11:12 AMLassen Sie uns die steigende Verwendung von "Vibes" als Bewertungsmetrik im KI -Feld diskutieren. Diese Analyse ist Teil meiner laufenden Forbes -Spalte zu KI -Fortschritten und untersucht komplexe Aspekte der KI -Entwicklung (siehe Link hier). Stimmung in der AI -Bewertung Tradi

Innerhalb der Waymo -Fabrik baut eine Robotaxi -Zukunft aufMay 06, 2025 am 11:11 AM

Innerhalb der Waymo -Fabrik baut eine Robotaxi -Zukunft aufMay 06, 2025 am 11:11 AMWaymo's Arizona Factory: Massenproduzierende selbstfahrende Jaguare und darüber hinaus Waymo befindet sich in der Nähe von Phoenix, Arizona, und betreibt eine hochmoderne Einrichtung, in der die Flotte autonomer Jaguar I-Pace Electric SUVs produziert wird. Diese 239.000 Quadratmeter große Fabrik wurde eröffnet

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software