Mistral Ai Mischung 8x22b: Ein tiefes Eintauchen in die führende Open-Source-LLM

Im Jahr 2022 löste OpenAIS Chatgpt -Ankunft ein Rennen unter den Tech -Giganten aus, um wettbewerbsfähige Großsprachmodelle (LLMs) zu entwickeln. Mistral AI wurde als wichtiger Anwärter auf und startete 2023 ihr bahnbrechendes 7B-Modell und übertraf trotz seiner kleineren Größe alle vorhandenen Open-Source-LLMs. In diesem Artikel wird Mixtral 8x22b, die neueste Errungenschaft von Mistral AI, die Architektur untersucht und seine Verwendung in einer RA -Pipeline (Abruf Augmented Generation) vorgestellt.

Mixtral 8x22bs UnterscheidungsmerkmaleMixtral 8x22b, veröffentlicht im April 2024, verwendet eine spärliche Mischung aus Experten (Smoe) -Architecture mit 141 Milliarden Parametern. Dieser innovative Ansatz bietet erhebliche Vorteile:

- unerreichte Kosteneffizienz: Die Smoe-Architektur liefert ein außergewöhnliches Verhältnis von Leistung zu Kosten, wobei das Open-Source-Feld führt. Wie nachstehend dargestellt, erreicht es hohe Leistungsstufen unter Verwendung weit weniger aktiver Parameter als vergleichbare Modelle.

-

hohe Leistung und Geschwindigkeit: Während des Aufenthalts von 141 Milliarden Parametern verwendet das spärliche Aktivierungsmuster nur 39 Milliarden während der Inferenz und überschreitet die Geschwindigkeit von 70-Milliarden Parameter-dichten Modellen wie LLAMA 2 70B.

-

Erweitertes Kontextfenster: Eine seltene Funktion unter Open-Source-LLMs, Mixtral 8x22b bietet ein 64K-gepflegtes Kontextfenster.

-

zulässige Lizenz: Das Modell wird unter der Apache 2.0-Lizenz veröffentlicht, wobei die Zugänglichkeit und eine einfache Feinabstimmung fördert.

Mixtral 8x22b übertrifft konsequent führende Alternativen wie Lama 70b und Command R über verschiedene Benchmarks:

- Mehrsprachige Fähigkeiten: Englisch, Deutsch, Französisch, Spanisch und Italienisch, wie in den Benchmark -Ergebnissen gezeigt:

- Überlegene Leistung in Bezug auf Argumentation und Kenntnis: Es ist im gesunden Menschenverstand im gesunden Menschenverstand (Arc-C, Hellaswag, MMLU) und zeigt ein starkes englisches Verständnis.

- Außergewöhnliche Mathematik- und Codierungsfähigkeiten: MIMTRAL 8x22B übertrifft die Wettbewerber in mathematischen und codierenden Aufgaben erheblich.

Verständnis der Smoe Architecture

Die Smoe -Architektur ist analog zu einem Team von Spezialisten. Anstelle einer einzigen großen Modellverarbeitung alle Informationen verwendet Smoe kleinere Expertenmodelle, die sich jeweils auf bestimmte Aufgaben konzentrieren. Ein Routing -Netzwerk lenkt Informationen an die relevantesten Experten und verbessert die Effizienz und Genauigkeit. Dieser Ansatz bietet mehrere wichtige Vorteile:

- Verbesserte Effizienz: reduziert die Rechenkosten und beschleunigt die Verarbeitung.

- Verbesserte Skalierbarkeit: Fügen Sie einfach Experten hinzu, ohne sich auf das Training oder die Inferenz zu beeinflussen.

- Erhöhte Genauigkeit: Spezialisierung führt zu einer besseren Leistung bei bestimmten Aufgaben.

Herausforderungen im Zusammenhang mit Smoe -Modellen umfassen die Schulung Komplexität, Expertenauswahl und hohe Speicheranforderungen.

Erste Schritte mit Mixtral 8x22b

Verwenden von Mixtral 8x22b beinhaltet die Mistral -API:

- Konto Setup: Erstellen Sie ein Mistral -AI -Konto, fügen Sie Abrechnungsinformationen hinzu und erhalten Sie einen API -Schlüssel.

-

Umgebungsaufbau: Richten Sie eine virtuelle Umgebung mit Conda ein und installieren Sie die erforderlichen Pakete (Mistralai, Python-dotenv, Ipykernel). Speichern Sie Ihre API -Taste sicher in einer .env -Datei.

-

Verwenden Sie den Chat -Client: Verwenden Sie das Mistralclient -Objekt und die ChatMessage -Klasse, um mit dem Modell zu interagieren. Streaming ist für längere Antworten verfügbar.

Mixtral 8x22b -Anwendungen

jenseits der Textgenerierung, MixTral 8x22b aktiviert:

- Einbettungserzeugung: Erstellt Vektordarstellungen von Text für die semantische Analyse.

- Paraphrase -Erkennung: identifiziert ähnliche Sätze mithilfe von Einbettungsständen.

- Lag -Pipelines: integriert externe Wissensquellen, um die Reaktionsgenauigkeit zu verbessern.

- Funktionsaufruf: Vordefinierte Funktionen für strukturierte Ausgänge auslösend.

Der Artikel enthält detaillierte Beispiele für die Einbettungserzeugung, Paraphraserkennung und das Erstellen einer grundlegenden Lag -Pipeline unter Verwendung von Mixtral 8x22b und der Mistral -API. Das Beispiel verwendet einen Beispiel -News -Artikel, in dem es darstellt, wie man Text einstößt, Einbettung generiert, FAISS für die Ähnlichkeitssuche verwendet und eine Aufforderung für Mixtral 8x22b erstellt, um Fragen basierend auf dem abgerufenen Kontext zu beantworten.

Schlussfolgerung

Mixtral 8x22b stellt einen signifikanten Fortschritt in Open-Source-LLMs dar. Die Smoe -Architektur, die hohe Leistung und die zulässige Lizenz machen es zu einem wertvollen Instrument für verschiedene Anwendungen. Der Artikel bietet einen umfassenden Überblick über seine Fähigkeiten und die praktische Nutzung und fördert die weitere Erforschung des Potenzials durch die bereitgestellten Ressourcen.

Das obige ist der detaillierte Inhalt vonErste Schritte mit Mixtral 8x22b. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

7 Leistungsstarke KI fordert jeder Projektmanager auf, jetzt zu meisternMay 08, 2025 am 11:39 AM

7 Leistungsstarke KI fordert jeder Projektmanager auf, jetzt zu meisternMay 08, 2025 am 11:39 AMGenerative KI, beispielhaft von Chatbots wie ChatGPT, bietet Projektmanagern leistungsstarke Tools, um Workflows zu optimieren und sicherzustellen, dass Projekte im Zeitplan und im Budget bleiben. Ein effektiver Gebrauch ist jedoch das Erstellen der richtigen Eingabeaufforderungen an. Präzise, Detail

Definieren der schlecht definierten Bedeutung von schwer fassbarem AGI über die hilfreiche Unterstützung der KI selbstMay 08, 2025 am 11:37 AM

Definieren der schlecht definierten Bedeutung von schwer fassbarem AGI über die hilfreiche Unterstützung der KI selbstMay 08, 2025 am 11:37 AMDie Herausforderung, künstliche allgemeine Intelligenz (AGI) zu definieren, ist von Bedeutung. Ansprüche des AGI-Fortschritts fehlen häufig einen klaren Benchmark, wobei Definitionen auf die festgelegten Forschungsrichtungen zugeschnitten sind. Dieser Artikel untersucht einen neuartigen Ansatz für definitiv

IBM Think 2025 präsentiert Watsonx.Datas Rolle in der generativen KIMay 08, 2025 am 11:32 AM

IBM Think 2025 präsentiert Watsonx.Datas Rolle in der generativen KIMay 08, 2025 am 11:32 AMIBM Watsonx.data: Straffung des AI -Datenstapels Enterprise IBM positioniert Watsonx.data als eine entscheidende Plattform für Unternehmen, die darauf abzielen, die Bereitstellung präziser und skalierbarer generativer KI -Lösungen zu beschleunigen. Dies wird erreicht, indem die Beschwerde vereinfacht wird

Der Aufstieg der humanoiden Robotermaschinen nähert sich.May 08, 2025 am 11:29 AM

Der Aufstieg der humanoiden Robotermaschinen nähert sich.May 08, 2025 am 11:29 AMDie schnellen Fortschritte in der Robotik, die durch Durchbrüche in KI und Materialwissenschaft angetrieben werden, sind bereit, eine neue Ära humanoischer Roboter einzuleiten. Seit Jahren steht die industrielle Automatisierung im Hauptaugenmerk, aber die Fähigkeiten von Robotern sind schnell exponiert

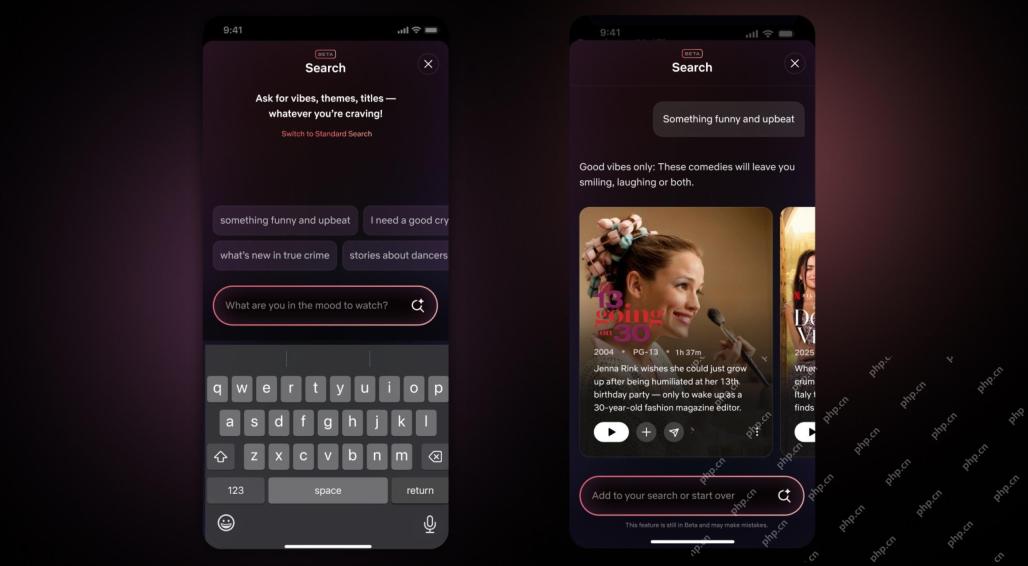

Netflix Revamps Interface-Debüt von KI-Suchwerkzeugen und Tiktok-ähnliches DesignMay 08, 2025 am 11:25 AM

Netflix Revamps Interface-Debüt von KI-Suchwerkzeugen und Tiktok-ähnliches DesignMay 08, 2025 am 11:25 AMDas größte Update der Netflix -Schnittstelle in einem Jahrzehnt: intelligentere, personalisierter, umarme Inhalte Netflix kündigte in einem Jahrzehnt seine größte Überarbeitung seiner Benutzeroberfläche an, nicht nur ein neues Erscheinungsbild, sondern fügt auch weitere Informationen zu jeder Show hinzu und führt intelligenteren KI -Suchwerkzeugen ein, die vage Konzepte wie "Umgebungsstoffe" und flexiblere Strukturen des Unternehmens verstehen können, um das Interesse des Unternehmens an aufstrebenden Videospielen, Live -Ereignissen, Sportveranstaltungen und anderen neuen Arten von Inhalten besser zu demonstrieren. Um mit dem Trend Schritt zu halten, erleichtert die neue vertikale Videokomponente auf Mobile den Fans, durch Trailer und Clips zu scrollen, die vollständige Show zu sehen oder Inhalte mit anderen zu teilen. Dies erinnert Sie an die unendliche Scrolling und die sehr erfolgreiche kurze Video -Website Ti

Lange vor AGI: Drei KI -Meilensteine, die Sie herausfordern werdenMay 08, 2025 am 11:24 AM

Lange vor AGI: Drei KI -Meilensteine, die Sie herausfordern werdenMay 08, 2025 am 11:24 AMDie wachsende Diskussion der allgemeinen Intelligenz (AGI) in künstlicher Intelligenz hat viele dazu veranlasst, darüber nachzudenken, was passiert, wenn künstliche Intelligenz die menschliche Intelligenz übertrifft. Ob dieser Moment in der Nähe oder weit entfernt ist, hängt davon ab, wen Sie fragen, aber ich denke nicht, dass es der wichtigste Meilenstein ist, auf den wir uns konzentrieren sollten. Welche früheren KI -Meilensteine betreffen alle? Welche Meilensteine wurden erreicht? Hier sind drei Dinge, von denen ich denke, dass sie passiert sind. Künstliche Intelligenz übertrifft die menschlichen Schwächen Im Film "Social Dilemma" 2022 wies Tristan Harris vom Zentrum für humane Technologie darauf hin, dass künstliche Intelligenz die menschlichen Schwächen übertroffen hat. Was bedeutet das? Dies bedeutet, dass künstliche Intelligenz Menschen benutzen konnte

Venkat Achanta über die Plattformtransformation von Transunion und KI -EhrgeizMay 08, 2025 am 11:23 AM

Venkat Achanta über die Plattformtransformation von Transunion und KI -EhrgeizMay 08, 2025 am 11:23 AMDie CTO von Transunion, Ranganath Achanta, führte eine bedeutende technologische Transformation an, seit er sich nach seinem Akquisition von Neustar Ende 2021 dem Unternehmen angeschlossen hat. Seine Führung von über 7.000 Mitarbeitern in verschiedenen Abteilungen hat sich auf u konzentriert

Wenn das Vertrauen in KI springt, folgt die ProduktivitätMay 08, 2025 am 11:11 AM

Wenn das Vertrauen in KI springt, folgt die ProduktivitätMay 08, 2025 am 11:11 AMDer Aufbau von Vertrauen ist für eine erfolgreiche KI -Einführung im Geschäft von größter Bedeutung. Dies gilt insbesondere angesichts des menschlichen Elements innerhalb von Geschäftsprozessen. Mitarbeiter, wie alle anderen, haben Bedenken hinsichtlich der KI und ihrer Umsetzung. Deloitte -Forscher sind SC

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen