Entsperren Sie die Kraft des Chunkking in der retrieval-generierten Generation (LAG): Ein tiefes Tauchgang

effizient verarbeiten große Mengen von Textdaten sind entscheidend für den Aufbau robuster und effektiver Systeme zur Erzeugung von Abrufs (RAG). In diesem Artikel werden verschiedene Chunking-Strategien untersucht, die für die Optimierung der Datenbearbeitung und die Verbesserung der Leistung von AI-betriebenen Anwendungen von entscheidender Bedeutung sind. Wir werden uns mit verschiedenen Ansätzen befassen, ihre Stärken und Schwächen hervorheben und praktische Beispiele anbieten.

Inhaltsverzeichnis

- Was ist in Lappen geknallt?

- Die Bedeutung des Knackens

- Verständnis von Lappenarchitektur und Chunking

- Häufige Herausforderungen mit Rag Systems

- Auswählen der optimalen Chunking -Strategie

- Zeichenbasierte Text-Chunking

- rekursive Charaktertextaufteilung mit Langchain

- dokumentspezifisches Chunking (HTML, Python, JSON usw.)

- semantisches Knacken mit Langchain und Openai

- agentisches Chunking (LLM-gesteuertes Chunking)

- Abschnittsbasierte Chunking

- Kontextbekämpfung für verbesserte Abruf

- spätes Knabgen für die Erhaltung des Langstreckenkontexts

- Schlussfolgerung

Was ist das Knochen im Lappen?

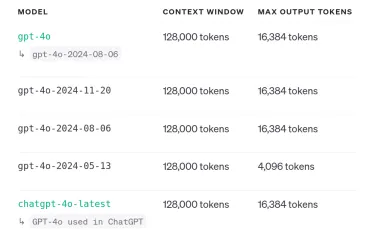

Chunking ist der Prozess der Aufteilung großer Textdokumente in kleinere, überschaubare Einheiten. Dies ist für Lappensysteme von wesentlicher Bedeutung, da Sprachmodelle nur begrenzte Kontextfenster haben. Das Chunking stellt sicher, dass relevante Informationen innerhalb dieser Grenzen bleiben, wodurch das Verhältnis von Signal-Rausch-Verhältnissen maximiert und die Modellleistung verbessert wird. Das Ziel ist es nicht nur, die Daten aufzuteilen, sondern seine Präsentation für das Modell für verbesserte Abrufen und Genauigkeit zu optimieren.

Warum ist das Knacken wichtig?

Anton Troynikov, Mitbegründer von Chroma, betont, dass irrelevante Daten im Kontextfenster die Anwendungseffektivität erheblich verringern. Chunking ist von entscheidender Bedeutung für:

- Überwindung der Kontextfensterbeschränkungen: stellt sicher, dass die Schlüsselinformationen aufgrund von Größenbeschränkungen nicht verloren gehen.

- Verbesserung des Signal-Rausch-Verhältnisses: filtert irrelevante Inhalte, Verbesserung der Modellgenauigkeit.

- Steigerung der Effizienz des Abrufs: erleichtert schneller und präziser Abruf von relevanten Informationen.

- aufgabenspezifische Optimierung: Ermöglicht die Anpassung von Chunking-Strategien auf bestimmte Anwendungsanforderungen (z. B. Zusammenfassung vs. Fragen-Antworten).

RAG -Architektur und Chunking

Die Lag -Architektur umfasst drei wichtige Phasen:

- Chunking: Rohdaten werden in kleinere, aussagekräftige Stücke aufgeteilt.

- Einbettung: Stücke werden in Vektor -Einbettungen umgewandelt.

- Abrufen & Generation: relevante Teile werden basierend auf Benutzeranfragen abgerufen, und das LLM generiert eine Antwort unter Verwendung der abgerufenen Informationen.

Herausforderungen in RAG -Systemen

RAG -Systeme stehen vor verschiedenen Herausforderungen:

- Abrufenprobleme: ungenau oder unvollständiges Abrufen relevanter Informationen.

- Erzeugungsschwierigkeiten: Halluzinationen, irrelevante oder voreingenommene Ausgänge.

- Integrationsprobleme: Schwierigkeiten, abgerufene Informationen kohärent zu kombinieren.

Auswählen der richtigen Chunking -Strategie

Die ideale Chunking -Strategie hängt von mehreren Faktoren ab: Inhaltstyp, Einbettungsmodell und erwartete Benutzeranfragen. Betrachten Sie die Struktur und Dichte des Inhalts, die Token -Einschränkungen des Einbettungsmodells und die Arten von Fragen, die Benutzer wahrscheinlich stellen.

1. Zeichenbasierte Text-Chunking

Diese einfache Methode spaltet den Text in fester Größe in fester Größe auf der Grundlage der Zeichenzahl, unabhängig von der semantischen Bedeutung. Obwohl es unkompliziert ist, stört es die Satzstruktur und den Kontext häufig. Beispiel mit Python:

text = "Clouds come floating into my life..." chunks = [] chunk_size = 35 chunk_overlap = 5 # ... (Chunking logic as in the original example)

2. Rekursive Charaktertextaufteilung mit Langchain

Dieser Ansatz spaltet den Text rekursiv mit mehreren Separatoren (z. B. Doppel -Newlines, Einzelneulinien, Räumen) und verschmilzt kleinere Teile, um eine Zielzeichengröße zu optimieren. Es ist anspruchsvoller als charakterbasiertes Chunking und bietet einen besseren Kontext-Erhalt. Beispiel mit Langchain:

# ... (LangChain installation and code as in the original example)

3. Dokumentspezifisches Chunking

Diese Methode passt das Chunking an verschiedene Dokumentformate (HTML, Python, Markdown usw.) unter Verwendung formalspezifischer Separatoren an. Dies stellt sicher, dass das Chunking die inhärente Struktur des Dokuments respektiert. Beispiele mit Langchain für Python und Markdown sind in der ursprünglichen Antwort bereitgestellt.

4. Semantisches Chunking mit Langchain und Openai

Semantisches Chunking teilt Text basierend auf semantischer Bedeutung unter Verwendung von Techniken wie Satzeinbettungen, um natürliche Haltepunkte zu identifizieren. Dieser Ansatz stellt sicher, dass jeder Chunk eine kohärente Idee darstellt. Beispiel unter Verwendung von Langchain und OpenAI -Einbettungen:

# ... (OpenAI API key setup and code as in the original example)

5. Agenten-Chunking (LLM-gesteuertes Chunking)

Agentic Chunking verwendet ein LLM, um natürliche Breakpoints im Text zu identifizieren, was zu kontextuell relevanteren Stücken führt. Dieser Ansatz nutzt das Verständnis der LLM von Sprache und Kontext, um sinnvollere Segmente zu erzeugen. Beispiel mit OpenAI -API:

text = "Clouds come floating into my life..." chunks = [] chunk_size = 35 chunk_overlap = 5 # ... (Chunking logic as in the original example)

6. Abschnittsbasierte Chunking

Diese Methode nutzt die inhärente Struktur des Dokuments (Überschriften, Unterblätter, Abschnitte), um Stücke zu definieren. Es ist besonders effektiv für gut strukturierte Dokumente wie Forschungsarbeiten oder Berichte. Beispiel mit PYMUPDF und Latent Dirichlet Allocation (LDA) für themenbasiertes Chunking:

# ... (LangChain installation and code as in the original example)

7. Kontextbezogenes Chunking

Kontextbekämpfung konzentriert sich auf die Erhaltung des semantischen Kontextes in jedem Stück. Dies stellt sicher, dass die abgerufenen Informationen kohärent und relevant sind. Beispiel mit Langchain und einer benutzerdefinierten Eingabeaufforderung:

# ... (OpenAI API key setup and code as in the original example)

8. Spätes Chunking

spätes Chunking verzögert das Knacken bis nach der Erzeugung von Einbettungen für das gesamte Dokument. Dies bewahrt langfristige kontextbezogene Abhängigkeiten und verbessert die Genauigkeit von Einbettungen und Abruf. Beispiel unter Verwendung des Jina -Embodings -Modells:

# ... (OpenAI API key setup and code as in the original example)

Schlussfolgerung

effektives Chunking ist für den Aufbau leistungsfähiger Lappensysteme von größter Bedeutung. Die Auswahl der Chunking -Strategie wirkt sich erheblich auf die Qualität des Informationsabrufs und die Kohärenz der generierten Antworten aus. Durch die sorgfältige Prüfung der Merkmale der Daten und die spezifischen Anforderungen der Anwendung können Entwickler die am besten geeignete Chunking -Methode auswählen, um die Leistung ihres Lappensystems zu optimieren. Denken Sie daran, die Aufrechterhaltung der kontextuellen Integrität und Relevanz in jedem Chunk immer priorisieren.

Das obige ist der detaillierte Inhalt von8 Arten von Chunking für RAG -Systeme - Analytics Vidhya. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

![Kann Chatgpt nicht verwenden! Erklären Sie die Ursachen und Lösungen, die sofort getestet werden können [die neueste 2025]](https://img.php.cn/upload/article/001/242/473/174717025174979.jpg?x-oss-process=image/resize,p_40) Kann Chatgpt nicht verwenden! Erklären Sie die Ursachen und Lösungen, die sofort getestet werden können [die neueste 2025]May 14, 2025 am 05:04 AM

Kann Chatgpt nicht verwenden! Erklären Sie die Ursachen und Lösungen, die sofort getestet werden können [die neueste 2025]May 14, 2025 am 05:04 AMChatgpt ist nicht zugänglich? Dieser Artikel bietet eine Vielzahl von praktischen Lösungen! Viele Benutzer können auf Probleme wie Unzugänglichkeit oder langsame Reaktion stoßen, wenn sie täglich ChatGPT verwenden. In diesem Artikel werden Sie geführt, diese Probleme Schritt für Schritt basierend auf verschiedenen Situationen zu lösen. Ursachen für Chatgpts Unzugänglichkeit und vorläufige Fehlerbehebung Zunächst müssen wir feststellen, ob sich das Problem auf der OpenAI -Serverseite oder auf dem eigenen Netzwerk- oder Geräteproblemen des Benutzers befindet. Bitte befolgen Sie die folgenden Schritte, um Fehler zu beheben: Schritt 1: Überprüfen Sie den offiziellen Status von OpenAI Besuchen Sie die OpenAI -Statusseite (status.openai.com), um festzustellen, ob der ChatGPT -Dienst normal ausgeführt wird. Wenn ein roter oder gelber Alarm angezeigt wird, bedeutet dies offen

Die Berechnung des Risikos des ASI beginnt mit dem menschlichen GeistMay 14, 2025 am 05:02 AM

Die Berechnung des Risikos des ASI beginnt mit dem menschlichen GeistMay 14, 2025 am 05:02 AMAm 10. Mai 2025 teilte der MIT-Physiker Max Tegmark dem Guardian mit, dass AI Labs Oppenheimers Dreifaltigkeitstestkalkül emulieren sollten, bevor sie künstliche Super-Intelligence veröffentlichen. „Meine Einschätzung ist, dass die 'Compton Constant', die Wahrscheinlichkeit, dass ein Rennen ums Rasse

Eine leicht verständliche Erklärung zum Schreiben und Komponieren von Texten und empfohlenen Tools in ChatgptMay 14, 2025 am 05:01 AM

Eine leicht verständliche Erklärung zum Schreiben und Komponieren von Texten und empfohlenen Tools in ChatgptMay 14, 2025 am 05:01 AMDie KI -Musikkreationstechnologie verändert sich mit jedem Tag. In diesem Artikel werden AI -Modelle wie ChatGPT als Beispiel verwendet, um ausführlich zu erklären, wie mit AI die Erstellung der Musik unterstützt und sie mit tatsächlichen Fällen erklärt. Wir werden vorstellen, wie man Musik durch Sunoai, Ai Jukebox auf Umarmung und Pythons Music21 -Bibliothek kreiert. Mit diesen Technologien kann jeder problemlos Originalmusik erstellen. Es ist jedoch zu beachten, dass das Urheberrechtsproblem von AI-generierten Inhalten nicht ignoriert werden kann, und Sie müssen bei der Verwendung vorsichtig sein. Lassen Sie uns die unendlichen Möglichkeiten der KI im Musikfeld zusammen erkunden! OpenAIs neuester AI -Agent "Openai Deep Research" führt vor: [CHATGPT] ope

Was ist Chatgpt-4? Eine gründliche Erklärung für das, was Sie tun können, die Preisgestaltung und die Unterschiede von GPT-3.5!May 14, 2025 am 05:00 AM

Was ist Chatgpt-4? Eine gründliche Erklärung für das, was Sie tun können, die Preisgestaltung und die Unterschiede von GPT-3.5!May 14, 2025 am 05:00 AMDie Entstehung von Chatgpt-4 hat die Möglichkeit von AI-Anwendungen erheblich erweitert. Im Vergleich zu GPT-3,5 hat sich ChatGPT-4 erheblich verbessert. Es verfügt über leistungsstarke Kontextverständnisfunktionen und kann auch Bilder erkennen und generieren. Es ist ein universeller AI -Assistent. Es hat in vielen Bereichen ein großes Potenzial gezeigt, z. B. die Verbesserung der Geschäftseffizienz und die Unterstützung der Schaffung. Gleichzeitig müssen wir jedoch auch auf die Vorsichtsmaßnahmen ihrer Verwendung achten. In diesem Artikel werden die Eigenschaften von ChatGPT-4 im Detail erläutert und effektive Verwendungsmethoden für verschiedene Szenarien einführt. Der Artikel enthält Fähigkeiten, um die neuesten KI -Technologien voll auszunutzen. Weitere Informationen finden Sie darauf. OpenAIs neueste AI -Agentin, klicken Sie auf den Link unten, um Einzelheiten zu "OpenAI Deep Research" zu erhalten.

Erklären Sie, wie Sie die Chatgpt -App verwenden! Japanische Unterstützung und SprachkonversationsfunktionMay 14, 2025 am 04:59 AM

Erklären Sie, wie Sie die Chatgpt -App verwenden! Japanische Unterstützung und SprachkonversationsfunktionMay 14, 2025 am 04:59 AMCHATGPT -App: Entfesselt Ihre Kreativität mit dem AI -Assistenten! Anfängerführer Die ChatGPT -App ist ein innovativer KI -Assistent, der eine breite Palette von Aufgaben erledigt, einschließlich Schreiben, Übersetzung und Beantwortung von Fragen. Es ist ein Werkzeug mit endlosen Möglichkeiten, die für kreative Aktivitäten und Informationssammeln nützlich sind. In diesem Artikel werden wir für Anfänger eine leicht verständliche Weise von der Installation der ChatGPT-Smartphone-App bis hin zu den Funktionen für Apps wie Spracheingangsfunktionen und Plugins sowie die Punkte erklären, die Sie bei der Verwendung der App berücksichtigen sollten. Wir werden auch die Pluginbeschränkungen und die Konfiguration der Geräte-zu-Device-Konfiguration genauer betrachten

Wie benutze ich die chinesische Version von Chatgpt? Erläuterung der Registrierungsverfahren und GebührenMay 14, 2025 am 04:56 AM

Wie benutze ich die chinesische Version von Chatgpt? Erläuterung der Registrierungsverfahren und GebührenMay 14, 2025 am 04:56 AMChatgpt Chinesische Version: Schalte neue Erfahrung des chinesischen KI -Dialogs frei Chatgpt ist weltweit beliebt. Wussten Sie, dass es auch eine chinesische Version bietet? Dieses leistungsstarke KI -Tool unterstützt nicht nur tägliche Gespräche, sondern behandelt auch professionelle Inhalte und ist mit vereinfachtem und traditionellem Chinesisch kompatibel. Egal, ob es sich um einen Benutzer in China oder ein Freund, der Chinesisch lernt, Sie können davon profitieren. In diesem Artikel wird detailliert eingeführt, wie die chinesische ChatGPT -Version verwendet wird, einschließlich der Kontoeinstellungen, der Eingabeaufgabe der chinesischen Eingabeaufforderung, der Filtergebrauch und der Auswahl verschiedener Pakete sowie potenziellen Risiken und Antwortstrategien. Darüber hinaus werden wir die chinesische Chatgpt -Version mit anderen chinesischen KI -Tools vergleichen, um die Vorteile und Anwendungsszenarien besser zu verstehen. Openais neueste KI -Intelligenz

5 KI -Agent -Mythen, die Sie jetzt aufhören müssen, zu glaubenMay 14, 2025 am 04:54 AM

5 KI -Agent -Mythen, die Sie jetzt aufhören müssen, zu glaubenMay 14, 2025 am 04:54 AMDiese können als der nächste Sprung nach vorne im Bereich der generativen KI angesehen werden, was uns Chatgpt und andere Chatbots mit großer Sprache modellierte. Anstatt nur Fragen zu beantworten oder Informationen zu generieren, können sie in unserem Namen Maßnahmen ergreifen, Inter

Eine leicht verständliche Erklärung für die Illegalität des Erstellens und Verwalten mehrerer Konten mit ChatGPTMay 14, 2025 am 04:50 AM

Eine leicht verständliche Erklärung für die Illegalität des Erstellens und Verwalten mehrerer Konten mit ChatGPTMay 14, 2025 am 04:50 AMEffiziente Mehrfachkontoverwaltungstechniken mit Chatgpt | Eine gründliche Erklärung, wie man Geschäft und Privatleben nutzt! Chatgpt wird in verschiedenen Situationen verwendet, aber einige Leute machen sich möglicherweise Sorgen über die Verwaltung mehrerer Konten. In diesem Artikel wird ausführlich erläutert, wie mehrere Konten für ChatGPT, was zu tun ist, wenn Sie es verwenden und wie Sie es sicher und effizient bedienen. Wir decken auch wichtige Punkte wie den Unterschied in der Geschäfts- und Privatnutzung sowie die Einhaltung der Nutzungsbedingungen von OpenAI ab und bieten einen Leitfaden zur Verfügung, mit dem Sie mehrere Konten sicher verwenden können. Openai

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

ZendStudio 13.5.1 Mac

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software