Tiefes neuronales Netzwerktraining steht häufig vor Hürden wie Verschwinden/explodierender Gradienten und interner kovariater Verschiebung, Verlangsamung von Training und Behinderung des Lernens. Normalisierungstechniken bieten eine Lösung, wobei die Batch -Normalisierung (BN) besonders prominent ist. BN beschleunigt die Konvergenz, verbessert die Stabilität und verbessert die Verallgemeinerung in vielen Architekturen für tiefe Lernen. Dieses Tutorial erklärt die Mechanik von BN, seine mathematischen Grundlagen und Tensorflow/Keras -Implementierung.

Normalisierung im maschinellen Lernen standardisiert Eingabedaten mit Methoden wie Min-Max-Skalierung, Z-Score-Normalisierung und logarithmischen Transformationen zu den Umschlüssen. Dies mindert Ausreißereffekte, verbessert die Konvergenz und sorgt für einen fairen Merkmalsvergleich. Normalisierte Daten sorgen für einen gleichen Merkmalsbeitrag zum Lernprozess, wodurch verhindern, dass größere Merkmale dominieren und zu einer suboptimalen Modellleistung führen. Es ermöglicht das Modell, sinnvolle Muster effektiver zu identifizieren.

Herausforderungen bei Deep Learning Training gehören:

- interne kovariate Verschiebung: Verteilungsänderungen für Aktivierungen während des Trainings, die Behinderung der Anpassung und des Lernens. . .

- Verschwinden/explodierende Gradienten: Gradienten werden während der Rückpropagation zu klein oder zu groß und behindern effektive Gewichtsaktualisierungen.

- Initialisierungsempfindlichkeit: Anfangsgewichte beeinflussen das Training stark; Eine schlechte Initialisierung kann zu langsamer oder fehlgeschlagener Konvergenz führen.

Die Batch-Normalisierung befasst sich durch die Normalisierung von Aktivierungen in jedem Mini-Batch, Stabilisierung der Schulung und Verbesserung der Modellleistung.

Stapel-Normalisierung normalisiert die Aktivierungen einer Schicht innerhalb eines Mini-Batch während des Trainings. Es berechnet den Mittelwert und die Varianz von Aktivierungen für jedes Merkmal und normalisiert dann mit diesen Statistiken. Lernbare Parameter (γ und β) Skala und verschieben die normalisierten Aktivierungen, sodass das Modell die optimale Aktivierungsverteilung lernen kann.

Quelle: Yintai Ma und Diego Klabjan.

bn wird typischerweise nach der linearen Transformation einer Schicht (z. B. Matrixmultiplikation in vollständig verbundenen Schichten oder Faltung in Faltungsschichten) und vor der nichtlinearen Aktivierungsfunktion (z. B. Relu) angewendet. Schlüsselkomponenten sind Mini-Batch-Statistiken (Mittelwert und Varianz), Normalisierung und Skalierung/Verschiebung mit lernbaren Parametern.

bn adressiert die interne kovariate Verschiebung durch Normalisierung von Aktivierungen in jedem Mini-Batch, wodurch Eingaben zu nachfolgenden Schichten stabiler werden. Dies ermöglicht eine schnellere Konvergenz mit höheren Lernraten und reduziert die Initialisierungsempfindlichkeit. Es wird auch reguliert, wodurch Überanpassung durch Verringerung der Abhängigkeit von spezifischen Aktivierungsmustern verhindert wird.

Mathematik der Stapelnormalisierung:

bn funktioniert während des Trainings und der Inferenz unterschiedlich.

Training:

- Normalisierung: Mittelwert (μ b ) und Varianz (σ b 2 ) werden für jedes Merkmal in einem Mini-Batch berechnet:

Aktivierungen (x i ) werden normalisiert:

(ε ist eine kleine Konstante für die numerische Stabilität).

- Skalierung und Verschiebung: Lernbare Parameter γ und β -Skala und Verschiebung:

Inferenz: Stapelstatistiken werden durch laufende Statistiken (laufender Mittel und Varianz) ersetzt, berechnet während des Trainings mit einem gleitenden Durchschnitt (Impulsfaktor α):

Diese laufenden Statistiken und die gelernten γ und β werden zur Normalisierung während der Inferenz verwendet.

TensorFlow -Implementierung:

import tensorflow as tf

from tensorflow import keras

# Load and preprocess MNIST data (as described in the original text)

# ...

# Define the model architecture

model = keras.Sequential([

keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

keras.layers.BatchNormalization(),

keras.layers.Conv2D(64, (3, 3), activation='relu'),

keras.layers.BatchNormalization(),

keras.layers.MaxPooling2D((2, 2)),

keras.layers.Flatten(),

keras.layers.Dense(128, activation='relu'),

keras.layers.BatchNormalization(),

keras.layers.Dense(10, activation='softmax')

])

# Compile and train the model (as described in the original text)

# ...

Implementierungsüberlegungen:

- Platzierung: Nach linearen Transformationen und vor Aktivierungsfunktionen.

- Stapelgröße: Größere Chargengrößen bieten genauere Stapelstatistiken.

- Regularisierung: bn führt einen Regularisierungseffekt ein.

Einschränkungen und Herausforderungen:

- Nicht-konvolutionelle Architekturen: Die Wirksamkeit von BN wird in RNNs und Transformatoren verringert.

- Kleine Stapelgrößen: Weniger zuverlässige Stapelstatistik.

- Rechenaufwand: Erhöhte Speicher- und Trainingszeit.

mildernde Einschränkungen: Adaptive Stapel -Normalisierung, virtuelle Stapel -Normalisierung und Hybridnormalisierungstechniken können einige Einschränkungen angehen.

Varianten und Erweiterungen: Schichtnormalisierung, Gruppennormalisierung, Instanznormalisierung, Stapel -Renormierung und Gewichtnormalisierung bieten Abhängigkeiten von den spezifischen Bedürfnissen.

Alternativen oder Verbesserungen.Schlussfolgerung: Die Stapelnormalisierung ist eine leistungsstarke Technik, die das tiefe Training für neuronale Netzwerke verbessert. Denken Sie an seine Vorteile, Implementierungsdetails und Einschränkungen und berücksichtigen Sie seine Varianten für eine optimale Leistung in Ihren Projekten.

Das obige ist der detaillierte Inhalt vonBatch -Normalisierung: Theorie und Tensorflow -Implementierung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Teslas Robovan war das versteckte Juwel im Robotaxi -Teaser 2024Apr 22, 2025 am 11:48 AM

Teslas Robovan war das versteckte Juwel im Robotaxi -Teaser 2024Apr 22, 2025 am 11:48 AMSeit 2008 habe ich mich für den Shared-Bride-Van eingesetzt, der als "Robotjitney" als "Vansit" als Zukunft des städtischen Transports bezeichnet wurde. Ich sehe diese Fahrzeuge als Transitlösung der nächsten Generation des 21. Jahrhunderts, Surpas, voraus

Sam's Club -Wetten auf KI zur Beseitigung von Quittungsprüfungen und zur Verbesserung des EinzelhandelsApr 22, 2025 am 11:29 AM

Sam's Club -Wetten auf KI zur Beseitigung von Quittungsprüfungen und zur Verbesserung des EinzelhandelsApr 22, 2025 am 11:29 AMRevolutionieren die Erfahrung im Checkout Der innovative "Just Go" -System von Sam's Club baut auf seiner vorhandenen KI-angetriebenen "Scan & Go" -Technologie auf und ermöglicht es den Mitgliedern, während ihres Einkaufsbaus Einkäufe über die Sam's Club-App zu scannen.

Die AI -Omniverse von Nvidia erweitert sich bei GTC 2025Apr 22, 2025 am 11:28 AM

Die AI -Omniverse von Nvidia erweitert sich bei GTC 2025Apr 22, 2025 am 11:28 AMVerbesserte Vorhersehbarkeit und neue Produktaufstellung von NVIDIA bei GTC 2025 Nvidia, ein wichtiger Akteur in der KI -Infrastruktur, konzentriert sich auf eine erhöhte Vorhersagbarkeit seiner Kunden. Dies beinhaltet eine konsequente Produktlieferung, die Erwartung der Leistungsverwaltung und die Erfüllung der Leistungsverwalter und beinhaltet

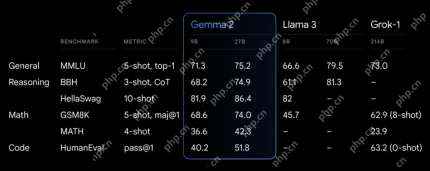

Erkundung der Funktionen der Gemma 2 -Modelle von Google.Apr 22, 2025 am 11:26 AM

Erkundung der Funktionen der Gemma 2 -Modelle von Google.Apr 22, 2025 am 11:26 AMGoogles Gemma 2: Ein leistungsstarkes, effizientes Sprachmodell Die Gemma-Familie von Google von Sprachmodellen, die für Effizienz und Leistung gefeiert wurde

Die nächste Welle von Genai: Perspektiven mit Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

Die nächste Welle von Genai: Perspektiven mit Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMDiese Führung mit Daten -Episode zeigt Dr. Kirk Borne, einen führenden Datenwissenschaftler, Astrophysiker und TEDX -Sprecher. Dr. Borne, ein renommierter Experte für Big Data, KI und maschinelles Lernen, bietet unschätzbare Einblicke in den aktuellen Zustand und den zukünftigen Traje

KI für Läufer und Sportler: Wir machen hervorragende FortschritteApr 22, 2025 am 11:12 AM

KI für Läufer und Sportler: Wir machen hervorragende FortschritteApr 22, 2025 am 11:12 AMEs gab einige sehr aufschlussreiche Perspektiven in dieser Rede - Background -Informationen über Ingenieurwesen, die uns zeigten, warum künstliche Intelligenz so gut darin ist, die körperliche Bewegung der Menschen zu unterstützen. Ich werde eine Kernidee aus der Perspektive jedes Mitwirkenden skizzieren, um drei Designaspekte zu demonstrieren, die ein wichtiger Bestandteil unserer Erforschung der Anwendung künstlicher Intelligenz im Sport sind. Edge -Geräte und rohe personenbezogene Daten Diese Vorstellung von künstlicher Intelligenz enthält tatsächlich zwei Komponenten - eine, die sich darauf bezieht, wo wir große Sprachmodelle platzieren, und die andere hängt mit den Unterschieden zwischen unserer menschlichen Sprache und der Sprache zusammen, die unsere Vitalfunktionen „ausdrücken“, wenn sie in Echtzeit gemessen werden. Alexander Amini weiß viel über Laufen und Tennis, aber er immer noch

Jamie Engstrom über Technologie, Talent und Transformation bei CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom über Technologie, Talent und Transformation bei CaterpillarApr 22, 2025 am 11:10 AMJamie Engstrom, Chief Information Officer und Senior Vice President It, leitet ein globales Team von über 2.200 IT -Fachleuten in 28 Ländern. Mit 26 Jahren in Caterpillar, darunter viereinhalb Jahre in ihrer gegenwärtigen Rolle, Engst

Neues Google -Fotos Update macht ein Foto mit Ultra HDR -Qualität PopApr 22, 2025 am 11:09 AM

Neues Google -Fotos Update macht ein Foto mit Ultra HDR -Qualität PopApr 22, 2025 am 11:09 AMDas neue Ultra HDR -Tool von Google Photos: Eine schnelle Anleitung Verbessern Sie Ihre Fotos mit dem neuen Ultra HDR-Tool von Google Photos und verwandeln Sie Standardbilder in lebendige Meisterwerke mit hohem Dynamik. Dieses Tool ist ideal für soziale Medien und steigert die Auswirkungen eines Fotos.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version