olmo 2: Eine leistungsstarke Open-Source-LLM für zugängliche AI

Das Gebiet der natürlichen Sprachverarbeitung (NLP) verzeichnete schnelle Fortschritte, insbesondere bei großen Sprachmodellen (LLMs). Während proprietäre Modelle historisch dominiert haben, schließen Open-Source-Alternativen die Lücke schnell. OLMO 2 stellt einen signifikanten Sprung nach vorne dar und bietet eine Leistung, die mit Closed-Source-Modellen vergleichbar ist und gleichzeitig die vollständige Transparenz und Zugänglichkeit beibehält. Dieser Artikel befasst sich mit Olmo 2 und untersucht seine Ausbildung, Leistung und praktische Anwendung.

Schlüssellernen:

- erfassen die Bedeutung von Open-Source-LLMs und Olmo 2s Beitrag zur AI-Forschung.

- Verstehen Sie die Architektur-, Trainingsmethoden von OLMO 2 und die Benchmark -Ergebnisse.

- Unterscheiden Sie zwischen offenem, teilweise offenem und vollständig geöffnetem Modellarchitekturen.

- Lernen Sie, Olmo 2 lokal mit Gradio und Langchain auszuführen.

- Erstellen Sie eine Chatbot -Anwendung mit OLMO 2 mit Python -Code -Beispielen.

(Dieser Artikel ist Teil des Datenwissenschaftsblogathons.)

Inhaltsverzeichnis:

- Die Notwendigkeit von Open-Source-LLMs

- Einführung von Olmo 2

- Dekonstruktion des Trainings von Olmo 2

- Erforschung der Fähigkeiten von Olmo 2

- Erstellen eines Chatbots mit Olmo 2

- Schlussfolgerung

- häufig gestellte Fragen

Die Nachfrage nach Open-Source-LLMs

Die anfängliche Dominanz von proprietären LLMs äußerte Bedenken hinsichtlich Zugänglichkeit, Transparenz und Voreingenommenheit. Open-Source LLMs befassen sich mit diesen Problemen, indem sie die Zusammenarbeit fördert und die Prüfung, Änderung und Verbesserung ermöglicht. Dieser offene Ansatz ist von entscheidender Bedeutung, um das Feld voranzutreiben und einen gerechten Zugang zur LLM -Technologie zu gewährleisten.

Das Olmo -Projekt von Allen Institute for AI (AI2) veranschaulicht dieses Engagement. Olmo 2 geht über die einfache Freisetzung von Modellgewichten hinaus; Es bietet die Schulungsdaten, Code, Schulungsrezepte, Zwischenprüfpunkte und Anweisungsmodelle. Diese umfassende Veröffentlichung fördert die Reproduzierbarkeit und weitere Innovation.

olmo 2

verstehenolmo 2 verbessert sich signifikant auf seinen Vorgänger OLMO-0424. Die Parametermodelle von 7B und 13B zeigen die Leistung, die mit oder übertroffenen, ähnlich offenen Modellen vergleichbar ist oder überschreiten, sogar mit offenen Modellen wie Lama 3.1 auf englischen akademischen Benchmarks-eine bemerkenswerte Leistung unter Berücksichtigung der reduzierten Trainingsflops.

wichtige Verbesserungen umfassen:

- Wesentliche Leistungssteigerungen: olmo-2 (7b und 13b) zeigt eine deutliche Verbesserung gegenüber früheren OLMO-Modellen, was auf Fortschritte in der Architektur-, Daten- oder Schulungsmethode hinweist.

- wettbewerbsfähig mit MAP-NEO-7B: olmo-2, insbesondere der 13b-Version, erzielt mit MAP-NEO-7B vergleichbar, eine starke Grundlinie unter vollständig offenen Modellen.

olmo 2's Trainingsmethodik

Die Architektur vonOlmo 2 baut auf dem ursprünglichen Olmo auf und enthält Verfeinerungen für eine verbesserte Stabilität und Leistung. Der Schulungsprozess umfasst zwei Phasen:

- Foundation Training: Verwendet den Olmo-Mix-1124-Datensatz (ungefähr 3,9 Billionen Token aus verschiedenen offenen Quellen), um eine robuste Grundlage für das Sprachverständnis zu schaffen.

- Verfeinerung und Spezialisierung: verwendet den Datensatz von Dolmino-MIX-1124, eine kuratierte Mischung aus hochwertigen Webdaten und domänenspezifischen Daten (akademische Inhalte, Q & A-Foren, Unterrichtsdaten, Mathematik-Arbeitsbücher), um das Wissen und die Fähigkeiten des Modells zu verfeinern. "Modellsubing" verbessert den endgültigen Checkpoint weiter.

Offenheit in LLMs

Da OLMO-2 ein vollständig geöffnetes Modell ist, klären wir die Unterscheidungen zwischen verschiedenen Ebenen der Modelloffenheit:

- Open-Gewicht-Modelle: Nur die Modellgewichte werden freigegeben.

- teilweise geöffnete Modelle: einige zusätzliche Informationen über die Gewichte hinaus veröffentlichen, aber kein vollständiges Bild des Trainingsprozesses.

- Voll öffne Modelle: Geben Sie eine vollständige Transparenz an, einschließlich Gewichte, Trainingsdaten, Code, Rezepte und Kontrollpunkten. Dies ermöglicht eine vollständige Reproduzierbarkeit.

Eine Tabelle, die die Schlüsselunterschiede zusammenfasst, finden Sie unten.

| Feature | Open Weight Models | Partially Open Models | Fully Open Models |

|---|---|---|---|

| Weights | Released | Released | Released |

| Training Data | Typically Not | Partially Available | Fully Available |

| Training Code | Typically Not | Partially Available | Fully Available |

| Training Recipe | Typically Not | Partially Available | Fully Available |

| Reproducibility | Limited | Moderate | Full |

| Transparency | Low | Medium | High |

Erforschen und Ausführen von Olmo 2 lokal

olmo 2 ist leicht zugänglich. Anweisungen zum Herunterladen des Modells und der Daten sowie der Trainingscode und der Bewertungsmetriken sind verfügbar. Verwenden Sie Ollama, um Olmo 2 lokal zu leiten. Führen Sie nach der Installation einfach ollama run olmo2:7b in Ihrer Befehlszeile aus. Notwendige Bibliotheken (Langchain und Gradio) können über Pip.

Erstellen eines Chatbots mit Olmo 2

Der folgende Python -Code zeigt, dass ein Chatbot mit Olmo 2, Gradio und Langchain:

erstellt wird:import gradio as gr

from langchain_core.prompts import ChatPromptTemplate

from langchain_ollama.llms import OllamaLLM

def generate_response(history, question):

template = """Question: {question}

Answer: Let's think step by step."""

prompt = ChatPromptTemplate.from_template(template)

model = OllamaLLM(model="olmo2")

chain = prompt | model

answer = chain.invoke({"question": question})

history.append({"role": "user", "content": question})

history.append({"role": "assistant", "content": answer})

return history

with gr.Blocks() as iface:

chatbot = gr.Chatbot(type='messages')

with gr.Row():

with gr.Column():

txt = gr.Textbox(show_label=False, placeholder="Type your question here...")

txt.submit(generate_response, [chatbot, txt], chatbot)

iface.launch()

Dieser Code bietet eine grundlegende Chatbot -Schnittstelle. Auf dieser Grundlage können ausgefeiltere Anwendungen aufgebaut werden. Beispielausgaben und Eingabeaufforderungen sind im ursprünglichen Artikel angezeigt.

Schlussfolgerung

olmo 2 stellt einen signifikanten Beitrag zum Open-Source-LLM-Ökosystem dar. Die starke Leistung in Kombination mit seiner vollständigen Transparenz macht es zu einem wertvollen Instrument für Forscher und Entwickler. Obwohl sie nicht allgemein überall über alle Aufgaben hinausging, fördert ihre offene Natur die Zusammenarbeit und beschleunigt den Fortschritt im Bereich der zugänglichen und transparenten Ai.

Key Takeaways:

- Olmo-2s 13B-Parametermodell zeigt eine hervorragende Leistung bei verschiedenen Benchmarks und übertreffen andere offene Modelle.

- Vollständige Modelloffenheit erleichtert die Entwicklung effektiverer Modelle.

- Das Chatbot -Beispiel zeigt die einfache Integration mit Langchain und Gradio.

häufig gestellte Fragen (FAQs)

(Die FAQs aus dem ursprünglichen Artikel sind hier enthalten.)(Hinweis: Bild -URLs bleiben unverändert.)

Das obige ist der detaillierte Inhalt vonLaufen OLMO-2 vor Ort mit Gradio und Langchain. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Teslas Robovan war das versteckte Juwel im Robotaxi -Teaser 2024Apr 22, 2025 am 11:48 AM

Teslas Robovan war das versteckte Juwel im Robotaxi -Teaser 2024Apr 22, 2025 am 11:48 AMSeit 2008 habe ich mich für den Shared-Bride-Van eingesetzt, der als "Robotjitney" als "Vansit" als Zukunft des städtischen Transports bezeichnet wurde. Ich sehe diese Fahrzeuge als Transitlösung der nächsten Generation des 21. Jahrhunderts, Surpas, voraus

Sam's Club -Wetten auf KI zur Beseitigung von Quittungsprüfungen und zur Verbesserung des EinzelhandelsApr 22, 2025 am 11:29 AM

Sam's Club -Wetten auf KI zur Beseitigung von Quittungsprüfungen und zur Verbesserung des EinzelhandelsApr 22, 2025 am 11:29 AMRevolutionieren die Erfahrung im Checkout Der innovative "Just Go" -System von Sam's Club baut auf seiner vorhandenen KI-angetriebenen "Scan & Go" -Technologie auf und ermöglicht es den Mitgliedern, während ihres Einkaufsbaus Einkäufe über die Sam's Club-App zu scannen.

Die AI -Omniverse von Nvidia erweitert sich bei GTC 2025Apr 22, 2025 am 11:28 AM

Die AI -Omniverse von Nvidia erweitert sich bei GTC 2025Apr 22, 2025 am 11:28 AMVerbesserte Vorhersehbarkeit und neue Produktaufstellung von NVIDIA bei GTC 2025 Nvidia, ein wichtiger Akteur in der KI -Infrastruktur, konzentriert sich auf eine erhöhte Vorhersagbarkeit seiner Kunden. Dies beinhaltet eine konsequente Produktlieferung, die Erwartung der Leistungsverwaltung und die Erfüllung der Leistungsverwalter und beinhaltet

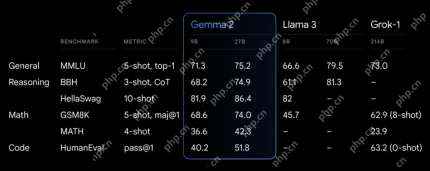

Erkundung der Funktionen der Gemma 2 -Modelle von Google.Apr 22, 2025 am 11:26 AM

Erkundung der Funktionen der Gemma 2 -Modelle von Google.Apr 22, 2025 am 11:26 AMGoogles Gemma 2: Ein leistungsstarkes, effizientes Sprachmodell Die Gemma-Familie von Google von Sprachmodellen, die für Effizienz und Leistung gefeiert wurde

Die nächste Welle von Genai: Perspektiven mit Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AM

Die nächste Welle von Genai: Perspektiven mit Dr. Kirk Borne - Analytics VidhyaApr 22, 2025 am 11:21 AMDiese Führung mit Daten -Episode zeigt Dr. Kirk Borne, einen führenden Datenwissenschaftler, Astrophysiker und TEDX -Sprecher. Dr. Borne, ein renommierter Experte für Big Data, KI und maschinelles Lernen, bietet unschätzbare Einblicke in den aktuellen Zustand und den zukünftigen Traje

KI für Läufer und Sportler: Wir machen hervorragende FortschritteApr 22, 2025 am 11:12 AM

KI für Läufer und Sportler: Wir machen hervorragende FortschritteApr 22, 2025 am 11:12 AMEs gab einige sehr aufschlussreiche Perspektiven in dieser Rede - Background -Informationen über Ingenieurwesen, die uns zeigten, warum künstliche Intelligenz so gut darin ist, die körperliche Bewegung der Menschen zu unterstützen. Ich werde eine Kernidee aus der Perspektive jedes Mitwirkenden skizzieren, um drei Designaspekte zu demonstrieren, die ein wichtiger Bestandteil unserer Erforschung der Anwendung künstlicher Intelligenz im Sport sind. Edge -Geräte und rohe personenbezogene Daten Diese Vorstellung von künstlicher Intelligenz enthält tatsächlich zwei Komponenten - eine, die sich darauf bezieht, wo wir große Sprachmodelle platzieren, und die andere hängt mit den Unterschieden zwischen unserer menschlichen Sprache und der Sprache zusammen, die unsere Vitalfunktionen „ausdrücken“, wenn sie in Echtzeit gemessen werden. Alexander Amini weiß viel über Laufen und Tennis, aber er immer noch

Jamie Engstrom über Technologie, Talent und Transformation bei CaterpillarApr 22, 2025 am 11:10 AM

Jamie Engstrom über Technologie, Talent und Transformation bei CaterpillarApr 22, 2025 am 11:10 AMJamie Engstrom, Chief Information Officer und Senior Vice President It, leitet ein globales Team von über 2.200 IT -Fachleuten in 28 Ländern. Mit 26 Jahren in Caterpillar, darunter viereinhalb Jahre in ihrer gegenwärtigen Rolle, Engst

Neues Google -Fotos Update macht ein Foto mit Ultra HDR -Qualität PopApr 22, 2025 am 11:09 AM

Neues Google -Fotos Update macht ein Foto mit Ultra HDR -Qualität PopApr 22, 2025 am 11:09 AMDas neue Ultra HDR -Tool von Google Photos: Eine schnelle Anleitung Verbessern Sie Ihre Fotos mit dem neuen Ultra HDR-Tool von Google Photos und verwandeln Sie Standardbilder in lebendige Meisterwerke mit hohem Dynamik. Dieses Tool ist ideal für soziale Medien und steigert die Auswirkungen eines Fotos.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SAP NetWeaver Server-Adapter für Eclipse

Integrieren Sie Eclipse mit dem SAP NetWeaver-Anwendungsserver.

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

SecLists

SecLists ist der ultimative Begleiter für Sicherheitstester. Dabei handelt es sich um eine Sammlung verschiedener Arten von Listen, die häufig bei Sicherheitsbewertungen verwendet werden, an einem Ort. SecLists trägt dazu bei, Sicherheitstests effizienter und produktiver zu gestalten, indem es bequem alle Listen bereitstellt, die ein Sicherheitstester benötigen könnte. Zu den Listentypen gehören Benutzernamen, Passwörter, URLs, Fuzzing-Payloads, Muster für vertrauliche Daten, Web-Shells und mehr. Der Tester kann dieses Repository einfach auf einen neuen Testcomputer übertragen und hat dann Zugriff auf alle Arten von Listen, die er benötigt.

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.