Das O3-Mini-Modell von

OpenAI bietet drei unterschiedliche Argumentationsstufen: niedrig, mittel und hoch und ermöglicht eine flexible Aufgabe. Dieser Artikel vergleicht diese Modi, untersucht Geschwindigkeit, Anwendungen, Benchmarks und Leistung.

Das OpenAI O3-Mini-Modell verfügt über drei Argumentationsmodi, die für unterschiedliche Aufgaben und Leistungsbedürfnisse optimiert sind. Dieser detaillierte Vergleich untersucht ihre Geschwindigkeit, ideale Anwendungen, Benchmarks und praktische Erkenntnisse zur Unterstützung der fundierten Entscheidungsfindung.

Inhaltsverzeichnis:

- Überblick über O3-Mini-Argumentationsniveaus

- geringer Argumentationsmodus

- Medienkundierungsmodus

- hoher Argumentationsmodus

- praktische O3-Mini-Argumentationsstufen

- niedriger Argumentationsmodus: Leistungsanalyse

- Medienkundierungsmodus: Leistungsanalyse

- hoher Argumentationsmodus: Leistungsanalyse

- Vergleichstabelle von O3-Mini-Argumentationsniveaus

- Endes Urteil: Auswählen des richtigen Modus

- Schlussfolgerung

Überblick über O3-Mini-Argumentationsniveaus:

| Reasoning Mode | Speed | Use Case | Benchmarks | Ideal Applications |

|---|---|---|---|---|

| Low | Very Fast | Rapid prototyping, data preprocessing | Comparable to O1-mini coding accuracy | Basic data entry, simple queries |

| Medium | Balanced Speed | Data analysis, content generation | Improved accuracy over Low mode | Moderate complexity tasks, report generation |

| High | Relatively Slow | Complex problem-solving, strategic planning | Elite-tier reasoning capabilities | Advanced STEM, SEO, in-depth research |

1. Niedriger Argumentationsmodus:

- Geschwindigkeit: signifikant schneller als das O1-Mini-Modell, die Abfragen innerhalb von Sekunden verarbeiten. Ideal für zeitsensitive Anwendungen.

- Anwendungsfall: Am besten für schnelle Prototypen und Datenvorbereitung mit hohem Volumen geeignet, wenn die Geschwindigkeit eingehende Analyse überwiegt.

- Benchmarks: erreicht die Codierungsgenauigkeit vergleichbar mit dem O1-Mini-Modell.

- Ideale Anwendungen: Grundlegende Dateneingabe, schnelle Antworten auf FAQs und einfache Interaktionen des Kundendienstes.

2. Medium -Argumentationsmodus:

- Geschwindigkeit: liefert ein Gleichgewicht zwischen Geschwindigkeit und Genauigkeit.

- Anwendungsfall: Geeignet für Aufgaben, die eine moderate Komplexität erfordern, wie z. B. Datenanalyse und Inhaltsgenerierung. Bietet einen nuancierteren Ansatz als der niedrige Modus.

- Benchmarks: zeigt eine verbesserte Genauigkeit im Vergleich zum niedrigen Modus.

- Ideale Anwendungen: Berichterstattung über Generierung, Blog -Post -Erstellung und mäßig komplexe Business Analytics -Aufgaben.

3. Hoher Argumentationsmodus:

- Geschwindigkeit: Während nicht explizit quantifiziert ist, ist sie für Aufgaben ausgelegt, die eine Präzision auf Doktorand erfordern und die Tiefe und die Gründlichkeit gegenüber der Geschwindigkeit priorisieren.

- Anwendungsfall: Am besten für komplexe Problemlösungen, strategische Planung und Aufgaben, die ein tiefes Verständnis und ein differenziertes Denken benötigen. Genauigkeit ist von größter Bedeutung.

- Benchmarks: bietet Elite-Tier-Argumentationsfunktionen.

- Ideale Anwendungen: Erweiterte STEM-Anwendungen, SEO-Optimierung und ausführliche Forschungsprojekte.

praktische O3-Mini-Argumentationsstufen:

Ein Beispiel für mathematische Problemlösungen (Aime 2024-Stilfrage) wurde verwendet, um jeden Modus zu testen. Die Code -Ausschnitte und -ausgänge sind für die Kürze weggelassen, aber die wichtigsten Ergebnisse sind unten zusammengefasst.

Leistungsanalyse Zusammenfassung:

| Reasoning Mode | Speed (seconds) | Accuracy | Solution Quality |

|---|---|---|---|

| Low | ~10 | Incorrect | High-level outline, flawed calculations |

| Medium | ~34 | Correct | Detailed, accurate step-by-step solution |

| High | ~33 | Correct | Detailed, accurate step-by-step solution |

Vergleichstabelle der O3-Mini-Argumentationsniveaus:

| Feature | Low Reasoning | Medium Reasoning | High Reasoning |

|---|---|---|---|

| Speed | Fastest (~10s) | Intermediate (~34s) | Slowest (~33s) |

| Accuracy | Incorrect (26) | Correct (104) | Correct (104) |

| Reasoning/Structure | High-level outline, flawed calculations | Detailed, accurate | Detailed, accurate |

| Use Case | Quick drafts | Moderate complexity | Complex problems |

| Calculation Ability | Weak | Strong | Strong |

Endes Urteil: Auswählen des richtigen Modus:

Das Experiment unterstreicht den Kompromiss zwischen Geschwindigkeit und Genauigkeit. Niedriger Modus priorisiert die Geschwindigkeit auf Kosten der Genauigkeit. Mittelgroße und hohe Modi liefern korrekte Lösungen, wobei ein Medium für viele praktische Anwendungen möglicherweise eine bessere Geschwindigkeitsgenauigkeitsbalance bietet. Der geringfügige Geschwindigkeitsunterschied zwischen Medium und hohem in diesem spezifischen Test kann je nach Serverlast und anderen Faktoren variieren.

Schlussfolgerung:

Die abgestuften Argumentationsniveaus des O3-Minis bieten Entwicklern Flexibilität. Wählen Sie bei einfachen Aufgaben, Medium für Geschwindigkeit und Genauigkeit in mäßig komplexen Aufgaben, niedrig für Geschwindigkeit für die Geschwindigkeit und hohe für tiefgreifende Argumentation und hohe Präzision in komplexen Szenarien. Diese Anpassungsfähigkeit verbessert die Effizienz und Produktivität der Workflow für verschiedene Anwendungen.

Das obige ist der detaillierte Inhalt vonWelches O3-Mini-Argumentationsniveau ist am klügsten?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

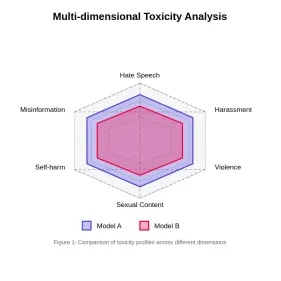

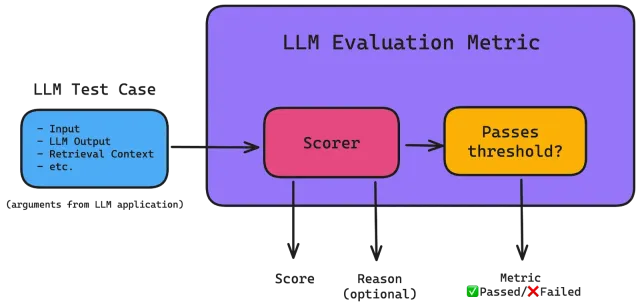

Bewertung der Toxizität in großen SprachmodellenApr 24, 2025 am 10:14 AM

Bewertung der Toxizität in großen SprachmodellenApr 24, 2025 am 10:14 AMIn diesem Artikel wird das entscheidende Problem der Toxizität in Großsprachenmodellen (LLMs) und die Methoden zur Bewertung und Minderung von Methoden untersucht. LLMs, die verschiedene Anwendungen von Chatbots bis hin zur Erzeugung von Inhalten betreiben, erfordert robuste Bewertungsmetriken, Witz

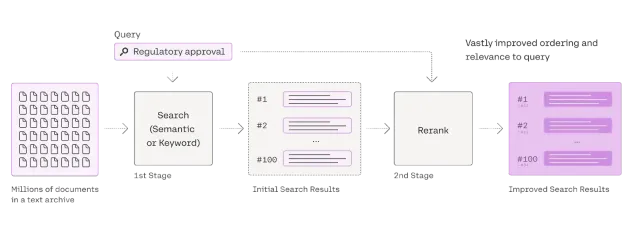

Umfassende Anleitung zum Reranker für LappenApr 24, 2025 am 10:10 AM

Umfassende Anleitung zum Reranker für LappenApr 24, 2025 am 10:10 AMRAG -Systeme (Abrufener Augmented Generation) transformieren den Zugang zum Informationen, ihre Effektivität hängt jedoch von der Qualität der abgerufenen Daten ab. Hier werden die Reranker entscheidend - als Qualitätsfilter für Suchergebnisse, um nur sicherzustellen, dass sie nur sicherstellen

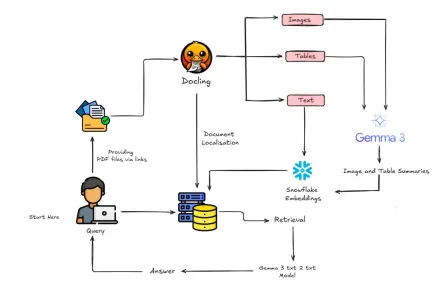

Wie baue ich multimodaler Lappen mit Gemma 3 & Docling?Apr 24, 2025 am 10:04 AM

Wie baue ich multimodaler Lappen mit Gemma 3 & Docling?Apr 24, 2025 am 10:04 AMDieses Tutorial führt Sie durch den Aufbau einer anspruchsvollen multimodalen Abrufpipeline (RAGMent-Generation) in Google Colab. Wir werden modernste Tools wie Gemma 3 (für Sprache und Vision), Docling (Dokumentkonvertierung), Langchain verwenden

Leitfaden zum Ray für skalierbare KI und maschinelles LernenanwendungenApr 24, 2025 am 10:01 AM

Leitfaden zum Ray für skalierbare KI und maschinelles LernenanwendungenApr 24, 2025 am 10:01 AMRay: Ein leistungsstarker Rahmen für die Skalierung von AI- und Python -Anwendungen Ray ist ein revolutionäres Open-Source-Framework, das mühelos AI- und Python-Anwendungen skalieren soll. Die intuitive API ermöglicht es Forschern und Entwicklern, ihren Code für zu wechseln

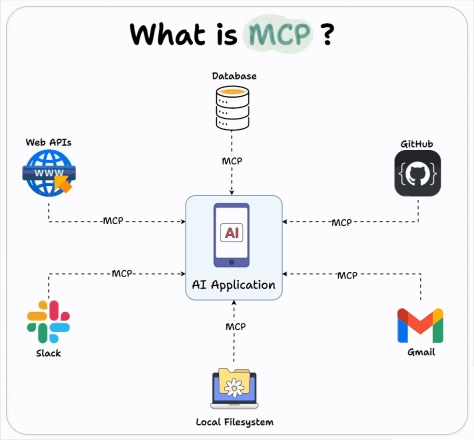

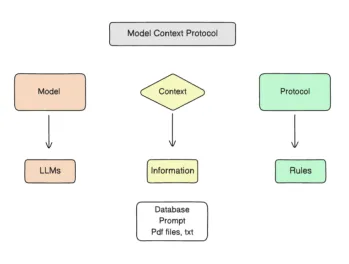

Wie benutze ich die OpenAI MCP -Integration für Bauagenten?Apr 24, 2025 am 09:58 AM

Wie benutze ich die OpenAI MCP -Integration für Bauagenten?Apr 24, 2025 am 09:58 AMOpenAI umfasst die Interoperabilität, indem es das Modellkontextprotokoll (MCP) von Anthropic unterstützt, einer Open-Source-Standard-Simpliking-Assistant-Integration der AI-Assistenten in verschiedene Datensysteme. Diese Zusammenarbeit fördert einen einheitlichen Rahmen für KI -Anwendungen nach EFF

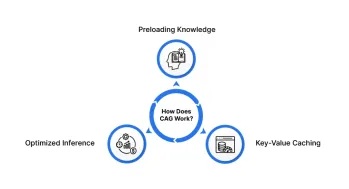

Cache-Augmented-Generation (CAG): Ist es besser als Rag?Apr 24, 2025 am 09:54 AM

Cache-Augmented-Generation (CAG): Ist es besser als Rag?Apr 24, 2025 am 09:54 AMCache-Augmented-Generation (CAG): Eine schnellere, effizientere Alternative zu Lappen Die Abruf Generation (RAG) hat die KI revolutioniert, indem er externes Wissen dynamisch einbezogen hat. Das Vertrauen in externe Quellen führt jedoch eine Latenz und führt zu

Rouge: Dekodierung der Qualität des maschinengenerierten TextesApr 24, 2025 am 09:49 AM

Rouge: Dekodierung der Qualität des maschinengenerierten TextesApr 24, 2025 am 09:49 AMBewertung großer Sprachmodelle: Ein tiefes Eintauchen in Rouge -Metriken Stellen Sie sich eine KI vor, die Gedichte komponieren, juristische Dokumente verfassen oder komplexe Forschung zusammenfasst. Wie bewerten wir ihre Leistung objektiv? Als Großsprachenmodelle (LLMs) Inc.

Verwendung von MCP: Modellkontextprotokoll - Analytics VidhyaApr 24, 2025 am 09:48 AM

Verwendung von MCP: Modellkontextprotokoll - Analytics VidhyaApr 24, 2025 am 09:48 AMSchalte die Kraft der realen Daten für deine AI-Assistenten mit dem Modellkontextprotokoll (MCP) frei! Sie haben wahrscheinlich Anwendungen mit LLMs erstellt, mit Wirkstoffen experimentiert und möglicherweise sogar Langchain, Autogen oder OpenAs Assistants API verwendet. Beeindruckend a

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),