Deepseek Janus Pro 1B, der am 27. Januar 2025 eingeführt wurde, ist ein fortschrittliches multimodales KI -Modell, das zur Verarbeitung und Generierung von Bildern aus textlichen Eingabeaufforderungen erstellt wurde. Mit seiner Fähigkeit, Bilder basierend auf Text zu verstehen und zu erstellen, liefert diese 1-Milliarden-Parameterversion (1B) eine effiziente Leistung für eine Vielzahl von Anwendungen, einschließlich der Erzeugung und des Bildverständnisses von Text zu Image. Darüber hinaus zeichnet es sich um detaillierte Bildunterschriften aus Fotos und macht es zu einem vielseitigen Werkzeug für kreative und analytische Aufgaben.

Lernziele

- Analyse seiner Architektur und Schlüsselmerkmale, die seine Fähigkeiten verbessern.

- Erforschung des zugrunde liegenden Designs und seiner Auswirkungen auf die Leistung.

- Eine Schritt-für-Schritt-Anleitung zum Aufbau eines RAG-Systems (Abruf-Augungs-Generation).

- Verwenden des Deepseek Janus Pro 1-Milliarden-Modells für reale Anwendungen.

- Verstehen Sie, wie Deepseek Janus Pro AI-gesteuerte Lösungen optimiert.

Dieser Artikel wurde als Teil des Data Science -Blogathon veröffentlicht.

Inhaltsverzeichnis

- Lernziele

- Was ist Deepseek Janus Pro? Verständnis & Generation

- Unified Transformator Architecture

-

- multimodaler RAG mit Deepseek Janus Pro 1B Modell

- Schritt 1. Installieren Sie notwendige Bibliotheken

- Schritt 2. Modell zum Speichern von Bildbetten. PDF

- Step 4. Querying & Retrieval From Saved Images

- Step 6. Output Generation

- Conclusions

- Key Takeaways

- Frequently Asked Questions

- Was ist Deepseek Janus Pro?

- Deepseek Janus Pro ist ein multimodales KI -Modell, das Text- und Bildverarbeitung integriert, das Bilder aus Textaufforderungen verstehen und generiert. Die 1-Milliarden-Parameterversion (1B) ist für effiziente Leistung für Anwendungen wie Text-zu-Image-Erzeugung und Bildverständnisaufgaben ausgelegt.

Unter Deepseeks Janus Pro-Serie sind die verfügbaren primären Modelle - „Janus Pro 1b“ und „Janus Pro 7b“, die sich hauptsächlich in ihrer Parametergröße unterscheiden, wobei das 7B-Modell signifikant größer ist und eine verbesserte Leistung in den Aufgaben der Text-zu-Images-Erzeugung angesehen wird.

Schlüsselmerkmale und Designaspekte von Janus Pro 1b

- Architektur : Janus Pro verwendet eine einheitliche Transformatorarchitektur, entkoppelt jedoch visuelle Codierung in separate Wege, um die Leistung sowohl bei den Aufgaben des Bildverständnisses als auch in der Erstellung zu verbessern.

- Funktionen : Es ist in Aufgaben im Zusammenhang mit dem Verständnis von Bildern und der Erzeugung neuer auf der Grundlage von Textaufforderungen hervorragend. Es unterstützt 384 × 384 Bildeingaben.

- Bild -Encoder : Für Bildverständnisaufgaben verwendet Janus Siglip, um Bilder zu codieren. Siglip ist ein Bildbettungsmodell, das das Framework von Clip verwendet, die Verlustfunktion jedoch durch einen paarweisen Sigmoidverlust ersetzt. Für die Bildgenerierung verwendet Janus einen vorhandenen Encoder von Llamagen, einem autoregressiven Bildgenerierungsmodus. Llamagen ist eine Familie von Bild-Generation-Modellen, die das nächstgefeilte Vorhersageparadigma von Großsprachenmodellen auf eine visuelle Generation anwendet

- Open Source: Es ist auf GitHub unter der MIT -Lizenz verfügbar, wobei die Modellnutzung der Deepseek -Modelllizenz abgelehnt wird.

auch lesen: Wie kann man Deepseek Janus Pro 7b zugreifen?

entkoppelte Architektur für Bildverständnis & Generation

Janus-pro weicht von früheren multimodalen Modellen ab, indem sie separate, spezialisierte Wege für die visuelle Codierung verwenden, anstatt sich auf einen einzelnen visuellen Encoder für das Bildverständnis und die Erzeugung zu verlassen.

- Bildverständnis Encoder. Dieser Weg extrahiert semantische Merkmale aus Bildern.

- Bildgenerierung Encoder. Dieser Weg synthetisiert Bilder basierend auf Textbeschreibungen.

Diese entkoppelte Architektur erleichtert aufgabenspezifische Optimierungen und mildern Konflikte zwischen Interpretation und kreativer Synthese. Die unabhängigen Encoder interpretieren Eingabefunktionen, die dann von einem einheitlichen autoregressiven Transformator verarbeitet werden. Dies ermöglicht es sowohl multimodaler Verständnis als auch Generationskomponenten, unabhängig ihre am besten geeigneten Codierungsmethoden auszuwählen.

Lesen Sie auch: Wie Deepseeks Janus Pro stapelt sich gegen Dall-e 3?

Schlüsselmerkmale der Modellarchitektur

1. Dual-Pathway-Architektur für visuelles Verständnis & Generation

- Visueller Verständnisweg: Für multimodale Verständnisaufgaben verwendet Janus Pro Siglip-L als visuelles Encoder, das Bildeingaben von bis zu 384 × 384 Auflösung unterstützt. Mit dieser hochauflösenden Unterstützung kann das Modell mehr Bilddetails erfassen und damit die Genauigkeit des visuellen Verständnisses verbessern.

- STIRS -Generierungspfad : Für Aufgaben der Bildgenerierung verwendet Janus Pro Llamagen -Tokenizer mit einer Downsampling -Rate von 16, um detailliertere Bilder zu generieren.

2. Unified Transformator Architecture

Ein gemeinsames Transformator -Rückgrat wird verwendet und Bildfunktionsfusion. Die unabhängigen Codierungsmethoden zum Umwandeln der Roheingaben in Funktionen werden von einem einheitlichen autoregressiven Transformator verarbeitet.

3. Optimierte Trainingsstrategie

Im früheren Janus-Training gab es einen dreistufigen Trainingsprozess für das Modell. Die erste Stufe konzentrierte sich auf das Training der Adapter und des Bildkopfes. In der zweiten Stufe wurde mit einheitlichen Vorbereitungen umgegangen, in denen alle Komponenten mit Ausnahme des Verständniscodierers und des Generationscodierers ihre Parameter aktualisiert haben. Stufe III überdachte Überwachung der Feinabstimmung und aufgebaut auf Stufe II, indem die Parameter des Verständnis-Encoders während des Trainings weiter entschlossen.

Dies wurde in Janus Pro verbessert:

- Durch Erhöhen der Trainingsschritte in Stufe I, sodass ein ausreichendes Training im ImageNet -Datensatz ermöglicht wird.

- Zusätzlich wurden in Stufe II für das Training der Text-zu-Image-Generation die Bilddaten vollständig fallen gelassen. Stattdessen wurden normale Text-zu-Image-Daten verwendet, um das Modell zu trainieren, um Bilder basierend auf dichten Beschreibungen zu generieren. Dies wurde festgestellt, um die Trainingseffizienz und die Gesamtleistung zu verbessern.

Lassen Sie uns nun multimodaler Lappen mit Deepseek Janus Pro bauen:

multimodaler Lappen mit Deepseek Janus Pro 1B Modell

In den folgenden Schritten werden wir ein multimodales Lappensystem erstellen, um Bilder basierend auf dem Deepseek Janus Pro 1B -Modell abzufragen.

Schritt 1. Installieren Sie die erforderlichen Bibliotheken

!pip install byaldi ollama pdf2image !sudo apt-get install -y poppler-utils !git clone https://github.com/deepseek-ai/Janus.git !pip install -e ./Janus

Schritt 2. Modell zum Speichern von Bildeinbettungen

import os from pathlib import Path from byaldi import RAGMultiModalModel import ollama # Initialize RAGMultiModalModel model1 = RAGMultiModalModel.from_pretrained("vidore/colqwen2-v0.1")byaldi bietet ein benutzerfreundliches Framework für die Einrichtung multimodaler Lappensysteme. Wie aus dem obigen Code erdenkt, laden wir ColqWen2, ein Modell, das für die effiziente Dokumentenindizierung mithilfe visueller Funktionen ausgelegt ist.

Schritt 3. Laden des Bildes PDF

# Use ColQwen2 to index and store the presentation index_name = "image_index" model1.index(input_path=Path("/content/PublicWaterMassMailing.pdf"), index_name=index_name, store_collection_with_index=True, # Stores base64 images along with the vectors overwrite=True )Wir verwenden dieses PDF, um in den nächsten Schritten ein Lappensystem abzufragen und zu erstellen. Im obigen Code speichern wir das Bild PDF zusammen mit den Vektoren.

Schritt 4. Abfrage & Abrufen von gespeicherten Bildern

query = "How many clients drive more than 50% revenue?" returned_page = model1.search(query, k=1)[0] import base64 # Example Base64 string (truncated for brevity) base64_string = returned_page['base64'] # Decode the Base64 string image_data = base64.b64decode(base64_string) with open('output_image.png', 'wb') as image_file: image_file.write(image_data)Die relevante Seite von den Seiten des PDF wird abgerufen und als output_image.png auf der Grundlage der Abfrage gespeichert.

Schritt 5. Laden Sie Janus Pro Model

.!pip install byaldi ollama pdf2image !sudo apt-get install -y poppler-utils !git clone https://github.com/deepseek-ai/Janus.git !pip install -e ./Janus

- vlchatProcessor.from_Pretrainierte ("Deepseek-AI/Janus-pro-1b") lädt einen vorabrundeten Prozessor zum Umgang mit multimodalen Eingängen (Bilder und Text). Dieser Prozessor verarbeitet und erstellt Eingabedaten (wie Text und Bilder) für das Modell.

- Der Tokenizer wird aus dem VlchatProcessor extrahiert. Es wird den Texteingang token und den Text in ein für das Modell geeignetes Format konvertieren.

- AutomodelforcausAllm.from_Pretrained ("Deepseek-AI/Janus-pro-1b") lädt das vorgebildete Janus-Pro-Modell, insbesondere für die kausale Sprachmodellierung.

- Außerdem wird ein multimodales Gesprächsformat eingerichtet, in dem der Benutzer sowohl Text als auch ein Bild eingibt.

- Die load_pil_images (Konversation) ist eine Funktion, die wahrscheinlich die im Konversationsobjekt aufgeführten Bilder lädt und sie in PIL -Bildformat umwandelt, das üblicherweise für die Bildverarbeitung in Python verwendet wird.

- Der -Prozessor Hier ist eine Instanz eines multimodalen Prozessors (des vlchatProcessor aus dem Deepseek Janus Pro -Modell), der sowohl Text- als auch Bilddaten als Eingabe nimmt.

- prepe_inputs_embeds (Eingänge) ist eine Methode, die die verarbeiteten Eingänge annimmt (Eingänge enthalten sowohl den Text als auch das Bild) und die für das Modell erforderlichen Einbettungen vorbereitet, um eine Antwort zu generieren. .

import os from pathlib import Path from byaldi import RAGMultiModalModel import ollama # Initialize RAGMultiModalModel model1 = RAGMultiModalModel.from_pretrained("vidore/colqwen2-v0.1")Schritt 6. AusgangsgenerierungDer Code generiert eine Antwort aus dem Deepseek Janus Pro 1B -Modell unter Verwendung der vorbereiteten Eingabempfetten (Text und Bild). Es verwendet mehrere Konfigurationseinstellungen wie Polsterung, Start-/End -Token, maximale Token -Länge und ob Caching und Probenahme. Nachdem die Antwort generiert wurde, dekodiert sie die Token-IDs mit dem Tokenizer wieder in den menschlichen Lesbarungstext. Die dekodierte Ausgabe ist in der Antwortvariablen gespeichert.

Der gesamte Code ist in diesem Colab -Notebook vorhanden.

Ausgabe für die Abfrage

Ausgabe für eine andere Abfrage

„Was war die Einnahmen in Frankreich?“

Die obige Antwort ist nicht genau, obwohl die relevante Seite durch TheColqWen2 Retriever abgerufen wurde, konnte das Deepseek Janus Pro 1B -Modell die genaue Antwort von der Seite nicht generieren. Die genaue Antwort sollte $ 2b betragen.

Ausgabe für eine andere Abfrage

"” Was war die Anzahl der Werbeaktionen seit Beginn des Geschäftsjahres? “

Die obige Antwort ist korrekt, da sie mit dem im PDF genannten Text übereinstimmt.Schlussfolgerungen

Abschließend stellt das Deepseek Janus Pro 1B -Modell einen signifikanten Fortschritt in der multimodalen KI mit seiner entkoppelten Architektur dar, die sowohl das Bildverständnis als auch die Erzeugungsaufgaben optimiert. Janus Pro bietet durch die Verwendung separater visueller Encoder für diese Aufgaben und die Verfeinerung seiner Trainingsstrategie eine verbesserte Leistung bei der Erzeugung und Bildanalyse von Text zu Image. Dieser innovative Ansatz (multimodaler Rag mit Deepseek Janus Pro), kombiniert mit seiner Open-Source-Zugänglichkeit, macht es zu einem leistungsstarken Werkzeug für verschiedene Anwendungen im visuellen Verständnis und der Erstellung von KI-gesteuertem.

Key Takeaways

- Multimodal AI mit Dual-Pfaden : Janus Pro 1B integriert sowohl die Text- als auch die Bildverarbeitung unter Verwendung separater Encoder für das Bildverständnis (Siglip) und die Bildgenerierung (Lamagen), wobei die aufgabenspezifische Leistung verbessert wird.

- entkoppierte Architektur: Das Modell trennt die visuelle Codierung in verschiedene Wege und ermöglicht die unabhängige Optimierung für das Bildverständnis und die Erzeugung, wodurch Konflikte bei Verarbeitungsaufgaben minimiert werden.

- Unified Transformator Backbone : Eine gemeinsame Transformatorarchitektur verschmilzt die Merkmale von Text und Bildern, wobei die multimodale Datenfusion für eine effektivere AI -Leistung strenger werden.

- Verbesserte Trainingsstrategie: Janus Pros optimiertes Trainingsansatz umfasst erhöhte Schritte in Stufe I und die Verwendung von spezialisierten Text-zu-Image-Daten in Stufe II, die die Trainingseffizienz und die Ausgangsqualität erheblich steigern.

- Open-Source-Zugänglichkeit: Janus Pro 1b ist auf GitHub unter der MIT-Lizenz verfügbar und fördert die weit verbreitete Verwendung und Anpassung in verschiedenen AI-gesteuerten Anwendungen.

Die in diesem Artikel gezeigten Medien sind nicht im Besitz von Analytics Vidhya und wird nach Ermessen des Autors verwendet.

häufig gestellte Fragen

Q1. Was ist Deepseek Janus Pro 1b?Ans. Deepseek Janus Pro 1B ist ein multimodales KI -Modell, mit dem sowohl Text- Es verfügt über 1 Milliarde Parameter für eine effiziente Leistung bei Aufgaben wie Text-zu-Image-Erzeugung und Bildverständnis.

Q2. Wie funktioniert die Architektur von Janus Pro 1b?Ans. Janus Pro verwendet eine einheitliche Transformatorarchitektur mit entkoppelter visueller Codierung. Dies bedeutet, dass es separate Pfade für das Verständnis und die Erzeugung von Bildern verwendet und die aufgabenspezifische Optimierung für jede Aufgabe ermöglicht.

Q3. Wie unterscheidet sich der Trainingsprozess von Janus Pro von früheren Versionen?Ans. Janus Pro verbessert frühere Trainingsstrategien, indem sie die Schulungsschritte erhöhen, den ImageNet-Datensatz zugunsten spezialisierter Text-zu-Im-Im---Daten fallen und sich auf eine bessere Feinabstimmung für verbesserte Effizienz und Leistung konzentriert.

Q4. Welche Art von Anwendungen kann von der Verwendung von Janus Pro 1B profitieren?Ans. Janus Pro 1b ist besonders nützlich für Aufgaben, die Text-zu-Image-Generierung, Bildverständnis und multimodale AI-Anwendungen umfassen, für die sowohl Bild- als auch Textverarbeitungsfunktionen

Q5 erforderlich sind. Wie vergleicht sich Janus-Pro mit anderen Modellen wie Dall-e 3?Ans. Janus-Pro-7b übertrifft laut Deepseek Dall-e 3 in Benchmarks wie Geneval und DPG-Bench. Janus-Pro trennt das Verständnis/die Erzeugung, skaliert Daten/Modelle für die stabile Bildgenerierung und hält eine einheitliche, flexible und kostengünstige Struktur. Während beide Modelle die Erzeugung von Text-zu-Image-Erzeugung durchführen, bietet Janus-Pro auch Bildunterschriften, die Dall-e 3 nicht.

nicht.

Das obige ist der detaillierte Inhalt vonVerbesserung des multimodalen Lappen mit Deepseek Janus Pro. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

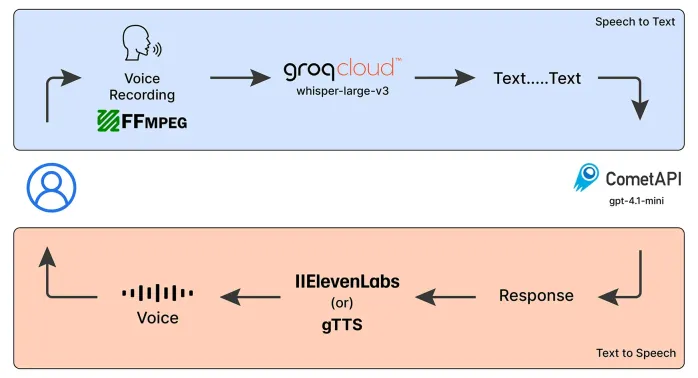

Notfallbetreiber Sprach -Chatbot: Unterstützung bei der UnterstützungMay 07, 2025 am 09:48 AM

Notfallbetreiber Sprach -Chatbot: Unterstützung bei der UnterstützungMay 07, 2025 am 09:48 AMSprachmodelle haben sich in der Welt schnell entwickelt. Jetzt ist es wichtig zu verstehen, wie wir die Funktionen dieses multimodalen Modells nutzen können

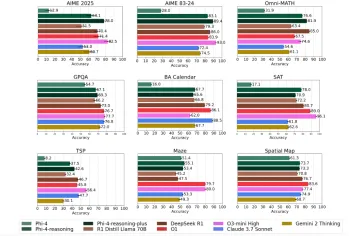

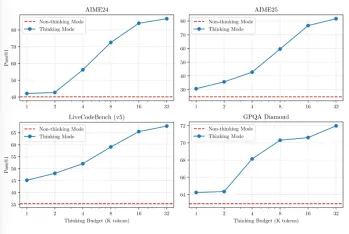

Die Phi-4-Argumentationsmodelle von Microsoft erklärten einfachMay 07, 2025 am 09:45 AM

Die Phi-4-Argumentationsmodelle von Microsoft erklärten einfachMay 07, 2025 am 09:45 AMMicrosoft ist nicht wie Openai, Google und Meta. Besonders nicht, wenn es um große Sprachmodelle geht. Während andere Tech -Giganten es vorziehen, mehrere Modelle zu starten, die die Benutzer mit Auswahlmöglichkeiten fast überwältigen. Microsoft startet einige,

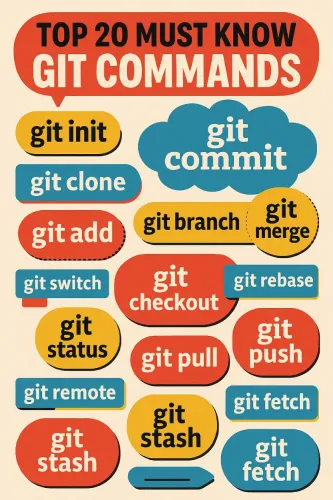

Top 20 Git -Befehle, die jeder Entwickler wissen sollte - Analytics VidhyaMay 07, 2025 am 09:44 AM

Top 20 Git -Befehle, die jeder Entwickler wissen sollte - Analytics VidhyaMay 07, 2025 am 09:44 AMGit kann sich wie ein Puzzle anfühlen, bis Sie die Schlüsselbewegungen lernen. In diesem Leitfaden finden Sie die Top 20 Git -Befehle, die dadurch bestellt werden, wie oft sie verwendet werden. Jeder Eintrag beginnt mit einer kurzen Zusammenfassung „Was es tut“, gefolgt von einer Bildanzeige

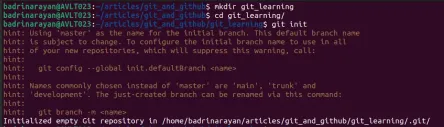

Git -Tutorial für AnfängerMay 07, 2025 am 09:36 AM

Git -Tutorial für AnfängerMay 07, 2025 am 09:36 AMIn der Softwareentwicklung kann das Verwalten von Code über mehrere Mitwirkende hinweg schneller werden. Stellen Sie sich vor, mehrere Personen bearbeiten das gleiche Dokument gleichzeitig, fügen jeweils neue Ideen hinzu, reparieren Fehler oder Optimierfunktionen. Ohne Struktur

Top 5 PDF zum Markdown -Konverter für mühelose Formatierung - Analytics VidhyaMay 07, 2025 am 09:21 AM

Top 5 PDF zum Markdown -Konverter für mühelose Formatierung - Analytics VidhyaMay 07, 2025 am 09:21 AMVerschiedene Formate wie PPTX, DOCX oder PDF zum Markdown -Konverter sind ein wesentliches Werkzeug für Inhaltautoren, Entwickler und Dokumentationsspezialisten. Wenn Sie die richtigen Werkzeuge haben

QWEN3 -Modelle: Zugriff, Funktionen, Anwendungen und mehrMay 07, 2025 am 09:18 AM

QWEN3 -Modelle: Zugriff, Funktionen, Anwendungen und mehrMay 07, 2025 am 09:18 AMQwen hat still ein Modell nach dem anderen hinzugefügt. Jedes seiner Modelle ist voller Merkmale und Größen, die so quantifiziert sind, dass es einfach unmöglich zu ignorieren ist. Nach QVQ, QWEN2.5-VL und QWEN2.5-OMNI in diesem Jahr die

Wie man Lag -Systeme und KI -Agenten mit QWEN3 bautMay 07, 2025 am 09:10 AM

Wie man Lag -Systeme und KI -Agenten mit QWEN3 bautMay 07, 2025 am 09:10 AMQwen hat gerade 8 neue Modelle im Rahmen seiner neuesten Familie veröffentlicht - QWEN3, die vielversprechende Fähigkeiten präsentiert. Das Flaggschiff-Modell, QWEN3-235B-A22B, übertraf die meisten anderen Modelle, darunter Deepseek-R1, OpenAs O1, O3-Mini,

Warum Sam Altman und andere jetzt Vibes als neues Messgerät für die neuesten Fortschritte in der KI verwendenMay 06, 2025 am 11:12 AM

Warum Sam Altman und andere jetzt Vibes als neues Messgerät für die neuesten Fortschritte in der KI verwendenMay 06, 2025 am 11:12 AMLassen Sie uns die steigende Verwendung von "Vibes" als Bewertungsmetrik im KI -Feld diskutieren. Diese Analyse ist Teil meiner laufenden Forbes -Spalte zu KI -Fortschritten und untersucht komplexe Aspekte der KI -Entwicklung (siehe Link hier). Stimmung in der AI -Bewertung Tradi

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

VSCode Windows 64-Bit-Download

Ein kostenloser und leistungsstarker IDE-Editor von Microsoft

DVWA

Damn Vulnerable Web App (DVWA) ist eine PHP/MySQL-Webanwendung, die sehr anfällig ist. Seine Hauptziele bestehen darin, Sicherheitsexperten dabei zu helfen, ihre Fähigkeiten und Tools in einem rechtlichen Umfeld zu testen, Webentwicklern dabei zu helfen, den Prozess der Sicherung von Webanwendungen besser zu verstehen, und Lehrern/Schülern dabei zu helfen, in einer Unterrichtsumgebung Webanwendungen zu lehren/lernen Sicherheit. Das Ziel von DVWA besteht darin, einige der häufigsten Web-Schwachstellen über eine einfache und unkomplizierte Benutzeroberfläche mit unterschiedlichen Schwierigkeitsgraden zu üben. Bitte beachten Sie, dass diese Software