Backend-Entwicklung

Backend-Entwicklung Python-Tutorial

Python-Tutorial Experimentieren Sie mit der Chainlit AI-Schnittstelle mit RAG auf Upsun

Experimentieren Sie mit der Chainlit AI-Schnittstelle mit RAG auf UpsunChainlit: Ein skalierbares Konversations-KI-Framework

Chainlit ist ein asynchrones Open-Source-Python-Framework, das für die Erstellung robuster und skalierbarer Konversations-KI-Anwendungen entwickelt wurde. Es bietet eine flexible Grundlage, die es Entwicklern ermöglicht, externe APIs, benutzerdefinierte Logik und lokale Modelle nahtlos zu integrieren.

Dieses Tutorial demonstriert zwei Retrieval Augmented Generation (RAG)-Implementierungen in Chainlit:

- Nutzung von OpenAI-Assistenten mit hochgeladenen Dokumenten.

- Verwendung von llama_index mit einem lokalen Dokumentordner.

Lokales Chainlit-Setup

Virtuelle Umgebung

Erstellen Sie eine virtuelle Umgebung:

mkdir chainlit && cd chainlit python3 -m venv venv source venv/bin/activate

Abhängigkeiten installieren

Erforderliche Pakete installieren und Abhängigkeiten speichern:

pip install chainlit pip install llama_index # For implementation #2 pip install openai pip freeze > requirements.txt

Chainlit testen

Chainlit starten:

chainlit hello

Zugriff auf den Platzhalter unter https://www.php.cn/link/2674cea93e3214abce13e072a2dc2ca5

Upsun-Bereitstellung

Git-Initialisierung

Git-Repository initialisieren:

git init .

Erstellen Sie eine .gitignore Datei:

<code>.env database/** data/** storage/** .chainlit venv __pycache__</code>

Upsun-Projekterstellung

Erstellen Sie ein Upsun-Projekt mit der CLI (folgen Sie den Anweisungen). Upsun konfiguriert das Remote-Repository automatisch.

Konfiguration

Beispiel für eine Upsun-Konfiguration für Chainlit:

applications:

chainlit:

source:

root: "/"

type: "python:3.11"

mounts:

"/database":

source: "storage"

source_path: "database"

".files":

source: "storage"

source_path: "files"

"__pycache__":

source: "storage"

source_path: "pycache"

".chainlit":

source: "storage"

source_path: ".chainlit"

web:

commands:

start: "chainlit run app.py --port $PORT --host 0.0.0.0"

upstream:

socket_family: tcp

locations:

"/":

passthru: true

"/public":

passthru: true

build:

flavor: none

hooks:

build: |

set -eux

pip install -r requirements.txt

deploy: |

set -eux

# post_deploy: |

routes:

"https://{default}/":

type: upstream

upstream: "chainlit:http"

"https://www.{default}":

type: redirect

to: "https://{default}/"

Legen Sie die Umgebungsvariable OPENAI_API_KEY über Upsun CLI fest:

upsun variable:create env:OPENAI_API_KEY --value=sk-proj[...]

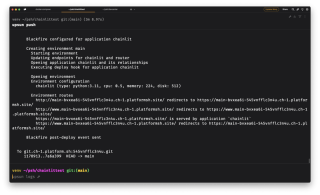

Bereitstellung

Festschreiben und bereitstellen:

git add . git commit -m "First chainlit example" upsun push

Überprüfen Sie den Bereitstellungsstatus. Bei erfolgreicher Bereitstellung wird angezeigt, dass Chainlit in Ihrer Hauptumgebung ausgeführt wird.

Implementierung 1: OpenAI-Assistent und hochgeladene Dateien

Diese Implementierung verwendet einen OpenAI-Assistenten, um hochgeladene Dokumente zu verarbeiten.

Assistentenerstellung

Erstellen Sie einen neuen OpenAI-Assistenten auf der OpenAI-Plattform. Legen Sie Systemanweisungen fest, wählen Sie ein Modell (mit Textantwortformat) und halten Sie die Temperatur niedrig (z. B. 0,10). Kopieren Sie die Assistenten-ID (asst_[xxx]) und legen Sie sie als Umgebungsvariable fest:

upsun variable:create env:OPENAI_ASSISTANT_ID --value=asst_[...]

Inhalt hochladen

Laden Sie Ihre Dokumente (Markdown bevorzugt) in den Assistenten hoch. OpenAI erstellt einen Vektorspeicher.

Assistant Logic (app.py)

Ersetzen Sie app.py den Inhalt durch den bereitgestellten Code. Wichtige Teile: @cl.on_chat_start erstellt einen neuen OpenAI-Thread und @cl.on_message sendet Benutzernachrichten an den Thread und streamt die Antwort.

Übernehmen Sie die Änderungen und stellen Sie sie bereit. Testen Sie den Assistenten.

Implementierung 2: OpenAI llama_index

Diese Implementierung verwendet llama_index für das lokale Wissensmanagement und OpenAI für die Antwortgenerierung.

Zweigerstellung

Neuen Zweig erstellen:

mkdir chainlit && cd chainlit python3 -m venv venv source venv/bin/activate

Ordnererstellung und Bereitstellung

Erstellen Sie die Ordner data und storage. Fügen Sie Halterungen zur Upsun-Konfiguration hinzu.

app.py-Update

Aktualisieren Sie app.py mit dem bereitgestellten llama_index-Code. Dieser Code lädt Dokumente, erstellt einen VectorStoreIndex und verwendet ihn, um Anfragen über OpenAI zu beantworten.

Stellen Sie die neue Umgebung bereit und laden Sie den Ordner data hoch. Testen Sie die Anwendung.

Bonus: Authentifizierung

Authentifizierung mithilfe einer SQLite-Datenbank hinzufügen.

Datenbank-Setup

Erstellen Sie einen database-Ordner und fügen Sie einen Mount zur Upsun-Konfiguration hinzu. Erstellen Sie eine Umgebungsvariable für den Datenbankpfad:

pip install chainlit pip install llama_index # For implementation #2 pip install openai pip freeze > requirements.txt

Authentifizierungslogik (app.py)

Fügen Sie mit app.py Authentifizierungslogik zu @cl.password_auth_callback hinzu. Dadurch wird ein Anmeldeformular hinzugefügt.

Erstellen Sie ein Skript, um gehashte Passwörter zu generieren. Fügen Sie Benutzer zur Datenbank hinzu (mithilfe von gehashten Passwörtern). Stellen Sie die Authentifizierung bereit und testen Sie die Anmeldung.

Fazit

Dieses Tutorial demonstrierte die Bereitstellung einer Chainlit-Anwendung auf Upsun mit zwei RAG-Implementierungen und Authentifizierung. Die flexible Architektur ermöglicht verschiedene Anpassungen und Integrationen.

Das obige ist der detaillierte Inhalt vonExperimentieren Sie mit der Chainlit AI-Schnittstelle mit RAG auf Upsun. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Python vs. C: Anwendungen und Anwendungsfälle verglichenApr 12, 2025 am 12:01 AM

Python vs. C: Anwendungen und Anwendungsfälle verglichenApr 12, 2025 am 12:01 AMPython eignet sich für Datenwissenschafts-, Webentwicklungs- und Automatisierungsaufgaben, während C für Systemprogrammierung, Spieleentwicklung und eingebettete Systeme geeignet ist. Python ist bekannt für seine Einfachheit und sein starkes Ökosystem, während C für seine hohen Leistung und die zugrunde liegenden Kontrollfunktionen bekannt ist.

Der 2-stündige Python-Plan: ein realistischer AnsatzApr 11, 2025 am 12:04 AM

Der 2-stündige Python-Plan: ein realistischer AnsatzApr 11, 2025 am 12:04 AMSie können grundlegende Programmierkonzepte und Fähigkeiten von Python innerhalb von 2 Stunden lernen. 1. Lernen Sie Variablen und Datentypen, 2. Master Control Flow (bedingte Anweisungen und Schleifen), 3.. Verstehen Sie die Definition und Verwendung von Funktionen, 4. Beginnen Sie schnell mit der Python -Programmierung durch einfache Beispiele und Code -Snippets.

Python: Erforschen der primären AnwendungenApr 10, 2025 am 09:41 AM

Python: Erforschen der primären AnwendungenApr 10, 2025 am 09:41 AMPython wird in den Bereichen Webentwicklung, Datenwissenschaft, maschinelles Lernen, Automatisierung und Skripten häufig verwendet. 1) In der Webentwicklung vereinfachen Django und Flask Frameworks den Entwicklungsprozess. 2) In den Bereichen Datenwissenschaft und maschinelles Lernen bieten Numpy-, Pandas-, Scikit-Learn- und TensorFlow-Bibliotheken eine starke Unterstützung. 3) In Bezug auf Automatisierung und Skript ist Python für Aufgaben wie automatisiertes Test und Systemmanagement geeignet.

Wie viel Python können Sie in 2 Stunden lernen?Apr 09, 2025 pm 04:33 PM

Wie viel Python können Sie in 2 Stunden lernen?Apr 09, 2025 pm 04:33 PMSie können die Grundlagen von Python innerhalb von zwei Stunden lernen. 1. Lernen Sie Variablen und Datentypen, 2. Master -Steuerungsstrukturen wie wenn Aussagen und Schleifen, 3. Verstehen Sie die Definition und Verwendung von Funktionen. Diese werden Ihnen helfen, einfache Python -Programme zu schreiben.

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?Apr 02, 2025 am 07:18 AMWie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer -Anfänger für Programmierungen? Wenn Sie nur 10 Stunden Zeit haben, um Computer -Anfänger zu unterrichten, was Sie mit Programmierkenntnissen unterrichten möchten, was würden Sie dann beibringen ...

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?Apr 02, 2025 am 07:15 AM

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?Apr 02, 2025 am 07:15 AMWie kann man nicht erkannt werden, wenn Sie Fiddlereverywhere für Man-in-the-Middle-Lesungen verwenden, wenn Sie FiddLereverywhere verwenden ...

Was soll ich tun, wenn das Modul '__builtin__' beim Laden der Gurkendatei in Python 3.6 nicht gefunden wird?Apr 02, 2025 am 07:12 AM

Was soll ich tun, wenn das Modul '__builtin__' beim Laden der Gurkendatei in Python 3.6 nicht gefunden wird?Apr 02, 2025 am 07:12 AMLaden Sie Gurkendateien in Python 3.6 Umgebungsbericht Fehler: ModulenotFoundError: Nomodulennamen ...

Wie verbessert man die Genauigkeit der Jiebeba -Wortsegmentierung in der malerischen Spot -Kommentaranalyse?Apr 02, 2025 am 07:09 AM

Wie verbessert man die Genauigkeit der Jiebeba -Wortsegmentierung in der malerischen Spot -Kommentaranalyse?Apr 02, 2025 am 07:09 AMWie löste ich das Problem der Jiebeba -Wortsegmentierung in der malerischen Spot -Kommentaranalyse? Wenn wir malerische Spot -Kommentare und -analysen durchführen, verwenden wir häufig das Jieba -Word -Segmentierungstool, um den Text zu verarbeiten ...

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

MinGW – Minimalistisches GNU für Windows

Dieses Projekt wird derzeit auf osdn.net/projects/mingw migriert. Sie können uns dort weiterhin folgen. MinGW: Eine native Windows-Portierung der GNU Compiler Collection (GCC), frei verteilbare Importbibliotheken und Header-Dateien zum Erstellen nativer Windows-Anwendungen, einschließlich Erweiterungen der MSVC-Laufzeit zur Unterstützung der C99-Funktionalität. Die gesamte MinGW-Software kann auf 64-Bit-Windows-Plattformen ausgeführt werden.

SAP NetWeaver Server-Adapter für Eclipse

Integrieren Sie Eclipse mit dem SAP NetWeaver-Anwendungsserver.

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

Dreamweaver Mac

Visuelle Webentwicklungstools

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version