Backend-Entwicklung

Backend-Entwicklung Python-Tutorial

Python-Tutorial Erstellen Sie einen KI-Code-Review-Assistenten mit Vev, Litellm und Agenta

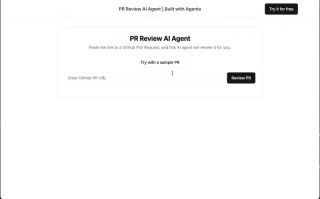

Erstellen Sie einen KI-Code-Review-Assistenten mit Vev, Litellm und AgentaDieses Tutorial zeigt den Aufbau eines produktionsbereiten KI-Pull-Request-Reviewers mithilfe von LLMOps-Best Practices. Die endgültige Bewerbung, die hier zugänglich ist, akzeptiert eine öffentliche PR-URL und gibt eine von der KI generierte Bewertung zurück.

Anwendungsübersicht

Dieses Tutorial behandelt:

- Codeentwicklung: PR-Unterschiede von GitHub abrufen und LiteLLM für die LLM-Interaktion nutzen.

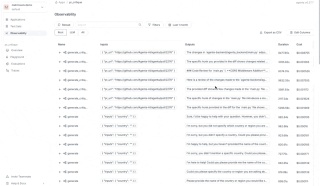

- Beobachtbarkeit:Implementierung von Agenta zur Anwendungsüberwachung und zum Debuggen.

- Prompt Engineering: Iteration von Eingabeaufforderungen und Modellauswahl mithilfe von Agentas Spielplatz.

- LLM-Bewertung:Einsatz von LLM als Richter für eine schnelle und vorbildliche Beurteilung.

- Bereitstellung: Bereitstellung der Anwendung als API und Erstellung einer einfachen Benutzeroberfläche mit v0.dev.

Kernlogik

Der Arbeitsablauf des KI-Assistenten ist einfach: Bei gegebener PR-URL ruft er das Diff von GitHub ab und sendet es zur Überprüfung an ein LLM.

Der Zugriff auf GitHub-Diffs erfolgt über:

<code>https://patch-diff.githubusercontent.com/raw/{owner}/{repo}/pull/{pr_number}.diff</code>

Diese Python-Funktion ruft den Unterschied ab:

def get_pr_diff(pr_url):

# ... (Code remains the same)

return response.text

LiteLLM erleichtert LLM-Interaktionen und bietet eine konsistente Schnittstelle über verschiedene Anbieter hinweg.

prompt_system = """

You are an expert Python developer performing a file-by-file review of a pull request. You have access to the full diff of the file to understand the overall context and structure. However, focus on reviewing only the specific hunk provided.

"""

prompt_user = """

Here is the diff for the file:

{diff}

Please provide a critique of the changes made in this file.

"""

def generate_critique(pr_url: str):

diff = get_pr_diff(pr_url)

response = litellm.completion(

model=config.model,

messages=[

{"content": config.system_prompt, "role": "system"},

{"content": config.user_prompt.format(diff=diff), "role": "user"},

],

)

return response.choices[0].message.content

Observability mit Agenta implementieren

Agenta verbessert die Beobachtbarkeit, indem es Eingaben, Ausgaben und den Datenfluss verfolgt, um das Debuggen zu erleichtern.

Agenta initialisieren und LiteLLM-Rückrufe konfigurieren:

import agenta as ag ag.init() litellm.callbacks = [ag.callbacks.litellm_handler()]

Instrumentenfunktionen mit Agenta-Dekoratoren:

@ag.instrument()

def generate_critique(pr_url: str):

# ... (Code remains the same)

return response.choices[0].message.content

Legen Sie die Umgebungsvariable AGENTA_API_KEY fest (erhalten von Agenta) und optional AGENTA_HOST für Selbsthosting.

Einen LLM-Spielplatz schaffen

Agentas benutzerdefinierte Workflow-Funktion bietet einen IDE-ähnlichen Spielplatz für die iterative Entwicklung. Der folgende Codeausschnitt demonstriert die Konfiguration und Integration mit Agenta:

from pydantic import BaseModel, Field

from typing import Annotated

import agenta as ag

import litellm

from agenta.sdk.assets import supported_llm_models

# ... (previous code)

class Config(BaseModel):

system_prompt: str = prompt_system

user_prompt: str = prompt_user

model: Annotated[str, ag.MultipleChoice(choices=supported_llm_models)] = Field(default="gpt-3.5-turbo")

@ag.route("/", config_schema=Config)

@ag.instrument()

def generate_critique(pr_url:str):

diff = get_pr_diff(pr_url)

config = ag.ConfigManager.get_from_route(schema=Config)

response = litellm.completion(

model=config.model,

messages=[

{"content": config.system_prompt, "role": "system"},

{"content": config.user_prompt.format(diff=diff), "role": "user"},

],

)

return response.choices[0].message.content

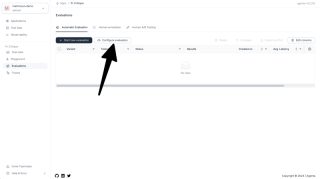

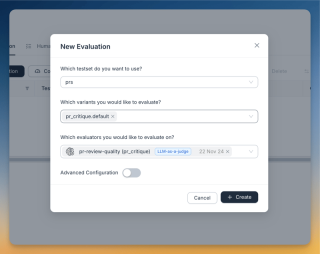

Betreuung und Bewertung mit Agenta

- Führen Sie

agenta initaus und geben Sie dabei den App-Namen und den API-Schlüssel an. - Führen Sie

agenta variant serve app.pyaus.

Dadurch wird die Anwendung über den Spielplatz von Agenta für End-to-End-Tests zugänglich gemacht. Für die Bewertung wird das LLM-as-a-Judge-Studium verwendet. Die Evaluator-Eingabeaufforderung lautet:

<code>You are an evaluator grading the quality of a PR review. CRITERIA: ... (criteria remain the same) ANSWER ONLY THE SCORE. DO NOT USE MARKDOWN. DO NOT PROVIDE ANYTHING OTHER THAN THE NUMBER</code>

Die Benutzeraufforderung für den Bewerter:

<code>https://patch-diff.githubusercontent.com/raw/{owner}/{repo}/pull/{pr_number}.diff</code>

Bereitstellung und Frontend

Die Bereitstellung erfolgt über die Benutzeroberfläche von Agenta:

- Navigieren Sie zur Übersichtsseite.

- Klicken Sie auf die drei Punkte neben der gewählten Variante.

- Wählen Sie „In der Produktion bereitstellen“ aus.

Für die schnelle Erstellung der Benutzeroberfläche wurde ein v0.dev-Frontend verwendet.

Nächste Schritte und Schlussfolgerung

Zukünftige Verbesserungen umfassen eine schnelle Verfeinerung, die Einbeziehung des vollständigen Codekontexts und die Handhabung großer Unterschiede. In diesem Tutorial wird erfolgreich das Erstellen, Bewerten und Bereitstellen eines produktionsbereiten KI-Pull-Request-Reviewers mit Agenta und LiteLLM demonstriert.

Das obige ist der detaillierte Inhalt vonErstellen Sie einen KI-Code-Review-Assistenten mit Vev, Litellm und Agenta. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Python: Spiele, GUIs und mehrApr 13, 2025 am 12:14 AM

Python: Spiele, GUIs und mehrApr 13, 2025 am 12:14 AMPython zeichnet sich in Gaming und GUI -Entwicklung aus. 1) Spielentwicklung verwendet Pygame, die Zeichnungen, Audio- und andere Funktionen bereitstellt, die für die Erstellung von 2D -Spielen geeignet sind. 2) Die GUI -Entwicklung kann Tkinter oder Pyqt auswählen. Tkinter ist einfach und einfach zu bedienen. PYQT hat reichhaltige Funktionen und ist für die berufliche Entwicklung geeignet.

Python vs. C: Anwendungen und Anwendungsfälle verglichenApr 12, 2025 am 12:01 AM

Python vs. C: Anwendungen und Anwendungsfälle verglichenApr 12, 2025 am 12:01 AMPython eignet sich für Datenwissenschafts-, Webentwicklungs- und Automatisierungsaufgaben, während C für Systemprogrammierung, Spieleentwicklung und eingebettete Systeme geeignet ist. Python ist bekannt für seine Einfachheit und sein starkes Ökosystem, während C für seine hohen Leistung und die zugrunde liegenden Kontrollfunktionen bekannt ist.

Der 2-stündige Python-Plan: ein realistischer AnsatzApr 11, 2025 am 12:04 AM

Der 2-stündige Python-Plan: ein realistischer AnsatzApr 11, 2025 am 12:04 AMSie können grundlegende Programmierkonzepte und Fähigkeiten von Python innerhalb von 2 Stunden lernen. 1. Lernen Sie Variablen und Datentypen, 2. Master Control Flow (bedingte Anweisungen und Schleifen), 3.. Verstehen Sie die Definition und Verwendung von Funktionen, 4. Beginnen Sie schnell mit der Python -Programmierung durch einfache Beispiele und Code -Snippets.

Python: Erforschen der primären AnwendungenApr 10, 2025 am 09:41 AM

Python: Erforschen der primären AnwendungenApr 10, 2025 am 09:41 AMPython wird in den Bereichen Webentwicklung, Datenwissenschaft, maschinelles Lernen, Automatisierung und Skripten häufig verwendet. 1) In der Webentwicklung vereinfachen Django und Flask Frameworks den Entwicklungsprozess. 2) In den Bereichen Datenwissenschaft und maschinelles Lernen bieten Numpy-, Pandas-, Scikit-Learn- und TensorFlow-Bibliotheken eine starke Unterstützung. 3) In Bezug auf Automatisierung und Skript ist Python für Aufgaben wie automatisiertes Test und Systemmanagement geeignet.

Wie viel Python können Sie in 2 Stunden lernen?Apr 09, 2025 pm 04:33 PM

Wie viel Python können Sie in 2 Stunden lernen?Apr 09, 2025 pm 04:33 PMSie können die Grundlagen von Python innerhalb von zwei Stunden lernen. 1. Lernen Sie Variablen und Datentypen, 2. Master -Steuerungsstrukturen wie wenn Aussagen und Schleifen, 3. Verstehen Sie die Definition und Verwendung von Funktionen. Diese werden Ihnen helfen, einfache Python -Programme zu schreiben.

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?Apr 02, 2025 am 07:18 AM

Wie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer-Anfänger-Programmierbasis in Projekt- und problemorientierten Methoden?Apr 02, 2025 am 07:18 AMWie lehre ich innerhalb von 10 Stunden die Grundlagen für Computer -Anfänger für Programmierungen? Wenn Sie nur 10 Stunden Zeit haben, um Computer -Anfänger zu unterrichten, was Sie mit Programmierkenntnissen unterrichten möchten, was würden Sie dann beibringen ...

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?Apr 02, 2025 am 07:15 AM

Wie kann man vom Browser vermeiden, wenn man überall Fiddler für das Lesen des Menschen in der Mitte verwendet?Apr 02, 2025 am 07:15 AMWie kann man nicht erkannt werden, wenn Sie Fiddlereverywhere für Man-in-the-Middle-Lesungen verwenden, wenn Sie FiddLereverywhere verwenden ...

Was soll ich tun, wenn das Modul '__builtin__' beim Laden der Gurkendatei in Python 3.6 nicht gefunden wird?Apr 02, 2025 am 07:12 AM

Was soll ich tun, wenn das Modul '__builtin__' beim Laden der Gurkendatei in Python 3.6 nicht gefunden wird?Apr 02, 2025 am 07:12 AMLaden Sie Gurkendateien in Python 3.6 Umgebungsbericht Fehler: ModulenotFoundError: Nomodulennamen ...

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Sicherer Prüfungsbrowser

Safe Exam Browser ist eine sichere Browserumgebung für die sichere Teilnahme an Online-Prüfungen. Diese Software verwandelt jeden Computer in einen sicheren Arbeitsplatz. Es kontrolliert den Zugriff auf alle Dienstprogramme und verhindert, dass Schüler nicht autorisierte Ressourcen nutzen.

MantisBT

Mantis ist ein einfach zu implementierendes webbasiertes Tool zur Fehlerverfolgung, das die Fehlerverfolgung von Produkten unterstützen soll. Es erfordert PHP, MySQL und einen Webserver. Schauen Sie sich unsere Demo- und Hosting-Services an.

SAP NetWeaver Server-Adapter für Eclipse

Integrieren Sie Eclipse mit dem SAP NetWeaver-Anwendungsserver.

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)