Java

Java javaLernprogramm

javaLernprogramm Mühelose Integration von KI-Modellen: Erstellen und Bewerten von KI-Modellen (Spring Boot und Hugging Face)

Mühelose Integration von KI-Modellen: Erstellen und Bewerten von KI-Modellen (Spring Boot und Hugging Face)Die KI-Revolution ist da und mit ihr kommt eine ständig wachsende Liste leistungsstarker Modelle, die Texte generieren, Bilder erstellen und komplexe Probleme lösen können. Aber seien wir ehrlich: Bei so vielen Optionen kann es überwältigend sein, herauszufinden, welches Modell am besten zu Ihrem Projekt passt. Was wäre, wenn es eine Möglichkeit gäbe, diese Modelle schnell zu testen, ihre Ergebnisse in Aktion zu sehen und zu entscheiden, welches Modell in Ihr Produktionssystem integriert werden soll?

Geben Sie Hugging Face’s Inference API ein – Ihre Abkürzung zur Erkundung und Nutzung modernster KI-Modelle. Durch das Angebot einer Plug-and-Play-Lösung entfällt der Aufwand für das Einrichten, Hosten oder Trainieren von Modellen. Egal, ob Sie über eine neue Funktion nachdenken oder die Fähigkeiten eines Modells bewerten, Hugging Face macht die KI-Integration einfacher als je zuvor.

In diesem Blog begleite ich Sie durch die Erstellung einer einfachen Backend-Anwendung mit Spring Boot, mit der Sie KI-Modelle mühelos testen und bewerten können. Das können Sie erwarten:

? Was Sie lernen werden

- Zugriff auf KI-Modelle: Erfahren Sie, wie Sie die Inferenz-API von Hugging Face verwenden, um Modelle zu erkunden und zu testen.

- Erstellen Sie ein Backend: Erstellen Sie eine Spring Boot-Anwendung, um mit diesen Modellen zu interagieren.

- Testmodelle: Richten Sie Endpunkte für die Text- und Bildgenerierung mithilfe von Beispielaufforderungen ein und testen Sie sie.

Am Ende verfügen Sie über ein praktisches Tool, mit dem Sie verschiedene KI-Modelle testen und fundierte Entscheidungen über deren Eignung für die Anforderungen Ihres Projekts treffen können. Wenn Sie bereit sind, die Lücke zwischen Neugier und Umsetzung zu schließen, legen wir los!

?️ Warum Hugging Face Inference API?

Deshalb ist Hugging Face ein Game-Changer für die KI-Integration:

- Benutzerfreundlichkeit: Modelle müssen nicht trainiert oder bereitgestellt werden – rufen Sie einfach die API auf.

- Vielfalt: Greifen Sie auf über 150.000 Modelle für Aufgaben wie Texterstellung, Bilderstellung und mehr zu.

- Skalierbarkeit: Perfekt für Prototyping und Produktionseinsatz.

? Was Sie bauen werden

Wir erstellen QuickAI, eine Spring Boot-Anwendung, die:

- Generiert Text: Erstellen Sie kreative Inhalte basierend auf einer Eingabeaufforderung.

- Erzeugt Bilder: Wandeln Sie Textbeschreibungen in visuelle Darstellungen um.

- Stellt API-Dokumentation bereit: Verwenden Sie Swagger, um die API zu testen und mit ihr zu interagieren.

? Erste Schritte

Schritt 1: Melden Sie sich für Hugging Face an

Gehen Sie zu Huggingface.co und erstellen Sie ein Konto, falls Sie noch keins haben.

Schritt 2: Holen Sie sich Ihren API-Schlüssel

Navigieren Sie zu Ihren Kontoeinstellungen und generieren Sie einen API-Schlüssel. Mit diesem Schlüssel kann Ihre Spring Boot-Anwendung mit der Inferenz-API von Hugging Face interagieren.

Schritt 3: Modelle erkunden

Schauen Sie sich den Hugging Face Model Hub an, um Modelle für Ihre Bedürfnisse zu finden. Für dieses Tutorial verwenden wir:

- Ein Textgenerierungsmodell (z. B. HuggingFaceH4/zephyr-7b-beta).

- Ein Bilderzeugungsmodell (z. B. „stableabilityai/stable-diffusion-xl-base-1.0“).

?️ Einrichten des Spring Boot-Projekts

Schritt 1: Erstellen Sie ein neues Spring Boot-Projekt

Verwenden Sie Spring Initializr, um Ihr Projekt mit den folgenden Abhängigkeiten einzurichten:

- Spring WebFlux: Für reaktive, nicht blockierende API-Aufrufe.

- Lombok: Um den Boilerplate-Code zu reduzieren.

- Swagger: Für API-Dokumentation.

Schritt 2: Fügen Sie die Konfiguration „Umarmendes Gesicht“ hinzu

Fügen Sie Ihren Hugging Face-API-Schlüssel und die Modell-URLs zur Datei application.properties hinzu:

huggingface.text.api.url=https://api-inference.huggingface.co/models/your-text-model huggingface.api.key=your-api-key-here huggingface.image.api.url=https://api-inference.huggingface.co/models/your-image-model

? Was kommt als nächstes?

Lassen Sie uns in den Code eintauchen und die Dienste für die Text- und Bildgenerierung erstellen. Bleiben Sie dran!

1. Textgenerierungsdienst:

@Service

public class LLMService {

private final WebClient webClient;

private static final Logger logger = LoggerFactory.getLogger(LLMService.class);

// Constructor to initialize WebClient with Hugging Face API URL and API key

public LLMService(@Value("${huggingface.text.api.url}") String apiUrl,

@Value("${huggingface.api.key}") String apiKey) {

this.webClient = WebClient.builder()

.baseUrl(apiUrl) // Set the base URL for the API

.defaultHeader("Authorization", "Bearer " + apiKey) // Add API key to the header

.build();

}

// Method to generate text using Hugging Face's Inference API

public Mono<string> generateText(String prompt) {

// Validate the input prompt

if (prompt == null || prompt.trim().isEmpty()) {

return Mono.error(new IllegalArgumentException("Prompt must not be null or empty"));

}

// Create the request body with the prompt

Map<string string> body = Collections.singletonMap("inputs", prompt);

// Make a POST request to the Hugging Face API

return webClient.post()

.bodyValue(body)

.retrieve()

.bodyToMono(String.class)

.doOnSuccess(response -> logger.info("Response received: {}", response)) // Log successful responses

.doOnError(error -> logger.error("Error during API call", error)) // Log errors

.retryWhen(Retry.backoff(3, Duration.ofMillis(500))) // Retry on failure with exponential backoff

.timeout(Duration.ofSeconds(5)) // Set a timeout for the API call

.onErrorResume(error -> Mono.just("Fallback response due to error: " + error.getMessage())); // Provide a fallback response on error

}

}

</string></string>

2. Bilderzeugungsdienst:

@Service

public class ImageGenerationService {

private static final Logger logger = LoggerFactory.getLogger(ImageGenerationService.class);

private final WebClient webClient;

public ImageGenerationService(@Value("${huggingface.image.api.url}") String apiUrl,

@Value("${huggingface.api.key}") String apiKey) {

this.webClient = WebClient.builder()

.baseUrl(apiUrl)

.defaultHeader("Authorization", "Bearer " + apiKey)

.build();

}

public Mono<byte> generateImage(String prompt) {

if (prompt == null || prompt.trim().isEmpty()) {

return Mono.error(new IllegalArgumentException("Prompt must not be null or empty"));

}

Map<string string> body = Collections.singletonMap("inputs", prompt);

return webClient.post()

.bodyValue(body)

.retrieve()

.bodyToMono(byte[].class) / Convert the response to a Mono<byte> (image bytes)

.timeout(Duration.ofSeconds(10)) // Timeout after 10 seconds

.retryWhen(Retry.backoff(3, Duration.ofMillis(500))) // Retry logic

.doOnSuccess(response -> logger.info("Image generated successfully for prompt: {}", prompt))

.doOnError(error -> logger.error("Error generating image for prompt: {}", prompt, error))

.onErrorResume(WebClientResponseException.class, ex -> {

logger.error("HTTP error during image generation: {}", ex.getMessage(), ex);

return Mono.error(new RuntimeException("Error generating image: " + ex.getMessage()));

})

.onErrorResume(TimeoutException.class, ex -> {

logger.error("Timeout while generating image for prompt: {}", prompt);

return Mono.error(new RuntimeException("Request timed out"));

});

}

}

</byte></string></byte>

Beispielaufforderungen und ihre Ergebnisse: ?

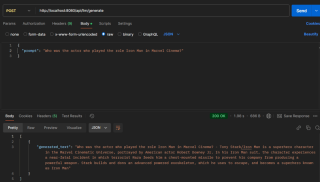

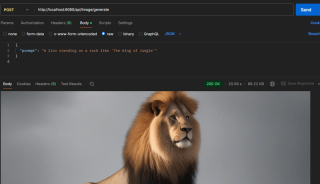

1. Textbasierter Endpunkt:

2. Bildbasierter Endpunkt:

? Entdecken Sie das Projekt

Bereit zum Eintauchen? Schauen Sie sich das GitHub-Repository von QuickAI an, um den vollständigen Code zu sehen und mitzumachen. Wenn Sie es nützlich finden, geben Sie ihm ein ⭐.

Bonus?

Möchten Sie dieses Projekt weiter vorantreiben?

- Ich habe die Swagger-Benutzeroberfläche für die API-Dokumentation konfiguriert, die Ihnen beim Erstellen einer Frontend-App hilft.

- Erstellen Sie eine einfache Frontend-App mit Ihrem bevorzugten Frontend-Framework (wie React, Angular oder einfach nur HTML/CSS/Vanilla JS).

? Herzlichen Glückwunsch, Sie haben es bis hierher geschafft.

Jetzt wissen Sie, wie man Hugging Face verwendet?:

- Um KI-Modelle schnell in Ihren Anwendungen zu verwenden.

- Text generieren: Erstellen Sie kreative Inhalte aus Eingabeaufforderungen.

- Bilder generieren: Verwandeln Sie Textbeschreibungen in Bilder.

? Lass uns verbinden!

Möchten Sie zusammenarbeiten oder haben Sie Vorschläge? Finden Sie mich auf LinkedIn, Portfolio. Schauen Sie sich auch andere meiner Projekte hier auf GitHub an.

Haben Sie eine Frage oder einen Vorschlag, hinterlassen Sie bitte hier unten einen Kommentar. Ich werde gerne darauf eingehen.

Viel Spaß beim Programmieren! ?

Das obige ist der detaillierte Inhalt vonMühelose Integration von KI-Modellen: Erstellen und Bewerten von KI-Modellen (Spring Boot und Hugging Face). Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Gibt es aufkommende Technologien, die die Unabhängigkeit der Plattform von Java bedrohen oder verbessern?Apr 24, 2025 am 12:11 AM

Gibt es aufkommende Technologien, die die Unabhängigkeit der Plattform von Java bedrohen oder verbessern?Apr 24, 2025 am 12:11 AMAufstrebende Technologien stellen sowohl Bedrohungen dar und verbessert die Plattformunabhängigkeit von Java. 1) Cloud Computing- und Containerisierungstechnologien wie Docker verbessern die Unabhängigkeit der Java -Plattform, müssen jedoch optimiert werden, um sich an verschiedene Cloud -Umgebungen anzupassen. 2) WebAssembly erstellt Java -Code über Graalvm, wodurch die Unabhängigkeit der Plattform erweitert wird, muss jedoch mit anderen Sprachen um die Leistung konkurrieren.

Was sind die unterschiedlichen Implementierungen des JVM und bieten alle die gleiche Unabhängigkeit der Plattform?Apr 24, 2025 am 12:10 AM

Was sind die unterschiedlichen Implementierungen des JVM und bieten alle die gleiche Unabhängigkeit der Plattform?Apr 24, 2025 am 12:10 AMVerschiedene JVM -Implementierungen können die Unabhängigkeit von Plattformen bieten, ihre Leistung ist jedoch etwas unterschiedlich. 1. OracleHotSpot und OpenJDKJVM können in der Plattformunabhängigkeit ähnlich erfolgen, aber OpenJDK erfordert möglicherweise eine zusätzliche Konfiguration. 2. IBMJ9JVM führt eine Optimierung für bestimmte Betriebssysteme durch. 3.. Graalvm unterstützt mehrere Sprachen und erfordert zusätzliche Konfiguration. 4. Azulzingjvm erfordert spezifische Plattformanpassungen.

Wie reduziert die Unabhängigkeit der Plattform die Entwicklungskosten und die Zeit?Apr 24, 2025 am 12:08 AM

Wie reduziert die Unabhängigkeit der Plattform die Entwicklungskosten und die Zeit?Apr 24, 2025 am 12:08 AMDie Unabhängigkeit der Plattform senkt die Entwicklungskosten und verkürzt die Entwicklungszeit, indem es denselben Code -Satz auf mehreren Betriebssystemen ausführt. Insbesondere manifestiert es sich als: 1. Reduzieren Sie die Entwicklungszeit, es ist nur ein Codesatz erforderlich; 2. Reduzieren Sie die Wartungskosten und vereinen Sie den Testprozess; 3.. Schnelle Iteration und Teamzusammenarbeit, um den Bereitstellungsprozess zu vereinfachen.

Wie erleichtert die Unabhängigkeit der Plattform von Java die Wiederverwendung von Code?Apr 24, 2025 am 12:05 AM

Wie erleichtert die Unabhängigkeit der Plattform von Java die Wiederverwendung von Code?Apr 24, 2025 am 12:05 AMJava'SplatformIndependenceFacilitateCodereuseByAllowingByteCodetorunonanyPlatformWitHajvm.1) EntwicklungscanwriteCodeonceforconsistentBehavioracrossplattforms.2) AUFTURET ISREITUNG ISRECTIONSUCDEDESCODEDOSNEWRITED.3)) und

Wie beheben Sie plattformspezifische Probleme in einer Java-Anwendung?Apr 24, 2025 am 12:04 AM

Wie beheben Sie plattformspezifische Probleme in einer Java-Anwendung?Apr 24, 2025 am 12:04 AMUm plattformspezifische Probleme in Java-Anwendungen zu lösen, können Sie die folgenden Schritte ausführen: 1. Verwenden Sie die Systemklasse von Java, um die Systemeigenschaften anzuzeigen, um die laufende Umgebung zu verstehen. 2. Verwenden Sie die Dateiklasse oder das Paket von Java.nio.file, um Dateipfade zu verarbeiten. 3. Laden Sie die lokale Bibliothek gemäß den Bedingungen des Betriebssystems. 4. Verwenden Sie VisualVM oder JProfiler, um die plattformübergreifende Leistung zu optimieren. 5. Stellen Sie sicher, dass die Testumgebung durch Docker -Containerisierung mit der Produktionsumgebung übereinstimmt. 6. Verwenden Sie GitHubactions, um automatisierte Tests auf mehreren Plattformen durchzuführen. Diese Methoden tragen dazu bei, plattformspezifische Probleme in Java-Anwendungen effektiv zu lösen.

Wie trägt das Klassenloader -Subsystem in der JVM zur Unabhängigkeit der Plattform bei?Apr 23, 2025 am 12:14 AM

Wie trägt das Klassenloader -Subsystem in der JVM zur Unabhängigkeit der Plattform bei?Apr 23, 2025 am 12:14 AMDer Klassenlader stellt die Konsistenz und Kompatibilität von Java-Programmen auf verschiedenen Plattformen durch ein einheitliches Klassendateiformat, dynamische Lade-, übergeordnete Delegationsmodell und plattformunabhängige Bytecode und erreicht Plattformunabhängigkeit.

Erstellt der Java-Compiler plattformspezifischen Code? Erklären.Apr 23, 2025 am 12:09 AM

Erstellt der Java-Compiler plattformspezifischen Code? Erklären.Apr 23, 2025 am 12:09 AMDer vom Java-Compiler generierte Code ist plattformunabhängig, aber der Code, der letztendlich ausgeführt wird, ist plattformspezifisch. 1. Java-Quellcode wird in plattformunabhängige Bytecode zusammengestellt. 2. Die JVM wandelt Bytecode für eine bestimmte Plattform in den Maschinencode um und stellt den plattformübergreifenden Betrieb sicher, aber die Leistung kann unterschiedlich sein.

Wie geht das JVM mit Multithreading auf verschiedenen Betriebssystemen um?Apr 23, 2025 am 12:07 AM

Wie geht das JVM mit Multithreading auf verschiedenen Betriebssystemen um?Apr 23, 2025 am 12:07 AMMultithreading ist für die moderne Programmierung wichtig, da es die Reaktionsfähigkeit und die Nutzung der Ressourcen verbessern und komplexe gleichzeitige Aufgaben erledigen kann. JVM sorgt für die Konsistenz und Effizienz von Multithreads auf verschiedenen Betriebssystemen durch Thread Mapping, Planungsmechanismus und Synchronisationssperrmechanismus.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

SublimeText3 Englische Version

Empfohlen: Win-Version, unterstützt Code-Eingabeaufforderungen!

SublimeText3 Linux neue Version

SublimeText3 Linux neueste Version

WebStorm-Mac-Version

Nützliche JavaScript-Entwicklungstools

mPDF

mPDF ist eine PHP-Bibliothek, die PDF-Dateien aus UTF-8-codiertem HTML generieren kann. Der ursprüngliche Autor, Ian Back, hat mPDF geschrieben, um PDF-Dateien „on the fly“ von seiner Website auszugeben und verschiedene Sprachen zu verarbeiten. Es ist langsamer und erzeugt bei der Verwendung von Unicode-Schriftarten größere Dateien als Originalskripte wie HTML2FPDF, unterstützt aber CSS-Stile usw. und verfügt über viele Verbesserungen. Unterstützt fast alle Sprachen, einschließlich RTL (Arabisch und Hebräisch) und CJK (Chinesisch, Japanisch und Koreanisch). Unterstützt verschachtelte Elemente auf Blockebene (wie P, DIV),