Solr 服务的安装可以参考 https://www.php.cn/blog/detail/25935.html

接下来我们介绍下怎么创建索引字段 和 添加中文分词器 IKAnalyzer分词的支持

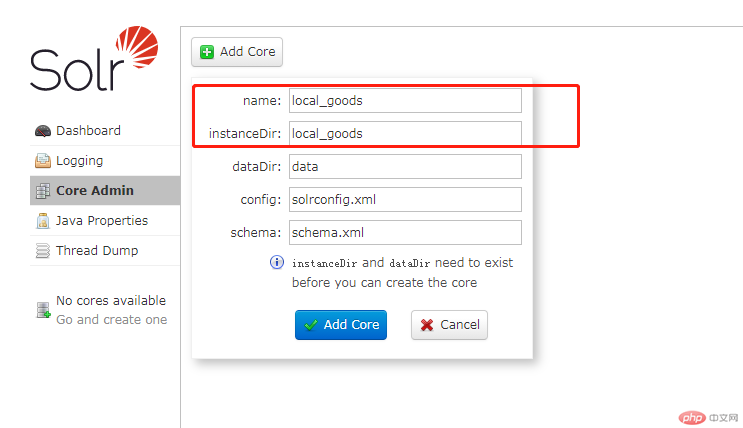

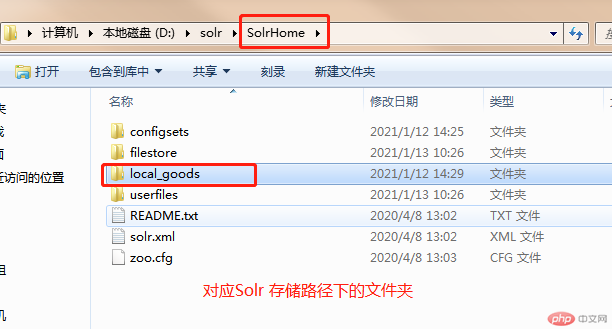

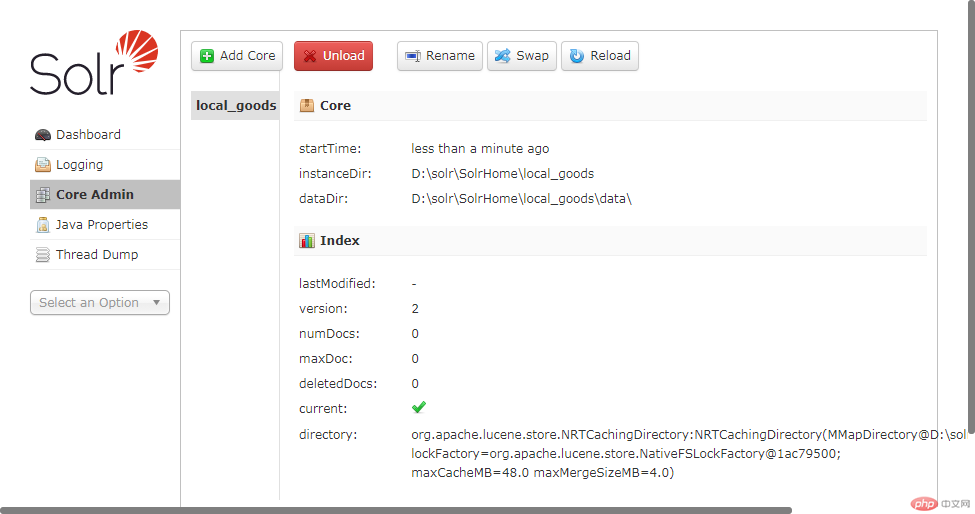

一、创建 Solr 数据核心仓库 local_goods(名称可自定义,创建成功后记得 copy 配置文件,详情参考安装)

Solr 字段和模式设计,参考文献:https://www.w3cschool.cn/solr_doc/solr_doc-6eil2fxo.html

可以通过管理后台进行配置字段及字段属性,当然也可以修改配置文件进行,

配置文件路径为: D:\solr\SolrHome\local_goods\conf 下的 managed-schema 字段配置文件 + solrconfig.xml solr性能配置

managed-schema 主要包括types、fields和其他的一些缺省设置。

solrconfig.xml 用来配置Solr的一些系统属性,例如与索引和查询处理有关的一些常见的配置选项,以及缓存、扩展等等。

上面的文档对这两个文件有比较详细的说明,非常容易上手。注意到 managed-schema 里有一个 <uniqueKey>id</uniqueKey> 的配置,这里将id字段作为索引文档的唯一标识符,非常重要。

什么是 IK Analyzer ?

IK Analyzer 是一个开源的,基亍 java 语言开发的轻量级的中文分词工具包。从 2006年 12 月推出 1.0 版开始, IKAnalyzer 已经推出了 4 个大版本。最初,它是以开源项目Luence 为应用主体的,结合词典分词和文法分析算法的中文分词组件。从 3.0 版本开始,IK 发展为面向 Java 的公用分词组件,独立亍 Lucene 项目,同时提供了对 Lucene 的默认优化实现。在 2012 版本中,IK 实现了简单的分词歧义排除算法,标志着 IK 分词器从单纯的词典分词向模拟语义分词衍化。

IK 下载地址:

官方下载地址:https://code.google.com/archive/p/ik-analyzer/downloads

git 下载地址:https://gitee.com/zehe/stopwords

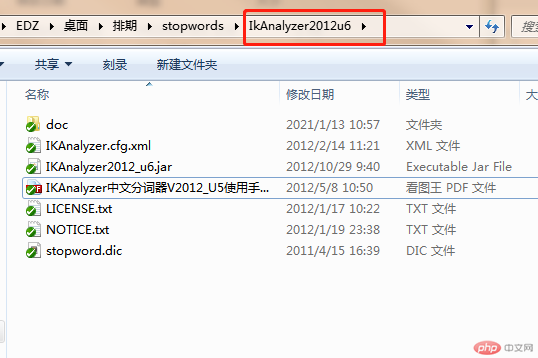

IK Analyzer的安装部署

IK Analyzer 安装包包含:

1. 《IKAnalyzer 中文分词器 V2012 使用手册》(即本文档)

2. IKAnalyzer2012.jar(主 jar 包)

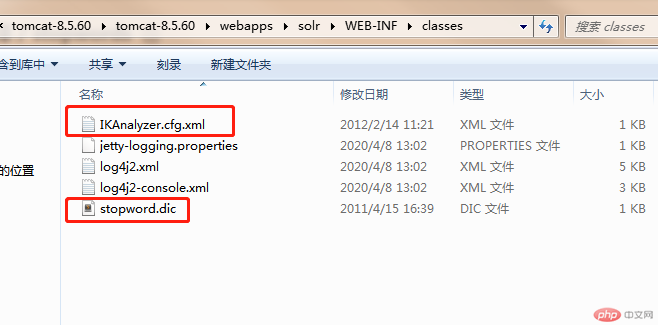

3. IKAnalyzer.cfg.xml(分词器扩展配置文件)

4. stopword.dic(停止词典)

5. LICENSE.TXT ; NOTICE.TXT (apache 版权申明)

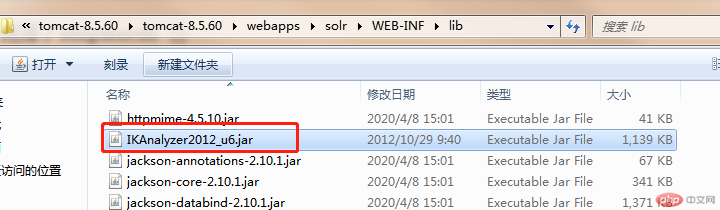

它 的 安 装 部 署 十 分 简 单 , 将 IKAnalyzer2012.jar 部 署 于 项 目 的 lib 目 录 中 ;

IKAnalyzer.cfg.xml 与 stopword.dic 文件放置在 class 根目录(对于 web 项目,通常是

WEB-INF/classes 目录,同 hibernate、log4j 等配置文件相同)下即可。

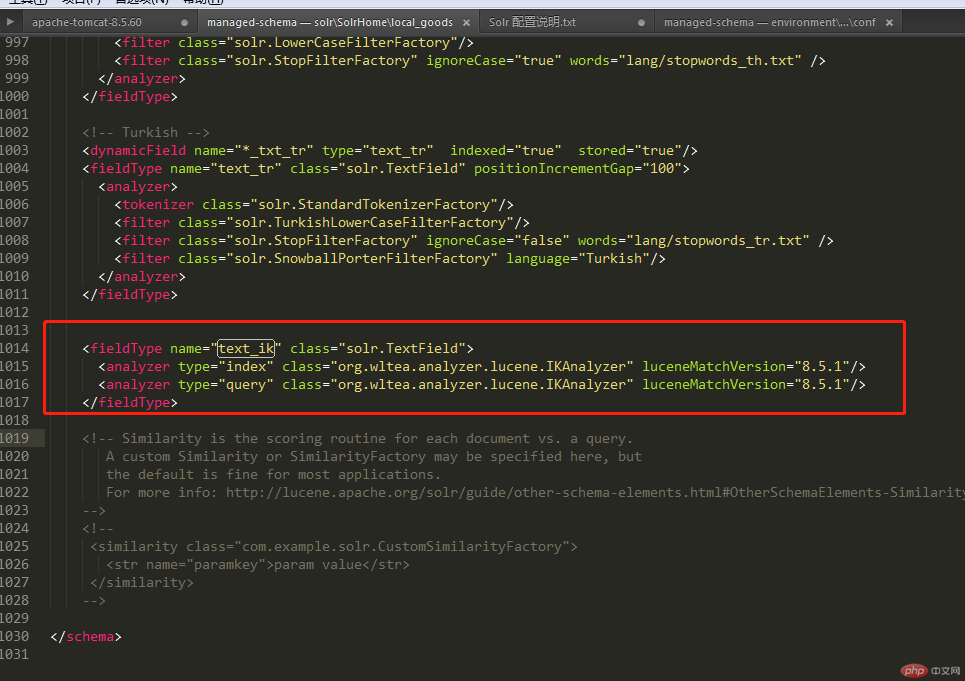

修改 SolrHome 的 managed-schema 文件,配置一个 FieldType,使用 IKAnalyzer

Solr 使用下载的Ik2012分词器配置有问题的话可以使用 ik-analyzer-8.3.0.jar 这个.jar 包哈,,,配置 xml 如下 <fieldType name="text_ik" class="solr.TextField"> <analyzer type="index" class="org.wltea.analyzer.lucene.IKAnalyzer" luceneMatchVersion="8.5.1"/> <analyzer type="query" class="org.wltea.analyzer.lucene.IKAnalyzer" luceneMatchVersion="8.5.1"/> </fieldType>

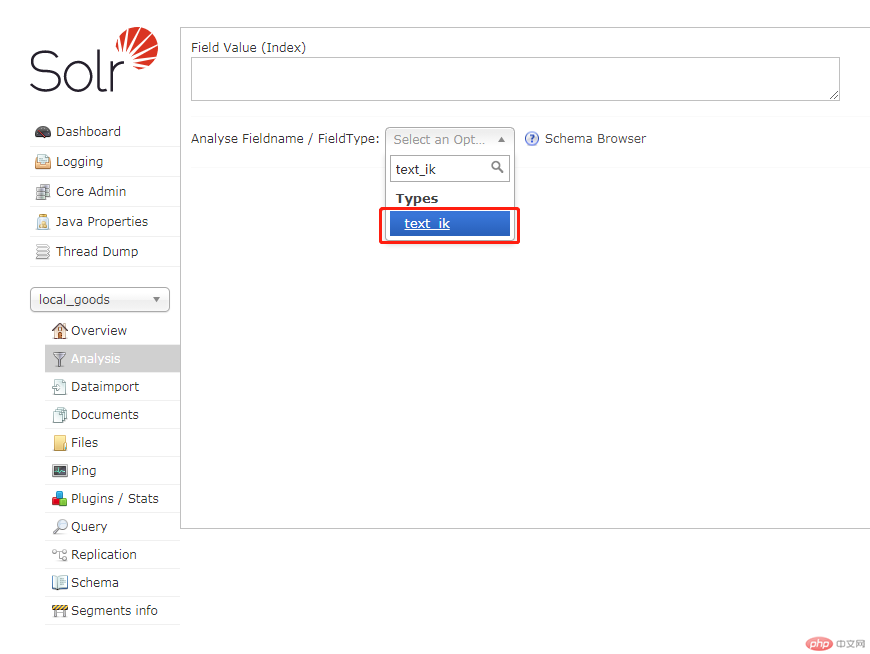

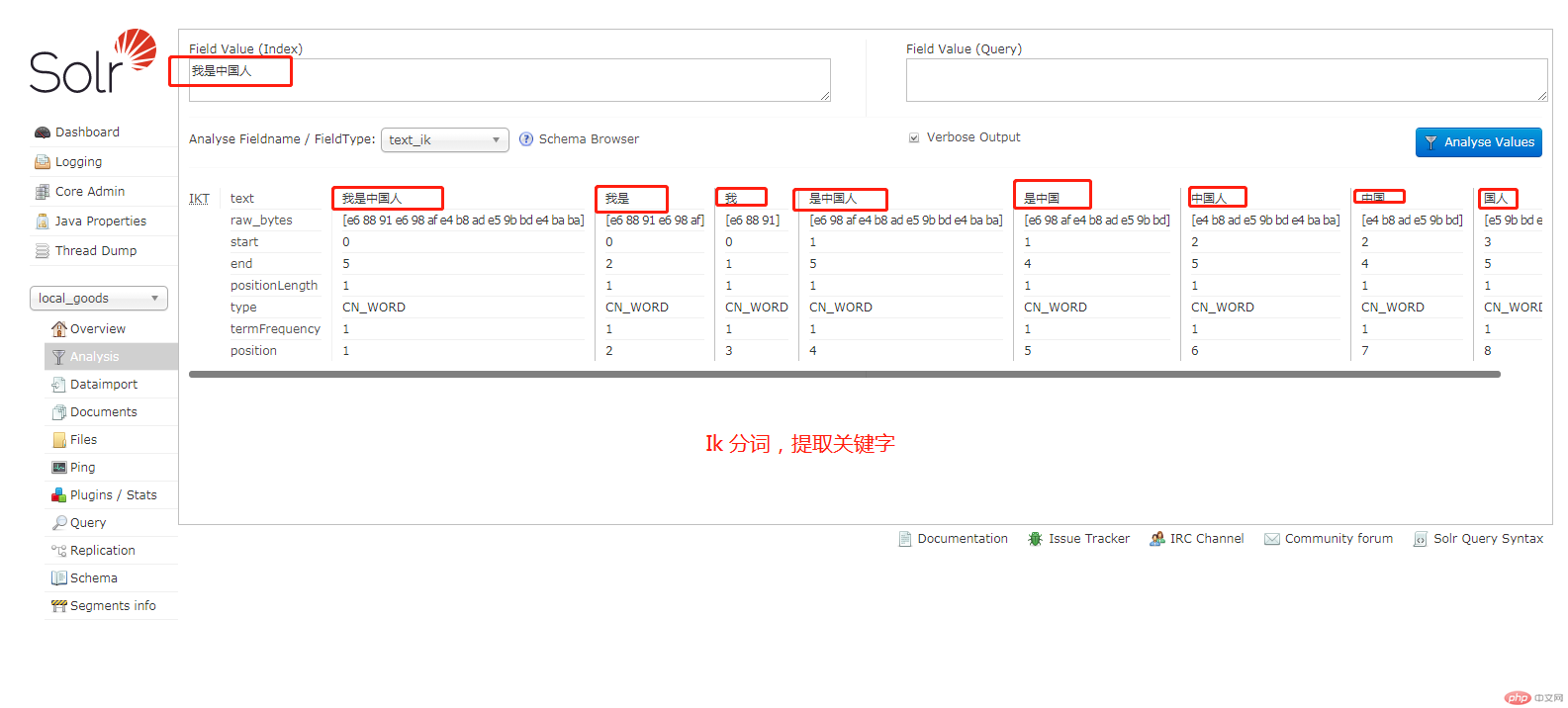

最后重启 Tomcat 服务,打开 Solr 管理后台,到分析界面验证

接下来就可以愉快的使用 Solr 了

推荐参考文档:

solr进阶一:java代码添加索引和增加IKAnalyzer分词支持 https://blog.csdn.net/u011439289/article/details/41698003

Solr集成IKAnalyzer中文分词器 https://segmentfault.com/a/1190000014780445

Solr官方文档 https://www.w3cschool.cn/solr_doc/

转载请注明出处~~~~